Die Integration von Agentischer KI in die wissenschaftliche Entdeckung läutet eine neue Ära der Forschungsautomatisierung ein und verändert fundamental, wie Du und andere Wissenschaftler Literatur sichten, Hypothesen bilden, Experimente durchführen und Ergebnisse analysieren könntest. Diese fortschrittlichen KI-Systeme, ausgestattet mit Fähigkeiten zum logischen Denken, Planen und autonomen Entscheiden, sind dabei, die Forschungslandschaft nachhaltig umzugestalten. Sie versprechen, den wissenschaftlichen Fortschritt erheblich zu beschleunigen, Kosten zu senken und den Zugang zu hochentwickelten Werkzeugen in verschiedensten Disziplinen wie Chemie, Biologie und Materialwissenschaften zu demokratisieren.

Dieser umfassende Überblick beleuchtet den aktuellen Stand der Agentischen KI für die wissenschaftliche Entdeckung. Er kategorisiert existierende Systeme sowie Werkzeuge und hebt die jüngsten Fortschritte präzise hervor. Dabei wird ein besonderer Fokus auf die dynamische Entwicklung und die zugrundeliegenden Technologien gelegt, die diese zukunftsweisende Transformation antreiben. Du erfährst hier, wie diese Systeme nicht nur bestehende Prozesse optimieren, sondern auch völlig neue Wege für Entdeckungen eröffnen können, die zuvor undenkbar waren.

Die rasante Entwicklung von Großen Sprachmodellen (LLMs) hat den Weg für Agentische KI-Systeme geebnet, die als leistungsstarke Instrumente zur Automatisierung komplexer Forschungsworkflows dienen. Im Gegensatz zu traditioneller KI sind diese Systeme auf ein hohes Maß an Autonomie ausgelegt. Das ermöglicht ihnen, Aufgaben wie Hypothesengenerierung, Literaturrecherche, Experimentaldesign und Datenanalyse selbstständig durchzuführen. Doch während das Potenzial enorm ist, werfen Aspekte wie die Automatisierung strukturierter Literaturreviews, die Systemzuverlässigkeit und ethische Fragen noch bedeutende Herausforderungen auf, die es präzise zu adressieren gilt.

Wenn Du das Thema spannend findest, dann kannst Du unter den folgenden Links weitere aktuelle ForschungsPaper zu KI-Agenten und Multi-Agenten-Frameworks finden:

Die Forschungspaper aus dem April findest Du hier.

Die Forschungs-Papers aus dem März findest Du hier.

Die Forschungs-Papers aus dem Januar und Februar findest Du hier.

Das musst Du wissen – Agentische KI in der wissenschaftlichen Forschung

- Autonome Forschung: Agentische KI ermöglicht es Systemen, selbstständig wissenschaftliche Aufgaben wie Literaturrecherche, Hypothesengenerierung, Experimentalplanung und Datenanalyse durchzuführen, was die Forschungsautomatisierung auf ein neues Level hebt.

- Beschleunigte Entdeckungen: Durch die Übernahme komplexer und zeitaufwendiger Prozesse hat Agentische KI das Potenzial, die Geschwindigkeit wissenschaftlicher Entdeckungen in Feldern wie Chemie, Biologie und Materialwissenschaften signifikant zu erhöhen.

- Vielfältige Systeme: Es gibt sowohl vollautonome Agentische KI-Systeme, die komplette Forschungszyklen ohne menschliches Eingreifen bewältigen, als auch kollaborative Systeme, die eng mit menschlichen Forschern zusammenarbeiten und deren Expertise erweitern.

- Herausforderungen & Zukunft: Trotz der Fortschritte bleiben die Automatisierung von Literaturreviews, die Gewährleistung von Systemzuverlässigkeit und ethische Bedenken zentrale Herausforderungen. Zukünftige Entwicklungen zielen auf eine verbesserte Mensch-KI-Kollaboration und präzisere Systemkalibrierung ab.

- Schlüsseltechnologien: Große Sprachmodelle (LLMs) bilden oft das Rückgrat Agentischer KI-Systeme und verleihen ihnen fortgeschrittene Fähigkeiten in der Verarbeitung natürlicher Sprache, im logischen Denken und in der Planung.

Agentische KI: Grundlagen und Schlüsselkonzepte präzise erklärt

Die Agentische KI markiert einen Paradigmenwechsel in der künstlichen Intelligenz, der weit über traditionelle Ansätze hinausgeht. Um ihre Rolle in der wissenschaftlichen Entdeckung vollumfänglich zu verstehen, ist es essenziell, ihre Definition, ihre charakteristischen Merkmale und die Unterschiede zwischen verschiedenen Architekturen detailliert zu beleuchten. Diese Systeme sind nicht nur Werkzeuge; sie agieren als autonome oder teilautonome Entitäten innerhalb komplexer Forschungsumgebungen.

Was genau ist Agentische KI? Definition und Charakteristika

Der Begriff „Agent“ besitzt eine reiche philosophische Tradition, die von Aristoteles bis Hume reicht und eine Entität beschreibt, die handlungsfähig ist. „Agency“ wiederum bezeichnet die Ausübung oder Repräsentation dieser Fähigkeit. In der künstlichen Intelligenz versteht man unter einem Agenten eine autonome, intelligente Entität, die in der Lage ist, auf sensorische Inputs angemessene und kontextrelevante Aktionen in physischen, virtuellen oder gemischten Realitäten auszuführen.

Agentische KI hebt dieses Konzept auf eine neue Ebene, indem sie die Bedeutung von verkörperter Intelligenz und integrierten Frameworks für interaktive Agenten in komplexen Systemen betont. Dieses Paradigma fußt auf der Erkenntnis, dass Intelligenz aus dem komplexen Zusammenspiel von Schlüsselprozessen wie Autonomie, Lernen, Gedächtnis, Wahrnehmung, Planung, Entscheidungsfindung und Aktion dynamisch entsteht. Diese Systeme sind darauf ausgelegt, eigenständig Ziele zu verfolgen und ihre Strategien basierend auf neuen Informationen präzise anzupassen.

Einzelagenten- vs. Multi-Agenten-Systeme: Eine dynamische Gegenüberstellung

Mit der explosionsartigen Zunahme von Forschungsarbeiten und industriellen Anwendungen im Bereich der Agentischen KI ist eine neue Debatte darüber entbrannt, ob Einzelagenten- oder Multi-Agenten-Systeme besser für die Lösung komplexer Aufgaben geeignet sind. Generell brillieren Einzelagenten-Architekturen bei klar definierten Problemen, bei denen kein direktes Feedback des Nutzers erforderlich ist. Multi-Agenten-Architekturen hingegen eignen sich besonders für Probleme, die Kollaboration erfordern und bei denen mehrere Durchläufe nötig sind, um zu einer optimalen Lösung zu gelangen.

Einzelagenten-Systeme: Ein Einzelagent kann sein Ziel unabhängig erreichen, ohne auf die Unterstützung oder das Feedback anderer KI-Agenten angewiesen zu sein, selbst wenn mehrere Agenten in derselben Umgebung koexistieren. Es kann jedoch Möglichkeiten für menschliche Interventionen geben, beispielsweise durch Feedback zur Steuerung des Agenten. Ein Einzelagent mit einem LLM als Rückgrat, der mehrere Aufgaben und Domänen bewältigen kann, wird als LM-basierter Agent bezeichnet. Er ist in der Lage, eigenständig zu schlussfolgern, zu planen und Werkzeuge auszuführen.

Auf Basis einer Eingabeaufforderung (Prompt) nutzt ein solcher Agent Werkzeuge, um seine Aufgabe präzise zu erledigen. Typische Anwendungen für Einzelagenten finden sich in der wissenschaftlichen Entdeckung, in Webszenarien, Spielumgebungen und im Gesundheitswesen.

Multi-Agenten-Systeme: Diese Architekturen involvieren zwei oder mehr Agenten, die miteinander interagieren. Ursprünglich inspiriert von Minskys „Society of Mind“, wo er eine neuartige Theorie der Intelligenz basierend auf den Interaktionen kleinerer Agenten mit spezifischen Funktionen vorschlug, die zu Intelligenz führen, erfordern Multi-Agenten-Systeme eine sorgfältige Interoperabilität zwischen den verschiedenen Agenten, insbesondere in ihrer Kommunikation und dem Informationsaustausch.

Solche Systeme stellen ein mächtiges kollaboratives Framework dar, wenn es um Probleme geht, die Aufgaben aus verschiedenen Domänen umfassen, wobei jeder Agent Experte in einer bestimmten Domäne ist. Im Bereich des Natural Language Processing (NLP) kann jeder Agent dasselbe oder unterschiedliche LLM-Backbones verwenden. Agenten können identische oder unterschiedliche Werkzeuge nutzen, wobei jeder Agent typischerweise eine einzigartige Persona verkörpert.

Multi-Agenten-Systeme werden umfassend in Bereichen wie der wissenschaftlichen Entdeckung, der Softwareentwicklung und dem Gesundheitswesen erforscht und eingesetzt. Obwohl sie sehr leistungsfähig bei der Lösung schwieriger Probleme in komplexen Umgebungen sind, bleiben die Kommunikation und Interaktion zwischen den Agenten im Vergleich zu Einzelagenten-Systemen eine der zentralen dynamischen Herausforderungen.

Eine Taxonomie der Agentischen KI für die wissenschaftliche Entdeckung

Der Anwendungsbereich der Agentischen KI in der wissenschaftlichen Entdeckung ist enorm und umfasst vielfältige Aufgaben wie die Hypothesengenerierung, das Design von Experimenten, die Datenanalyse und die Literaturrecherche. Durch die Automatisierung dieser traditionell arbeitsintensiven Prozesse besitzt Agentische KI das zukunftsweisende Potenzial, das Tempo wissenschaftlicher Entdeckungen zu beschleunigen, Kosten zu senken und den Zugang zu fortschrittlichen Forschungswerkzeugen zu demokratisieren.

Die wahre Stärke der Agentischen KI liegt jedoch in ihrer Fähigkeit, menschliche Expertise zu erweitern, anstatt sie zu ersetzen. Diese Systeme werden zunehmend so konzipiert, dass sie mit Forschern kollaborieren, Einsichten liefern, neuartige Ideen generieren und repetitive Aufgaben übernehmen, wodurch Wissenschaftler sich auf kreative und übergeordnete Problemlösungen konzentrieren können. Während sich das Feld dynamisch weiterentwickelt, expandieren seine Anwendungen in der wissenschaftlichen Entdeckung über diverse Domänen hinweg, von Chemie und Biologie bis hin zu Materialwissenschaften und dem Gesundheitswesen.

Agentische KI-Systeme lassen sich grob nach ihrem Grad an Autonomie, ihrer Interaktion mit Forschern und dem Umfang ihrer Anwendung präzise kategorisieren.

Vollautonome Systeme: Forschung ohne menschliches Zutun?

Vollautonome Systeme sind darauf ausgelegt, unabhängig zu operieren und wissenschaftliche Arbeitsabläufe von Anfang bis Ende mit minimaler menschlicher Intervention zu automatisieren. Diese Systeme nutzen fortschrittliche KI-Fähigkeiten wie das Verstehen natürlicher Sprache, Planung und Entscheidungsfindung, um komplexe Aufgaben von der Hypothesengenerierung bis zur Durchführung von Experimenten präzise zu bewältigen.

Ein Beispiel hierfür ist Coscientist (Boiko et al., 2023), ein autonomer KI-Agent, der von GPT-4 angetrieben wird und chemische Experimente plant, entwirft und ausführt. Ähnlich stellten M. Bran et al. (2024) ChemCrow vor, das die Fähigkeiten von GPT-4 durch die Integration von 18 von Experten entworfenen Werkzeugen für Aufgaben wie organische Synthese, Wirkstoffentdeckung und Materialdesign erweitert. Es demonstriert das zukunftsweisende Potenzial vollautonomer Systeme, komplexe, domänenspezifische Herausforderungen dynamisch anzugehen.

ProtAgents (Ghafarollahi & Buehler, 2024a) wurde für Proteindesign und molekulare Modellierung vorgeschlagen. Es nutzt LLMs und Reinforcement Learning, um Proteinstrukturen zu optimieren, Faltungsmuster vorherzusagen und molekulare Docking-Simulationen durchzuführen. ProtAgents kann autonom Proteinsequenzen generieren, testen und verfeinern, um gewünschte biochemische Eigenschaften zu erzielen.

LLaMP (Large Language Model for Materials Prediction) (Chiang et al., 2024) ist ein autonomer KI-Agent für die Materialwissenschaft, der RAG (Retrieval Augmented Generation) nutzt, um Materialeigenschaften vorherzusagen und Formulierungen zu optimieren. Er führt autonom atomistische Simulationen und Materialentdeckungen durch und unterstützt Anwendungen in Nanotechnologie, Energiespeicherung und Katalyse.

Der Hauptvorteil dieser Systeme liegt in ihrer Effizienz in Umgebungen, in denen Aufgaben gut definiert, repetitiv sind oder hohe Präzision erfordern. Sie können die Forschung erheblich beschleunigen, indem sie zeitaufwendige Prozesse automatisieren. Sie könnten jedoch bei Aufgaben an ihre Grenzen stoßen, die Kreativität, domänenspezifische Intuition oder interdisziplinäres Wissen erfordern, was die Notwendigkeit menschlicher Aufsicht in bestimmten Szenarien unterstreicht.

Mensch-KI-Kollaborationssysteme: Die Synergie von Expertise und Rechenkraft

Mensch-KI-Kollaborationssysteme betonen die Synergie zwischen künstlicher Intelligenz und Forschern, indem sie die Rechenleistung der KI mit der Kreativität und menschlichen Expertise dynamisch kombinieren. Swanson et al. (2024) schlugen Virtual Lab vor, ein KI-Mensch-kollaboratives Framework, das interdisziplinäre wissenschaftliche Forschung durchführt.

Es organisiert Team-Meetings und individuelle Aufgaben, um komplexe Probleme zu lösen, wie beispielsweise das Design von Nanobody-Bindern für SARS-CoV-2. O’Donoghue et al. (2023) entwickelten BioPlanner, ein KI-gesteuertes Forschungsplanungstool, das experimentelle Protokolle entwirft, indem es wissenschaftliche Ziele in pseudocode-ähnliche Schritte umwandelt. Es unterstützt Forscher bei der effizienten Strukturierung von Nasslaborexperimenten, führt diese jedoch nicht autonom durch.

Prince et al. (2024) stellten CALMS (Context-Aware Language Model for Science) vor, einen KI-gestützten Laborassistenten, der mit Wissenschaftlern und Laborinstrumenten interagiert. Er bietet Echtzeit-kontextbezogene Unterstützung bei Experimenten, hilft bei der Verfahrensanleitung, Dateninterpretation und Workflow-Optimierung, führt jedoch keine Experimente autonom aus. Kürzlich führten Schmidgall et al. (2025) das Agent Laboratory ein, ein Framework, das von Menschen bereitgestellte Forschungsideen annimmt und autonom durch Literaturrecherche, Experimente und Berichtserstellung fortschreitet.

Die Vorteile dieser KI-getriebenen wissenschaftlichen Frameworks liegen in ihrer Fähigkeit, die Forschung zu beschleunigen, das Experimentaldesign zu verbessern und die Entscheidungsfindung in Bereichen wie Genetik, Materialwissenschaft und Chemie präzise zu optimieren. Ihre Grenzen ergeben sich jedoch aus ihrer Abhängigkeit von menschlicher Aufsicht, Datenqualität und Interpretierbarkeit. Daher erfordern sie immer noch eine manuelle Validierung und Ausführung, was die zukunftsweisende Entwicklung hin zu noch ausgefeilteren Kollaborationsmodellen andeutet.

Agentische KI im Fokus: Die Herausforderung der Literaturrecherche

Die wissenschaftliche Entdeckung ist ein iterativer Prozess, der auf vorhandenem Wissen aufbaut und von Forschern verlangt, frühere Arbeiten systematisch zu untersuchen und zu synthetisieren. Eine Literaturrecherche bildet das Fundament dieses Prozesses und ermöglicht es Wissenschaftlern, Schlüsseltrends zu identifizieren, Methoden zu bewerten und Wissenslücken zu erkennen, die neue Forschungsrichtungen dynamisch vorantreiben können. In Feldern wie Chemie, Biologie, Materialwissenschaften, Gesundheitswesen und künstlicher Intelligenz ist eine gut durchgeführte Literaturrecherche unerlässlich, um Forschungsfragen präzise zu formulieren, geeignete experimentelle oder computergestützte Ansätze auszuwählen und Reproduzierbarkeit zu gewährleisten.

Angesichts des exponentiellen Wachstums wissenschaftlicher Publikationen sind traditionelle manuelle Recherchen zunehmend herausfordernd geworden. Forscher verlassen sich nun auf fortschrittliche Werkzeuge, wie autonome Agenten, um riesige Datenmengen wissenschaftlicher Literatur effizient zu navigieren. Diese Technologien erleichtern die automatische Extraktion relevanter Informationen, Trendanalysen und prädiktive Modellierungen und beschleunigen so das Entdeckungstempo.

Agentische KI-Systeme haben das zukunftsweisende Potenzial, diese Herausforderungen durch die Automatisierung der Informationsbeschaffung, -extraktion und -synthese anzugehen. Die Automatisierung der Literaturrecherche ist jedoch eine komplexe Aufgabe, die fortgeschrittenes Sprachverständnis, domänenspezifisches Wissen und die Fähigkeit erfordert, mit Mehrdeutigkeiten und Nuancen umzugehen.

Mehrere Frameworks wurden entwickelt, um den Literaturrechercheprozess mittels Agentischer KI zu automatisieren oder zu erweitern. SciLitLLM (Li et al., 2024c) ist ein vorgeschlagenes Framework, das darauf abzielt, das Verständnis wissenschaftlicher Literatur zu verbessern. Es verwendet eine Hybridstrategie, die kontinuierliches Vortraining (CPT) und überwachtes Feinabstimmen (SFT) kombiniert, um domänenspezifisches Wissen einzuspeisen und die Fähigkeit zur Befolgung von Anweisungen zu verbessern.

Obwohl SciLitLLM eine verbesserte Leistung bei Aufgaben wie Dokumentenklassifizierung, Zusammenfassung und Beantwortung von Fragen zeigt und somit ein wertvolles Werkzeug für die Literaturrecherche darstellt, ist das Framework stark von qualitativ hochwertigen Trainingsdaten abhängig, die für neu entstehende Felder möglicherweise nicht immer verfügbar sind.

Ajith et al. (2024) stellten LitSearch vor, einen Benchmark zur Bewertung von Retrieval-Systemen bei komplexen Literatursuchanfragen im maschinellen Lernen und NLP. Die Stärke von LitSearch liegt in seiner Fähigkeit, einen standardisierten Rahmen für die Leistungsbewertung von Retrieval-Systemen bereitzustellen, der es Forschern ermöglicht, verschiedene Ansätze zu vergleichen und Verbesserungspotenziale zu identifizieren. Im Gegensatz dazu ist der Benchmark auf spezifische Domänen (ML und NLP) beschränkt, was seine Anwendbarkeit auf andere Felder einschränken kann.

ResearchArena (Kang & Xiong, 2024) ist ein Benchmark zur Bewertung von LLM-basierten Agenten in akademischen Übersichten, der den Prozess in drei Phasen unterteilt: Informationsentdeckung, -auswahl und -organisation. Es hilft, die KI-Leistung bei strukturierten Literaturrecherchen zu bewerten, hat aber Schwierigkeiten, die Komplexität realer Recherchen vollständig zu erfassen. CiteME (Press et al., 2024) bewertet die Fähigkeit von Sprachmodellen, wissenschaftliche Behauptungen korrekt ihren Quellen zuzuordnen, wobei der Fokus auf der Literatur des maschinellen Lernens liegt.

Während CiteME einen entscheidenden Aspekt der Literaturrecherche durch die Gewährleistung korrekter Zitierungen adressiert, ist es im Umfang begrenzt, was seine Anwendung in anderen Feldern einschränkt.

Trotz der Fortschritte bestehender Frameworks bleiben mehrere Herausforderungen bei der Automatisierung des Literaturrechercheprozesses bestehen. Obwohl Frameworks wie SciLitLLM und ResearchArena vielversprechende Ergebnisse zeigen, haben sie oft Schwierigkeiten mit Aufgaben, die tiefes domänenspezifisches Wissen und nuanciertes Verständnis erfordern.

Diese Einschränkung wird im Agent Laboratory (Schmidgall et al., 2025) weiter hervorgehoben, wo während der Literaturrecherchephase ein signifikanter Leistungsabfall beobachtet wurde, was die Komplexität der Automatisierung dieses Prozesses unterstreicht. Eine weitere Herausforderung liegt in der Mensch-KI-Kollaboration, da viele bestehende Frameworks vollautonome Arbeitsabläufe priorisieren. Dieser Ansatz kann die Benutzerfreundlichkeit für Forscher einschränken, die ihre einzigartigen Ideen untersuchen möchten, und unterstreicht die Notwendigkeit kollaborativer Ansätze, die menschliche Expertise effektiv mit KI-Fähigkeiten präzise integrieren.

Generalisierbarkeit ist ebenfalls ein großes Hindernis, da viele Frameworks für spezifische Domänen wie maschinelles Lernen, Chemie oder Materialwissenschaften entwickelt wurden, was ihre Anwendung in anderen dynamischen Forschungsfeldern einschränkt.

Der dynamische Einsatz von Agentischer KI im gesamten Forschungsprozess

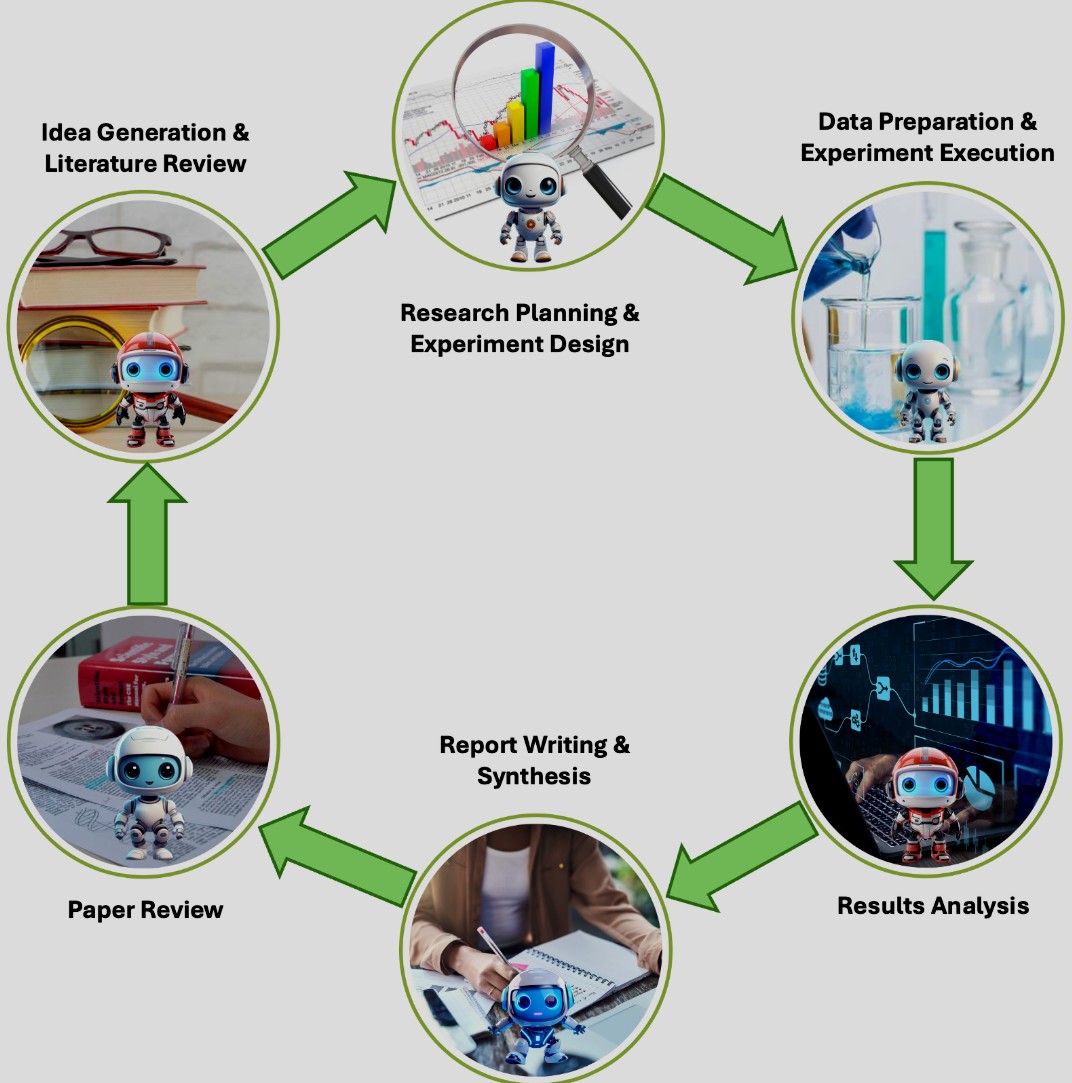

Agentische KI-Systeme revolutionieren den wissenschaftlichen Forschungsprozess, indem sie verschiedene Phasen des Forschungszyklus – von der Ideenfindung und dem Experimentieren bis hin zum Verfassen von Fachartikeln und deren Verbreitung – automatisieren und erweitern. Diese Systeme nutzen die Fähigkeiten von LLMs und anderen KI-Technologien, um Arbeitsabläufe zu optimieren, den menschlichen Aufwand zu reduzieren und das Tempo der wissenschaftlichen Entdeckung präzise zu beschleunigen.

Im Folgenden untersuchen wir, wie Agentische KI die wissenschaftliche Entdeckung transformiert, unterstützt durch Fallstudien und eine Diskussion der wichtigsten Herausforderungen. Der Forschungszyklus umfasst traditionell mehrere Phasen: Problemidentifikation, Literaturrecherche, Hypothesengenerierung, Experimentaldesign, Datenanalyse und Publikation. Agentische KI-Systeme werden eingesetzt, um jede dieser Phasen zu automatisieren oder zu ergänzen, sodass sich Forscher auf übergeordnete Entscheidungen und kreative Problemlösungen konzentrieren können.

Die Hauptschritte, in denen Agentische KI unterstützend oder führend eingreift, sind:

- Ideenfindung (Ideation): Dieser Prozess umfasst das Generieren, Verfeinern und Auswählen von Forschungsideen oder Hypothesen. KI-Agenten automatisieren diesen Prozess, indem sie vorhandene Literatur analysieren, Lücken identifizieren und neuartige Hypothesen vorschlagen, wodurch die Anfangsphasen der Forschung dynamisch beschleunigt werden (Baek et al., 2024).

- Experimentaldesign und -durchführung: Das Experimentaldesign beinhaltet die Planung und Strukturierung von Experimenten zum Testen von Hypothesen, während die Durchführung sich auf die Ausführung dieser Experimente bezieht. KI-Agenten entwerfen und führen komplexe Experimente autonom durch, indem sie Werkzeuge für Planung, Optimierung und robotische Automatisierung integrieren (Boiko et al., 2023).

- Datenanalyse und -interpretation: Die Datenanalyse umfasst die Untersuchung experimenteller Daten zur Gewinnung aussagekräftiger Erkenntnisse, während sich die Interpretation auf das Ziehen von Schlussfolgerungen und das Erkennen von Mustern bezieht. Agenten können große Datensätze verarbeiten und Erkenntnisse generieren, die von Forschern möglicherweise übersehen werden, was die Genauigkeit und Effizienz dieser Phase präzise erhöht.

- Verfassen und Verbreiten von Fachartikeln: Das Verfassen von Artikeln beinhaltet die Synthese von Forschungsergebnissen zu einem kohärenten und strukturierten Manuskript, während die Verbreitung sich auf das Teilen der Forschung mit der wissenschaftlichen Gemeinschaft durch Publikationen oder Präsentationen bezieht. KI-Agenten automatisieren das Schreiben von Forschungsarbeiten, gewährleisten Klarheit, Kohärenz und die Einhaltung akademischer Standards und reduzieren so den Zeit- und Arbeitsaufwand für die Veröffentlichung (Lu et al., 2024).

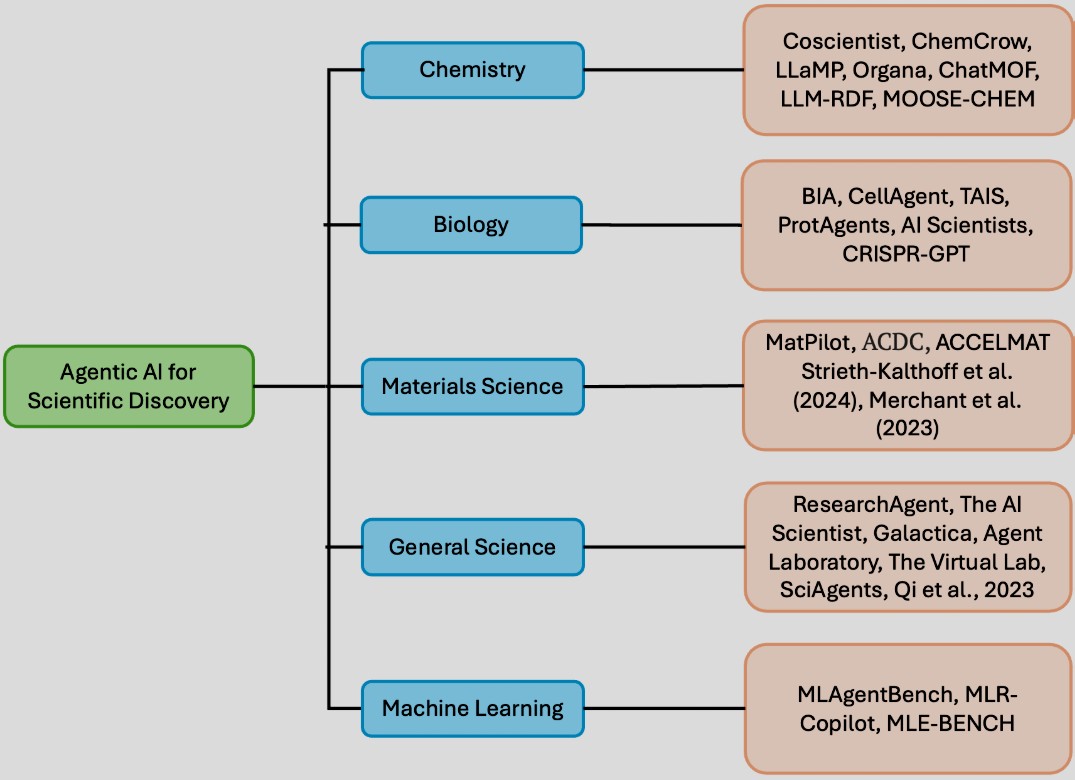

Durch den Einsatz von LLM-erweiterten Agenten haben diese Systeme signifikante Fortschritte in der wissenschaftlichen Entdeckung in Domänen wie Chemie, Biologie, Materialwissenschaften sowie in den allgemeinen Wissenschaften erzielt, wo der Traum darin besteht, einen vollständig autonomen KI-Wissenschaftler zu entwickeln.

Agentische KI in der Chemie: Von Molekülen zu Materialien

In der Chemie transformieren KI-Agenten Schlüsselbereiche wie die Entdeckung und das Design von Molekülen, die Vorhersage von Reaktionen und die Planung von Synthesen, indem sie die Identifizierung neuartiger Verbindungen beschleunigen und Synthesewege optimieren. Zusätzlich tragen sie zur Laborautomatisierung bei, indem sie sich in robotische Systeme integrieren, um Experimente autonom auszuführen, und die computergestützte Chemie durch die Durchführung molekularer Simulationen für Reaktionskinetik und Thermodynamik verbessern.

Coscientist (Boiko et al., 2023) ist ein autonomer KI-Agent, der von GPT-4 angetrieben wird und chemische Experimente plant, entwirft und ausführt. Er integriert Module für Websuche, Dokumentationsanalyse, Codeausführung und robotische Automatisierung und ermöglicht so die Handhabung mehrstufiger Problemlösungen und datengesteuerter Entscheidungen. Beispielsweise entwarf und optimierte Coscientist erfolgreich eine Palladium-katalysierte Kreuzkupplungsreaktion und demonstrierte damit sein Potenzial, die chemische Entdeckung zu beschleunigen. Ähnlich schlugen Ruan et al. (2024) LLM-RDF (Large Language Model Reaction Development Framework) vor, ein Framework, das die chemische Synthese mithilfe von sechs LLM-basierten Agenten für Aufgaben wie Literatursuche, Experimentaldesign, Reaktionsoptimierung und Datenanalyse automatisiert.

Getestet an der Kupfer/TEMPO-katalysierten aeroben Alkoholoxidation demonstriert es die durchgängige Automatisierung der Synthese. Es vereinfacht die Reaktionsentwicklung und macht sie für Chemiker ohne Programmierkenntnisse zugänglicher. Im gleichen Kontext entwickelten Chiang et al. (2024) ein neuartiges Framework namens LLaMP (Large Language Model Made Powerful), das für die wissenschaftliche Entdeckung in der Chemie durch die Integration von RAG mit hierarchischen schlussfolgernden Agenten konzipiert wurde. Es reduziert Halluzinationen in der Materialinformatik signifikant, indem es Vorhersagen auf hochpräzisen Datensätzen des Materials Project (MP) basiert und atomistische Simulationen durchführt.

LLaMP ruft erfolgreich wichtige Materialeigenschaften wie Volumenmodul, Bildungsenergie und elektronische Bandlücke ab und übertrifft dabei Standard-LLMs. Darvish et al. (2024) stellten Organa vor, ein assistierendes Robotersystem zur Automatisierung verschiedener Chemieexperimente, einschließlich Löslichkeitsscreening, pH-Messung, Rekristallisation und elektrochemischer Charakterisierung. Mithilfe von LLMs für Schlussfolgerung und Planung interagiert Organa mit Chemikern in natürlicher Sprache, um Experimentziele abzuleiten und mehrstufige Aufgaben mit paralleler Ausführungskapazität durchzuführen.

In der Elektrochemie demonstrierte es die Automatisierung komplexer Prozesse wie Elektrodenpolitur und Redoxpotentialmessung, wobei Ergebnisse erzielt wurden, die mit menschlichen Chemikern vergleichbar sind, während die Ausführungszeit um über 20 % reduziert wurde. Dieses System verbessert die wissenschaftliche Entdeckung durch die Erhöhung der Reproduzierbarkeit und Effizienz von Chemieexperimenten. Weitere bemerkenswerte Frameworks basierend auf KI-Agenten für die wissenschaftliche Entdeckung in der Chemie umfassen ChatMOF (Kang & Kim, 2023), ChemCrow (M. Bran et al., 2024) und MOOSE-CHEM (Yang et al., 2024).

Agentische KI in der Biologie: Genomik und Wirkstoffforschung neu gedacht

Neben der Chemie transformieren KI-Agenten, angetrieben von LLMs und Multi-Agenten-Systemen, die Biologie, indem sie automatisierte Datenanalyse, Hypothesengenerierung und experimentelle Planung ermöglichen. Diese Agenten können Erkenntnisse aus riesigen Mengen biologischer Daten wie Genomsequenzen, Proteinstrukturen und biomedizinischer Literatur extrahieren, um die Forschung in Bereichen wie Genetik, Wirkstoffentdeckung und synthetische Biologie dynamisch zu beschleunigen.

Mit Fähigkeiten wie dem Design von Gen-Editierungen, Protein-Engineering und der Modellierung von Systembiologie spielen KI-Agenten eine entscheidende Rolle in der wissenschaftlichen Entdeckung für die Biologie. Durch die Integration mit Laborwerkzeugen und robotischen Systemen reduzieren sie nicht nur den menschlichen Aufwand, sondern verbessern auch die Genauigkeit und Reproduzierbarkeit der Forschung und bringen uns zukunftsweisenden Durchbrüchen in der personalisierten Medizin, Krankheitsmodellierung und Bioinformatik näher.

Xin et al. (2024) stellten BIA (BioInformatics Agent) vor, einen KI-Agenten, der LLMs nutzt, um Bioinformatik-Workflows zu optimieren, insbesondere mit Fokus auf die Analyse von Einzelzell-RNA-Sequenzierungsdaten (scRNA-seq). BIA automatisiert komplexe Aufgaben wie Datenabruf, Metadatenextraktion und Workflow-Generierung und verbessert so die Effizienz der Bioinformatikforschung erheblich. Es verfügt über eine Chat-basierte Schnittstelle zum Entwerfen experimenteller Protokolle, zum Aufrufen von Bioinformatik-Tools und zum Erstellen umfassender Analyseberichte ohne Programmierung.

BIAs innovative Nutzung der statischen und dynamischen Workflow-Anpassung ermöglicht es, Bioinformatik-Analysen iterativ zu verfeinern und demonstriert sein Potenzial, die kognitive Belastung von Forschern zu reduzieren und die wissenschaftliche Entdeckung in Genomik und Transkriptomik präzise zu verbessern. Ähnlich entwickelten Xiao et al. (2024) CellAgent, ein LLM-getriebenes Multi-Agenten-System zur Automatisierung der Analyse von Einzelzell-RNA-Sequenzierungsdaten.

Es verfügt über drei Expertenrollen: Planer, Ausführer und Bewerter, die zusammenarbeiten, um Datenanalyseaufgaben wie Batch-Korrektur, Zelltyp-Annotation und Trajektorieninferenz zu planen, auszuführen und zu bewerten. CellAgent reduziert menschliche Interventionen durch einen selbstiterativen Optimierungsmechanismus, erreicht eine Aufgabenerledigungsrate von 92 % und übertrifft andere scRNA-seq-Tools in Genauigkeit und Zuverlässigkeit. Dieses Framework verbessert die Effizienz biologischer Forschung signifikant, macht die scRNA-seq-Analyse für Nicht-Experten zugänglich und ermöglicht neue biologische Entdeckungen.

Liu et al. (2024) entwickelten TAIS (Team of AI-made Scientists), einen teilautonomen KI-Assistenten für die genetische Forschung, der darauf ausgelegt ist, biologische Experimente mittels selbstlernender Mechanismen vorzuschlagen und zu verfeinern. Er hilft Wissenschaftlern bei der Datenanalyse, Hypothesengenerierung und Experimentplanung, erfordert jedoch eine menschliche Validierung vor der Ausführung. Weitere Arbeiten umfassen ProtAgents (Ghafarollahi & Buehler, 2024a), AI Scientists (Gao et al., 2024) und CRISPR-GPT (Huang et al., 2024a).

Über diese spezifischen Domänen hinaus werden KI-Agenten auch intensiv in anderen Feldern wie den Materialwissenschaften (Ni et al., 2024; Maqsood et al., 2024), den allgemeinen Wissenschaften (Taylor et al., 2022; Schmidgall et al., 2025) und dem maschinellen Lernen (Li et al., 2024b) erforscht und eingesetzt, was die dynamische und breite Anwendbarkeit dieser zukunftsweisenden Technologie unterstreicht.

Werkzeuge, Datensätze und Metriken: Das Fundament Agentischer KI

Die Entwicklung und Evaluierung von Agentischen KI-Systemen für die wissenschaftliche Entdeckung stützt sich auf robuste Werkzeuge, sorgfältig kuratierte Datensätze und klar definierte Bewertungsmetriken. Dieser Abschnitt bietet einen präzisen Überblick über die Schlüsselressourcen, die in diesem dynamischen Feld verwendet werden, um das Design, das Training und die Bewertung autonomer KI-Agenten für die wissenschaftliche Entdeckung zu erleichtern.

Implementierungswerkzeuge: Von AutoGen bis LangChain

Agentische KI-Systeme nutzen eine Kombination aus grundlegenden Modellen, Berechnungsframeworks und domänenspezifischen Werkzeugen, um wissenschaftliche Aufgaben effektiv auszuführen. Diese Werkzeuge unterstützen die Erstellung von Einzel- und Multi-Agenten-Frameworks. AutoGen (Wu et al., 2023) ist ein umfassendes Framework für das Management von Multi-Agenten-Systemen, das auf der Idee „anpassbarer und dialogfähiger Agenten“ basiert.

Es ermöglicht Entwicklern, Agenten sowohl in natürlicher Sprache als auch in Code zu definieren oder zu programmieren, was es vielseitig für Anwendungen macht, die von technischen Bereichen wie Codierung und Mathematik bis hin zu verbraucherorientierten Sektoren wie Unterhaltung reichen. MetaGPT (Hong et al., 2024), ein intelligentes agentenbasiertes Framework, optimiert den Softwareentwicklungsprozess. Es legt Wert darauf, menschliche Arbeitsabläufe in die Aufgaben von LM-Agenten einzubetten und eine Fließbandmethode zu verwenden, um verschiedenen Agenten spezifische Rollen zuzuweisen.

Letta, ein Open-Source-Agentenframework, ermöglicht den einfachen Aufbau und die Bereitstellung persistenter Agenten als Dienste. Letta basiert hauptsächlich auf dem aktuellen MemGPT-Paper (Packer et al., 2023) und zeichnet sich als das Framework aus, das explizit kognitive Architekturprinzipien berücksichtigt. Weitere einflussreiche Werkzeuge sind CAMEL (Li et al., 2023), LangChain und AutoGPT (Yang et al., 2023a), die alle zur zukunftsweisenden Entwicklung in diesem Bereich beitragen.

Datensätze und Benchmarks: Die Testumgebung für KI-Wissenschaftler

Für wissenschaftliches Schlussfolgern und Entdecken sind die meisten Datensätze darauf ausgelegt, die Schlussfolgerungs-, Planungs- und Kollaborationsfähigkeiten mehrerer KI-Agenten bei Aufgaben wie Hypothesengenerierung, Literaturanalyse und experimenteller Planung zu bewerten. In Biologie und Chemie werden Datensätze wie LAB-Bench (Laurent et al., 2024) und MoleculeNet (Wu et al., 2018) verwendet, um die Fähigkeit von Agenten zu benchmarken, komplexe biologische und chemische Daten zu verstehen und zu analysieren.

In aufstrebenden Bereichen wie der Materialentdeckung und der Automatisierung des gesamten Forschungsprozesses besteht jedoch weiterhin Bedarf an umfassenden Benchmarks, die die reale Wirkung und Anpassungsfähigkeit der Agenten bewerten. Die Entwicklung solcher Benchmarks würde die Bewertung von Agentischen KI-Systemen erheblich verbessern und Forschern helfen, ihre Anwendbarkeit in komplexen und dynamischen Feldern wie Genomik, Wirkstoffentdeckung und synthetischer Biologie präzise einzuschätzen.

Hier eine tabellarische Übersicht wichtiger Datensätze und Benchmarks:

| Dataset/Benchmark | Domäne | Zweck |

|---|---|---|

| LAB-Bench (Laurent et al., 2024) | Biologie | Bewertung von Schlussfolgerung und Planung für biologische Forschung |

| MoleculeNet (Wu et al., 2018) | Chemie | Vorhersage molekularer Eigenschaften |

| ZINC Database (Irwin et al., 2012) | Chemie | Virtuelles Screening für Wirkstoffentdeckung |

| MatText (Alampara et al., 2024) | Materialwissenschaften | Textbasierte Vorhersage von Materialeigenschaften |

| MatSci-NLP (Song et al., 2023) | Materialwissenschaften | Sprachverarbeitung für Materialwissenschaften |

| MaScQA (Zaki et al., 2024) | Materialwissenschaften | QA für Materialwissenschaften |

| ChEMBL (Gaulton et al., 2012) | Chemie | Vorhersage bioaktiver Moleküle |

| PubChem (Kim et al., 2016) | Chemie | Extraktion molekularer Merkmale |

| Mol-Instructions (Fang et al., 2023) | Biologie/Chemie | Protein- und biomolekülbezogene Aufgaben |

| MPcules (Spotte-Smith et al., 2023) | Materialwissenschaften | Molekulare Eigenschaften |

| AlphaFold Protein Structure (Varadi et al., 2022) | Biologie | Vorhersage von Proteinstrukturen |

| ICLR 2022 OpenReview (Lu et al., 2024) | Wissenschaftl. Forschung | Leistungsbewertung des automatisierten Paper-Reviewers |

Metriken: Die Messlatte für den Erfolg

Die Metriken in diesem Feld sind vielfältig und hängen von der spezifischen Aufgabe und Domäne ab. Für Schlussfolgerung und Planung bewerten Metriken typischerweise Genauigkeit, Aufgabenerledigungsraten und Kohärenz der Antworten. Bei experimentellen Vorhersagen und wissenschaftlicher Entdeckung werden Metriken wie Präzision, Recall und Vorhersagefehler verwendet, um die Qualität und Zuverlässigkeit der von KI generierten Ergebnisse zu bewerten. Erklärbarkeit und menschliche Bewertung spielen ebenfalls eine entscheidende Rolle bei der Beurteilung, wie gut diese Systeme mit wissenschaftlichen Zielen übereinstimmen.

Das kürzlich vorgeschlagene Framework Agent Laboratory (Schmidgall et al., 2025) führt zusätzliche Bewertungsmetriken ein, die eine umfassendere Bewertung von Agentischen KI-Systemen ermöglichen. Dazu gehören Metriken zur Bewertung von wissenschaftlichen Veröffentlichungen im Stil von NeurIPS wie Qualität, Signifikanz, Klarheit, Stichhaltigkeit, Präsentation und Beitrag. Erfolgsraten verfolgen den Prozentsatz erfolgreich abgeschlossener Arbeitsabläufe, während Vergleiche zwischen menschlichen und automatisierten Gutachtern Konsistenz und Zuverlässigkeit in den Bewertungen gewährleisten. Usability- und Zufriedenheitsmetriken wie Nützlichkeit, Fortführungswille und Nutzerzufriedenheit werden eingesetzt, um die Benutzerfreundlichkeit des Systems und das allgemeine Nutzererlebnis präzise zu bewerten.

Für komplexere Aufgaben, wie die Kooperation von Multi-Agenten-Systemen bei der experimentellen Automatisierung und Hypothesengenerierung, befinden sich standardisierte Bewertungsmetriken jedoch noch in der dynamischen Entwicklung. Die Etablierung umfassender Metriken, die objektive Leistungsmaße (z. B. Erfolgsraten und Vorhersagegenauigkeit) mit subjektiven menschlichen Bewertungen (z. B. Nutzerzufriedenheit und Erklärbarkeit) kombinieren, wird entscheidend sein, um die Leistung dieser zukunftsweisenden Systeme in realen Anwendungen genau zu messen.

Herausforderungen und offene Probleme: Der Weg zur verlässlichen Agentischen KI

Obwohl Agentische KI-Systeme ein immenses zukunftsweisendes Potenzial für die Transformation der wissenschaftlichen Entdeckung bergen, stehen sie auch vor signifikanten Herausforderungen, die präzise angegangen werden müssen, um ihr volles Potenzial auszuschöpfen. In diesem Abschnitt diskutieren wir die Hauptherausforderungen, mit denen das Feld der Agentischen KI für die wissenschaftliche Entdeckung konfrontiert ist, und beleuchten die dynamischen Anstrengungen zu deren Bewältigung.

Vertrauenswürdigkeit: Die Basis für wissenschaftlichen Einsatz

Aktuelle Forschungsarbeiten betonen die Vermeidung von Overfitting, um reale Bedingungen widerzuspiegeln und die Vorhersagbarkeit von KI-Agenten zu verbessern (Kapoor et al., 2024). Der Fokus auf die Sicherung der Agentenleistung (Agentic Assurance) und die Vertrauenswürdigkeit von KI-Agenten für die wissenschaftliche Entdeckung umfasst robuste Benchmarking-Praktiken, um die Zuverlässigkeit und Effektivität von KI-Agenten in realen Anwendungen sicherzustellen. Es unterstreicht die Notwendigkeit kostenkontrollierter Bewertungen und der gemeinsamen Optimierung von Leistungsmetriken wie Genauigkeit, Kosten, Geschwindigkeit, Durchsatz und Zuverlässigkeit (z. B. Ausfallraten von Aufgaben, Wiederherstellung nach Ausfällen).

Dieser Ansatz zielt darauf ab, effiziente, praktische KI-Agenten für den realen Einsatz zu entwickeln und übermäßig komplexe und kostspielige Designs zu vermeiden. Laufende Bemühungen konzentrieren sich auch auf die Verbesserung der Erklärbarkeit und Sicherheit von KI-Agenten, um sicherzustellen, dass ihre Handlungen und Entscheidungen von Menschen verstanden und überprüft werden können. Dies beinhaltet die Entwicklung von Methoden, um das Verhalten der KI interpretierbarer zu machen und klare Erklärungen für ihre Entscheidungen zu liefern. Die Forschung hebt die Bedeutung der Vermeidung von Overfitting hervor und stellt sicher, dass Benchmarks so konzipiert sind, dass sie reale Bedingungen widerspiegeln, wodurch der praktische Nutzen von KI-Agenten erhöht wird (Li et al., 2024a; Aliferis & Simon, 2024).

Diese Bemühungen betonen die Notwendigkeit robuster Bewertungsframeworks, um eine hohe Generalisierungsleistung aufrechtzuerhalten. Zusätzlich tragen innovative Methoden zur Erkennung und Verhinderung von Overfitting weiter zur Zuverlässigkeit und Vertrauenswürdigkeit von KI-Systemen bei. Diese Studien unterstreichen insgesamt die Notwendigkeit umfassender Bewertungspraktiken, um KI-Agenten zu entwickeln, die sowohl präzise als auch verlässlich in realen Szenarien sind.

Ethische und praktische Überlegungen: Verantwortung im Code

Ethische Überlegungen und Prinzipien stehen im Mittelpunkt vieler Forschungsgruppen sowohl in der Wissenschaft als auch in der Industrie. Ethik spielt eine entscheidende Rolle bei der Entwicklung und dem Einsatz von KI-Agenten, insbesondere in kritischen Bereichen wie dem Gesundheitswesen. Die Handhabung von Bias ist ein zentrales ethisches Risiko, zusätzlich zu anderen Aspekten wie Datenschutz, Rechenschaftspflicht und Compliance. Daher besteht ein dringender Bedarf an Transparenz, Rechenschaftspflicht und Fairness bei der Gestaltung von KI-Agenten sowie die Notwendigkeit, diese Werte während des gesamten Entwicklungszyklus präzise zu priorisieren. Bei der Integration von LLMs in autonome Agenten werden ethische Herausforderungen noch ausgeprägter.

LLMs können naturgemäß bestehende Verzerrungen in Trainingsdaten verstärken, was potenziell zu unethischen oder schädlichen Ergebnissen führen kann. Sie bergen auch Risiken bei der Generierung irreführender, fabrizierter oder kontextuell unangemessener Antworten (Halluzinationen), was besonders in kritischen Domänen wie dem Gesundheitswesen nachteilig ist. Agentenspezifische Herausforderungen verschärfen diese ethischen Überlegungen weiter. Zukünftig könnten autonome Agenten oft kollaborativ in dezentralen Umgebungen oder mit Werkzeugaufruffähigkeiten operieren, wie z. B. der Automatisierung von Finanztransaktionen oder der Verwaltung sensibler Gesundheitsdaten.

Wenn sich ein Agent in einem Multi-Agenten-System unethisch verhält – sei es aufgrund von adversarieller Manipulation, unvollständiger ethischer Ausrichtung oder systemischem Bias – kann dies die Integrität des gesamten Systems dynamisch gefährden. Die Bewältigung dieser Probleme erfordert robuste Aufsichtsmechanismen, Mensch-Maschine-Architekturen (Human-in-the-Loop) und Frameworks zur Bewertung und Minderung dieser Risiken während Training und Einsatz. Algorithmen zur Bias-Erkennung und -Minderung, wie adversarielles Debasing (Lim et al., 2023) und Reweighting (Zhu et al., 2021), können in den Trainingsprozess integriert werden, um das Risiko der Perpetuierung bestehender Verzerrungen zu minimieren und die Erkennung und Korrektur von Verzerrungen sowohl in Daten als auch in Modellausgaben zu ermöglichen.

Potenzielle Risiken: Wenn Autonomie zur Gefahr wird

Agentische KI bietet aufregende Möglichkeiten in der wissenschaftlichen Entdeckung, birgt aber auch signifikante Risiken. Da diese Systeme komplexe Aufgaben übernehmen – wie Datenanalyse, Hypothesengenerierung und Experimentdurchführung – werden Datenzuverlässigkeit und Bias zu Hauptanliegen. Fehlerhafte oder unvollständige Daten können Fehler verbreiten, was zu falschen Ergebnissen oder nicht reproduzierbaren Resultaten führt. Der Mangel an menschlicher Aufsicht bei hochautonomen Agenten erhöht das Risiko der Fehlerfortpflanzung, was in Feldern wie Chemie und Biologie, wo Präzision und Sicherheit entscheidend sind, schwerwiegende Folgen haben kann.

Darüber hinaus kann eine Fehlausrichtung der Agenten auf die Forschungsziele zu irrelevanten oder verschwenderischen Experimenten führen, während Multi-Agenten-Systeme unter Koordinationsfehlern leiden können. In der experimentellen Automatisierung könnten Agenten von etablierten Protokollen abweichen oder wichtige Sicherheitsmaßnahmen übersehen, was potenziell zu gefährlichen Ergebnissen führen kann. Mit wachsender Autonomie müssen die Vorhersagbarkeit und Kontrolle dieser Agenten sorgfältig überwacht werden, um unbeabsichtigte Aktionen zu vermeiden, die in Echtzeit schwer zu erkennen oder zu korrigieren sind. Schließlich muss der „Explosionsradius“ (Blast Radius) dieser Agenten – insbesondere jener, die in robotische Labore integriert sind – genau definiert werden.

Autonome Agenten, die mit physischen Systemen interagieren, könnten situative Kontexte falsch interpretieren, was zu unerwarteten Eskalationen oder Systemausfällen führen kann. Die Gewährleistung einer robusten KI-Governance und menschlicher Aufsicht ist entscheidend, um diese Risiken zu mindern, die Zuverlässigkeit aufrechtzuerhalten und die Rolle der KI als kollaboratives Werkzeug anstatt als unabhängiger Entscheidungsträger in der wissenschaftlichen Forschung präzise zu stärken.

Schlussfolgerung und zukunftsweisende Perspektiven für Agentische KI in der Forschung

Die Agentische KI für die wissenschaftliche Entdeckung hat inspirierende Ergebnisse in Domänen wie Chemie, Biologie und Materialwissenschaften gezeigt und zieht ein wachsendes Forschungsinteresse auf sich. In diesem Survey haben wir systematisch Ansätze der Agentischen KI für die wissenschaftliche Entdeckung überprüft, indem wir verschiedene Aspekte ihrer funktionalen Frameworks präzise untersucht haben. Darüber hinaus haben wir ihre Taxonomie, die wichtige Rolle der Literaturrecherche in ihrem Workflow und verschiedene in den letzten Jahren vorgeschlagene Ansätze zusammengefasst.

Indem wir weit verbreitete Datensätze und Benchmarks hervorheben sowie aktuelle Herausforderungen und offene Probleme adressieren, zielen wir darauf ab, dass dieser Survey als wertvolle Ressource für Forscher dient, die Agentische KI für die wissenschaftliche Entdeckung nutzen. Wir hoffen, er inspiriert zu weiterer dynamischer Erforschung des Potenzials dieses Forschungsbereichs und ermutigt zu zukünftigen Forschungsanstrengungen.

Unsere Analyse zeigt, dass frühere Systeme zwar in Bereichen wie Chemie, Biologie und den allgemeinen Wissenschaften gut abgeschnitten haben, die Literaturrecherche jedoch bei fast allen Ansätzen eine signifikante Herausforderung bleibt, insbesondere bei Aufgaben wie der Generierung von Forschungsideen (Baek et al., 2024) und der wissenschaftlichen Entdeckung (Schmidgall et al., 2025). Beispielsweise berichteten Schmidgall et al. (2025), dass unter den Phasen Datenaufbereitung, Experimentieren, Berichtserstellung und Forschungsberichtgenerierung die Literaturrecherchephase die höchste Ausfallrate aufwies.

Ähnlich ist ResearchAgent zwar effektiv bei der Generierung neuartiger Forschungsideen, ihm fehlt jedoch die Fähigkeit, strukturierte Literaturrecherchen durchzuführen, die unerlässlich sind, um generierte Ideen in vorhandenem Wissen zu verankern (Baek et al., 2024). Dieselbe Einschränkung wurde im Framework The AI Scientist (Lu et al., 2024) beobachtet.

Eine weitere wichtige zukunftsweisende Richtung ist die Integration von Kalibrierungstechniken in KI-Agenten, um die Genauigkeit und Zuverlässigkeit ihrer Ergebnisse in der wissenschaftlichen Entdeckung zu verbessern. Kalibrierung stellt sicher, dass das Vertrauen des Systems in seine Vorhersagen mit deren tatsächlicher Korrektheit übereinstimmt, was in Hochrisikodomänen wie dem Gesundheitswesen entscheidend ist.

Durch die Integration dieser Techniken könnten KI-Agenten zu vertrauenswürdigeren und effektiveren Werkzeugen für Forscher werden und die Zuverlässigkeit ihrer Beiträge zur wissenschaftlichen Forschung präzise erhöhen. Die fortlaufende Entwicklung und Verfeinerung von Agentischer KI verspricht, die Grenzen dessen, was in der Forschungsautomatisierung möglich ist, dynamisch zu erweitern und eine neue Ära der beschleunigten und erkenntnisreichen wissenschaftlichen Entdeckung einzuläuten, in der Du und Deine Kollegen von leistungsstarken, intelligenten Assistenten unterstützt werdet. Die sorgfältige Adressierung der genannten Herausforderungen wird der Schlüssel sein, um dieses transformative Potenzial voll auszuschöpfen.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Gridach, M., Nanavati, J., Zine El Abidine, K., Mendes, L., & Mack, C. (2025). Agentic AI for Scientific Discovery: A Survey of Progress, Challenges, and Future Directions. arXiv:2503.08979 [cs.CL]. Verfügbar unter: https://doi.org/10.48550/arXiv.2503.08979 (Zugriff am 10. Mai 2025).

#KI #AI #ArtificialIntelligence #KuenstlicheIntelligenz #AgentischeKI #WissenschaftlicheEntdeckung #Forschungsautomatisierung #ZukunftDerForschung