Im rasanten Universum des Prompt Engineerings jagt eine Innovation die nächste – und wer hier bestehen will, für den ist Effizienz kein Nice-to-have, sondern schlichtweg überlebensnotwendig. Wir alle kennen das: Standard Prompts sind nützlich, Chain-of-Thought (CoT) Prompts (also alle Modelle, die Reasoning-Modell sind, wie OpenAI o1, mini-3, Grok 3, Google Gemini 2.0 Flash, DeepSeek R1) gehen beim „nachdenken“ ins Detail, und die Modelle schreiben für eine kurze Frage einen kilometerlangen Roman . Und hier – genau hier – liegt der Clou: Genauso wie im Alltag brauchen wir auch im Prompt Engineering clevere Abkürzungen.

Denn das Geniale ist: Um wirklich effiziente Prompts zu bauen, musst niemand ein teures Modell neu trainieren oder Millionen investieren – es ist reine Prompt-Magie!

Stell Dir klassische Prompting-Methoden oft wie verschlungene Denknoten vor: Ausführliche Beschreibungen, komplexe Schritt-für-Schritt Anweisungen, endlose Beispiele – das kostet Zeit, Nerven und vor allem: wertvolle Zyklen im Testprozess und Anlauf um ein Deployment fertiger Lösungen. Klar, detaillierte Prompts können in bestimmten Situationen notwendig sein, keine Frage. Aber warum kompliziert, wenn es auch easy geht? Warum seitenlange Anleitungen, wenn ein prägnanter Impuls reicht, um das gewünschte Ergebnis aus der KI herauszukitzeln? Hier tritt Chain of Draft (CoD) Prompting auf den Plan: eine brandneue Methode, die sich von unserem Denkprozess im Alltag inspirieren lässt – kurz, prägnant, und direkt auf den Punkt, wie ein perfekter Tweet im Vergleich zu Romanwälzern.

In diesem Artikel analysieren wir deshalb die Chain of Draft (CoD) Prompting Methodik. Wir lüften das Geheimnis dieser faszinierenden Technik, zeigen Dir die handfesten Vorteile anhand leuchtender Beispiele und verständlicher Vergleiche und geben Dir praktische Guidance an die Hand: Wann und für welche Fälle CoD Dein persönlicher Gamechanger im Prompt Engineering sein kann – und wann vielleicht doch der klassische „Roman“ die bessere Wahl ist. Mach Dich bereit für einen Effizienz-Boost in Deiner Prompt-Praxis – Du wirst staunen, was mit kurer, kluger Fragestellung alles möglich ist!

Das musst Du wissen – Chain of Draft Prompting: Denk schneller, schreib kürzer – Dein Turbo für KI-Effizienz

- Blitzschnelle Antworten: CoD verschlankt den Output, reduziert die Token-Anzahl und damit die Latenz – ideal für Echtzeit-Anwendungen.

- Spar-Genie: Weniger Tokens bedeuten weniger Kosten. Stell dir vor, du fährst mit einem超effizienten Hybrid in den KI-Olymp.

- Smarte & schlanke Präzision: Trotz der Kürze liefert CoD akkurate Ergebnisse, die fast an den detaillierten CoT-Ansatz heranreichen und ihn in symbolischen Aufgaben sogar übertreffen.

- Kein Overthinking mehr: CoD konzentriert sich auf das Wesentliche und vermeidet so unnötige Komplikationen und Halluzinationen, die bei ausführlichen Modellen auftreten können.

Hauptfrage: Was genau ist Chain of Draft Prompting und wie katapultiert es meine KI-Projekte in Sachen Effizienz auf ein neues Level?

Folgefragen (FAQs)

Was ist Chain of Draft Prompting (CoD) im Detail?

Wie unterscheidet sich CoD von traditionellen Prompting-Methoden wie Standard Prompting und Chain-of-Thought (CoT)?

Welche konkreten Vorteile bietet Chain of Draft Prompting gegenüber Chain-of-Thought Prompting?

In welchen Anwendungsfällen spielt Chain of Draft Prompting seine Stärken besonders aus?

Gibt es auch Situationen, in denen andere Prompting-Methoden besser geeignet sind als CoD?

Wie erstelle ich effektive Chain-of-Draft Prompts für meine KI-Projekte?

Welche Rolle spielt die Begrenzung auf fünf Wörter pro Denkschritt bei CoD?

Kann ich Chain of Draft Prompting mit anderen Latency-Reduzierungs-Methoden kombinieren?

Schritt für Schritt Anleitung für Deinen besten Chain of Draft Prompt

Antworten auf jede Frage

Was ist Chain of Draft Prompting (CoD) im Detail?

Chain of Draft (CoD) Prompting ist eine innovative Prompting-Strategie für Large Language Models (LLMs), die auf maximale Effizienz abzielt. Der Clou: CoD ermutigt LLMs, prägnante, aber dennoch informative Zwischenschritte im Denkprozess zu generieren. Statt ausführlicher, wortreicher Begründungen, wie sie beim Chain-of-Thought (CoT) Prompting üblich sind, fokussiert sich CoD auf essentielle Informationen und Berechnungen.

Stell dir vor, du löst ein komplexes Rätsel. Anstatt jeden Gedankengang in langen Sätzen auszuschreiben, machst du dir nur kurze Notizen, Skizzen oder Formeln – eben „Drafts“ deiner Gedanken. Genau dieses Prinzip adaptiert CoD für LLMs. Es geht darum, die Verbosität zu reduzieren und sich auf die kritischen Einsichten zu konzentrieren. Dadurch werden Token-Verbrauch, Kosten und Latenz signifikant gesenkt, während die Genauigkeit im Idealfall erhalten bleibt oder sogar verbessert wird.

Das Kernprinzip von CoD ist die Limitierung der Wortanzahl pro Denkschritt. Empfohlen werden maximal fünf Wörter. Diese Beschränkung zwingt das Modell, sich auf das absolute Minimum zu konzentrieren und unwesentliche Details wegzulassen. Das Ergebnis sind dichte, informationsreiche Zwischenschritte, die den Denkprozess transparent machen, aber gleichzeitig extrem effizient sind.

CoD ist inspiriert von menschlichen Denkprozessen. Wenn wir komplexe Probleme lösen, neigen wir dazu, uns kurze Notizen zu machen, um unsere Gedanken zu strukturieren und festzuhalten. Wir elaborieren nicht jeden Schritt ausführlich, sondern fokussieren uns auf die wesentlichen Punkte. CoD emuliert dieses natürliche, effiziente Denkmuster und ermöglicht es LLMs, schneller und kostengünstiger zu denken, ohne dabei an Qualität einzubüßen.

Wie unterscheidet sich CoD von traditionellen Prompting-Methoden wie Standard Prompting und Chain-of-Thought (CoT)?

Um die Unterschiede zwischen Chain of Draft (CoD) und traditionellen Prompting-Methoden wie Standard Prompting und Chain-of-Thought (CoT) zu verstehen, hilft ein direkter Vergleich anhand verschiedener Kriterien:

| Kriterium | Standard Prompting | Chain-of-Thought (CoT) Prompting | Chain-of-Draft (CoD) Prompting |

| Reasoning | Keine explizite Darstellung des Denkprozesses | Ausführliche, schrittweise Darstellung des Denkprozesses | Prägnante, minimale Darstellung des Denkprozesses |

| Verbosität | Minimal, direkte Antwort | Sehr hoch, ausführliche Erklärungen | Sehr gering, Fokus auf essentielle Informationen |

| Token-Verbrauch | Sehr gering | Sehr hoch | Sehr gering, signifikant reduziert im Vergleich zu CoT |

| Latenz | Sehr gering | Hoch | Gering, signifikant reduziert im Vergleich zu CoT |

| Genauigkeit | Kann bei komplexen Aufgaben ungenau sein | Sehr hoch, verbessert Genauigkeit bei komplexen Aufgaben | Sehr hoch, vergleichbar oder besser als CoT |

| Effizienz | Hoch für einfache Aufgaben, gering für komplexe Aufgaben | Gering, hoher Ressourcenverbrauch | Sehr hoch, effizient auch bei komplexen Aufgaben |

| Menschenähnlichkeit | Weniger menschenähnlich (keine Denkprozess-Darstellung) | Ähnlicher menschlichem Denken (schrittweise Argumentation) | Sehr ähnlich menschlichem Denken (kurze Notizen, Entwürfe) |

| Anwendungsfälle | Einfache Fragen, schnelle Antworten | Komplexe Reasoning-Aufgaben, detaillierte Erklärungen | Effiziente Reasoning-Aufgaben, Echtzeit-Anwendungen, Kosten-sensitive Projekte |

Standard Prompting:

- Direkte Antwort: Standard Prompting zielt auf eine direkte, unmittelbare Antwort ab, ohne explizite Darstellung des Denkprozesses.

- Minimalistisch: Es ist die einfachste und ressourcenschonendste Methode, aber oft unzureichend für komplexe Aufgaben, die Reasoning erfordern.

- Beispiel: „Wie viele Planeten hat unser Sonnensystem?“ -> „Acht.“

Chain-of-Thought (CoT) Prompting:

- Ausführliches Reasoning: CoT Prompting fordert das Modell auf, den Denkprozess Schritt für Schritt darzustellen.

- Verbosität: CoT generiert ausführliche, wortreiche Erklärungen, die den Denkprozess transparent machen, aber auch den Token-Verbrauch und die Latenz erhöhen.

- Genauigkeit: CoT verbessert die Genauigkeit bei komplexen Reasoning-Aufgaben signifikant, da das Modell den Lösungsweg explizit darlegen muss.

- Beispiel: „Wie viele Planeten hat unser Sonnensystem? Begründe deine Antwort Schritt für Schritt.“ -> „Unser Sonnensystem hat acht Planeten. Früher wurde Pluto als neunter Planet gezählt, aber er wurde 2006 zum Zwergplaneten herabgestuft. Die acht Planeten sind Merkur, Venus, Erde, Mars, Jupiter, Saturn, Uranus und Neptun.“

Chain-of-Draft (CoD) Prompting:

- Prägnantes Reasoning: CoD Prompting konzentriert sich auf minimale, abstrakte Repräsentationen des Denkprozesses.

- Effizienz: CoD reduziert die Verbosität drastisch, was zu geringerem Token-Verbrauch, niedrigerer Latenz und geringeren Kosten führt.

- Genauigkeit: Trotz der Kürze erreicht CoD eine vergleichbare oder sogar bessere Genauigkeit als CoT, insbesondere bei Aufgaben, bei denen es auf essentielle Informationen ankommt.

- Beispiel: „Wie viele Planeten hat unser Sonnensystem? Gib die Antwort in Form einer kurzen Gleichung an.“ -> „8 Planeten. Planetenanzahl = 8.“

Zusammenfassend lässt sich sagen, dass Standard Prompting für einfache, schnelle Antworten geeignet ist, Chain-of-Thought Prompting für komplexe Reasoning-Aufgaben und detaillierte Erklärungen, und Chain-of-Draft Prompting für effiziente Reasoning-Aufgaben, Echtzeit-Anwendungen und kosten-sensitive Projekte, bei denen Geschwindigkeit und Kosteneffizienz im Vordergrund stehen, ohne die Genauigkeit zu vernachlässigen.

Welche konkreten Vorteile bietet Chain of Draft Prompting gegenüber Chain-of-Thought Prompting?

Chain of Draft (CoD) Prompting bietet gegenüber Chain-of-Thought (CoT) Prompting eine Reihe konkreter Vorteile, die in verschiedenen Anwendungsfällen entscheidend sein können:

1. Reduzierte Latenz:

- Kürzerer Output: CoD generiert signifikant kürzere Reasoning-Schritte als CoT, da die Wortanzahl pro Schritt limitiert ist.

- Schnellere Antwortzeiten: Durch den geringeren Output wird die Latenz, also die Zeit bis zur Antwortgenerierung, drastisch reduziert. Dies ist besonders wichtig für Echtzeit-Anwendungen, wie z.B. Chatbots, interaktive Assistenten oder Systeme, die in schnellen Feedback-Schleifen agieren müssen.

- Beispiel aus dem Forschungspapier: CoD reduziert die Latenz im Vergleich zu CoT um bis zu 76,2% bei bestimmten Aufgaben.

2. Geringere Kosten:

- Weniger Token-Verbrauch: CoD verbraucht deutlich weniger Tokens als CoT, da die generierten Texte kürzer sind.

- Kosteneffizienz: Da die Kosten für die Nutzung von LLMs oft tokenbasiert sind, führt der geringere Token-Verbrauch direkt zu geringeren Kosten. Dies ist besonders relevant für großvolumige Anwendungen oder kosten-sensitive Projekte.

- Beispiel aus dem Forschungspapier: CoD reduziert den Token-Verbrauch im Vergleich zu CoT um bis zu 80% bei bestimmten Aufgaben.

3. Vergleichbare oder sogar verbesserte Genauigkeit:

- Fokus auf das Wesentliche: Die Beschränkung auf kurze, prägnante Reasoning-Schritte zwingt das Modell, sich auf die essentiellen Informationen zu konzentrieren und unwichtige Details wegzulassen.

- Vermeidung von Overthinking: CoD kann Overthinking und Redundanzen vermeiden, die bei ausführlichen CoT-Prompts auftreten können. Dies kann in manchen Fällen sogar zu einer höheren Genauigkeit führen, insbesondere bei symbolischen Reasoning-Aufgaben.

- Beispiel aus dem Forschungspapier: CoD erreicht in verschiedenen Experimenten eine vergleichbare oder sogar bessere Genauigkeit als CoT, während es gleichzeitig deutlich effizienter ist.

4. Bessere Eignung für bestimmte Aufgaben:

- Symbolisches Reasoning: CoD scheint besonders stark im symbolischen Reasoning zu sein, wo es oft eine perfekte Genauigkeit erreicht und gleichzeitig den Token-Verbrauch massiv reduziert.

- Aufgaben mit klaren, prägnanten Lösungen: CoD ist ideal für Aufgaben, bei denen die Lösung in Form von kurzen, präzisen Aussagen, Formeln oder Gleichungen dargestellt werden kann.

- Beispiele: Mathematische Probleme, logische Rätsel, Ja/Nein-Fragen, Entscheidungsfindung.

5. Näher an menschlicher Denkweise:

- Kurze Notizen und Entwürfe: CoD emuliert die menschliche Denkweise, komplexe Probleme durch kurze Notizen und Entwürfe zu lösen.

- Effiziente Kommunikation: CoD fördert eine effiziente Kommunikation zwischen Mensch und Maschine, da die Antworten prägnant und auf den Punkt sind.

Zusammenfassend lässt sich sagen, dass Chain of Draft Prompting eine hervorragende Alternative zu Chain-of-Thought Prompting darstellt, wenn Effizienz, Geschwindigkeit und Kostenreduktion im Vordergrund stehen, ohne dabei die Genauigkeit zu stark zu beeinträchtigen. CoD ist besonders vorteilhaft für Echtzeit-Anwendungen, kosten-sensitive Projekte und Aufgaben mit klaren, prägnanten Lösungen.

In welchen Anwendungsfällen spielt Chain of Draft Prompting seine Stärken besonders aus?

Chain of Draft (CoD) Prompting entfaltet sein volles Potenzial in einer Vielzahl von Anwendungsfällen, in denen Effizienz, Geschwindigkeit und Kosteneffizienz kritische Erfolgsfaktoren sind:

1. Echtzeit-Anwendungen:

- Chatbots und virtuelle Assistenten: In Chatbots und virtuellen Assistenten ist eine geringe Latenz entscheidend für eine flüssige und natürliche Nutzererfahrung. CoD ermöglicht schnellere Antwortzeiten, was die Interaktion angenehmer und reaktionsfreudiger macht.

- Interaktive Systeme: Anwendungen, die schnelles Feedback erfordern, wie z.B. interaktive Lernplattformen, Spiele oder Echtzeit-Analysetools, profitieren von der geringen Latenz von CoD.

- Beispiele: Kunden-Support-Chatbots, In-Game-Assistenten, interaktive Dashboards.

2. Kosten-sensitive Projekte:

- Massendatenverarbeitung: Bei der Verarbeitung großer Datenmengen können die Kosten für Token-Verbrauch schnell in die Höhe schnellen. CoD reduziert den Token-Verbrauch drastisch und macht den Einsatz von LLMs in kostensensitiven Projekten wirtschaftlich realisierbar.

- Skalierbare Anwendungen: Für Anwendungen, die auf große Nutzerzahlen oder hohe Anfragevolumina ausgelegt sind, ist die Kosteneffizienz von CoD ein entscheidender Vorteil für die Skalierbarkeit.

- Beispiele: Sentiment-Analyse großer Textmengen, automatisierte Content-Erstellung in großem Maßstab, Massen-Personalisierung.

3. Mobile Anwendungen und ressourcenbeschränkte Umgebungen:

- Mobile Geräte: Auf mobilen Geräten sind Rechenleistung und Bandbreite oft begrenzt. CoD ist ressourcenschonender als CoT und eignet sich daher besser für den Einsatz auf mobilen Plattformen.

- Edge Computing: In Edge-Computing-Szenarien, in denen die Verarbeitung dezentral und nah am Datenursprung erfolgt, ist Effizienz besonders wichtig. CoD ermöglicht den Einsatz von LLMs in ressourcenbeschränkten Edge-Umgebungen.

- Beispiele: Mobile Assistenten, Offline-Übersetzungs-Apps, Edge-basierte Analysen.

4. Aufgaben mit klaren, prägnanten Lösungen:

- Mathematische Probleme und logische Rätsel: CoD ist besonders effektiv bei Aufgaben, bei denen die Lösung in Form von kurzen, präzisen Aussagen, Formeln oder Gleichungen dargestellt werden kann.

- Strukturierte Datenanalyse: Die prägnanten Antworten von CoD eignen sich gut für die Analyse strukturierter Daten und die Extraktion wesentlicher Informationen.

- Beispiele: Mathematik-Tutoren, Logikspiel-Solver, Datenextraktions-Tools.

5. Prototyping und schnelle Iteration:

- Schnelle Entwicklung: Die Effizienz von CoD beschleunigt den Entwicklungsprozess und ermöglicht schnellere Iterationen bei der Entwicklung von KI-Anwendungen.

- Experimentieren und Testen: Die geringeren Kosten von CoD erleichtern das Experimentieren mit verschiedenen Prompts und Modellen und das Testen in realen Anwendungsszenarien.

- Beispiele: Rapid Prototyping von Chatbots, schnelle Validierung von KI-Konzepten, A/B-Tests von Prompting-Strategien.

Zusammenfassend ist Chain of Draft Prompting ideal für alle Anwendungsfälle, in denen Effizienz, Geschwindigkeit und Kosten eine zentrale Rolle spielen. Es ist eine leistungsstarke und vielseitige Technik, die es ermöglicht, LLMs auch in ressourcenbeschränkten Umgebungen und Echtzeit-Szenarien effektiv einzusetzen.

Gibt es auch Situationen, in denen andere Prompting-Methoden besser geeignet sind als CoD?

Ja, obwohl Chain of Draft (CoD) Prompting viele Vorteile bietet, gibt es durchaus Situationen, in denen andere Prompting-Methoden, insbesondere Chain-of-Thought (CoT) Prompting, besser geeignet sein können:

1. Detaillierte Erklärungen und nachvollziehbare Reasoning-Pfade:

- Komplexe Reasoning-Aufgaben mit Bedarf an Transparenz: Wenn es wichtig ist, den vollständigen Denkprozess des Modells detailliert nachzuvollziehen, um z.B. Fehler zu analysieren oder die Logik zu überprüfen, ist CoT die bessere Wahl. CoT liefert ausführliche Reasoning-Schritte, die den Lösungsweg transparent machen.

- Lern- und Schulungsszenarien: In Bildungskontexten kann CoT wertvoll sein, um Schülern oder Studenten den Denkprozess zu vermitteln. Die detaillierten Erklärungen helfen, Konzepte zu verstehen und Reasoning-Fähigkeiten zu entwickeln.

- Beispiele: Fehlerdiagnose in komplexen Systemen, Erklärungen für mathematische Beweise, Schulungsmaterialien für kritisches Denken.

2. Qualitative Analysen und kreative Aufgaben:

- Offene Fragen und explorative Aufgaben: Bei Aufgaben, die kreatives Denken, freie Assoziationen oder qualitative Analysen erfordern, kann die Beschränkung auf kurze, prägnante Schritte von CoD einschränkend sein. CoT ermöglicht ausführlichere, explorativere Antworten, die nuancierter und facettenreicher sein können.

- Brainstorming und Ideenfindung: In Brainstorming- oder Ideenfindungsprozessen ist es oft hilfreich, viele verschiedene Perspektiven und Ansätze zu generieren. CoT kann hier vielfältigere und umfassendere Ergebnisse liefern.

- Beispiele: Kreatives Schreiben, Entwicklung neuer Produktideen, qualitative Marktforschung.

3. Aufgaben, bei denen Verbosität kein Problem darstellt:

- Asynchrone Anwendungen: In Anwendungen, bei denen Latenz und Kosten keine kritischen Faktoren sind, z.B. bei asynchronen Prozessen oder Offline-Analysen, kann die Verbosität von CoT vernachlässigbar sein.

- High-Performance-Infrastruktur: Wenn ausreichend Rechenressourcen zur Verfügung stehen, z.B. in Cloud-Umgebungen mit leistungsstarker Hardware, ist der höhere Ressourcenverbrauch von CoT möglicherweise kein limitierender Faktor.

- Beispiele: Batch-Verarbeitung großer Textmengen, Offline-Generierung von ausführlichen Berichten, ressourcenintensive Forschungsprojekte.

4. Komplexe, mehrdeutige Aufgaben:

- Aufgaben mit Interpretationsspielraum: Bei Aufgaben, die mehrere Interpretationen zulassen oder unterschiedliche Perspektiven erfordern, kann die Prägnanz von CoD zu einfachen oder unvollständigen Antworten führen. CoT ermöglicht ausführlichere Auseinandersetzungen mit der Komplexität der Aufgabe.

- Kontextabhängige Aufgaben: Wenn der Kontext für die Lösung einer Aufgabe entscheidend ist, können die kurzen, abstrakten Schritte von CoD möglicherweise wichtige Nuancen übersehen. CoT kann den Kontext besser berücksichtigen.

- Beispiele: Ethische Dilemmata, politische Analysen, interpretative Textanalysen.

Zusammenfassend ist CoT die bessere Wahl, wenn detaillierte Erklärungen, Transparenz, Kreativität oder die Auseinandersetzung mit Komplexität im Vordergrund stehen, oder wenn Latenz und Kosten keine kritischen Beschränkungen darstellen. CoD hingegen glänzt in Szenarien, die Effizienz, Geschwindigkeit und Kosteneffizienz priorisieren, und bei Aufgaben mit klaren, prägnanten Lösungen. Die Wahl der optimalen Prompting-Methode hängt also stark vom jeweiligen Anwendungsfall und den spezifischen Anforderungen ab.

Wie erstelle ich effektive Chain-of-Draft Prompts für meine KI-Projekte?

Um effektive Chain-of-Draft (CoD) Prompts für deine KI-Projekte zu erstellen, befolge diese bewährten Strategien und Tipps:

1. Klare Aufgabenstellung:

- Präzise Formulierung: Definiere die Aufgabe klar und präzise. Je genauer die Aufgabenstellung, desto fokussierter und effizienter kann das Modell arbeiten.

- Fokus auf das Ziel: Stelle sicher, dass das Modell das Ziel der Aufgabe versteht. Was soll erreicht werden? Welche Art von Antwort wird erwartet?

- Beispiel: Statt „Löse das Matheproblem“ -> „Löse das folgende mathematische Problem mit dem Chain-of-Draft-Ansatz und gib die Antwort in Form einer Gleichung an: Lisa hat 30 Äpfel…“

2. Explizite Anweisung zum CoD-Ansatz:

- Direkte Aufforderung: Weise das Modell explizit an, den Chain-of-Draft-Ansatz zu verwenden. Formuliere dies eindeutig im Prompt.

- Hinweis auf Wortlimit: Erwähne die Beschränkung auf maximal fünf Wörter pro Reasoning-Schritt (oder ein anderes, passendes Limit). Dies signalisiert dem Modell die gewünschte Kürze und Prägnanz.

- Beispiel: „Verwende den Chain-of-Draft-Ansatz, um das folgende Problem zu lösen. Jeder Reasoning-Schritt sollte maximal 5 Wörter umfassen.“

3. Fokus auf essentielle Informationen:

- Anleitung zur Minimalisierung: Ermutige das Modell, sich auf die wesentlichen Informationen und Operationen zu konzentrieren und unwichtige Details wegzulassen.

- Abstraktion fördern: Fordere das Modell auf, abstrakte Repräsentationen zu verwenden, z.B. Formeln, Gleichungen oder Symbole, anstatt ausführlicher Beschreibungen.

- Beispiel: „Denke Schritt für Schritt, aber beschränke dich auf minimale Entwürfe für jeden Denkschritt. Konzentriere dich auf die notwendigen Berechnungen und Transformationen.“

4. Strukturierung des Prompts:

- Klarer Prompt-Aufbau: Strukturiere den Prompt logisch und übersichtlich. Beginne mit der Aufgabenstellung, gefolgt von der Anweisung zum CoD-Ansatz und ggf. weiteren Hinweisen.

- Formatierung: Verwende Formatierungen wie Bulletpoints, Listen oder Absätze, um den Prompt lesbarer und verständlicher zu machen.

- Beispiel:

"Aufgabe: Löse das folgende Logikrätsel mit Chain-of-Draft Prompting.

Anleitung:

- Verwende den Chain-of-Draft-Ansatz.

- Beschränke jeden Reasoning-Schritt auf maximal 5 Wörter.

- Gib die endgültige Schlussfolgerung nach '####' an.

Rätsel: Alle Rosen sind rot. Einige Blumen sind Rosen. Was kann man über einige Blumen schließen?"5. Beispiele und Few-Shot Learning:

- Beispiele im Prompt: Integriere Beispiele in den Prompt, die demonstrieren, wie Chain-of-Draft Reasoning aussehen soll. Dies hilft dem Modell, den gewünschten Stil und die Prägnanz zu verstehen.

- Few-Shot Learning: Nutze Few-Shot Learning, indem du dem Modell einige Beispiele für Eingabe- und erwartete CoD-Ausgabe-Paare gibst. Dies kann die Performance und Konsistenz verbessern.

- Beispiel: Füge dem Prompt Beispiele für gelöste Aufgaben mit CoD-Reasoning hinzu, wie in den Beispielen im Blogartikel gezeigt.

6. Experimentieren und Iteration:

- Prompt Engineering ist iterativ: Sei bereit zu experimentieren und verschiedene Prompt-Formulierungen auszuprobieren. Optimiere die Prompts basierend auf den Ergebnissen und der Performance des Modells.

- Feinjustierung: Passe das Wortlimit pro Schritt an die jeweilige Aufgabe und das Modell an. Manchmal sind weniger als fünf Wörter optimal, manchmal etwas mehr.

- Evaluation: Evaluiere die Ergebnisse von CoD-Prompts sorgfältig. Vergleiche die Genauigkeit, Latenz und Kosten mit anderen Prompting-Methoden, um die beste Strategie für dein Projekt zu finden.

Durch die Anwendung dieser Tipps und Strategien kannst du effektive Chain-of-Draft Prompts erstellen, die die Effizienz deiner KI-Projekte maximieren und gleichzeitig die gewünschte Genauigkeit und Qualität der Ergebnisse sicherstellen.

Welche Rolle spielt die Begrenzung auf fünf Wörter pro Denkschritt bei CoD?

Die Begrenzung auf fünf Wörter pro Denkschritt spielt eine zentrale Rolle bei Chain of Draft (CoD) Prompting und ist entscheidend für die Effizienzsteigerung, die CoD auszeichnet. Diese Limitierung hat mehrere wichtige Auswirkungen:

1. Förderung von Prägnanz und Minimalismus:

- Erzwingt Konzentration auf das Wesentliche: Die Wortbegrenzung zwingt das Modell, sich auf die absolut notwendigen Informationen und Operationen zu konzentrieren. Unwesentliche Details und Ausschmückungen werden automatisch eliminiert.

- Fokussierung auf Kernbotschaften: Jeder Reasoning-Schritt muss auf den Punkt gebracht werden. Das Modell lernt, prägnant und effizient zu kommunizieren.

- Analogie zur menschlichen Kurznotation: Die Fünf-Wort-Grenze imitiert die menschliche Tendenz, sich bei komplexen Problemen kurze Notizen und Stichpunkte zu machen, anstatt lange Sätze zu formulieren.

2. Reduzierung von Verbosität und Token-Verbrauch:

- Direkte Output-Reduktion: Die Begrenzung der Wortanzahl führt direkt zu kürzeren Reasoning-Schritten und damit zu einem geringeren Gesamtoutput.

- Weniger Token benötigt: Kürzere Texte bedeuten weniger Token-Verbrauch, was die Kosten senkt und die Verarbeitung beschleunigt.

- Effizienzsteigerung: Die reduzierte Verbosität ist der Hauptgrund für die Effizienzsteigerung von CoD im Vergleich zu CoT.

3. Verbesserung der Lesbarkeit und Nachvollziehbarkeit:

- Klarere Struktur: Kurze, prägnante Schritte machen den Denkprozess übersichtlicher und leichter nachvollziehbar.

- Fokus auf Logik: Die Konzentration auf das Wesentliche schärft den Blick für die Logik des Reasoning-Pfads.

- Schnellere Erfassung: Kurze Schritte sind schneller zu lesen und zu verstehen als lange, ausführliche Erklärungen.

4. Vermeidung von Overthinking und Redundanzen:

- Verhindert Ausweichungen: Die Wortbegrenzung verhindert, dass das Modell abschweift oder sich in unnötigen Details verliert.

- Reduziert Redundanz: Das Modell wird gezwungen, Wiederholungen zu vermeiden und Informationen effizient zu komprimieren.

- Fokussierung auf den Lösungsweg: Die Konzentration auf das Wesentliche lenkt den Fokus auf den eigentlichen Lösungsweg und vermeidet Ablenkungen.

5. Flexibilität und Anpassbarkeit:

- Richtlinie, keine strikte Regel: Die Fünf-Wort-Grenze ist eher als Richtlinie zu verstehen denn als strikte Regel. In manchen Fällen kann es sinnvoll sein, diese Grenze leicht zu überschreiten, wenn dies die Klarheit oder Präzision verbessert.

- Anpassbar an Aufgabe und Modell: Das optimale Wortlimit kann je nach Aufgabe und verwendetem Modell variieren. Experimentiere, um das beste Limit für deinen Anwendungsfall zu finden.

Kritische Betrachtung:

- Potenzieller Informationsverlust: In extremen Fällen könnte die Wortbegrenzung zu einem Verlust wichtiger Informationen führen, wenn das Modell gezwungen ist, zu stark zu kürzen. Es ist wichtig, ein ausgewogenes Verhältnis zwischen Prägnanz und Informationsgehalt zu finden.

- Herausforderung für komplexe Erklärungen: Bei Aufgaben, die detaillierte Erklärungen oder komplexe Argumentationen erfordern, kann die Fünf-Wort-Grenze einschränkend sein. In solchen Fällen ist CoT möglicherweise besser geeignet.

Die Begrenzung auf fünf Wörter pro Denkschritt ist ein Schlüsselmerkmal von Chain of Draft Prompting und maßgeblich für dessen Effizienz und Stärke. Sie fördert Prägnanz, Minimalismus und Effizienz, reduziert Verbosität und Kosten und verbessert die Lesbarkeit und Nachvollziehbarkeit des Reasoning-Prozesses. Es ist jedoch wichtig, die potenziellen Einschränkungen zu berücksichtigen und das Wortlimit gegebenenfalls anzupassen, um ein optimales Ergebnis zu erzielen.

Kann ich Chain of Draft Prompting mit anderen Latency-Reduzierungs-Methoden kombinieren?

Ja, Chain of Draft (CoD) Prompting lässt sich hervorragend mit anderen Latency-Reduzierungs-Methoden kombinieren, um die Effizienz von LLMs weiter zu steigern und die Antwortzeiten zu optimieren. CoD konzentriert sich primär auf die Reduktion der Verbosität im Reasoning-Prozess, während andere Methoden auf verschiedenen Ebenen der LLM-Inferenzpipeline ansetzen. Die Kombination dieser Ansätze kann synergetische Effekte erzielen und zu signifikanten Verbesserungen in Bezug auf Latenz und Kosten führen.

Hier sind einige Beispiele für Latency-Reduzierungs-Methoden, die sich gut mit CoD kombinieren lassen:

1. Streaming:

- Prinzip: Streaming ermöglicht die inkrementelle Ausgabe von Teilergebnissen, während die Antwort noch generiert wird. Der Nutzer muss nicht auf die vollständige Antwort warten, sondern erhält sofort erste Ergebnisse.

- Kombination mit CoD: CoD reduziert die Gesamtlänge der Antwort, was das Streaming noch effektiver macht. Die kürzeren Reasoning-Schritte von CoD können schneller gestreamt werden, was die wahrgenommene Latenz weiter reduziert.

- Anwendungsfälle: Chatbots, Live-Transkription, Echtzeit-Übersetzung.

2. Skeleton-of-Thought (SoT):

- Prinzip: SoT generiert zunächst ein Skelett oder eine Outline der Antwort, bevor die Details ausgefüllt werden. Dies ermöglicht parallele Dekodierung und Reduzierung der sequentiellen Verarbeitung.

- Kombination mit CoD: CoD kann verwendet werden, um das Skelett selbst prägnanter und effizienter zu gestalten. Die kurzen CoD-Schritte eignen sich ideal für die Outline-Phase von SoT.

- Anwendungsfälle: Komplexe Reasoning-Aufgaben, bei denen eine Vorabplanung des Lösungswegs sinnvoll ist.

3. Draft-Verify-Methoden:

- Prinzip: Draft-Verify-Methoden generieren zunächst einen schnellen, aber möglicherweise ungenauen „Draft“ der Antwort, der anschließend durch einen langsameren, aber genaueren „Verify“-Prozess korrigiert wird.

- Kombination mit CoD: CoD kann für die Draft-Generierung verwendet werden, um einen schnellen und effizienten ersten Entwurf zu erstellen. Die Kürze von CoD ist hier von Vorteil.

- Anwendungsfälle: Anwendungen, bei denen eine schnelle, vorläufige Antwort wichtiger ist als absolute Perfektion, z.B. bei der Suche nach relevanten Informationen oder beim Brainstorming.

4. Modell-Destillation und -Komprimierung:

- Prinzip: Modell-Destillation und -Komprimierungstechniken zielen darauf ab, kleinere, effizientere Modelle zu trainieren, die eine ähnliche Performance wie größere Modelle aufweisen, aber weniger Rechenressourcen benötigen und schneller inferieren.

- Kombination mit CoD: CoD kann unabhängig von der Modellgröße eingesetzt werden. Die Kombination mit kleineren, destillierten Modellen verstärkt die Effizienzgewinne von CoD noch weiter.

- Anwendungsfälle: Mobile Anwendungen, Edge Computing, kosten-sensitive Projekte.

5. Adaptive Berechnung und frühes Beenden:

- Prinzip: Adaptive Berechnungsmethoden passen den Rechenaufwand dynamisch an die Komplexität der Aufgabe an. Bei einfachen Aufgaben wird weniger Rechenzeit investiert als bei komplexen. Frühes Beenden stoppt die Inferenz, sobald eine ausreichend gute Antwort gefunden wurde.

- Kombination mit CoD: CoD kann dazu beitragen, die Komplexität der Reasoning-Aufgabe zu reduzieren, indem es den Fokus auf das Wesentliche lenkt. Dies kann adaptive Berechnungsalgorithmen effektiver machen und zu früherem Beenden der Inferenz führen.

- Anwendungsfälle: Anwendungen, bei denen die Anforderungsqualität variiert und schnelle Antworten wichtiger sind als maximale Präzision in allen Fällen.

Bei der Kombination von CoD mit anderen Latency-Reduzierungs-Methoden ist es wichtig, die spezifischen Anforderungen des Anwendungsfalls und die Charakteristika der einzelnen Methoden zu berücksichtigen, um die optimale Kombination zu finden und die bestmögliche Effizienzsteigerung zu erzielen.

Konkrete Tipps und Anleitungen

Tipps zur effektiven Nutzung von Chain of Draft Prompting

Um Chain of Draft (CoD) Prompting optimal in deinen Projekten einzusetzen, beachte diese praktischen Tipps und Anleitungen:

1. Starte einfach und werde prägnant:

- Beginne mit Standard Prompting: Wenn du neu bei CoD bist, beginne mit einem einfachen Standard Prompt, um das grundlegende Verhalten des Modells für deine Aufgabe zu verstehen.

- Inkrementelle Verfeinerung: Füge dann schrittweise CoD-Elemente hinzu, wie z.B. die Anweisung zur Kürze und das Wortlimit.

- Iterative Optimierung: Teste verschiedene Formulierungen und Wortlimits, um den effektivsten CoD-Prompt für deine spezifische Aufgabe zu finden.

2. Definiere klare Wortlimits:

- Fünf-Wort-Richtlinie als Startpunkt: Nutze die Fünf-Wort-Grenze als guten Ausgangspunkt, aber sei flexibel.

- Aufgabenabhängige Anpassung: Passe das Wortlimit an die Komplexität der Aufgabe an. Für sehr einfache Aufgaben können auch noch kürzere Schritte sinnvoll sein. Für komplexere Aufgaben musst du das Limit ggf. leicht erhöhen, um ausreichend Informationsgehalt zu gewährleisten.

- Experimentiere mit verschiedenen Limits: Teste verschiedene Wortlimits (z.B. 3, 5, 7 Wörter), um die optimale Balance zwischen Prägnanz und Genauigkeit zu finden.

3. Fördere abstrakte Repräsentationen:

- Formeln und Gleichungen: Nutze Formeln, Gleichungen und mathematische Symbole, um komplexe Operationen prägnant darzustellen.

- Logische Symbole: Verwende logische Symbole (z.B. „=>“ für Implikation, „∧“ für „und“, „∨“ für „oder“), um logische Beziehungen kurz und präzise auszudrücken.

- Kurze Schlüsselwörter: Verwende prägnante Schlüsselwörter und Akronyme, um Konzepte und Objekte zu bezeichnen.

4. Trainiere dein „CoD-Gespür“:

- Beispiele analysieren: Studier Beispiele für effektive CoD-Prompts und -Antworten (wie in diesem Artikel und im Forschungspapier).

- Menschliche Kurznotationen studieren: Analysiere, wie Menschen sich kurze Notizen machen, um komplexe Probleme zu lösen. Lerne von diesen Techniken und adaptiere sie für CoD-Prompts.

- Übung macht den Meister: Je mehr du mit CoD-Prompts experimentierst, desto besser wirst du darin, effektive und effiziente Prompts zu formulieren.

5. Kombiniere CoD mit anderen Techniken:

- Streaming für Echtzeit: Nutze Streaming in Kombination mit CoD, um die wahrgenommene Latenz in interaktiven Anwendungen weiter zu reduzieren.

- SoT für komplexe Planung: Kombiniere CoD mit Skeleton-of-Thought, um komplexe Reasoning-Aufgaben effizienter zu strukturieren.

- Draft-Verify für schnelle Entwürfe: Verwende CoD in Draft-Verify-Methoden, um schnelle und kostengünstige erste Antwortentwürfe zu generieren.

6. Evaluiere und iteriere kontinuierlich:

- Messe die Performance: Evaluiere die Genauigkeit, Latenz und Kosten deiner CoD-basierten Anwendungen.

- Vergleiche mit anderen Methoden: Vergleiche die Ergebnisse mit anderen Prompting-Methoden (Standard, CoT), um die Vorteile von CoD zu quantifizieren.

- Iterative Optimierung: Optimiere deine CoD-Prompts kontinuierlich basierend auf den Evaluationsergebnissen und dem Feedback der Nutzer.

Durch die Anwendung dieser Tipps und Anleitungen kannst du Chain of Draft Prompting erfolgreich in deine KI-Projekte integrieren und von den signifikanten Effizienzgewinnen profitieren. Denke daran, dass Prompt Engineering ein iterativer Prozess ist. Experimentiere, lerne und optimiere deine Prompts kontinuierlich, um das volle Potenzial von CoD auszuschöpfen.

5 Beispiele, die Dir den Unterschied zwischen Standard Prompting, Reasoning (CoT) und Chain of Draft (CoD) im Business-Umfeld gegenüberstellen.

Die Tabelle stellt fünf Business-Szenarien gegenüber und hebt den Mehrwert von CoD deutlich hervor.

| Business-Szenario | Standard Prompt | Reasoning Prompt (Chain of Thought – CoT) | Chain of Draft (CoD) Prompt | Erläuterung des CoD-Vorteils |

|---|---|---|---|---|

| 1. Kunden‑Email Zusammenfassung | „Fasse diese Kunden‑E-Mail bitte kurz zusammen und nenne die Hauptpunkte:“ [Kunden‑E-Mail einfügen] | „Um die Kunden‑E-Mail präzise und kurz zusammenzufassen, befolge diese Schritte: 1. Identifiziere das Hauptanliegen. 2. Extrahiere die wichtigsten Fakten. 3. Formuliere eine Zusammenfassung in maximal drei Sätzen. Zusammenfassung:“ [Kunden‑E-Mail einfügen] | „Nutze den Chain‑of‑Draft-Ansatz: Denke in max. 5-Wort-Schritten. Generiere zwei Entwürfe – Entwurf 1: Knapp, direkte Zusammenfassung; Entwurf 2: Zusammenfassung mit Fokus auf Handlungsbedarf. Antwort:“ [Kunden‑E-Mail einfügen] | CoD erzwingt eine extrem prägnante Denkweise, liefert direkt zwei alternative Versionen und spart so Iterationszeit. |

| 2. Produktbeschreibung erstellen | „Schreibe eine ansprechende Produktbeschreibung für: [Produktname & Details einfügen].“ | „Um eine verkaufsstarke Produktbeschreibung zu erstellen, folge diesen Schritten: 1. Bestimme die Hauptvorteile. 2. Definiere die Zielgruppe. 3. Nenne relevante Features. 4. Formuliere einen einleitenden Satz, beschreibe Vorteile, nenne Features und schließe mit einem Call‑to‑Action. Produktbeschreibung:“ [Produktname & Details einfügen] | „Nutze den Chain‑of‑Draft-Ansatz: Denke in max. 5-Wort-Schritten. Generiere zwei Entwürfe – Entwurf 1: Kernbeschreibung; Entwurf 2: Beschreibung mit Fokus auf Lifestyle-Vorteile. Antwort:“ [Produktname & Details einfügen] | CoD liefert sofort alternative „Angles“ (zwei Entwürfe) statt einer langen, iterativen Ausarbeitung – das erhöht Flexibilität und spart Ressourcen. |

| 3. Meeting‑Agenda vorschlagen | „Schlage eine Meeting‑Agenda für ein Meeting zum Thema [Meeting‑Thema einfügen] vor.“ | „Um eine effektive Meeting‑Agenda zu erstellen, gehe wie folgt vor: 1. Definiere die Zielsetzung des Meetings. 2. Bestimme Hauptthemen und Diskussionspunkte. 3. Weise jedem Punkt einen Zeitrahmen zu. 4. Lasse Raum für offene Diskussion. Agenda-Vorschlag:“ [Meeting‑Thema einfügen] | „Nutze den Chain‑of‑Draft-Ansatz: Denke in max. 5-Wort-Schritten. Generiere zwei Entwürfe – Entwurf 1: Agenda mit Fokus auf Entscheidungen; Entwurf 2: Agenda für ein Brainstorming-Meeting. Antwort:“ [Meeting‑Thema einfügen] | CoD ermöglicht es, in einem Durchgang zwei passgenaue Agenda-Varianten zu erhalten – ideal, wenn unterschiedliche Meeting-Ziele abgedeckt werden sollen. |

| 4. Kundenanfrage‑Antwort vorschlagen | „Formuliere eine kurze Antwort auf diese Kundenanfrage: [Kundenanfrage einfügen].“ | „Um eine hilfreiche Kundenantwort zu erstellen, berücksichtige diese Schritte: 1. Bedanke dich für die Anfrage. 2. Bestätige das Problem. 3. Schlage eine Lösung bzw. nächste Schritte vor. 4. Bleibe freundlich und serviceorientiert. Antwortvorschlag:“ [Kundenanfrage einfügen] | „Nutze den Chain‑of‑Draft-Ansatz: Denke in max. 5-Wort-Schritten. Generiere zwei Entwürfe – Entwurf 1: Kurze, direkte Antwort; Entwurf 2: Ausführlichere, detaillierte Antwort. Antwort:“ [Kundenanfrage einfügen] | CoD liefert sofort zwei Antwortvarianten in unterschiedlicher Länge, sodass schnell zwischen „Quick & Dirty“ und einer ausführlicheren Antwort gewählt werden kann. |

| 5. Report‑Zusammenfassung (kurz) | „Fasse diesen Report in 5 Bullet Points zusammen: [Report‑Text einfügen].“ | „Um die Kernaussagen des Reports präzise in Bullet Points zu extrahieren, folge diesen Schritten: 1. Lies den Report abschnittsweise. 2. Identifiziere zentrale Aussagen. 3. Kondensiere diese auf maximal 5 Bullet Points. Achte auf Klarheit und Prägnanz. Bullet Point Zusammenfassung:“ [Report‑Text einfügen] | „Nutze den Chain‑of‑Draft-Ansatz: Denke in max. 5-Wort-Schritten. Generiere zwei Entwürfe – Entwurf 1: Zusammenfassung mit Fokus auf Zahlen & Fakten; Entwurf 2: Zusammenfassung mit Fokus auf Kernbotschaften. Antwort:“ [Report‑Text einfügen] | CoD zeigt kompakt zwei unterschiedliche Interpretationsperspektiven, wodurch das „Big Picture“ schnell erfasst werden kann – ohne langwierige Zwischenschritte. |

Wichtiger Hinweis: CoD Prompting ist kein Allheilmittel. Bei sehr komplexen Aufgaben, die einen detaillierten Reasoning-Prozess erfordern, bleibt CoT relevant. In vielen Business-Szenarien, in denen schnelle, variable und pragmatische Ergebnisse im Vordergrund stehen, ist CoD jedoch ein echter Effizienz-Booster!

Diese Tabelle hebt deutlich hervor, wie der klare CoD-Prompt—mit der Vorgabe, in maximal 5-Wort-Schritten zu denken und direkt alternative Entwürfe zu generieren—eine schnelle und flexible Arbeitsweise ermöglicht.

Vergleich der Prompting-Methoden: Leistungsdaten im Überblick

| Model | Prompt | Accuracy | Token # | Latency |

| GPT-4o | Standard | 53.3% | 1.1 | 0.6 s |

| CoT | 95.4% | 205.1 | 4.2 s | |

| CoD | 91.1% | 43.9 | 1.0 s | |

| Claude 3.5 Sonnet | Standard | 64.6% | 1.1 | 0.9 s |

| CoT | 95.8% | 190.0 | 3.1 s | |

| CoD | 91.4% | 39.8 | 1.6 s |

Hinweis: Die Daten basieren auf einer „GSM8K evaluation“, wie in „Table 1: GSM8K evaluation results.“ der Quelle angegeben. GSM8K bezieht sich wahrscheinlich auf einen spezifischen Benchmark-Datensatz im Bereich des „reasoning-heavy word problems“ , wie in der Prompting-Forschung üblich. Es ist wichtig, diese Ergebnisse im Kontext des verwendeten Benchmarks zu interpretieren und nicht unkritisch auf alle Arten von Prompting-Aufgaben zu verallgemeinern.

Vergleich der Prompting-Methoden: Leistungsdaten ‚Date Understanding‘ im Überblick

| Model | Prompt | Accuracy | Token # | Latency |

| GPT-4o | Standard | 72.6% | 5.2 | 0.6 s |

| CoT | 90.2% | 75.7 | 1.7 s | |

| CoD | 88.1% | 30.2 | 1.3 s | |

| Claude 3.5 Sonnet | Standard | 84.3% | 5.2 | 1.0 s |

| CoT | 87.0% | 172.5 | 3.2 s | |

| CoD | 89.7% | 31.3 | 1.4 s |

Hinweis: Diese Tabelle zeigt die Ergebnisse einer „Date understanding evaluation“, wie in „Table 2: Date understanding evaluation results.“ der Quelle spezifiziert. „Date understanding“ bezieht sich vermutlich auf die Fähigkeit der Modelle, Datumsangaben in Texten zu verstehen und zu verarbeiten, was ein relevanter Aspekt im Kontext von Business-Themen (z.B. Fristen, Zeiträume in Dokumenten) sein kann. Auch hier gilt, dass diese Resultate im spezifischen Kontext dieses „Date understanding“ Benchmarks zu sehen sind.

Vergleich der Prompting-Methoden: Leistungsdaten ‚Sportverständnis‘ im Überblick

| Model | Prompt | Accuracy | Token # | Latency |

| GPT-4o | Standard | 90.0% | 1.0 | 0.4 s |

| CoT | 95.9% | 28.7 | 0.9 s | |

| CoD | 98.3% | 15.0 | 0.7 s | |

| Claude 3.5 Sonnet | Standard | 90.6% | 1.0 | 0.9 s |

| CoT | 93.2% | 189.4 | 3.6 s | |

| CoD | 97.3% | 14.3 | 1.0 s |

Hinweis: Diese Tabelle zeigt die Resultate der „Sports understanding evaluation“ (Tabelle 3 der Quelle). „Sports understanding“ bezieht sich demnach auf die Evaluierung der Fähigkeit der Modelle, Informationen und Zusammenhänge in sportbezogenen Texten zu erfassen und zu verarbeiten. Auch diese Daten sollten im Kontext dieses spezifischen Sport-Benchmarks betrachtet werden.

Vergleich der Prompting-Methoden: Leistungsdaten ‚Münzwurf-Aufgabe‘ im Überblick

| Model | Prompt | Accuracy | Token # | Latency |

| GPT-4o | Standard | 73.2% | 1.0 | 0.4 s |

| CoT | 100.0% | 52.4 | 1.4 s | |

| CoD | 100.0% | 16.8 | 0.8 s | |

| Claude 3.5 Sonnet | Standard | 85.2% | 1.0 | 1.2 s |

| CoT | 100.0% | 135.3 | 3.1 s | |

| CoD | 100.0% | 18.9 | 1.6 s |

Hinweis: Diese Tabelle zeigt die Resultate der „Coin flip evaluation“ (Tabelle 4 der Quelle). „Coin flip evaluation“ (Münzwurf-Aufgabe) bezieht sich möglicherweise auf eine probabilistische Aufgabe, bei der die Modelle Vorhersagen oder Einschätzungen im Zusammenhang mit Zufallsereignissen (wie einem Münzwurf) treffen mussten. Auch hier gilt: Die Ergebnisse sind im Kontext dieses spezifischen Benchmarks zu sehen.

Chain of Draft Prompting: Top-KI-Leistung, Mini-Token-Budget

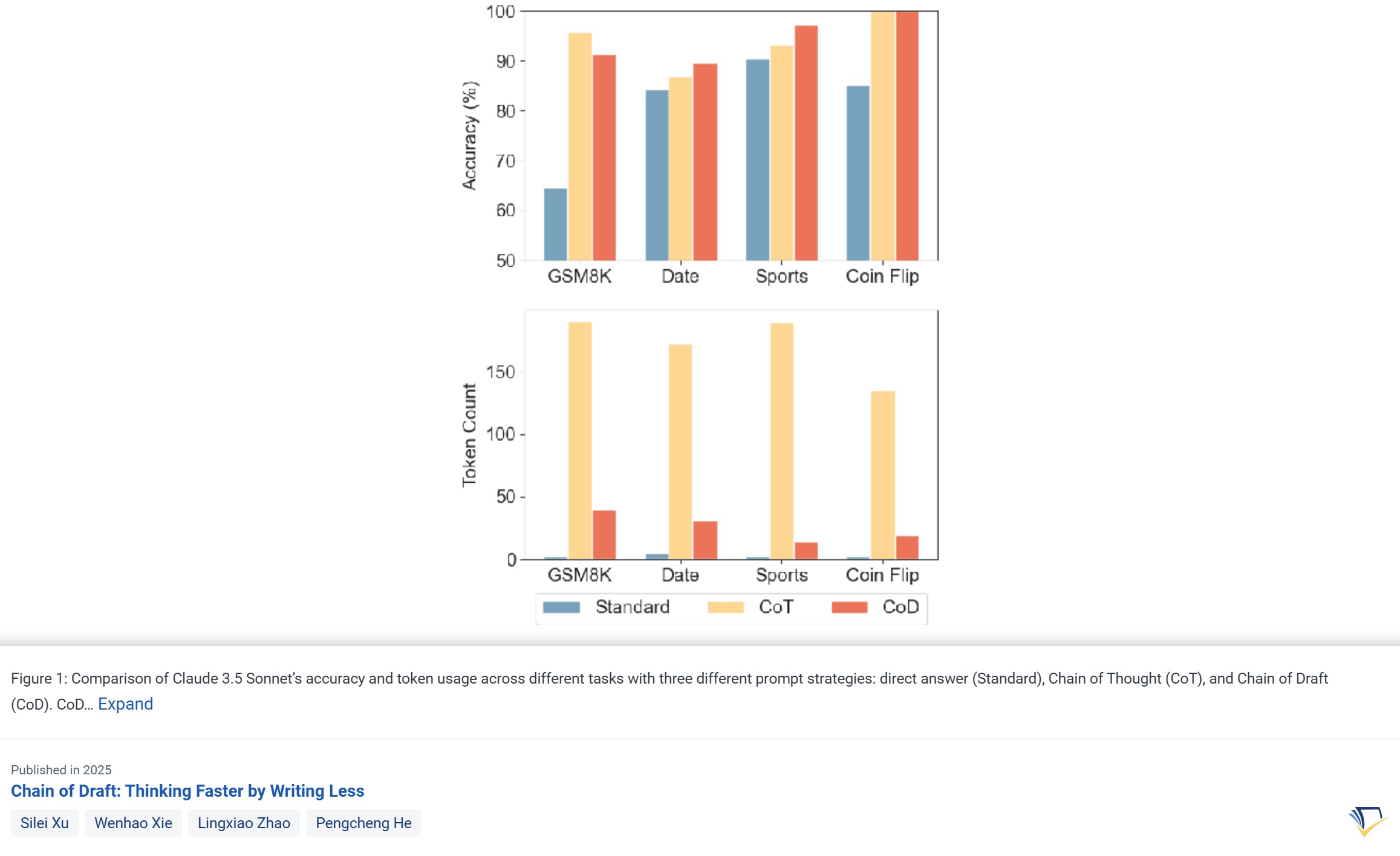

Formell gesagt, demonstriert Chain of Draft Prompting in beeindruckender Weise, wie man mit weniger mehr erreicht. Betrachten wir dazu einmal die konkreten Zahlen, die in Abbildung 1 dargestellt sind – sie zeigen einen direkten Vergleich der Performance zwischen Chain of Thought (CoT) und Chain of Draft (CoD) für Claude 3.5 Sonnet über verschiedene Aufgaben hinweg:

Was diese Grafik besonders aussagekräftig macht, sind vor allem zwei Kennzahlen: „Accuracy“ (Genauigkeit) und „Token Count“ (Token-Verbrauch). Accuracy (Genauigkeit) verdeutlich wie präzise die Ergebnisse des KI-Modells im jeweiligen Anwendungskontext sind – vereinfacht als Anteil der korrekten Antworten gemessen an allen Antworten im Test. Je höher der Wert, desto treffsicherer ist das Modell bei einer gegebenen Prompting-Methode in dieser Aufgabe.

Der Token Count (Token-Verbrauch) zeigt die rechnerischen Ressourcen, die für eine Antwort generierung benötigt werden; vereinfacht ausgedrückt repräsentiert die Anzahl der Tokens die „Wort-Bausteine“, die für die Verarbeitung des Prompts und die Erstellung der Antwort notwendig sind. Je weniger Tokens benötigt werden, desto ressourcenschonender arbeitet der Prompt – im Sinne geringerer Kosten und potenziell schnellerer Antwortzeiten.

Wichtiger noch: Chain of Draft Prompting reduziert den Token-Verbrauch dramatisch – Abbildung 1 demonstriert diese Einsparungen anschaulich.

Ein Blick auf „Abbildung 1“ für Claude 3.5 Sonnet zeigt: CoD erreicht im direkten Vergleich mit CoT eine fast identische Accuracy (Genauigkeit), teilweise sogar bessere Werte! Gleichzeitig reduziert CoD aber den Token-Verbrauch im Durchschnitt auf ca. 35% des Token-Verbrauchs von CoT – und in manchen Fällen sogar noch deutlicher! Das ist ENORM, besonders wenn man bedenkt: Dieser massive Effizienzgewinn wird allein durch eine hoch-optimierte Prompt-Technik erzielt. Es ist kein aufwendiges Modelltraining, keine teure Hardware-Aufrüstung oder Ähnliches notwendig.

Alles, was Du tun musst: Deine Prompts bewusst im Sinne der effizienten Chain of Draft-Prinzipien zu formulieren. Diese signifikante Ressourcenersparnis (geringerer Token-Verbrauch um ca. 65%), kombiniert mit hoher Accuracy und schnelleren Antwortzeiten, macht Chain of Draft Prompting für Unternehmen – insbesondere im praktischen Einsatz von KI-basierten System – zu einer hocheffizienten und denkbar einfachen bzw. günstigen Optimierungsmethode, quasi KI-Effizienz „per Prompt“.

Chain of Draft im Vergleich mit Chain of Thought

Um den Unterschied zu verdeutlichen, hier ein Vergleich zwischen CoD und CoT basierend auf den verfügbaren Informationen:

| Eigenschaft | Chain of Thought (CoT) | Chain of Draft (CoD) |

|---|---|---|

| Verbosity | Hoch, detaillierte Schritte | Niedrig, prägnante Zwischenüberlegungen |

| Token-Nutzung | Hoch, mehr Kosten und Latenz | Niedrig, kosteneffizient und schnell |

| Genauigkeit | Hoch, besonders bei komplexen Aufgaben | Ähnlich oder besser, bei weniger Token |

| Transparenz | Hoch, gut für Debugging und Bildung | Niedrig, weniger geeignet für Debugging |

| Anwendungsbereiche | Komplexe Aufgaben, Bildung | Echtzeit-Anwendungen, ressourcenbeschränkt |

Diese Tabelle zeigt, dass CoD besonders für Szenarien geeignet ist, in denen Effizienz und Schnelligkeit entscheidend sind, während CoT besser für detaillierte Analysen geeignet ist.

Regelmäßige Aktualisierung

Dieser Artikel wird fortlaufend aktualisiert, um die neuesten Erkenntnisse und Entwicklungen im Bereich Chain of Draft Prompting und effizienter KI-Techniken zu berücksichtigen. Schau regelmäßig vorbei, um auf dem neuesten Stand zu bleiben und dein Wissen zu erweitern!

Fazit: Die minimalistische Revolution im Prompt Engineering

Chain of Draft Prompting ist ein revolutionärer Ansatz, der das Potenzial hat, die Art und Weise, wie wir mit Large Language Models interagieren, grundlegend zu verändern. CoD verkörpert die Essenz menschlichen Denkens: prägnant, direkt und effektiv. Indem es unnötigen Ballast abwirft, liefert CoD nahezu alle Vorteile detaillierten Reasonings mit einem Bruchteil der Kosten und der Zeit.

CoD ist mehr als nur eine Prompting-Technik. Es ist ein Paradigmenwechsel hin zu effizienterem, ressourcenschonenderem und menschenähnlicherem KI-Reasoning. Es demonstriert eindrucksvoll, dass effektives Reasoning in LLMs nicht zwangsläufig lange, wortreiche Ausgaben erfordert. Im Gegenteil: Weniger ist oft mehr. Durch die Konzentration auf das Wesentliche und die Reduktion der Verbosität eröffnet CoD neue Möglichkeiten für Echtzeit-Anwendungen, kosten-sensitive Projekte und ressourcenbeschränkte Umgebungen.

Die Vorteile von CoD sind vielfältig und überzeugend:

- Signifikante Reduzierung der Latenz für schnellere Antwortzeiten und verbesserte Nutzererfahrung.

- Drastische Senkung der Kosten durch geringeren Token-Verbrauch, was LLMs auch für großvolumige und kosten-sensitive Anwendungen wirtschaftlich macht.

- Vergleichbare oder sogar verbesserte Genauigkeit, insbesondere bei Aufgaben, die prägnante Lösungen erfordern.

- Bessere Eignung für mobile und Edge-Umgebungen durch geringeren Ressourcenverbrauch.

- Näher an menschlicher Denkweise durch Emulation von Kurznotationen und effizientem Denken.

Chain of Draft Prompting ist keine Allzwecklösung, und es gibt Situationen, in denen andere Methoden wie CoT besser geeignet sind. Aber für eine wachsende Zahl von Anwendungsfällen, in denen Effizienz, Geschwindigkeit und Kosten im Vordergrund stehen, ist CoD die Technik der Wahl.

Wenn du Klarheit mit Effizienz verbinden und deine Prompt-Engineering-Fähigkeiten auf das nächste Level heben möchtest, ist Chain of Draft Prompting ein Muss für dein Toolkit. Tauche ein in die minimalistische Revolution, experimentiere mit CoD und entdecke das unglaubliche Potenzial dieser effizienten Prompting-Strategie. Bist du bereit, deine KI-Projekte auf Turbo-Geschwindigkeit zu bringen und dich der minimalistischen Revolution anzuschließen? Dann leg los und denk schneller, schreib kürzer – mit Chain of Draft!

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar. Hier kannst Du Dich in einer aktiven Community austauschen und KI lernen.

Quellen

- Xu, Silei; Xie, Wenhao; Zhao, Lingxiao; He, Pengcheng. (2025). Chain of Draft: Thinking Faster by Writing Less. arXiv:2502.18600v1 [cs.CL]

- Remiddi, Manolo. (2025). Chain-of-Draft Prompting: Think Fast, Write Less, and Get Results. [Blog Post] https://manoloremiddi.com/2025/03/01/chain-of-draft-prompting-think-fast-write-less-and-get-results/

- Chain of Draft

#ChainOfDraft #CoDPrompting #PromptEngineering #LLM #KI #KünstlicheIntelligenz #Effizienz #LatencyReduction