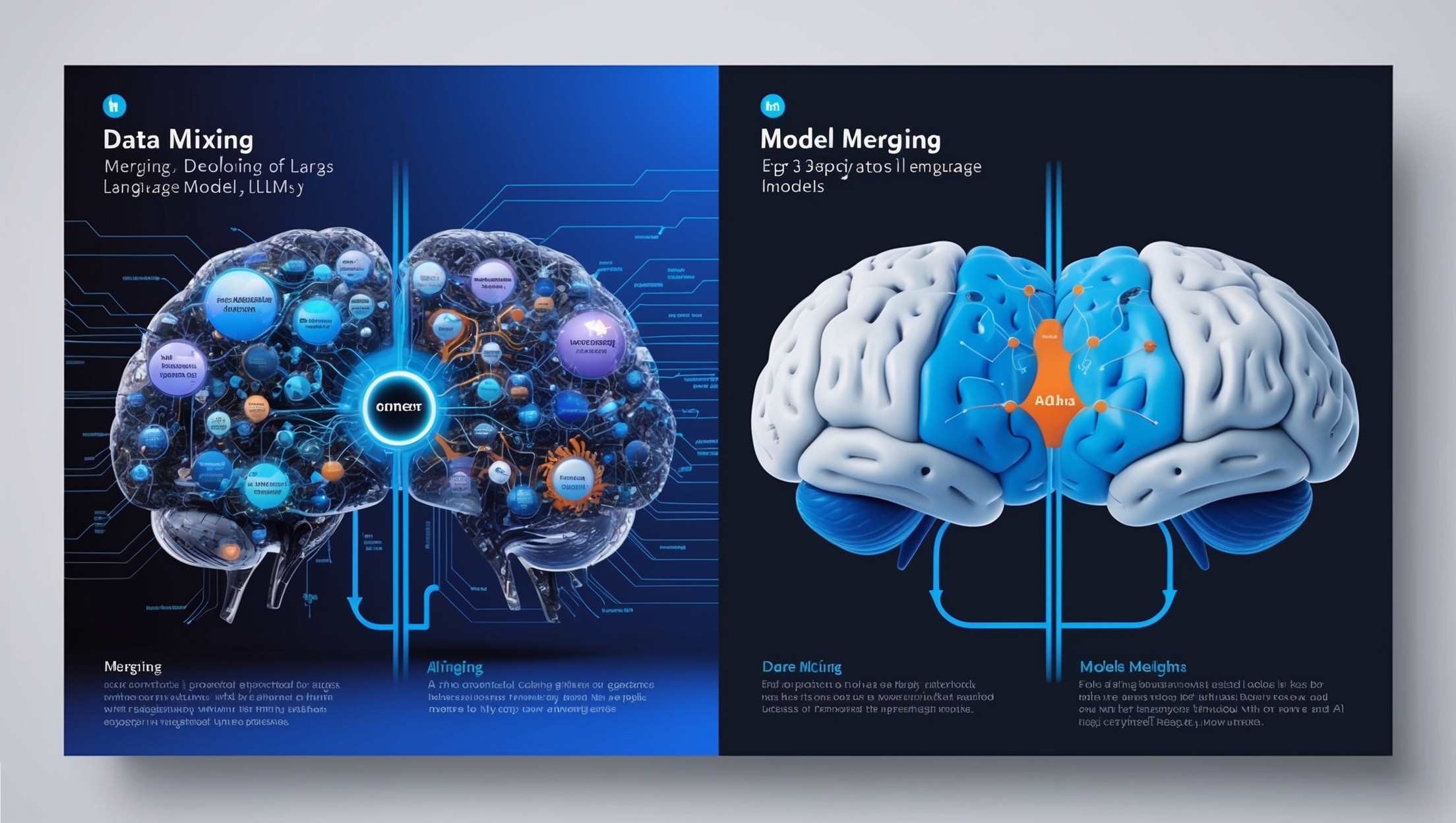

In der Entwicklung von Large Language Models (LLMs) stehen Forscher vor der Herausforderung, Modelle zu erstellen, die sowohl leistungsstark als auch sicher sind. Besonders bei multilingualen Anwendungen stellt sich die Frage, wie man hohe Performance sicherstellt, ohne dass die Ausgabe potenziell schädlicher oder voreingenommener Inhalte erhöht wird. Eine neue Studie von Cohere AI wirft einen genaueren Blick auf zwei Methoden zur Optimierung dieser Modelle: Merging und Data Mixing.

Hauptfrage: Was sind die effektivsten Strategien zur Entwicklung sicherer und leistungsstarker LLMs?

Die herkömmliche Methode, um ein Gleichgewicht zwischen Leistung und Sicherheit in LLMs zu erreichen, ist das sogenannte Data Mixing. Hierbei werden mehrere Datensätze aus unterschiedlichen Aufgaben und Sprachen zusammengeführt und zur Feinabstimmung des Modells genutzt. Eine alternative Methode, die in der aktuellen Forschung an Popularität gewinnt, ist das Model Merging. Im Gegensatz zum Data Mixing verfolgt diese Technik den Ansatz, separate, bereits für spezifische Aufgaben oder Sprachen feinabgestimmte Modelle zu kombinieren. Durch diese Zusammenführung soll die Spezialität jedes Modells gewahrt bleiben und die Gesamtleistung des finalen Modells verbessert werden.

Unterschiede zwischen Data Mixing und Model Merging

1. Data Mixing:

- Multitasking: Ein einzelnes Modell wird mit einer Vielzahl von Aufgaben und Sprachen trainiert. Diese Methode sorgt für eine allgemeine Leistung in verschiedenen Bereichen.

- Herausforderung: Oft führt Data Mixing zu einer Überfrachtung des Modells, sodass es nicht in der Lage ist, eine Aufgabe optimal zu bewältigen. Zudem werden Sicherheitsanforderungen nicht immer ausreichend berücksichtigt, besonders in Sprachen, für die weniger Trainingsdaten verfügbar sind.

- Ergebnisse: Data Mixing erreicht moderate Verbesserungen, jedoch bleiben sicherheitsrelevante Bedenken in bestimmten Sprachkontexten bestehen.

2. Model Merging:

- Fokussierte Optimierung: Jedes Modell wird unabhängig für eine spezifische Aufgabe oder Sprache optimiert und später kombiniert. Dies ermöglicht eine Spezialisierung des Modells auf spezifische Aufgaben und Sprachen, bevor sie in ein Gesamtmodell integriert werden.

- Techniken: Die Forscher von Cohere AI nutzten innovative Verfahren wie die Spherical Linear Interpolation (SLERP) und Task Interference Elimination Strategy (TIES), um Modellkonflikte zu minimieren und Leistungsverbesserungen sicherzustellen.

- Ergebnisse: Durch Model Merging konnten signifikante Leistungssteigerungen erreicht werden. Beispielsweise führte SLERP zu einer 7%-Steigerung der allgemeinen Leistung und einer Reduktion schädlicher Ausgaben um 3,1%. TIES führte zu einer Reduzierung der schädlichen Inhalte um 10,4%, obwohl die allgemeine Leistung leicht zurückging.

Folgefragen: Wie wird KI im Content-Marketing eingesetzt?

Künstliche Intelligenz (KI) und besonders Large Language Models (LLMs) werden zunehmend im Content-Marketing verwendet. Besonders bei der Erstellung und Anpassung von Inhalten an unterschiedliche Zielgruppen und Plattformen zeigen diese Modelle ihr Potenzial. Durch Natural Language Processing (NLP)-Techniken können LLMs, wie sie durch Methoden wie Data Mixing oder Merging optimiert wurden, kontextgerechte und zielgruppenspezifische Inhalte erstellen.

Wie wirken sich Multilingualität und kulturelle Kontexte auf LLMs aus?

Ein zentraler Punkt der Forschung zu LLMs ist die Anpassungsfähigkeit an unterschiedliche Sprachen und Kulturen. Besonders in mehrsprachigen Kontexten kann die Verfügbarkeit von Trainingsdaten für weniger verbreitete Sprachen die Leistung und Sicherheit des Modells beeinflussen. Hier zeigen Merging-Strategien eine besonders vielversprechende Entwicklung, da sie es ermöglichen, für jede Sprache spezialisierte Modelle zu erstellen und zu kombinieren, ohne dass eine einzelne Sprache dominiert.

Welchen Einfluss haben LLMs auf die Sicherheit von Modellen?

Die Sicherheit von LLMs ist besonders in sensiblen Bereichen wie der Gesundheitsversorgung, dem Bildungswesen und im Finanzsektor von zentraler Bedeutung. Wenn Modelle in verschiedenen Sprachen und Kulturen eingesetzt werden, besteht die Gefahr, dass kulturelle Voreingenommenheiten oder missverständliche Inhalte generiert werden. Durch Techniken wie Model Merging können Sicherheitsprotokolle sprachspezifisch angepasst und optimiert werden, ohne dass dies auf Kosten der Gesamtleistung geht.

Konkrete Tipps: Wie kann man Model Merging zur Verbesserung der LLM-Leistung nutzen?

- Sprachspezifische Feinabstimmung: Modelle, die speziell für eine bestimmte Sprache oder Aufgabe optimiert wurden, sollten kombiniert werden, um ihre jeweiligen Stärken zu nutzen.

- Techniken wie SLERP und TIES anwenden: Diese Methoden stellen sicher, dass Konflikte zwischen den Modellen minimiert und deren Stärken in einem finalen Modell bewahrt werden.

- Leistungsüberwachung: Regelmäßige Tests und Benchmarks sollten genutzt werden, um sicherzustellen, dass das Model Merging zu tatsächlichen Verbesserungen in Leistung und Sicherheit führt.

Welche Trends gibt es im B2B-Marketing für 2024?

Ein wachsender Trend im B2B-Marketing ist die zunehmende Integration von KI und LLMs zur Verbesserung der Personalisierung und der zielgerichteten Kundenansprache. Durch KI-gestützte Modelle können Unternehmen in Echtzeit auf sich ändernde Kundenbedürfnisse reagieren und ihre Marketingstrategien kontinuierlich anpassen.

LAPA: Ein weiteres Beispiel für Fortschritte im Bereich der Robotersteuerung

Ein ähnlicher Fortschritt ist auch im Bereich der Robotik zu sehen, wo das Team um LAPA (Latent Action Pretraining) von KAIST, Microsoft Research und der University of Washington ein Verfahren zur unüberwachten Vortraining von Vision-Language-Action (VLA)-Modellen entwickelt hat. Ziel dieses Modells ist es, robotergesteuerte Aktionen ohne umfangreiche, menschlich gekennzeichnete Daten auszuführen. LAPA ermöglicht es, dass Roboter aus großangelegten Internetvideos lernen, ohne dass explizite Aktionsdaten vorhanden sind.

Fazit und Handlungsaufforderung

Die aktuellen Forschungen im Bereich von Model Merging und Data Mixing bieten vielversprechende Ansätze, um LLMs sowohl in Bezug auf Leistung als auch Sicherheit zu optimieren. Insbesondere in multilingualen und multikulturellen Anwendungen wird dies eine Schlüsselrolle spielen. Mit fortschrittlichen Techniken wie SLERP und TIES können Entwickler spezialisierte Modelle nutzen, um maßgeschneiderte Lösungen für spezifische Anwendungsfälle zu schaffen.

Quellen und Referenzen:

- Cohere AI Research zu Merging vs. Data Mixing

- LAPA: Latent Action Pretraining

- Latent Action Pretraining for Robotics