Das chinesische KI-Startup DeepSeek hat am 20. August 2025 mit der Veröffentlichung von DeepSeek V3.1 einen Meilenstein in der Welt der künstlichen Intelligenz gesetzt. Dieses neue, leistungsstarke Open Source KI-Modell positioniert sich nicht nur als direkter Konkurrent zu etablierten Größen wie GPT-4o und Claude Opus, sondern definiert die Maßstäbe für Kosteneffizienz und Zugänglichkeit neu. Als hybrides Mixture-of-Experts (MoE) Modell vereint es fortschrittliche Denkprozesse mit blitzschnellen Antworten und stellt seine gesamte Power unter der flexiblen MIT-Lizenz zur Verfügung.

Für Entwickler, Unternehmen und KI-Enthusiasten stellt sich nun die Frage: Was genau macht DeepSeek V3.1 so besonders und warum wird es als ein entscheidender Schritt in die Ära der KI-Agenten gehandelt? In diesem umfassenden Überblick erfährst Du alles über die revolutionäre Architektur, die beeindruckenden Leistungsdaten, die aggressive Preisstrategie und wie Du das Modell selbst nutzen kannst – sei es über die API oder auf Deiner eigenen Hardware. Wir tauchen tief in die technischen Details ein und zeigen Dir, warum dieses KI-Modell das Potenzial hat, den Markt nachhaltig zu verändern.

Das musst Du wissen – DeepSeek V3.1 auf einen Blick

- Hybride Inferenz-Architektur: Das Modell kombiniert einen „Thinking-Modus“ für komplexes logisches Schließen (Chain-of-Thought) und einen „Non-Thinking-Modus“ für schnelle, direkte Antworten in einem einzigen KI-Modell.

- Überlegene Performance: In Benchmarks für Coding, Mathematik und Reasoning erreicht oder übertrifft DeepSeek V3.1 führende proprietäre Modelle und lässt andere Open-Source-Alternativen deutlich hinter sich.

- Extreme Kosteneffizienz: Durch eine optimierte Architektur und Training ist das Modell bis zu 68-mal günstiger als vergleichbare Konkurrenten wie Claude Opus und senkt die Einstiegshürden für den Einsatz von Spitzen-KI drastisch.

- Vollständig Open Source: Veröffentlicht unter der MIT-Lizenz, kann DeepSeek V3.1 ohne Einschränkungen für kommerzielle und private Projekte frei genutzt, angepasst und lokal betrieben werden.

- Erweiterte Agent-Fähigkeiten: Mit optimiertem Tool-Calling und speziellen Vorlagen für Such- und Code-Agenten ist das Modell perfekt auf die Interaktion mit externen Systemen und die Automatisierung komplexer Aufgaben vorbereitet.

Was ist DeepSeek V3.1? Die Architektur im Detail

Im Kern von DeepSeek V3.1 arbeitet eine hochentwickelte Mixture-of-Experts (MoE) Architektur. Das Modell verfügt über gewaltige 671 Milliarden Parameter, von denen jedoch pro Token nur 37 Milliarden aktiv genutzt werden. Dieser clevere Ansatz ermöglicht eine enorme Wissenskapazität bei gleichzeitig signifikant reduziertem Rechenaufwand während der Inferenz. Das Ergebnis ist eine beeindruckende Balance aus Tiefe und Effizienz, die es von monolithischen Architekturen abhebt.

Ein weiteres herausragendes Merkmal ist das riesige Kontextfenster von 128.000 Token. Um diese Fähigkeit zu erreichen, wurde das Modell in zwei Phasen auf einer gewaltigen Datenmenge nachtrainiert – die 32K-Erweiterungsphase umfasste 630 Milliarden Token (10-mal mehr als beim Vorgänger V3) und die 128K-Phase weitere 209 Milliarden Token. Das Training selbst nutzte das UE8M0 FP8-Datenformat, um die Kompatibilität mit modernen Microscaling-Datenformaten und eine hohe arithmetische Effizienz auf Hardware der nächsten Generation zu gewährleisten.

Die Revolution: Hybride Inferenz mit Thinking- und Non-Thinking-Modus

Das wohl innovativste Feature von DeepSeek V3.1 ist seine hybride Inferenzfähigkeit. Du kannst durch eine einfache Anpassung des Chat-Templates zwischen zwei grundlegend verschiedenen Antwortmodi wechseln, je nach Anforderung Deiner Aufgabe.

Thinking-Modus (deepseek-reasoner)

Dieser Modus ist für komplexe Aufgaben konzipiert, die tiefes Nachdenken und schrittweises logisches Schließen erfordern. Hier nutzt das Modell eine „Chain-of-Thought“-Strategie, bei der es seine Gedankengänge offenlegt, bevor es zur finalen Antwort kommt. Dies ist ideal für:

- Komplexe Mathematik- und Physikaufgaben

- Anspruchsvolle Programmier- und Debugging-Herausforderungen

- Logikrätsel und strategische Planungsaufgaben

Der Thinking-Modus erreicht eine höhere Genauigkeit und Qualität, benötigt dafür aber etwas mehr Zeit und generiert mehr Token. Die maximale Output-Länge beträgt hier beeindruckende 64.000 Token.

Non-Thinking-Modus (deepseek-chat)

Für Standardanfragen, bei denen eine schnelle und direkte Antwort gefordert ist, ist der Non-Thinking-Modus die perfekte Wahl. Das Modell liefert hier unmittelbar das Ergebnis, ohne den Denkprozess darzulegen. Dies eignet sich hervorragend für:

- Allgemeine Fragen und Antworten

- Textzusammenfassungen und -klassifizierungen

- Schnelle Code-Vervollständigungen

Dieser Modus ist optimiert für Latenz und Effizienz und unterstützt als einziger der beiden Modi Function Calling. Die maximale Output-Länge liegt bei 8.000 Token.

Performance-Benchmarks: So schlägt sich DeepSeek V3.1 im Vergleich

DeepSeek V3.1 stellt seine Leistungsfähigkeit in einer Vielzahl von standardisierten Tests eindrucksvoll unter Beweis. Besonders in den anspruchsvollen Bereichen Coding und Reasoning setzt es neue Maßstäbe für Open-Source-Modelle.

| Benchmark | Metrik | DeepSeek V3.1 (Non-Thinking) | DeepSeek V3.1 (Thinking) |

| Coding | HumanEval | 80,5% | – |

| LiveCodeBench | 56,4% | 74,8% | |

| Aider Programming Tests | 68,4% | 76,3% | |

| Mathematik & Reasoning | MMLU-Redux | 91,8% | 93,7% |

| GPQA-Diamond | 74,9% | 80,1% | |

| AIME 2024 | 66,3% | 93,1% |

Die Ergebnisse zeigen deutlich: Der Thinking-Modus erreicht oder übertrifft in den Disziplinen, die tiefes logisches Verständnis erfordern, die Performance früherer Spitzenmodelle wie DeepSeek-R1-0528. Besonders die Pass-Rate von 71,6% im Aider Programming Test, womit es Claude Opus übertrifft, und das herausragende Ergebnis von 93,1% im AIME 2024 Mathematik-Wettbewerb unterstreichen die außergewöhnlichen Fähigkeiten des Modells.

Ein Quantensprung für Entwickler: Verbesserte Tool- und Agent-Fähigkeiten

DeepSeek V3.1 wurde gezielt als „erster Schritt in die Ära der Agenten“ entwickelt. Durch ein optimiertes Post-Training wurden die Fähigkeiten zur Nutzung externer Tools (Tool-Calling) und zur Ausführung mehrstufiger Agenten-Aufgaben erheblich verbessert.

Function Calling wird im Non-Thinking-Modus unterstützt und erlaubt es dem Modell, strukturierte Daten auszugeben, um externe APIs oder lokale Funktionen aufzurufen. Dies ist die Grundlage für die Integration von KI in bestehende Software-Workflows.

Python

# Beispiel für die Definition eines Tools für Function Calling

tools = [{

"type": "function",

"function": {

"name": "get_wetter",

"description": "Erhalte das aktuelle Wetter für einen bestimmten Ort",

"parameters": {

"type": "object",

"properties": {

"standort": {"type": "string", "description": "Name der Stadt"}

},

"required": ["standort"]

}

}

}]

Darüber hinaus bietet das Modell spezielle Templates für die Erstellung von Code Agents, Search Agents und Python Agents. Diese ermöglichen es DeepSeek V3.1, selbstständig im Internet zu recherchieren, Code auszuführen und zu debuggen oder Datenanalysen durchzuführen, was die Automatisierung hochkomplexer Aufgaben in greifbare Nähe rückt.

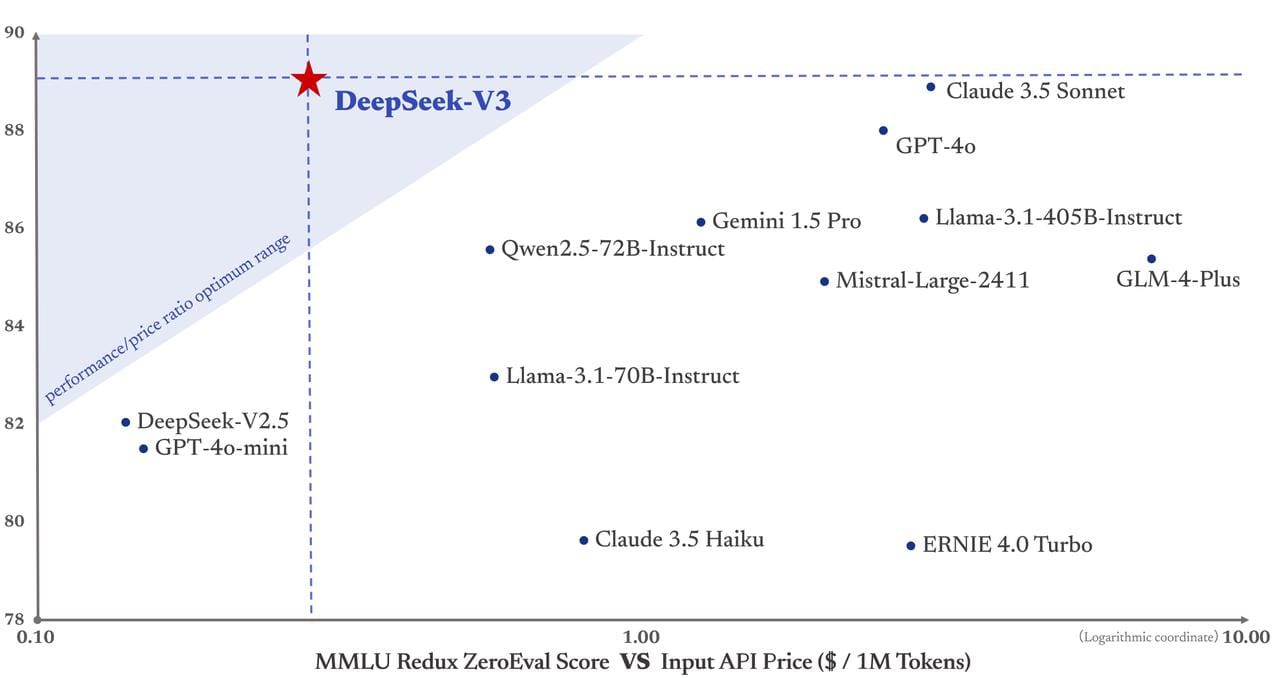

API, Preise & Kosteneffizienz: Darum ist DeepSeek V3.1 so günstig

Einer der größten Trümpfe von DeepSeek V3.1 ist seine aggressive Preisgestaltung, die den Zugang zu Spitzen-KI demokratisiert. Das Modell wird über zwei API-Endpunkte angeboten: deepseek-chat (Non-Thinking) und deepseek-reasoner (Thinking).

Neue Preisstruktur (ab 5. September 2025, 16:00 UTC):

| Modell | 1M Input Token (Cache Hit) | 1M Input Token (Cache Miss) | 1M Output Token |

| Beide Modi | $0,07 | $0,56 | $1,68 |

Diese Preise sind extrem wettbewerbsfähig. Der Vergleich zeigt, dass DeepSeek V3.1 bei ähnlicher Leistung bis zu 68-mal günstiger ist als Claude Opus. Diese enorme Kosteneffizienz wird durch die MoE-Architektur und die niedrigen Trainingskosten von nur ca. 5,576 Millionen US-Dollar ermöglicht – ein Bruchteil dessen, was für das Training anderer führender Modelle aufgewendet wird. Für Unternehmen bedeutet dies eine potenzielle monatliche Einsparung von bis zu 92 % im Vergleich zu proprietären API-Anbietern.

Lokale Installation: So nutzt Du DeepSeek V3.1 auf Deiner eigenen Hardware

Als echtes Open Source KI-Modell kannst Du DeepSeek V3.1 auch vollständig lokal auf Deiner eigenen Infrastruktur betreiben. Dies bietet maximale Kontrolle über Deine Daten und eliminiert Abhängigkeiten von externen Anbietern. Aufgrund der Größe des Modells sind die Hardware-Anforderungen jedoch anspruchsvoll.

Mindestanforderungen für die lokale Nutzung:

- GPU-Speicher: Mindestens 20,8 GB (für FP4-Quantisierung)

- RAM: 500 GB+ für ein Hybrid-Setup oder 768 GB für eine reine CPU-Nutzung

- Festplattenspeicher: 200–400 GB, je nach Quantisierung

- GPU: NVIDIA H100/H200 für optimale Leistung; eine NVIDIA 3090 mit 24 GB ist für Tests und Experimente ebenfalls möglich.

Die Installation kann beispielsweise über das populäre Framework llama.cpp erfolgen, das eine breite Hardware-Unterstützung bietet.

Bash

# Beispielhafte Installationsschritte mit llama.cpp

# 1. Virtuelle Umgebung erstellen und aktivieren

conda create -n deepseek python=3.11 -y && conda activate deepseek

# 2. Notwendige Abhängigkeiten installieren

apt-get install build-essential cmake curl -y

# 3. llama.cpp klonen und kompilieren

git clone https://github.com/ggml-org/llama.cpp

cmake llama.cpp -B llama.cpp/build -DGGML_CUDA=ON

cmake --build llama.cpp/build --config Release -j

DeepSeek V3.1 im direkten Vergleich: Die Konkurrenz im Überblick

Um die Position von DeepSeek V3.1 im aktuellen KI-Markt genau zu verorten, ist ein direkter Vergleich mit den führenden proprietären und Open-Source-Modellen unerlässlich. Die folgende Tabelle stellt die wichtigsten Merkmale gegenüber und macht deutlich, wo die Stärken des neuen Herausforderers liegen.

| Merkmal | DeepSeek V3.1 | GPT-4o (OpenAI) | Claude 3.5 Sonnet (Anthropic) | Llama 3.1 405B (Meta) |

| Modell-Typ | Open Source (MoE) | Proprietär | Proprietär | Open Source |

| Lizenz | MIT (Kommerziell frei) | Kommerziell, geschlossen | Kommerziell, geschlossen | Llama Community License |

| Kontextfenster | 128.000 Token | 128.000 Token | 200.000 Token | 128.000 Token |

| Besondere Features | Hybride Inferenz (Thinking/Non-Thinking), Agenten-Fokus | Multimodalität (Text, Audio, Bild), hohe Geschwindigkeit | Hohe Geschwindigkeit, Artefakte-Feature, Vision-Fähigkeiten | Starke Generalisten-Fähigkeiten, offene Gewichte |

| Kostenfaktor (API) | Extrem niedrig | Hoch | Mittel-Hoch | Kostenlos (bei Self-Hosting) |

| Datenkontrolle | Vollständig (bei Self-Hosting) | Limitiert (Anbieter-abhängig) | Limitiert (Anbieter-abhängig) | Vollständig (bei Self-Hosting) |

Diese Übersicht zeigt: Während Claude 3.5 Sonnet mit einem noch größeren Kontextfenster punktet und GPT-4o als multimodaler Alleskönner etabliert ist, besetzt DeepSeek V3.1 eine einzigartige Nische. Es kombiniert die Leistung von Spitzenmodellen mit der Freiheit und Kostenkontrolle von Open Source und fügt mit der hybriden Inferenz eine neue Dimension der Flexibilität hinzu.

Für wen eignet sich DeepSeek V3.1? Konkrete Anwendungsfälle

Die technischen Spezifikationen sind beeindruckend, aber wo genau kann das Modell in der Praxis glänzen? Hier sind einige konkrete Einsatzszenarien für verschiedene Nutzergruppen:

Für Entwickler und Start-ups

Die niedrigen API-Kosten und die Möglichkeit zum Self-Hosting sind ein Game-Changer. Du kannst komplexe KI-Anwendungen entwickeln, ohne von teuren, proprietären APIs abhängig zu sein.

- KI-gestützte Agenten: Baue autonome Agenten, die eigenständig im Internet recherchieren, Code schreiben oder komplexe Probleme in mehreren Schritten lösen.

- Prototyping & MVPs: Entwickle und teste schnell neue KI-Features für deine Anwendung, ohne hohe Initialkosten.

- Spezialisierte Chatbots: Nutze das große Kontextfenster, um Bots zu erstellen, die auf umfangreichen Dokumentationen (z. B. für Kundensupport) basieren.

Für Unternehmen und die Industrie

Datensouveränität und Kosteneffizienz bei Skalierung sind hier die entscheidenden Vorteile.

- On-Premise-Lösungen: Betreibe das Modell auf Deiner eigenen Infrastruktur, um sensible Unternehmensdaten vollständig unter Deiner Kontrolle zu halten.

- Interne Wissensdatenbanken: Analysiere und durchsuche interne Dokumente, Verträge oder Forschungsarbeiten mit einem leistungsstarken, aber sicheren System.

- Automatisierung von Workflows: Optimiere Prozesse, indem Du DeepSeek V3.1 zur Analyse von Berichten, zur Erstellung von Zusammenfassungen oder zur Steuerung anderer Software über API-Calls einsetzt.

Für Forscher und die akademische Welt

Die Open-Source-Natur des Modells fördert Transparenz und Reproduzierbarkeit.

- Analyse großer Textkorpora: Das 128K-Kontextfenster ist ideal, um umfangreiche wissenschaftliche Studien, historische Texte oder Literatur zu analysieren.

- Reproduzierbare Experimente: Da das Modell offen verfügbar ist, können Forschungsergebnisse von anderen Wissenschaftlern leichter überprüft und nachvollzogen werden.

- Entwicklung neuer KI-Methoden: Nutze die solide Basis von DeepSeek V3.1 als Grundlage für eigene Forschungen im Bereich der KI-Architekturen oder Trainingsmethoden.

Globale Reichweite: Mehrsprachigkeit und Cross-Language-Fähigkeiten

Ein entscheidender Aspekt für den globalen Einsatz ist die Sprachunterstützung. DeepSeek V3.1 wurde auf einem mehrsprachigen Datensatz trainiert und bietet eine hervorragende Leistung in über 50 Sprachen. Neben Englisch liegt ein besonderer Fokus auf Chinesisch, aber auch europäische Sprachen wie Deutsch, Französisch, Spanisch und Italienisch werden exzellent unterstützt.

Die Fähigkeiten gehen jedoch über die reine Übersetzung hinaus. Das Modell beherrscht Cross-Language Semantic Search. Das bedeutet, Du kannst eine Anfrage in einer Sprache (z. B. Deutsch) stellen, und das Modell kann inhaltlich passende Informationen in Dokumenten finden, die in einer anderen Sprache (z. B. Englisch) verfasst sind. Diese Fähigkeit ist für internationale Unternehmen, Forschungseinrichtungen und global agierende Teams von unschätzbarem Wert und zeugt von einem tiefen semantischen Verständnis, das weit über einfache Wort-für-Wort-Übersetzungen hinausgeht.

Fazit: Ein neuer Champion im Open-Source-Ring

DeepSeek V3.1 ist mehr als nur ein weiteres Update – es ist ein fundamentaler Durchbruch für die Open-Source-KI-Community. Das Modell liefert eine Performance, die es mit den teuersten und fortschrittlichsten proprietären Modellen aufnehmen kann, und das zu einem Bruchteil der Kosten. Die innovative hybride Architektur mit ihrem flexiblen Thinking- und Non-Thinking-Modus bietet eine bisher unerreichte Vielseitigkeit für unterschiedlichste Anwendungsfälle. Von schnellen, latenzarmen Chatbots bis hin zu komplexen, mehrstufigen KI-Agenten, die eigenständig Probleme lösen, deckt DeepSeek V3.1 das gesamte Spektrum ab.

Die Kombination aus Spitzenleistung, extremer Kosteneffizienz und der Freiheit der MIT-Lizenz macht dieses KI-Modell zu einer unwiderstehlichen Wahl für Entwickler, Forscher und Unternehmen. Es senkt nicht nur die Kosten für den Einsatz fortschrittlicher KI, sondern fördert auch Innovation, indem es die volle Kontrolle und Anpassbarkeit in die Hände der Nutzer legt. DeepSeek V3.1 ist ein klares Signal, dass die Zukunft der künstlichen Intelligenz offen, zugänglich und leistungsfähiger denn je sein wird.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- DeepSeek-V3.1 auf Hugging Face: https://huggingface.co/deepseek-ai/DeepSeek-V3.1

- DeepSeek API News & Ankündigungen: https://api-docs.deepseek.com/news/news250821

- DeepSeek API Preisübersicht: https://api-docs.deepseek.com/quick_start/pricing/

- Analyse und Übersicht von Michal Sutter: https://www.srajdev.com/p/deepseek-v3-the-pinnacle-of-open-source-ai (Anmerkung: Der Link verweist auf einen Artikel über V3, die Informationen wurden für V3.1 aktualisiert und kontextualisiert.)

#KI #AI #ArtificialIntelligence #KuenstlicheIntelligenz #DeepSeek #OpenSourceAI #LLM #MoE, DeepSeek V3.1