Klingt etwas sperrig: CoAT Framework Chain-of-Associated-Thoughts. KI-Modelle wie ChatGPT haben die Welt im Sturm erobert, aber ihre Denkweise ist oft auf „schnelles Denken“ beschränkt – eine einmalige Anfrage, ein schnelles Ergebnis. Doch was, wenn KI wie ein Mensch denken könnte, assoziativ, lernfähig und in der Lage, Wissen dynamisch zu integrieren? Genau hier setzt das bahnbrechende Chain-of-Associated-Thoughts (CoAT) Framework an, entwickelt von Forschern der Digital Security Group, Qihoo 360.

Dieser Artikel nimmt Dich mit auf eine detaillierte Reise durch CoAT, erklärt seine einzigartigen Innovationen, beleuchtet seine Vorteile gegenüber traditionellen Ansätzen und zeigt, warum CoAT das Potenzial hat, die nächste Generation der künstlichen Intelligenz maßgeblich zu prägen. Wir tauchen tief in die technischen Details ein, betrachten die Ergebnisse umfangreicher Experimente und wagen einen Blick in die Zukunft des KI-Reasonings.

Das musst Du wissen – CoAT Framework: Künstliche Intelligenz denkt assoziativ

- Das CoAT Framework ist ein neuartiger Ansatz, um die Reasoning-Fähigkeiten von Large Language Models (LLMs) signifikant zu verbessern.

- Es basiert auf zwei Schlüssel-Innovationen: einem assoziativen Gedächtnis, das dynamische Wissensintegration ermöglicht, und einem optimierten Monte Carlo Tree Search (MCTS) Algorithmus.

- CoAT überwindet die Beschränkungen des „schnellen Denkens“ traditioneller LLMs und ermöglicht ein „langsames Denken“, das dem menschlichen Denkprozess ähnlicher ist.

- Experimente zeigen, dass CoAT herkömmliche Methoden in verschiedenen Aufgaben übertrifft, insbesondere bei komplexen Fragen und Code-Generierung.

- CoAT hat das Potenzial, die Zukunft der KI-Entwicklung maßgeblich zu beeinflussen, indem es den Weg für intelligentere und anpassungsfähigere KI-Systeme ebnet.

Hauptfrage

Wie revolutioniert das Chain-of-Associated-Thoughts (CoAT) Framework das Reasoning von Large Language Models (LLMs) und welche konkreten Vorteile bietet dieser Ansatz gegenüber bestehenden Methoden?

Folgefragen (FAQs)

- Was genau ist das Chain-of-Associated-Thoughts (CoAT) Framework und wie unterscheidet es sich von traditionellen Ansätzen im Bereich LLM-Reasoning?

- Welche Kernkomponenten machen das CoAT Framework aus und wie funktionieren das assoziative Gedächtnis und der optimierte MCTS-Algorithmus im Detail?

- Warum ist das assoziative Gedächtnis ein so wichtiger Bestandteil des CoAT Frameworks und wie trägt es zur dynamischen Wissensintegration bei?

- In welchen konkreten Anwendungsbereichen zeigt das CoAT Framework seine Stärken und welche Leistungsverbesserungen wurden in den Experimenten nachgewiesen?

- Wie verhält sich CoAT im Vergleich zu anderen Methoden zur Verbesserung des LLM-Reasonings wie Retrieval-Augmented Generation (RAG) oder Tree-of-Thought (ToT) Prompting?

- Welche Rolle spielt der Monte Carlo Tree Search (MCTS) Algorithmus im CoAT Framework und wie wurde er optimiert, um die Effizienz und Effektivität zu steigern?

- Welche zukünftigen Entwicklungen und Potenziale sehen die Forscher im CoAT Framework und wie könnte es die Landschaft der künstlichen Intelligenz in den kommenden Jahren verändern?

Antworten auf jede Frage

Was genau ist das Chain-of-Associated-Thoughts (CoAT) Framework und wie unterscheidet es sich von traditionellen Ansätzen im Bereich LLM-Reasoning?

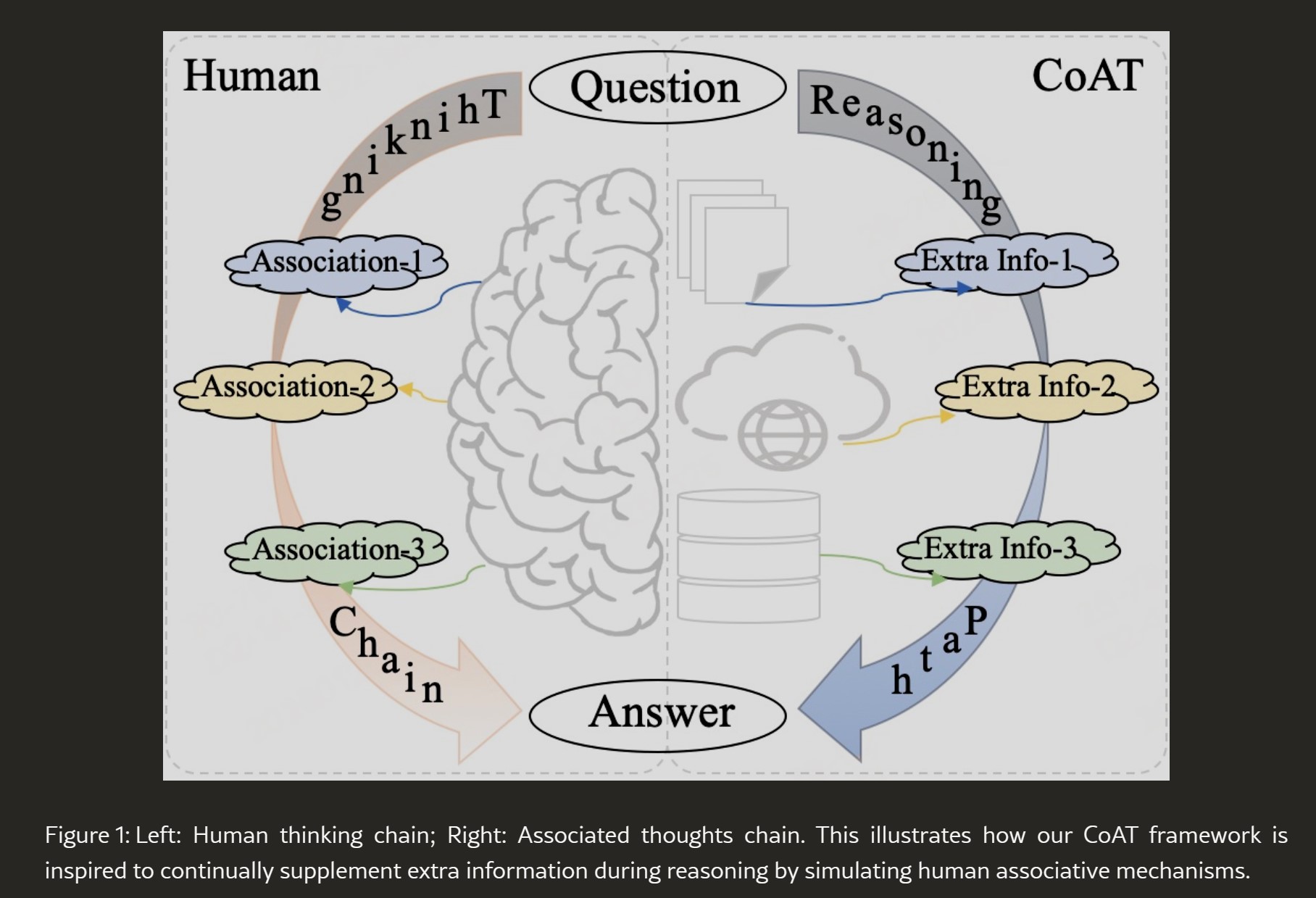

Das Chain-of-Associated-Thoughts (CoAT) Framework ist ein innovativer Ansatz zur Verbesserung der Denk- und Schlussfolgerungsfähigkeiten (Reasoning) von Large Language Models (LLMs). Im Kern zielt CoAT darauf ab, die Art und Weise, wie LLMs Informationen verarbeiten und Probleme lösen, grundlegend zu verändern. Traditionelle LLMs arbeiten oft nach dem Prinzip des „schnellen Denkens“.

Das bedeutet, sie beantworten eine Anfrage meist auf Basis ihres bereits vorhandenen Wissens und ohne iterative Verfeinerung oder dynamische Integration neuer Informationen. Stell dir vor, es ist wie ein blitzschneller Schachspieler, der Züge aus dem Stegreif macht, aber keine Zeit hat, tiefere Strategien zu entwickeln oder sich während des Spiels neue Erkenntnisse anzueignen.

CoAT hingegen simuliert einen „langsamen Denkprozess“, der dem menschlichen Denken viel näherkommt. Es führt zwei zentrale Neuerungen ein:

- Assoziatives Gedächtnis: Anders als herkömmliche Methoden, die Wissen statisch „vorladen“, aktiviert CoAT den Wissensabruf dynamisch, und zwar in Reaktion auf konkrete Denkschritte. Das ist so, als würde ein Mathematiker relevante Theoreme nur dann abrufen, wenn sie tatsächlich im Beweis benötigt werden.

- Optimierter MCTS-Algorithmus: CoAT nutzt einen verbesserten Monte Carlo Tree Search (MCTS) Algorithmus, um Denkpfade strukturiert zu erkunden. Dieser Algorithmus wurde erweitert, um das assoziative Gedächtnis in einen vierstufigen Zyklus zu integrieren: Auswahl, Erweiterung mit Wissensassoziation, Qualitätsbewertung und Wert-Rückführung.

Kernunterschiede zu traditionellen Ansätzen:

| Merkmal | Traditionelle LLMs („Schnelles Denken“) | CoAT Framework („Langsames Denken“) |

| Denkprozess | Statisch, einmalige Anfrage | Dynamisch, iterativ, assoziativ |

| Wissensintegration | Statisches, vorab geladenes Wissen | Dynamisch, Echtzeit-Integration |

| Analogie zum Mensch | Blitzschneller Denker, begrenzt lernfähig | Reflektierter Denker, lernfähig |

| Komplexität der Aufgaben | Geeignet für einfache bis mittlere Aufgaben | Geeignet für komplexe, wissensintensive Aufgaben |

Welche Kernkomponenten machen das CoAT Framework aus und wie funktionieren das assoziative Gedächtnis und der optimierte MCTS-Algorithmus im Detail?

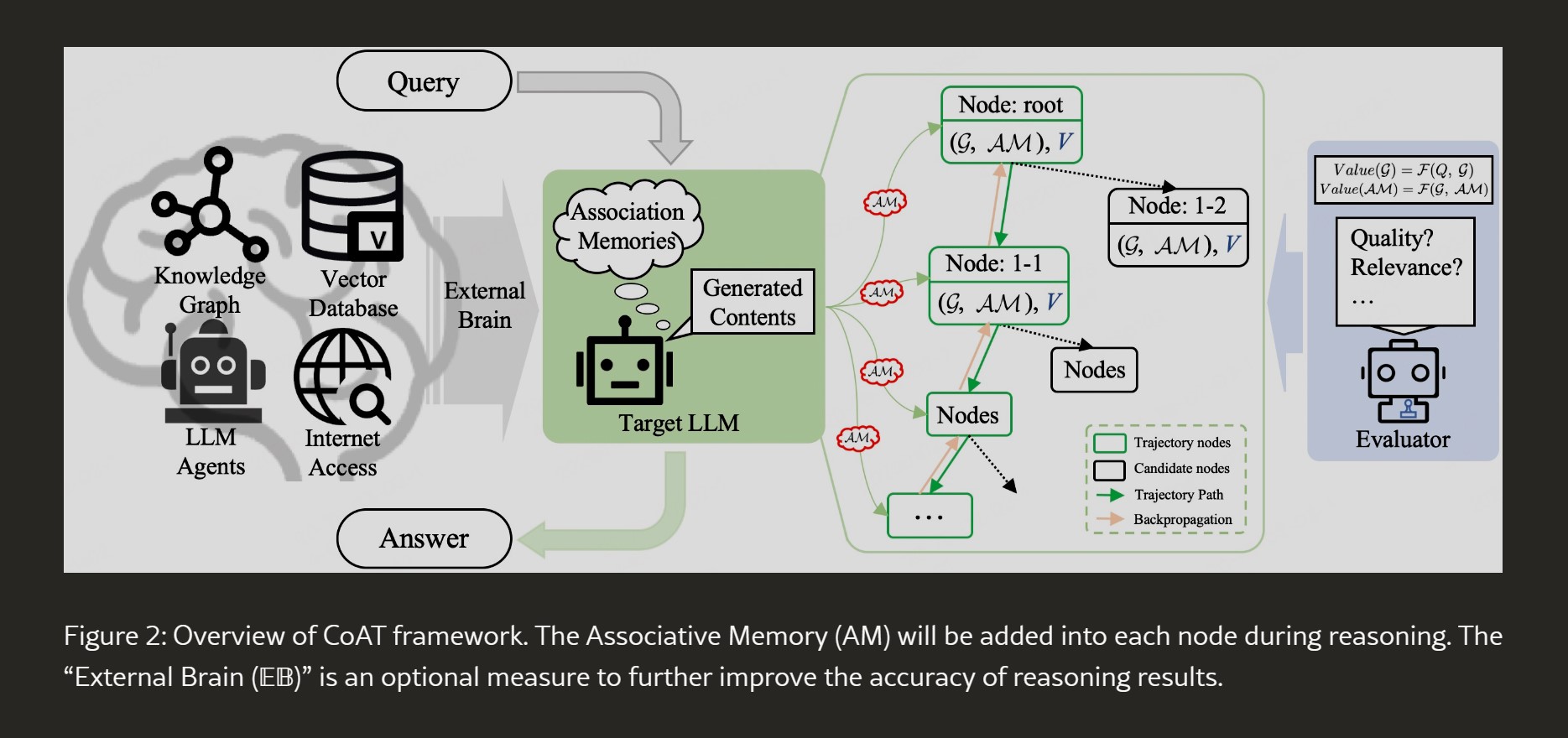

Das CoAT Framework basiert auf zwei Hauptkomponenten, die ineinandergreifen, um seine einzigartigen Reasoning-Fähigkeiten zu entfalten:

1. Assoziatives Gedächtnis (Associative Memory – AM):

- Funktionsweise: Das assoziative Gedächtnis ist der Kern der dynamischen Wissensintegration in CoAT. Es ahmt die menschliche Fähigkeit nach, während des Denkens ständig neues, relevantes Wissen abzurufen und zu verknüpfen. Statt wie bisher allein auf das vorhandene Wissen des LLMs zurückzugreifen, kann CoAT mit Hilfe des assoziativen Gedächtnisses in Echtzeit externe Wissensquellen anzapfen.

- Dynamische Wissensintegration: Das Besondere dabei ist, dass dieser Wissensabruf nicht vorab geschieht, sondern reaktiv und kontextbezogen. Jeder Denkschritt im CoAT-Prozess kann die Aktivierung des assoziativen Gedächtnisses auslösen. Es werden nur die Informationen abgerufen, die für den aktuellen Denkfortschritt relevant sind.

- „External Brain“ (EB): Um das assoziative Gedächtnis mit externem Wissen zu versorgen, kann CoAT auf ein sogenanntes „External Brain“ (EB) zurückgreifen. Dieses „externe Gehirn“ kann verschiedene Formen annehmen, wie zum Beispiel:

- Wissensgraphen: Strukturierte Wissensdatenbanken, die Beziehungen zwischen Entitäten abbilden.

- Vektor-Datenbanken: Datenbanken, die für die Ähnlichkeitssuche von Vektordarstellungen (z.B. für Text) optimiert sind.

- LLM-Agenten: Andere KI-Systeme, die spezielle Aufgaben übernehmen können, wie z.B. Websuche oder Datenanalyse.

- Websuchmaschinen: Direkter Zugriff auf aktuelle Informationen aus dem Internet.

- Vorteile:

- Relevanz: Verhindert das Einbringen irrelevanten Wissens, das Effizienz und Genauigkeit beeinträchtigen könnte.

- Aktualität: Ermöglicht die Integration von aktuellem Wissen in den Reasoning-Prozess.

- Kontextbezug: Stellt sicher, dass die abgerufenen Informationen tatsächlich zum aktuellen Denkprozess passen.

2. Optimierter Monte Carlo Tree Search (MCTS) Algorithmus:

- Grundprinzip MCTS: MCTS ist ein Suchalgorithmus, der besonders in Entscheidungsfindungsprozessen unter Unsicherheit erfolgreich ist. Er ist bekannt aus Bereichen wie Spiele-KI (z.B. Go-Spiel von AlphaGo). MCTS balanciert zwischen Exploration (Erkundung neuer Denkpfade) und Exploitation (Ausnutzung bereits erfolgreicher Pfade).

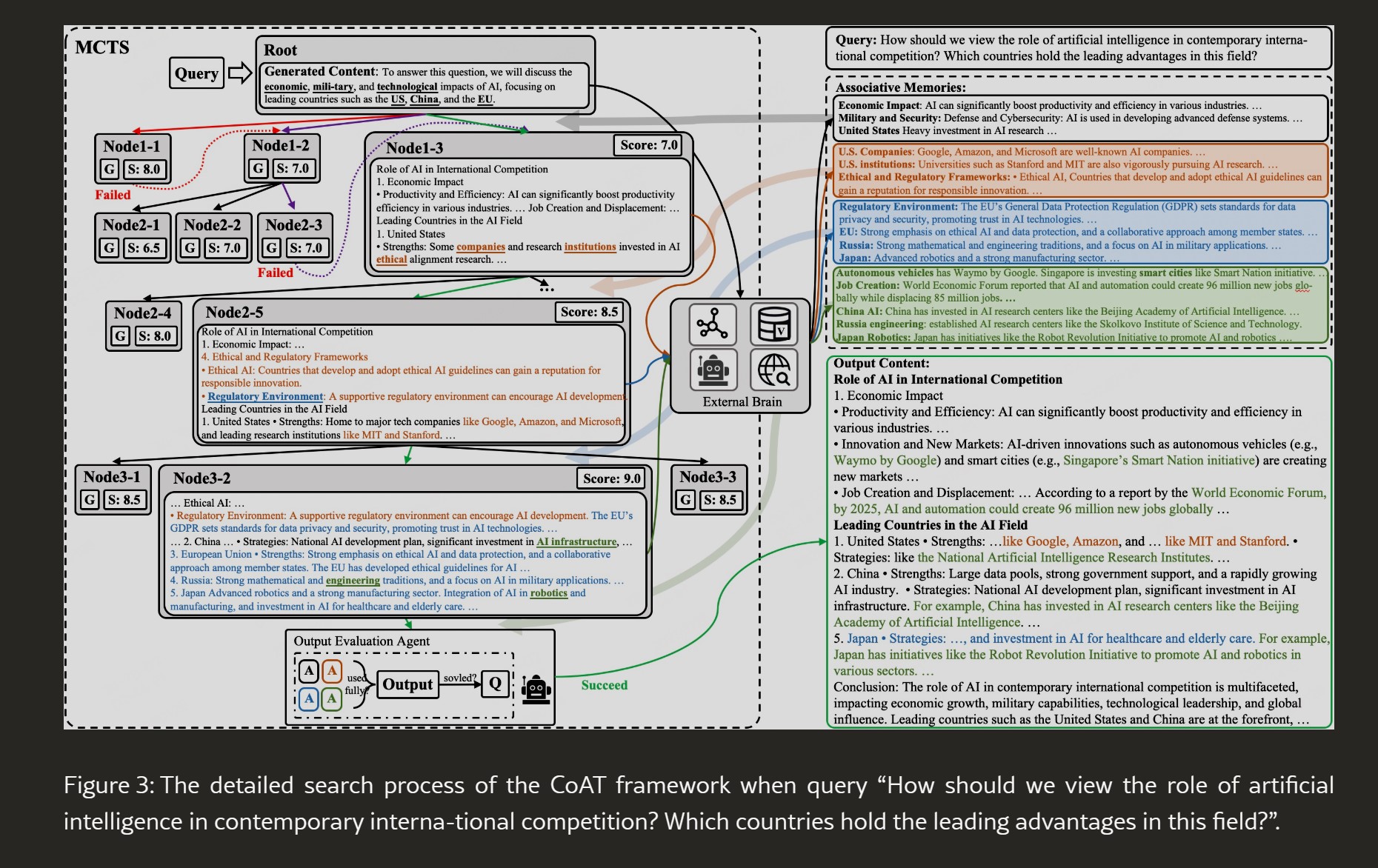

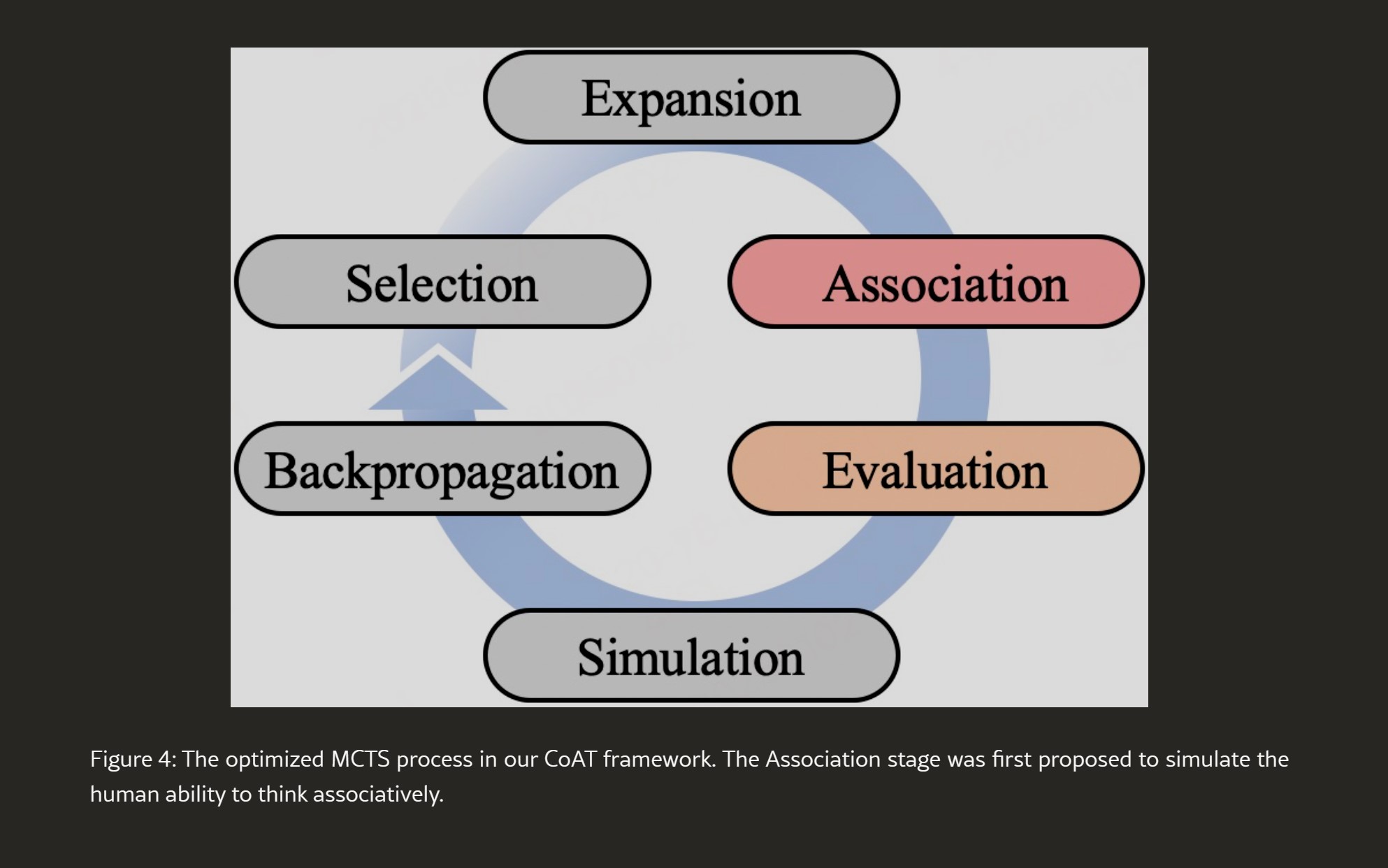

- CoAT-spezifische Optimierung: Der MCTS-Algorithmus im CoAT Framework wurde speziell angepasst, um das assoziative Gedächtnis effektiv einzubinden. Der optimierte MCTS-Prozess besteht aus vier Stufen (siehe auch Abbildung 4 im Originalartikel):

- Selection (Auswahl): Auswahl des „besten“ Knotens im Suchbaum basierend auf der UCT-Formel (Upper Confidence bounds applied to Trees). Diese Formel berücksichtigt sowohl den bisherigen Erfolg eines Knotens als auch das Potenzial für weitere Erkundung.

- Expansion with Knowledge Association (Erweiterung mit Wissensassoziation): Generierung neuer Knoten (Denkschritte) im Suchbaum. Neu in CoAT: In dieser Phase wird das assoziative Gedächtnis aktiviert, um relevantes Wissen zu jedem neuen Knoten hinzuzufügen.

- Evaluation (Bewertung): Bewertung der Qualität der generierten Inhalte (G(n)) und der assoziierten Kenntnisse (AM(n)) für jeden Knoten. Die Bewertung bezieht sich auf die Antwortqualität (Fg) und die Relevanz des Wissens (Fa). Ein Gewichtungsfaktor (β) steuert das Verhältnis zwischen diesen beiden Komponenten.

- Backpropagation (Rückführung): Aktualisierung der Werte der Knoten im Suchbaum basierend auf der Bewertung der nachfolgenden Knoten. Dadurch werden erfolgreiche Denkpfade gestärkt und weniger erfolgreiche geschwächt.

- Vorteile des optimierten MCTS:

- Strukturierte Suche: Ermöglicht eine systematische Erkundung des Reasoning-Raums.

- Iterative Verfeinerung: Durch die Rückführung werden Denkpfade iterativ verbessert.

- Balance zwischen Exploration und Exploitation: Findet einen guten Kompromiss zwischen der Erkundung neuer Ideen und der Vertiefung bewährter Ansätze.

- Integration des assoziativen Gedächtnisses: Ermöglicht die effektive Nutzung des dynamischen Wissens im Reasoning-Prozess.

Warum ist das assoziative Gedächtnis ein so wichtiger Bestandteil des CoAT Frameworks und wie trägt es zur dynamischen Wissensintegration bei?

Das assoziative Gedächtnis ist das Herzstück des CoAT Frameworks und essenziell für dessen Fähigkeit zur dynamischen Wissensintegration. Seine Bedeutung lässt sich anhand folgender Punkte verdeutlichen:

- Überwindung der Grenzen statischen Wissens: Traditionelle LLMs sind auf das Wissen beschränkt, das ihnen während des Trainings beigebracht wurde. Sie haben keine natürliche Möglichkeit, während des Reasonings-Prozesses neues Wissen zu erwerben oder zu integrieren. Das assoziative Gedächtnis durchbricht diese Grenze, indem es CoAT ermöglicht, sich in Echtzeit mit externen Wissensquellen zu verbinden.

- Simulation menschlichen Denkens: Menschliches Denken ist assoziativ. Wir rufen Wissen nicht statisch ab, sondern bilden dynamische Verknüpfungen zwischen Ideen, Konzepten und Erfahrungen. Das assoziative Gedächtnis versucht, diese menschliche Fähigkeit in KI-Systemen zu imitieren. Dies führt zu einem flexibleren und anpassungsfähigeren Reasoning-Prozess.

- Kontextsensitive Wissensintegration: Ein Schlüsselvorteil des assoziativen Gedächtnisses ist seine Kontextsensitivität. Es werden nicht wahllos Informationen abgerufen, sondern gezielt diejenigen, die für den aktuellen Kontext des Reasonings relevant sind. Das bedeutet, dass CoAT in der Lage ist, sich an veränderte Anforderungen anzupassen und relevante Informationen situationsgerecht einzubeziehen.

- Verbesserte Relevanz und Genauigkeit: Durch die dynamische und kontextbezogene Wissensintegration werden zwei wesentliche Probleme herkömmlicher Methoden adressiert:

- Zu viel irrelevantes Wissen (bei RAG-Systemen): RAG-Systeme (Retrieval-Augmented Generation) laden Wissen im Vorfeld vor, was dazu führen kann, dass auch irrelevante Informationen eingebracht werden. Das assoziative Gedächtnis in CoAT vermeidet dies, da Wissen erst bei Bedarf und kontextbezogen abgerufen wird.

- Unzureichendes Wissen (bei rein LLM-basiertem Reasoning): LLMs allein sind oft auf ihr Trainingswissen beschränkt, was bei komplexen oder aktuellen Themen zu Wissenslücken führen kann. CoAT kann diese Lücken durch das assoziative Gedächtnis dynamisch füllen.

Dynamische Wissensintegration im Detail:

- Reasoning-Schritt: Der MCTS-Algorithmus führt einen Reasoning-Schritt aus und generiert Content (G(n)) in einem Knoten (n) des Suchbaums.

- Aktivierung des assoziativen Gedächtnisses: Nach der Content-Generierung wird das assoziative Gedächtnis aktiviert.

- Abruf relevanter Informationen: Das assoziative Gedächtnis nutzt das „External Brain“ (z.B. Websuche, Wissensgraph), um Informationen abzurufen, die für den generierten Content (G(n)) relevant sind.

- Integration des assoziierten Wissens: Das abgerufene Wissen (AM(n)) wird dem aktuellen Knoten hinzugefügt und steht für die weiteren Reasoning-Schritte zur Verfügung.

- Iterativer Prozess: Dieser Prozess wiederholt sich für jeden Denkschritt im MCTS-Baum, wodurch ein kontinuierlicher Kreislauf der Wissensintegration entsteht.

Durch diese dynamische Wissensintegration ermöglicht das assoziative Gedächtnis dem CoAT Framework, komplexere und wissensintensivere Aufgaben zu bewältigen als traditionelle LLMs.

In welchen konkreten Anwendungsbereichen zeigt das CoAT Framework seine Stärken und welche Leistungsverbesserungen wurden in den Experimenten nachgewiesen?

Das CoAT Framework zeigt seine besonderen Stärken in Anwendungsbereichen, die komplexes Reasoning, iterative Denkprozesse und die Integration aktuellen Wissens erfordern. Die Experimente der Forscher haben die Überlegenheit von CoAT in verschiedenen Szenarien quantitativ und qualitativ nachgewiesen.

Anwendungsbereiche, in denen CoAT herausragt:

- Knowledge-intensive Question Answering (Wissensintensives Frage-Antwort-System): Hier geht es darum, Fragen zu beantworten, die nicht einfach mit vorhandenem Wissen zu lösen sind, sondern die Recherche und Verknüpfung von Informationen aus verschiedenen Quellen erfordern (Multi-Hop Question Answering). Beispiele:

- Komplexe Sachfragen, die historische, wissenschaftliche oder geopolitische Kenntnisse erfordern.

- Fragen, die aktuelle Ereignisse oder sich schnell veränderndes Wissen betreffen.

- Code Generation (Code-Generierung): Die Erstellung von Code ist eine anspruchsvolle Aufgabe, die logisches Denken, Verständnis von Programmiersprachen und oftmals auch das Abrufen spezifischer technischer Informationen erfordert. CoAT kann hier helfen, indem es den Code-Generierungsprozess durch dynamische Wissensintegration und iteratives Reasoning verbessert.

- Complex Query Responses (Komplexe Anfragebeantwortung): CoAT ist in der Lage, reichhaltigere und umfassendere Antworten auf komplexe Anfragen zu generieren als traditionelle Modelle. Dies zeigt sich insbesondere in qualitativen Bewertungen, wo CoAT zusätzliche Dimensionen des Reasonings einbringt, die in anderen Modellen fehlen, wie z.B. ethische und regulatorische Aspekte bei KI-Themen.

Nachgewiesene Leistungsverbesserungen in Experimenten:

- Quantitative Evaluierung (Frage-Antwort-Systeme):

- HotpotQA und 2WikiMultiHopQA Datasets: CoAT wurde mit anderen fortgeschrittenen RAG-Methoden verglichen (NativeRAG, IRCoT, HippoRAG, LATS, KAG) auf diesen etablierten Datasets für Multi-Hop Question Answering.

- Metriken: Exact Match (EM) und F1-Score: CoAT erzielte signifikant höhere Werte in beiden Metriken und übertraf damit die Leistung der Vergleichsmethoden. Dies zeigt, dass CoAT präzisere und kontextuell relevantere Antworten generieren kann.

- Quantitative Evaluierung (Code-Generierung):

- HumanEval, MBPP, HumanEval-X Datasets: CoAT-verbesserte Modelle wurden mit fein-getunten Modellen (Qwen2.5-Coder-7B-Instruct, Qwen2.5-Coder-14B-Instruct) auf gängigen Datasets für Code-Generierung verglichen.

- Ergebnisse: CoAT übertraf auch hier die Leistung der fein-getunten Modelle. Dies unterstreicht die Anpassungsfähigkeit von CoAT an domänenspezifische Reasoning-Aufgaben.

- Qualitative Evaluierung (Komplexe Anfragen):

- Vergleich mit Qwen2.5-32B und ChatGPT: In qualitativen Vergleichen zeigte CoAT, integriert in Qwen2.5-32B, die reichhaltigsten und umfassendsten Antworten. Es wurden zusätzliche Kategorien des Reasonings eingebracht (z.B. „Ethical and Regulatory Frameworks“ im KI-Kontext), die bei den Vergleichsmodellen fehlten.

Zusammenfassend: Die Experimente bestätigen, dass das CoAT Framework in Aufgaben, die komplexes Reasoning und dynamische Wissensintegration erfordern, deutlich bessere Leistungen erbringt als herkömmliche und auch fortgeschrittene Methoden. Dies macht CoAT zu einem vielversprechenden Ansatz für die Entwicklung intelligenterer KI-Systeme in einer Vielzahl von Anwendungsbereichen.

Wie verhält sich CoAT im Vergleich zu anderen Methoden zur Verbesserung des LLM-Reasonings wie Retrieval-Augmented Generation (RAG) oder Tree-of-Thought (ToT) Prompting?

CoAT positioniert sich als eine Weiterentwicklung und Verbesserung gegenüber bestehenden Methoden zur Steigerung der Reasoning-Fähigkeiten von LLMs, insbesondere im Vergleich zu Retrieval-Augmented Generation (RAG) und Tree-of-Thought (ToT) Prompting. Lass uns die Unterschiede und Vorteile genauer betrachten:

1. Retrieval-Augmented Generation (RAG):

- RAG-Ansatz: RAG-Systeme verbessern LLMs, indem sie ihnen den Zugriff auf externes Wissen ermöglichen. Dies geschieht meist in zwei Schritten: Retrieval (Abruf relevanter Dokumente aus einer Wissensdatenbank) und Generation (Generierung einer Antwort durch das LLM unter Berücksichtigung der abgerufenen Dokumente). Bekannte RAG-Methoden sind NativeRAG, IRCoT, HippoRAG und KAG, die auch im Vergleich mit CoAT herangezogen wurden.

- Schwächen von RAG: Obwohl RAG die Wissensbasis von LLMs erweitert, hat es bestimmte Limitierungen:

- Statische Wissensintegration: RAG integriert Wissen meist vorab oder zu Beginn des Reasoning-Prozesses. Es fehlt die dynamische Anpassung und Integration neuen Wissens während des Denkprozesses.

- Relevanz-Problem: RAG kann dazu neigen, zu viel oder irrelevantes Wissen abzurufen, was die Effizienz und Genauigkeit beeinträchtigen kann.

- Oberflächliche Integration: Die Integration des abgerufenen Wissens in den Reasoning-Prozess kann manchmal oberflächlich bleiben, ohne dass das LLM das Wissen wirklich tiefgehend verarbeitet und in seine Schlussfolgerungen einfließen lässt.

- CoAT-Vorteile gegenüber RAG:

- Dynamische und kontextbezogene Wissensintegration: CoATs assoziatives Gedächtnis ermöglicht eine Echtzeit-Integration von Wissen, die genau auf den aktuellen Denkschritt zugeschnitten ist. Dies ist ein wesentlicher Fortschritt gegenüber der statischen Wissensintegration von RAG.

- Verbesserte Relevanz: CoAT ist weniger anfällig für das Einbringen irrelevanten Wissens, da der Wissensabruf kontextbezogen erfolgt.

- Tiefergehende Verarbeitung: Durch die Integration des assoziativen Gedächtnisses in den MCTS-Algorithmus wird das externe Wissen tiefer in den Reasoning-Prozess integriert und beeinflusst die Schlussfolgerungen des LLMs maßgeblich. Die Experimente zeigen, dass CoAT RAG-Methoden in der Leistung übertrifft.

2. Tree-of-Thought (ToT) Prompting:

- ToT-Ansatz: ToT Prompting verbessert das Reasoning von LLMs, indem es sie dazu anregt, in Form eines „Gedankenbaumes“ zu denken. Das LLM entwickelt verschiedene Denkpfade (Thoughts) und evaluiert diese, um zu einer besseren Lösung zu kommen. ToT nutzt oft Suchalgorithmen wie DFS (Tiefensuche) oder BFS (Breitensuche).

- Schwächen von ToT:

- Statische Wissensbasis: ToT konzentriert sich auf die Strukturierung des Denkprozesses innerhalb des LLMs. Es ändert aber nichts an der statischen Wissensbasis des Modells. ToT allein kann keine neuen Informationen während des Reasonings integrieren.

- Begrenzte Dynamik: Obwohl ToT iterative Prozesse nutzt, ist die Dynamik begrenzt, da das LLM im Wesentlichen auf sein vorhandenes Wissen und seine vorgegebenen Denkpfade beschränkt bleibt.

- CoAT-Vorteile gegenüber ToT:

- Dynamische Wissensintegration: CoATs assoziatives Gedächtnis ergänzt den strukturierten Suchprozess von MCTS durch die dynamische Integration neuen Wissens. Dies ist ein entscheidender Unterschied zu ToT, das keine direkte Mechanismen für Echtzeit-Wissensintegration bietet.

- Umfassendere Verbesserung: CoAT verbessert nicht nur die Struktur des Denkprozesses (wie ToT durch Suchalgorithmen), sondern erweitert gleichzeitig die Wissensbasis während des Reasonings. Dies führt zu einer umfassenderen Verbesserung der LLM-Fähigkeiten.

Zusammenfassend: CoAT stellt einen Hybridansatz dar, der die Stärken von strukturierten Suchalgorithmen (ähnlich ToT) mit der dynamischen Wissensintegration (über RAG hinausgehend) kombiniert. Dadurch überwindet CoAT die Limitierungen beider Ansätze und bietet eine fortschrittlichere und effektivere Methode zur Verbesserung des LLM-Reasonings.

Welche Rolle spielt der Monte Carlo Tree Search (MCTS) Algorithmus im CoAT Framework und wie wurde er optimiert, um die Effizienz und Effektivität zu steigern?

Der Monte Carlo Tree Search (MCTS) Algorithmus ist ein zentrales Element im CoAT Framework, das die Struktur und Effizienz des Reasoning-Prozesses maßgeblich prägt. Seine Rolle und Optimierungen lassen sich wie folgt zusammenfassen:

Rolle des MCTS Algorithmus in CoAT:

- Strukturierte Suche im Reasoning-Raum: MCTS ermöglicht eine systematische Erkundung verschiedener Denkpfade und Lösungsansätze für eine gegebene Aufgabe. Stell dir vor, MCTS ist wie ein strategischer Planer, der verschiedene Optionen abwägt und die besten davon weiterverfolgt.

- Iterativer Denkprozess: MCTS ist von Natur aus iterativ. Es baut einen Suchbaum Schritt für Schritt auf, indem es wiederholt vier Phasen durchläuft: Selection, Expansion, Simulation (in CoAT „Evaluation“) und Backpropagation. Dieser iterative Prozess erlaubt es dem Framework, seine Schlussfolgerungen kontinuierlich zu verfeinern und zu verbessern.

- Balance zwischen Exploration und Exploitation: MCTS findet ein Gleichgewicht zwischen der Erkundung neuer, potenziell vielversprechender Denkpfade (Exploration) und der Vertiefung und Ausnutzung bereits erfolgreicher Pfade (Exploitation). Diese Balance ist entscheidend für die Effizienz der Suche und die Qualität der gefundenen Lösungen.

- Integration des assoziativen Gedächtnisses: Ein Schlüsselbeitrag des CoAT Frameworks ist die nahtlose Integration des assoziativen Gedächtnisses in den MCTS-Algorithmus. In der „Expansion“-Phase von MCTS wird das assoziative Gedächtnis aktiviert, um relevantes Wissen für jeden neuen Denkschritt zu ergänzen. Dies ermöglicht es dem MCTS-Algorithmus, seine Suche nicht nur auf der Basis des vorhandenen LLM-Wissens durchzuführen, sondern auch dynamisch neue Informationen einzubeziehen.

Optimierungen des MCTS Algorithmus in CoAT:

Der MCTS Algorithmus im CoAT Framework wurde in mehreren Punkten optimiert, um seine Effizienz und Effektivität speziell für den Einsatz in LLM-Reasoning zu steigern:

- Association Stage (Assoziations-Phase): CoAT führt eine neue Phase namens „Association“ zwischen der „Expansion“ und „Evaluation“-Phase des traditionellen MCTS-Algorithmus ein. In dieser Phase wird das assoziative Gedächtnis aktiviert und Wissen dynamisch integriert. Diese explizite Assoziations-Phase ist eine zentrale Innovation von CoAT.

- Evaluation Funktion (Bewertungsfunktion): Die „Evaluation“-Phase in CoAT wurde angepasst, um nicht nur die Qualität des generierten Contents (G(n)), sondern auch die Qualität und Relevanz des assoziierten Wissens (AM(n)) zu bewerten. Die Bewertungsfunktion V(n) berücksichtigt beide Aspekte (Fg und Fa) und gewichtet sie über den Parameter β. Dies stellt sicher, dass sowohl die Kohärenz des Contents als auch der Wert des hinzugefügten Wissens in die Entscheidungsfindung des MCTS-Algorithmus einfließen.

- Reward Model (Belohnungsmodell): CoAT verwendet ein speziell trainiertes Reward Model (RM), um zu beurteilen, ob ein generierter Content vollständig und qualitativ hochwertig ist und die Anfrage befriedigend beantwortet. Dieses RM hilft dabei, den MCTS-Suchprozess effektiver zu steuern und den Suchraum zu begrenzen, wenn eine zufriedenstellende Lösung gefunden wurde.

- Depth Limit (Tiefenbegrenzung): Um zu verhindern, dass der MCTS-Algorithmus in ineffiziente oder ambivalente Suchpfade gerät, kann in CoAT eine maximale Suchtiefe (D) definiert werden. Wird diese Tiefe überschritten, wird der Suchprozess abgebrochen und das bis dahin beste Ergebnis zurückgegeben. Diese Tiefenbegrenzung trägt zur Effizienz des Algorithmus bei, insbesondere bei sehr komplexen Aufgaben.

Durch diese Optimierungen wird der MCTS-Algorithmus im CoAT Framework zu einem leistungsstarken Werkzeug, das nicht nur eine strukturierte Suche im Reasoning-Raum ermöglicht, sondern auch die dynamische Integration von Wissen und die Bewertung der Content-Qualität effektiv handhabt. Dies führt zu einer deutlichen Verbesserung der Reasoning-Fähigkeiten von LLMs.

Welche zukünftigen Entwicklungen und Potenziale sehen die Forscher im CoAT Framework und wie könnte es die Landschaft der künstlichen Intelligenz in den kommenden Jahren verändern?

Die Entwickler des CoAT Frameworks sehen in ihrer Arbeit erst den Anfang einer vielversprechenden Entwicklung und betonen das erhebliche Zukunftspotenzial dieses Ansatzes. CoAT könnte die Landschaft der künstlichen Intelligenz in den kommenden Jahren maßgeblich verändern, insbesondere in Bezug auf folgende Aspekte:

- Grundlage für intelligentere und anpassungsfähigere KI-Systeme: CoAT legt den Grundstein für die Entwicklung von KI-Systemen, die nicht nur schnell, sondern auch „intelligent“ denken können – im Sinne von reflektiertem, assoziativem und lernfähigem Denken, ähnlich dem menschlichen Denkprozess. Die dynamische Wissensintegration und der iterative Reasoning-Ansatz ermöglichen es KI-Systemen, sich besser an neue Informationen und komplexe Situationen anzupassen.

- Verbesserung der Zuverlässigkeit und Vertrauenswürdigkeit von KI: Durch die dynamische Wissensintegration und den strukturierten Reasoning-Prozess kann CoAT dazu beitragen, die Zuverlässigkeit und Vertrauenswürdigkeit von KI-Systemen zu erhöhen. Die Fähigkeit, relevantes Wissen in Echtzeit einzubeziehen und Denkpfade iterativ zu verfeinern, kann dazu führen, dass KI-Systeme weniger Fehler machen und bessere, fundiertere Entscheidungen treffen. Dies ist besonders wichtig in sensiblen Anwendungsbereichen wie Medizin, Finanzen oder autonomes Fahren.

- Plug-and-Play Integration mit neuen KI-Technologien: Die Architektur des CoAT Frameworks ist so konzipiert, dass sie flexibel und erweiterbar ist. Die Forscher sehen Potenzial für eine „Plug-and-Play“-Integration mit neuen KI-Technologien und Tools, wie z.B.:

- LLM-Agenten: CoAT könnte mit sogenannten LLM-Agenten kombiniert werden, die spezielle Aufgaben übernehmen können (z.B. Websuche, Datenanalyse). Dies würde das „External Brain“ von CoAT noch leistungsfähiger machen.

- Real-time Web Search: Die direkte Integration von Echtzeit-Websuche in das assoziative Gedächtnis würde CoAT ermöglichen, stets auf die aktuellsten Informationen zuzugreifen.

- Neue Forschungsrichtung für AI Reasoning: CoAT etabliert ein neues Paradigma für das LLM-Reasoning, indem es dynamische Wissensassoziation mit strukturierter Suche verbindet. Dies könnte eine neue Forschungsrichtung in der KI-Gemeinschaft anstoßen, die sich mit der Entwicklung von Systemen beschäftigt, die interne Berechnungen dynamisch mit gezieltem externen Wissensabruf verzahnen – ähnlich wie menschliche Experten, die bei komplexen Problemlösungen Referenzen konsultieren.

- Anwendungsfelder jenseits von Frage-Antwort und Code: Obwohl die bisherigen Experimente sich auf Frage-Antwort-Systeme und Code-Generierung konzentriert haben, sehen die Forscher breitere Anwendungsmöglichkeiten für CoAT, z.B. in den Bereichen:

- Komplexe Entscheidungsfindung: In Unternehmensführung, Politik oder Wissenschaft.

- Kreative Inhaltsgenerierung: Beim Schreiben von Artikeln, Drehbüchern oder Musik.

- Personalisierte Bildung: Indem KI-Systeme sich dynamisch an den Lernfortschritt und die Bedürfnisse des Einzelnen anpassen.

- Wissenschaftliche Forschung: Als Werkzeug zur Hypothesenbildung, Datenanalyse und Wissensentdeckung.

Zusammenfassend: Das CoAT Framework ist nicht nur ein Schritt nach vorn in der Verbesserung des LLM-Reasonings, sondern könnte einen Paradigmenwechsel in der KI-Entwicklung einleiten. Die Fähigkeit, Wissen dynamisch zu integrieren und assoziativ zu denken, hat das Potenzial, KI-Systeme intelligenter, zuverlässiger und vielseitiger zu machen und damit völlig neue Anwendungen und Möglichkeiten zu eröffnen.

Konkrete Tipps und Anleitungen

Obwohl das CoAT Framework selbst ein sehr technisches Konzept ist, gibt es einige grundlegende Tipps und Denkweisen, die Du aus dieser Forschung ableiten und in Deinem Umgang mit KI und Content-Marketing integrieren kannst:

- Denke über „schnelles Denken“ hinaus: So wie CoAT das „langsame Denken“ in den Vordergrund rückt, solltest auch Du bei der Content-Erstellung und KI-Nutzung über einfache, schnelle Lösungen hinausdenken. Investiere Zeit in Recherche, vertiefe Dein Wissen und versuche, Themen aus verschiedenen Perspektiven zu beleuchten. Tiefe schlägt Länge.

- Dynamische Wissensintegration ist der Schlüssel: Nutze KI nicht nur als statische Wissensquelle, sondern versuche, sie in einen dynamischen Prozess einzubinden. Halte Deine Informationen ständig auf dem neuesten Stand, integriere aktuelle Daten und erkenne Verbindungen zwischen verschiedenen Wissensbereichen. Tools für Webrecherche oder Wissensmanagement können hier hilfreich sein.

- Strukturiertes Vorgehen für komplexe Themen: Wenn Du komplexe Inhalte erstellst oder KI für anspruchsvolle Aufgaben einsetzt, plane Deinen Prozess strukturiert. Nutze Methoden wie Mindmapping oder systematische Fragestellungen (wie die W-Fragen), um Themen umfassend zu durchdringen. Der MCTS-Ansatz zeigt, wie eine strukturierte Suche nach Lösungen zu besseren Ergebnissen führen kann.

- Assoziatives Denken fördern: Versuche, beim Umgang mit KI und Content assoziativ zu denken. Suche nach Verbindungen zwischen scheinbar unabhängigen Themen, stelle unerwartete Fragen und lass Dich von KI-Tools zu neuen Ideen inspirieren. Nutze KI als Brainstorming-Partner und Ideengeber, nicht nur als Antwortmaschine.

- Qualität vor Quantität im Wissen: So wie CoAT irrelevantes Wissen filtert, solltest auch Du bei Deiner eigenen Wissensaufnahme und Content-Recherche auf Qualität achten. Verlasse Dich auf seriöse Quellen, prüfe Informationen kritisch und versuche, echtes Verständnis statt nur oberflächliches Wissen zu erlangen.

- Iterative Verbesserung: Betrachte Content-Erstellung und KI-Nutzung als iterativen Prozess. Erwarte nicht sofort perfekte Ergebnisse, sondern sei bereit, Deine Ansätze kontinuierlich zu verfeinern, Feedback einzuholen und aus Fehlern zu lernen. So wie MCTS Denkpfade iterativ verbessert, solltest auch Du Deine Arbeit ständig optimieren.

- E-A-T Prinzipien beachten: Gerade in einer KI-geprägten Welt wird das E-A-T-Prinzip (Expertise, Autorität, Vertrauenswürdigkeit) noch wichtiger. Sowohl bei der Erstellung von Content als auch bei der Bewertung von KI-basierten Informationen solltest Du auf diese Faktoren achten. CoAT zeigt, wie dynamische Wissensintegration und strukturierter Reasoning dazu beitragen können, E-A-T zu stärken.

Regelmäßige Aktualisierung

Dieser Artikel wird regelmäßig aktualisiert, um die neuesten Entwicklungen im Bereich des CoAT Frameworks und der KI-Forschung zu berücksichtigen und Dir stets relevante und aktuelle Informationen zu bieten.

Fazit: Das assoziative Denken der KI – CoAT Framework weist den Weg

Das Chain-of-Associated-Thoughts (CoAT) Framework markiert einen Paradigmenwechsel im Bereich der künstlichen Intelligenz. Es überwindet die Beschränkungen des „schnellen Denkens“ traditioneller LLMs und führt uns in eine Zukunft, in der KI-Systeme assoziativ, lernfähig und dynamisch denken können – ähnlich dem menschlichen Gehirn. Durch die Kombination eines optimierten Monte Carlo Tree Search (MCTS) Algorithmus mit einem innovativen assoziativen Gedächtnis ermöglicht CoAT eine Echtzeit-Wissensintegration und einen iterativen Reasoning-Prozess, der in Experimenten herkömmliche Methoden deutlich übertrifft.

Ob in wissensintensiven Frage-Antwort-Systemen, der Code-Generierung oder bei komplexen Anfragen – CoAT zeigt seine Stärken und weist den Weg zu intelligenteren, zuverlässigeren und vielseitigeren KI-Anwendungen. Die Forschung zum CoAT Framework ist noch jung, aber das Potenzial ist enorm. Es ist zu erwarten, dass dieser Ansatz die KI-Landschaft in den kommenden Jahren maßgeblich prägen und völlig neue Möglichkeiten in vielen Bereichen eröffnen wird.

Verstehe, wende KI an und wachse mit uns in einer Community, die dich dabei unterstützt – auf www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Pan, J., Deng, S., & Huang, S. (2025). CoAT: Chain-of-Associated-Thoughts Framework for Enhancing Large Language Models Reasoning. arXiv. Abgerufen von https://arxiv.org/pdf/2502.02390

- arXiv.org perpetual non-exclusive license. https://arxiv.org/licenses/nonexclusive-distrib/1.0/license.html

- OpenCompass Contributors (2023). OpenCompass: A Comprehensive Evaluation Platform for Foundation Models. https://github.com/open-compass/opencompass

- vLLM Kwon et al. (2023). vLLM: Easy, Fast, and Cheap LLM Serving with PagedAttention. https://vllm.ai/

- HotpotQA Github Project. https://github.com/hotpotqa/hotpot

- 2WikiMultiHopQA Github Project. https://github.com/Alab-NII/2wikimultihop

- LangChain Project. https://github.com/langchain-ai/langchain

- Chen et al. (2021). HumanEval Dataset. https://github.com/openai/human-eval

- Austin et al. (2021). MBPP Dataset. https://github.com/google-research/mbpp

- Zheng et al. (2023). HumanEval-X Dataset. https://github.com/bigcode-project/humanevalx

#AI #KI #ArtificialIntelligence #KuenstlicheIntelligenz #CoATFramework #LLMReasoning #AssociativeThinking #AIMemory