KI-Video-Revolution Dynamic Concepts Personalization: Das ist einfach faszinierend. Diese Forschung ermöglicht Dir aus einem einzigen Video dynamische Elemente extrahieren und sie in völlig neue Videowelten einzufügen – und das alles mit der Präzision und Kreativität von Künstlicher Intelligenz. Willkommen in der Zukunft der Videobearbeitung, in der „Dynamic Concepts Personalization“ aus einzelnen Videos Realität wird. Diese innovative Technologie, basierend auf neuesten Fortschritten im Bereich der Diffusion Transformers (DiTs), eröffnet ungeahnte Möglichkeiten für die Personalisierung, Bearbeitung und Komposition von Videoinhalten.

Wir stehen am Anfang einer neuen Ära, in der KI nicht nur statische Bilder, sondern auch die fließenden Bewegungen und dynamischen Nuancen der realen Welt in Videos erfassen und manipulieren kann. Dieser Artikel nimmt dich mit auf eine Entdeckungsreise durch diese revolutionäre Technologie, zeigt dir ihre Anwendungsbereiche und erklärt, wie auch du von den „Dynamic Concepts Personalization“ profitieren kannst.

Bei aller Begeisterung für die neue Forschung: FakeNews und DeepFakes werden jetzt noch leichter und entsprechend zunehmen!

Das musst Du wissen – KI-Video-Revolution: Dynamic Concepts Personalization aus Einzelvideos personalisieren!

- Dynamic Concepts Personalization: KI-Modelle lernen, Bewegungsmuster wie fließende Wellen oder flackerndes Feuer zu verstehen und zu personalisieren – nicht nur das Aussehen.

- Set-and-Sequence Framework: Ein neuartiger Ansatz, der räumliche und zeitliche Informationen in einem einzigen Gewichtsraum vereint und so dynamische Konzepte präzise abbildet.

- Zwei-Phasen-Training: Zuerst wird eine Identitätsbasis aus einzelnen Frames gelernt, dann werden Bewegungsresiduen auf der gesamten Videosequenz trainiert, um Dynamik zu erfassen.

- Überlegene Editierbarkeit: Ermöglicht nahtlose Komposition, intuitive Text-basierte Bearbeitung und beispiellose Kontrolle über dynamische Elemente in Videos.

- Benchmark für Personalisierung: Setzt neue Maßstäbe in der Videopersonalisierung und überwindet Limitierungen bisheriger Methoden durch einen einheitlichen Ansatz.

Hauptfrage: Wie revolutioniert die Personalisierung dynamischer Konzepte aus einzelnen Videos die Erstellung und Bearbeitung von Videoinhalten im Jahr 2025, und welche konkreten Vorteile ergeben sich daraus für Kreative und Unternehmen?

Folgefragen (FAQs)

- Was genau sind „dynamische Konzepte“ in Videos und warum ist ihre Personalisierung so herausfordernd?

- Wie funktioniert das „Set-and-Sequence“ Framework im Detail und welche Vorteile bietet es gegenüber herkömmlichen Methoden?

- Welche konkreten Anwendungsfälle und Bearbeitungsmöglichkeiten eröffnet die Personalisierung dynamischer Konzepte?

- Inwiefern übertrifft dieser Ansatz existierende Methoden zur Videopersonalisierung und -bearbeitung in Bezug auf Qualität, Flexibilität und Benutzerfreundlichkeit?

- Welche Rolle spielen Diffusion Transformer (DiTs) in dieser Technologie und warum sind sie so effektiv?

- Was bedeutet die „räumlich-zeitliche Gewichtung“ und wie trägt sie zur präzisen Erfassung dynamischer Konzepte bei?

- Welche Herausforderungen und Limitationen gibt es bei der Personalisierung dynamischer Konzepte und wie könnten zukünftige Entwicklungen aussehen?

- Wie kann ich diese Technologie nutzen, um meine eigenen Videos zu personalisieren und dynamische Konzepte einzubinden?

Antworten auf jede Frage

Was genau sind „Dynamic Concepts Personalization“ in Videos und warum ist ihre Personalisierung so herausfordernd?

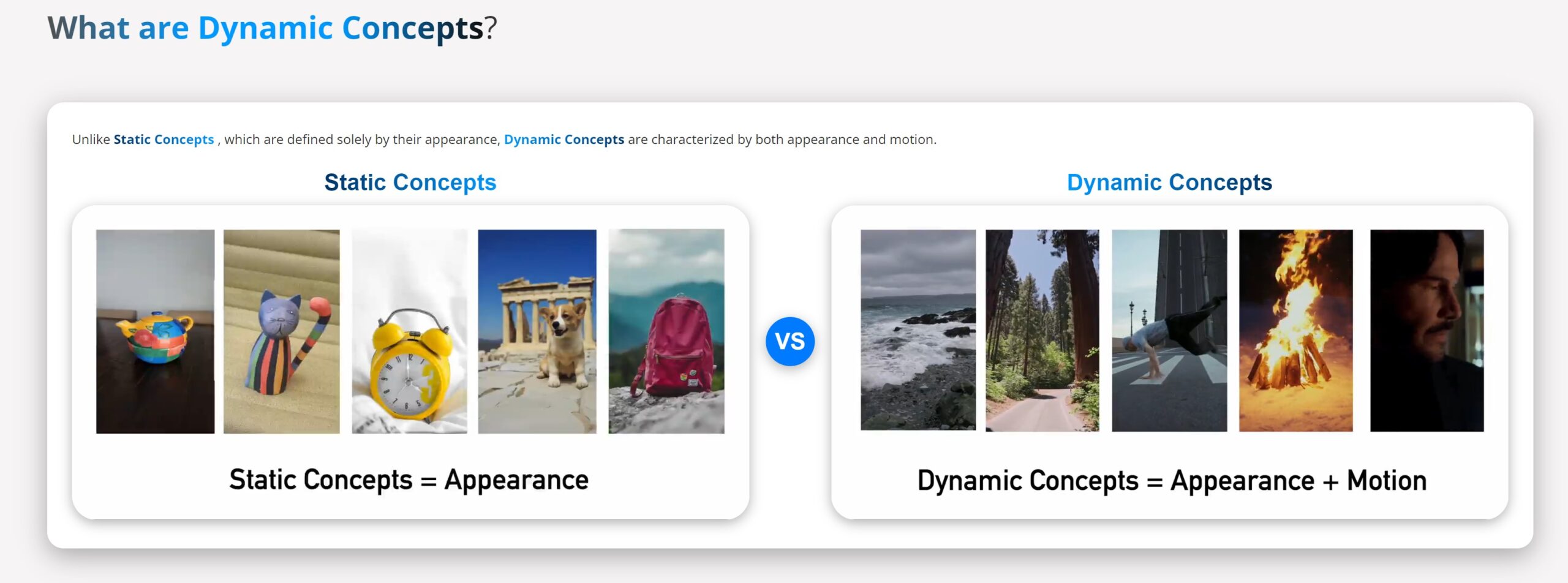

Dynamische Konzepte in Videos sind Entitäten, die nicht nur durch ihr Aussehen, sondern vor allem durch ihre einzigartigen Bewegungsmuster definiert sind. Denk an das fließende, unvorhersehbare Spiel von Meereswellen, das lebendige Flackern eines Lagerfeuers oder die subtilen, aber charakteristischen Bewegungen eines Tänzers. Im Gegensatz zu statischen Konzepten, die in Bildern relativ einfach zu personalisieren sind, bringen dynamische Konzepte eine zusätzliche zeitliche Dimension ins Spiel. Es geht nicht nur darum, wie etwas aussieht, sondern auch wie es sich bewegt und wie sich diese Bewegung im Laufe der Zeit verändert.

Die Herausforderung liegt darin, dass herkömmliche Text-zu-Video-Modelle oft auf generische Bewegungstrajektorien setzen und Schwierigkeiten haben, nuancierte, objektspezifische Dynamiken präzise zu erfassen und wiederzugeben. Sie können zwar einen Menschen darstellen, der geht, aber nicht unbedingt die individuelle Art zu gehen, die eine bestimmte Person auszeichnet. Ebenso können sie ein Feuer erzeugen, aber möglicherweise nicht das einzigartige Flackern eines bestimmten Lagerfeuers einfangen. Die gleichzeitige Erfassung und kohärente Darstellung von Aussehen und Bewegung in personalisierten Videokonzepten ist daher eine komplexe Aufgabe, die bisherige Methoden an ihre Grenzen brachte.

Wie funktioniert das „Set-and-Sequence“ Framework im Detail und welche Vorteile bietet es gegenüber herkömmlichen Methoden?

Das „Set-and-Sequence“ Framework ist ein neuartiger, zweistufiger Ansatz, der speziell entwickelt wurde, um die Herausforderungen der dynamischen Konzeptpersonalisierung zu meistern. Es basiert auf der Idee, Aussehen und Bewegung in einem gemeinsamen, räumlich-zeitlichen Gewichtsraum zu kodieren, anstatt sie getrennt zu behandeln. Dieser Ansatz nutzt die Stärken von Diffusion Transformers (DiTs), die räumliche und zeitliche Token gleichzeitig verarbeiten, aber überwindet deren Mangel an impliziter Trennung von Raum und Zeit.

Die zwei Phasen des Frameworks sind:

- Identity Basis Learning (Set Encoding): In dieser ersten Phase wird ein unordered Set von Frames aus dem Eingabevideo verwendet. Der Fokus liegt ausschließlich auf dem Erlernen des Aussehens des dynamischen Konzepts, ohne zeitliche Ablenkungen. Dies geschieht durch Fine-Tuning von Low-Rank Adaptation (LoRA) Layern. Das Ergebnis ist eine Identitäts-LoRA-Basis, die das Erscheinungsbild des Konzepts repräsentiert – zeitlich unveränderlich und frei von Bewegungsartefakten. Stell dir vor, du extrahierst ein „statisches Abbild“ der Identität aus dem Video, bevor die Bewegung ins Spiel kommt.

- Motion Residual Encoding (Sequence Encoding): In der zweiten Phase wird die Identitäts-LoRA-Basis „eingefroren“. Nun wird die gesamte Videosequenz genutzt, um die Bewegungsdynamik zu erfassen. Dies geschieht durch ein weiteres Fine-Tuning, bei dem die Koeffizienten der Identitäts-LoRAs um sogenannte Motion Residuals erweitert werden. Diese Motion Residuals kodieren die zeitlichen Veränderungen und Bewegungen des Konzepts – also die Dynamik, die es ausmacht. Im Wesentlichen wird die Bewegung als eine „Verformung“ der statischen Identitätsbasis gelernt.

Vorteile des Set-and-Sequence Frameworks:

- Präzise Erfassung dynamischer Konzepte: Durch die Trennung von Identität und Bewegung im Trainingsprozess und die anschließende Zusammenführung in einem gemeinsamen Gewichtsraum, können sowohl Aussehen als auch Bewegungsmuster hochpräzise und kohärent erfasst werden.

- Überlegene Editierbarkeit und Komposition: Die räumlich-zeitliche Gewichtung ermöglicht eine intuitive und flexible Bearbeitung und Komposition. Dynamische Konzepte können nahtlos in neue Szenen eingefügt, verändert oder kombiniert werden, ohne ihre charakteristische Dynamik zu verlieren.

- Robustheit und Generalisierbarkeit: Das Framework ist robust gegenüber verschiedenen Kontexten und ermöglicht die Generalisierung dynamischer Konzepte über verschiedene Videos hinweg. Einmal gelernt, kann ein dynamisches Konzept (z.B. das Flackern eines bestimmten Feuers) in unterschiedlichen Videoszenarien angewendet werden.

- Effizienz: Die Verwendung von LoRA-Layern macht das Fine-Tuning effizient und ressourcenschonend.

Im Vergleich zu herkömmlichen Methoden, die oft auf einer getrennten Modellierung von Raum und Zeit basieren (z.B. UNet-basierte Architekturen), bietet das Set-and-Sequence Framework einen einheitlicheren und effektiveren Ansatz zur Personalisierung dynamischer Konzepte. Es überwindet die Limitierungen starrer, artefaktbehafteter Bewegungsmuster und ermöglicht eine natürlichere und kreativere Videobearbeitung.

Welche konkreten Anwendungsfälle und Bearbeitungsmöglichkeiten eröffnet die Personalisierung dynamischer Konzepte?

Die Personalisierung dynamischer Konzepte eröffnet ein breites Spektrum an faszinierenden Anwendungsfällen und Bearbeitungsmöglichkeiten, die weit über herkömmliche Videobearbeitung hinausgehen. Hier sind einige konkrete Beispiele:

- Nahtlose Szenenkomposition: Stell dir vor, du möchtest das fließende Meer aus einem Video mit dem knisternden Lagerfeuer aus einem anderen Video kombinieren. Mit Dynamic Concepts Personalization ist das kein Problem! Du kannst unterschiedliche dynamische Elemente aus verschiedenen Videos extrahieren und sie in einer einzigen, kohärenten Szene zusammenfügen. Das Ergebnis sind Videos, in denen sich die dynamischen Konzepte natürlich miteinander interagieren, als wären sie von Anfang an Teil derselben Szene gewesen. Die Technologie ermöglicht sogar die Farbkodierung verschiedener Konzepte, um ihre Integration visuell zu verdeutlichen.

- Intuitive Text-basierte Videobearbeitung: Die Bearbeitung von Videos wird so einfach wie das Bearbeiten von Text. Du kannst Textprompts verwenden, um dynamische Konzepte zu verändern, zu kombinieren oder in neue Kontexte zu setzen. Möchtest du das Lagerfeuer in einen Kamin verlegen? Oder die Meereswellen in einen ruhigen See verwandeln? Gib einfach den gewünschten Textprompt ein, und die KI passt das Video entsprechend an. Das Framework unterstützt sowohl globale Edits (z.B. Hintergrundänderungen, Lichtanpassungen) als auch lokale Edits (z.B. Kleidung ändern, Objekte ersetzen).

- Kreative Stilübertragung und -anpassung: Du kannst den Stil eines dynamischen Konzepts verändern, ohne seine grundlegende Dynamik zu beeinträchtigen. Möchtest du das Lagerfeuer im Stil eines impressionistischen Gemäldes darstellen? Oder die Meereswellen in einen futuristischen Look verwandeln? Durch gezielte Anpassung der Gewichte der LoRA-Layer oder durch modifizierte Textprompts kannst du vielfältige Stilvariationen erzeugen. Sogar Pixar-ähnliche Stilisierungen sind möglich, um Videos einen ganz besonderen Look zu verleihen.

- Feinabstimmung von Bewegung und Ausdruck: Gerade bei der Bearbeitung von Videos mit menschlichen Protagonisten ist die präzise Kontrolle über Bewegung und Ausdruck entscheidend. Mit Dynamic Concepts Personalization kannst du Kamerabewegungen intuitiv bearbeiten, Ausdrücke verfeinern oder lokalisierte Bewegungsänderungen vornehmen – alles gesteuert durch Textprompts. Möchtest du, dass die Person im Video langsamer tanzt? Oder dass sie fröhlicher aussieht? Passe einfach den Textprompt an, und die KI setzt deine Wünsche um.

- Erstellung personalisierter Videoinhalte: Für Unternehmen und Content-Creator eröffnet sich die Möglichkeit, hochgradig personalisierte Videoinhalte zu erstellen, die auf die individuellen Bedürfnisse und Vorlieben der Zielgruppe zugeschnitten sind. Denk an personalisierte Produktvideos, individuelle Trainingsvideos oder maßgeschneiderte Marketingkampagnen. Die Technologie ermöglicht es, dynamische Elemente flexibel anzupassen und in unterschiedliche Kontexte zu integrieren, um so einzigartige und ansprechende Videoerlebnisse zu schaffen.

Inwiefern übertrifft dieser Ansatz existierende Methoden zur Videopersonalisierung und -bearbeitung in Bezug auf Qualität, Flexibilität und Benutzerfreundlichkeit?

Dynamic Concepts Personalization setzt in vielerlei Hinsicht neue Maßstäbe und übertrifft existierende Methoden zur Videopersonalisierung und -bearbeitung deutlich:

- Qualität und Kohärenz: Durch das Set-and-Sequence Framework und die räumlich-zeitliche Gewichtung werden dynamische Konzepte mit höherer Qualität und Kohärenz erfasst und wiedergegeben als mit herkömmlichen Methoden. Die Videos wirken natürlicher, flüssiger und weniger artefaktbehaftet. Gerade bei komplexen dynamischen Elementen und Szenenkompositionen zeigt sich die Überlegenheit des neuen Ansatzes.

- Flexibilität und Editierbarkeit: Die Text-basierte Steuerung und die modulare Struktur des Frameworks ermöglichen eine beispiellose Flexibilität und Editierbarkeit. Dynamische Konzepte können intuitiv und vielseitig bearbeitet, kombiniert und angepasst werden. Im Vergleich zu Methoden, die auf rigiden Parametern oder komplexen manuellen Eingriffen basieren, bietet Dynamic Concepts Personalization einen deutlich benutzerfreundlicheren und kreativeren Workflow.

- Umfassende Personalisierung: Während viele bestehende Methoden sich auf statische Aspekte oder einfache Bewegungsübertragungen beschränken, ermöglicht Dynamic Concepts Personalization eine umfassende Personalisierung dynamischer Konzepte in ihrer Gesamtheit – inklusive Aussehen, Bewegungsmuster und Interaktionen. Dieser ganzheitliche Ansatz eröffnet völlig neue Dimensionen der Videopersonalisierung.

- Benutzerfreundlichkeit: Die Text-basierte Steuerung macht die Technologie auch für Nutzer zugänglich, die keine Experten in Videobearbeitung oder KI sind. Komplexe Bearbeitungsschritte werden auf einfache Textprompts reduziert, was den Einstieg und die Anwendung deutlich erleichtert. Die intuitive Bedienbarkeit und die vielfältigen Bearbeitungsmöglichkeiten machen Dynamic Concepts Personalization zu einem kraftvollen Werkzeug für Kreative und Unternehmen.

- Benchmark in der Forschung: Die quantitativen und qualitativen Evaluationen im wissenschaftlichen Artikel zeigen, dass Dynamic Concepts Personalization existierende State-of-the-Art-Methoden in Bezug auf verschiedene Metriken übertrifft – darunter Identitätserhaltung, Texttreue, zeitliche Kohärenz und visuelle Qualität. Das Framework setzt damit einen neuen Benchmark für die Forschung im Bereich der Videopersonalisierung.

Welche Rolle spielen Diffusion Transformer (DiTs) in dieser Technologie und warum sind sie so effektiv?

Diffusion Transformer (DiTs) bilden das Herzstück der Dynamic Concepts Personalization Technologie. DiTs sind eine spezielle Art von neuronalen Netzen, die auf der Transformer-Architektur basieren – dem gleichen Prinzip, das auch in Large Language Models wie GPT-3 zum Einsatz kommt. Im Kontext der Videogenerierung und -bearbeitung bieten DiTs entscheidende Vorteile:

- Gleichzeitige Verarbeitung von Raum und Zeit: Im Gegensatz zu UNet-basierten Architekturen, die Raum und Zeit oft getrennt modellieren, können DiTs räumliche und zeitliche Token gleichzeitig verarbeiten. Dies ermöglicht eine einheitlichere und kohärentere Modellierung von Videodaten, da räumliche und zeitliche Informationen von Anfang an integriert werden. Diese Fähigkeit ist entscheidend für die präzise Erfassung und Wiedergabe dynamischer Konzepte, bei denen Aussehen und Bewegung untrennbar miteinander verbunden sind.

- Skalierbarkeit und Qualität: DiTs haben in jüngster Zeit beeindruckende Fortschritte in der Qualität der Videogenerierung gezeigt und sind in der Lage, hochauflösende und detailreiche Videos zu erzeugen. Ihre Skalierbarkeit ermöglicht das Training auf großen Datensätzen und die Modellierung komplexer Szenen und Dynamiken. Die hohe Qualität der DiT-basierten Videogenerierung ist eine wesentliche Grundlage für die Realisierung anspruchsvoller Personalisierungs- und Bearbeitungsaufgaben.

- Flexibilität und Anpassbarkeit: Die Transformer-Architektur, auf der DiTs basieren, zeichnet sich durch ihre Flexibilität und Anpassbarkeit aus. DiTs können relativ einfach an verschiedene Aufgaben und Daten angepasst werden. Im Fall von Dynamic Concepts Personalization werden DiTs durch das Set-and-Sequence Framework und das Fine-Tuning mit LoRA-Layern speziell auf die Personalisierung dynamischer Konzepte zugeschnitten. Diese Anpassbarkeit ist entscheidend, um die spezifischen Herausforderungen dieser Aufgabe zu bewältigen.

- Implizite räumlich-zeitliche Gewichtung: Obwohl DiTs keine explizite Trennung von Raum und Zeit aufweisen, ermöglichen sie durch ihre Architektur eine implizite räumlich-zeitliche Gewichtung. Die Aufmerksamkeitsmechanismen in den Transformer-Layern erlauben dem Modell, relevante räumliche und zeitliche Beziehungen im Video zu erkennen und zu gewichten. Diese implizite Gewichtung trägt dazu bei, dynamische Konzepte kohärent und realistisch darzustellen.

Zusammenfassend lässt sich sagen, dass DiTs aufgrund ihrer Fähigkeit zur gleichzeitigen Raum-Zeit-Verarbeitung, ihrer Skalierbarkeit, Flexibilität und impliziten räumlich-zeitlichen Gewichtung eine ideale Grundlage für die Dynamic Concepts Personalization Technologie bilden. Sie ermöglichen die Erfassung, Personalisierung und Bearbeitung dynamischer Konzepte in einer Qualität und Flexibilität, die mit herkömmlichen Architekturen kaum zu erreichen wäre.

Was bedeutet die „räumlich-zeitliche Gewichtung“ und wie trägt sie zur präzisen Erfassung dynamischer Konzepte bei?

Die „räumlich-zeitliche Gewichtung“ ist ein zentrales Konzept des Set-and-Sequence Frameworks und ein Schlüsselfaktor für die präzise Erfassung dynamischer Konzepte. Sie bezieht sich auf die Art und Weise, wie das Framework räumliche und zeitliche Informationen im Video kodiert und verarbeitet. Anstatt Raum und Zeit getrennt zu behandeln, wie es viele traditionelle Video-Modelle tun, integriert das Set-and-Sequence Framework beide Dimensionen in einem gemeinsamen Gewichtsraum.

Konkret bedeutet räumlich-zeitliche Gewichtung:

- Gemeinsamer Gewichtsraum: Das Framework verwendet einen einzigen Satz von Gewichten (insbesondere die LoRA-Layer), um sowohl das Aussehen (räumliche Information) als auch die Bewegung (zeitliche Information) des dynamischen Konzepts zu repräsentieren. Dies steht im Gegensatz zu Ansätzen, die separate Gewichte oder Module für räumliche und zeitliche Aspekte verwenden.

- Implizite Gewichtung durch DiTs: Die Diffusion Transformer (DiTs) Architektur trägt maßgeblich zur räumlich-zeitlichen Gewichtung bei. Durch ihre Fähigkeit, räumliche und zeitliche Token gleichzeitig zu verarbeiten und durch ihre Aufmerksamkeitsmechanismen, können DiTs implizit relevante räumliche und zeitliche Beziehungen im Video erkennen und gewichten. Das Modell lernt, welche räumlichen Aspekte zu welchen Zeitpunkten relevant sind, um die Dynamik des Konzepts zu erfassen.

- Fokussierung auf Bewegung als Deformation: Das Set-and-Sequence Framework betrachtet Bewegung als eine „Verformung“ der statischen Identitätsbasis. Die Motion Residuals, die in der zweiten Trainingsphase gelernt werden, kodieren die zeitlichen Veränderungen und Abweichungen vom statischen Erscheinungsbild. Diese Sichtweise impliziert eine Gewichtung der zeitlichen Information in Bezug auf die räumliche Identität. Die Bewegung wird nicht als etwas völlig Separates betrachtet, sondern als eine Modifikation des Aussehens im Laufe der Zeit.

Wie trägt die räumlich-zeitliche Gewichtung zur präzisen Erfassung dynamischer Konzepte bei?

- Kohärenz und Realismus: Durch die gemeinsame Kodierung von Raum und Zeit in einem Gewichtsraum und die implizite Gewichtung durch DiTs, werden dynamische Konzepte kohärenter und realistischer dargestellt. Die Bewegung wirkt natürlicher und integrierter in das Erscheinungsbild des Konzepts, anstatt als separate Ebene „aufgesetzt“ zu wirken.

- Präzise Bewegungsmuster: Die räumlich-zeitliche Gewichtung ermöglicht es dem Modell, feinere und nuanciertere Bewegungsmuster zu erfassen. Es kann subtile zeitliche Veränderungen und räumliche Variationen lernen, die für die Charakterisierung dynamischer Konzepte entscheidend sind (z.B. das spezifische Flackern eines bestimmten Feuers oder die individuelle Gangart einer Person).

- Robustheit gegenüber Variationen: Die räumlich-zeitliche Gewichtung macht das Modell robuster gegenüber Variationen im Aussehen oder im Kontext. Da Aussehen und Bewegung in einem gemeinsamen Raum gelernt werden, kann das Modell dynamische Konzepte auch dann erkennen und personalisieren, wenn sich das Erscheinungsbild leicht verändert oder der Hintergrund variiert.

- Effektive Komposition und Bearbeitung: Die räumlich-zeitliche Gewichtung ist eine Schlüsselvoraussetzung für die effektive Komposition und Bearbeitung dynamischer Konzepte. Da die räumlichen und zeitlichen Aspekte integriert sind, können dynamische Konzepte nahtlos in neue Szenen eingefügt, verändert oder kombiniert werden, ohne ihre Kohärenz oder ihren Realismus zu verlieren.

Welche Herausforderungen und Limitationen gibt es bei der Personalisierung dynamischer Konzepte und wie könnten zukünftige Entwicklungen aussehen?

Trotz der beeindruckenden Fortschritte von Dynamic Concepts Personalization gibt es auch Herausforderungen und Limitationen, die in zukünftigen Entwicklungen adressiert werden könnten:

- Rechenaufwand und Trainingszeit: Das Training von DiT-basierten Modellen mit LoRA-Optimierung und zusätzlicher Regularisierung kann rechenintensiv und zeitaufwendig sein. Obwohl LoRA das Fine-Tuning effizienter macht als das Training des gesamten Modells, sind für komplexe dynamische Konzepte und hochwertige Ergebnisse immer noch erhebliche Rechenressourcen und Trainingszeiten erforderlich. Zukünftige Forschung könnte sich auf die Entwicklung effizienterer Trainingsmethoden und Architekturen konzentrieren, um den Rechenaufwand zu reduzieren und die Trainingszeiten zu verkürzen. Ein encoderbasierter Ansatz könnte hier eine vielversprechende Richtung sein.

- Hochfrequente und komplexe Bewegungen: Während das Framework die meisten Bewegungen mit hoher Genauigkeit erfasst, kann es bei hochfrequenten oder extrem komplexen Bewegungsmustern (z.B.erratische, schnelle Bewegungen) an seine Grenzen stoßen. In solchen Fällen kann die zeitliche Kohärenz und die Detailtreue der Bewegungswiedergabe möglicherweise noch verbessert werden. Zukünftige Modelle könnten fortschrittlichere Bewegungsmodellierungs-Techniken integrieren, um auch diese anspruchsvollen Dynamiken präziser zu erfassen und wiederzugeben.

- Generalisierung auf neue dynamische Konzepte: Obwohl das Framework eine gute Generalisierung innerhalb ähnlicher dynamischer Konzepte (z.B. verschiedene Arten von Feuer oder Wasser) zeigt, könnte die Generalisierung auf völlig neue, unbekannte dynamische Konzepte eine Herausforderung darstellen. Das Modell lernt aus den Trainingsdaten und ist möglicherweise weniger gut darin, Dynamiken zu personalisieren, die stark von den im Training gesehenen Mustern abweichen. Zukünftige Forschung könnte sich auf die Verbesserung der Generalisierungsfähigkeit von Modellen konzentrieren, um auch ein breiteres Spektrum neuer dynamischer Konzepte personalisieren zu können.

- Interaktion mit multiplen dynamischen Konzepten: Die Komposition von Videos mit mehreren interagierenden dynamischen Konzepten (z.B. ein Mensch, der sich vor einem Lagerfeuer bewegt, während im Hintergrund das Meer rauscht) ist eine komplexe Aufgabe, die noch weitere Forschungsarbeit erfordert. Obwohl das Framework bereits beeindruckende Ergebnisse in der Szenenkomposition zeigt, könnten zukünftige Modelle noch besser darin werden, die subtilen Interaktionen und Abhängigkeiten zwischen verschiedenen dynamischen Konzepten zu modellieren und zu erzeugen. Die Berücksichtigung semantischer Beziehungen und physikalischer Gesetze könnte hier eine wichtige Rolle spielen.

- Benutzerkontrolle und Interpretierbarkeit: Obwohl die Text-basierte Steuerung sehr intuitiv ist, könnte die genaue Kontrolle über spezifische Aspekte dynamischer Konzepte (z.B. die Frequenz des Flackerns eines Feuers oder die Amplitude der Wellenbewegung) noch verbessert werden. Auch die Interpretierbarkeit der gelernten Gewichte und Motion Residuals ist ein wichtiger Aspekt für zukünftige Forschung. Das Verständnis, wie das Modell dynamische Konzepte intern repräsentiert und manipuliert, könnte zu noch gezielteren und kreativeren Bearbeitungsmöglichkeiten führen.

Wie kann ich diese Technologie nutzen, um meine eigenen Videos zu personalisieren und dynamische Konzepte einzubinden?

Aktuell ist Dynamic Concepts Personalization noch vorrangig eine Forschungstechnologie. Es gibt noch keine öffentlich zugängliche Software oder Online-Plattform, die diese Technologie direkt anbietet. Allerdings deuten die beeindruckenden Ergebnisse und die rasante Entwicklung im Bereich der KI-Videogenerierung darauf hin, dass solche Technologien in Zukunft breitere Anwendung finden werden.

Für Kreative und Unternehmen, die sich für Dynamic Concepts Personalization interessieren, gibt es dennoch einige Möglichkeiten, sich jetzt schon vorzubereiten und die Entwicklungen zu verfolgen:

- Bleibe informiert: Verfolge die Veröffentlichungen und Fortschritte im Bereich der KI-Videogenerierung und -personalisierung. Abonniere relevante Blogs, Newsletter und Forschungspublikationen, um auf dem Laufenden zu bleiben. Die KINEWS24-Academy ist hierfür eine exzellente Ressource, um KI-Entwicklungen direkt, verständlich und anwendbar zu verfolgen.

- Experimentiere mit existierenden KI-Video-Tools: Auch wenn Dynamic Concepts Personalization noch nicht direkt verfügbar ist, gibt es bereits andere KI-gestützte Videobearbeitungstools und -plattformen, die einige ähnliche Funktionen bieten (z.B. Stilübertragung, Objekterkennung, einfache Bewegungsbearbeitung). Durch das Experimentieren mit diesen Tools kannst du dich mit den Grundlagen der KI-Videobearbeitung vertraut machen und ein Gefühl für die Möglichkeiten und Grenzen der aktuellen Technologie entwickeln.

- Sammle und kuratiere Video-Daten: Wenn du spezifische dynamische Konzepte personalisieren möchtest (z.B. das Firmenlogo in dynamischer Form darstellen oder personalisierte Produktvideos mit individuellen Bewegungsmustern erstellen), beginne jetzt schon mit dem Sammeln und Kuratieren relevanter Video-Daten. Je mehr hochwertige und vielfältige Videodaten du zur Verfügung hast, desto besser kannst du zukünftige Personalisierungstechnologien nutzen.

- Bild dich weiter im Bereich KI: Ein grundlegendes Verständnis der Prinzipien von Künstlicher Intelligenz und Deep Learning kann dir helfen, die Potenziale und Herausforderungen von Technologien wie Dynamic Concepts Personalization besser einzuschätzen und zukünftige Anwendungen kreativer zu gestalten. Die KINEWS24-Academy bietet hierfür verständliche und praxisorientierte Weiterbildungsmöglichkeiten.

- Denke über kreative Anwendungsfälle nach: Überlege dir, wie du Dynamic Concepts Personalization in deinen eigenen kreativen Projekten oder in deinem Unternehmen einsetzen könntest. Welche dynamischen Konzepte sind für dich relevant? Welche Bearbeitungsmöglichkeiten würden dir neue kreative Freiräume eröffnen oder deine Arbeitsabläufe effizienter gestalten? Je früher du anfängst, über diese Fragen nachzudenken, desto besser bist du vorbereitet, wenn die Technologie breiter verfügbar wird.

Es ist zwar noch ein Weg, bis Dynamic Concepts Personalization für jeden zugänglich ist, aber die Richtung ist klar vorgezeichnet. Die Technologie hat das Potenzial, die Videobearbeitung grundlegend zu verändern und uns neue kreative Werkzeuge und Ausdrucksformen zu geben. Indem du dich jetzt schon informierst und vorbereitest, kannst du zu den Ersten gehören, die diese revolutionäre Technologie voll ausschöpfen.

Konkrete Tipps und Anleitungen

Tipps zur effektiven Nutzung von Dynamic Concepts Personalization (zukünftig):

Auch wenn die Technologie noch nicht direkt verfügbar ist, können wir uns schon jetzt auf die zukünftige Nutzung vorbereiten. Hier sind einige Tipps, die dir helfen werden, Dynamic Concepts Personalization optimal einzusetzen, sobald sie zugänglich ist:

- Definiere deine dynamischen Konzepte klar: Bevor du mit der Personalisierung beginnst, überlege genau, welche dynamischen Konzepte du erfassen und bearbeiten möchtest. Je klarer deine Vorstellung ist, desto gezielter kannst du die Technologie einsetzen. Beschreibe die Konzepte so detailliert wie möglich – nicht nur das Aussehen, sondern vor allem die spezifischen Bewegungsmuster und Dynamiken.

- Nutze detaillierte Textprompts: Die Text-basierte Steuerung ist ein zentrales Element von Dynamic Concepts Personalization. Investiere Zeit in die Formulierung präziser und detaillierter Textprompts, um die gewünschten Bearbeitungsergebnisse zu erzielen. Beschreibe nicht nur das gewünschte Aussehen und die Bewegung, sondern auch den Kontext, den Stil und die Interaktionen mit anderen Elementen in der Szene. Experimentiere mit verschiedenen Formulierungen und Prompts, um die optimale Steuerung zu finden.

- Experimentiere mit Kompositionen: Die Möglichkeit, dynamische Konzepte nahtlos zu komponieren, ist eine der größten Stärken der Technologie. Sei kreativ und experimentiere mit der Kombination verschiedener dynamischer Elemente aus unterschiedlichen Videos. Probiere ungewöhnliche und überraschende Kombinationen aus, um einzigartige und faszinierende Videoerlebnisse zu schaffen. Nutze die Farbkodierung, um die Integration verschiedener Konzepte visuell zu verdeutlichen und die Kohärenz der Komposition zu verbessern.

- Verfeinere den Stil durch Gewichtsanpassung: Nutze die Möglichkeit, den Stil dynamischer Konzepte durch Anpassung der LoRA-Gewichte zu verändern. Experimentiere mit verschiedenen Gewichtungen, um unterschiedliche Stilrichtungen und Looks zu erzeugen. Spiele mit subtilen Veränderungen, um den gewünschten Effekt zu erzielen. Die Stilübertragung und -anpassung eröffnet dir vielfältige kreative Möglichkeiten, um deinen Videos einen individuellen Touch zu verleihen.

- Achte auf Kohärenz und Realismus: Auch wenn Dynamic Concepts Personalization beeindruckende Ergebnisse liefert, ist es wichtig, die Kohärenz und den Realismus der bearbeiteten Videos kritisch zu prüfen. Achte darauf, dass die dynamischen Konzepte natürlich in die Szene integriert sind und sich realistisch bewegen und interagieren. Überprüfe, ob die Bearbeitungen subtil und glaubwürdig wirken oder ob sie unnatürlich oder artefaktbehaftet erscheinen. Feinabstimmung und iterative Bearbeitung können helfen, optimale Ergebnisse zu erzielen.

- Nutze die Technologie iterativ: Dynamic Concepts Personalization ist ein iteratives Werkzeug. Erwarte nicht, beim ersten Versuch perfekte Ergebnisse zu erzielen. Nutze die Technologie als kreativen Partner und experimentiere iterativ, um deine Visionen umzusetzen. Beginne mit einfachen Bearbeitungen und steigere dich allmählich zu komplexeren Aufgaben. Nutze das Feedback der KI, um deine Prompts und Bearbeitungsstrategien zu optimieren und deine kreativen Fähigkeiten zu erweitern.

- Gib Feedback an die Entwickler-Community: Sobald Dynamic Concepts Personalization oder ähnliche Technologien breiter verfügbar werden, teile deine Erfahrungen, dein Feedback und deine kreativen Projekte mit der Entwickler-Community. Dein Feedback kann dazu beitragen, die Technologie weiter zu verbessern und ihre Anwendungsmöglichkeiten zu erweitern. Durch den Austausch und die Zusammenarbeit mit anderen Nutzern und Entwicklern kannst du die Zukunft der KI-Videobearbeitung aktiv mitgestalten.

Regelmäßige Aktualisierung

Dieser Artikel wird fortlaufend aktualisiert, um die neuesten Entwicklungen im Bereich Dynamic Concepts Personalization und KI-Videobearbeitung zu berücksichtigen. Schau regelmäßig vorbei, um auf dem neuesten Stand zu bleiben!

Fazit: Dynamische Konzeptpersonalisierung – Der nächste Evolutionsschritt für KI-Videos

Die Personalisierung dynamischer Konzepte aus einzelnen Videos markiert einen bedeutenden Wendepunkt in der Welt der KI-Videogenerierung und -bearbeitung. Das vorgestellte Set-and-Sequence Framework, basierend auf Diffusion Transformers, ermöglicht es erstmals, nicht nur das Aussehen, sondern auch die charakteristischen Bewegungsmuster dynamischer Elemente präzise zu erfassen, zu personalisieren und in neue Kontexte zu übertragen. Diese Technologie überwindet die Limitierungen bisheriger Ansätze und eröffnet ungeahnte kreative Möglichkeiten für die Videobearbeitung, Szenenkomposition und personalisierte Inhaltserstellung.

Von nahtlosen Szenenkompositionen und intuitiver Text-basierter Bearbeitung bis hin zu kreativer Stilübertragung und feinster Bewegungsanpassung – Dynamic Concepts Personalization definiert die Grenzen des Machbaren in der KI-Videobearbeitung neu. Die Möglichkeit, dynamische Konzepte aus Einzelvideos zu extrahieren und in vielfältiger Weise zu manipulieren, eröffnet Kreativen und Unternehmen völlig neue Perspektiven, um ihre Visionen auszudrücken, ihre Botschaften zu vermitteln und ihre Zielgruppen zu begeistern.

Auch wenn die Technologie noch in den Kinderschuhen steckt und noch einige Herausforderungen zu bewältigen sind, ist das Potenzial enorm. Dynamic Concepts Personalization ist mehr als nur eine technische Innovation – es ist ein kreativer Game-Changer, der die Art und Weise, wie wir Videos erstellen, bearbeiten und erleben, grundlegend verändern wird. Wir stehen am Beginn einer neuen Ära der KI-gestützten Videokunst, in der die Grenzen zwischen Realität und Imagination verschwimmen und in der jeder von uns zum Regisseur seiner eigenen dynamischen Videowelten werden kann.

Es ist eine aufregende Zeit, und die KINEWS24-Academy hält dich auf dem Laufenden, damit du diese Revolution nicht verpasst und KI für dich nutzen kannst. Hier kannst Du Dich in einer aktiven Community austauschen und KI lernen: www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Rameen Abdal, Or Patashnik, Ivan Skorokhodov, Willi Menapace, Daniel Cohen-Or, Kfir Aberman, Aliaksandr Siarohin, Sergey Tulyakov. Dynamic Concepts Personalization from Single Videos. SNAP RESEARCH. https://snap-research.github.io/dynamic_concepts

- arXiv:2502.14844v1 [cs.GR] 20 Feb 2025. https://arxiv.org/abs/2502.14844v1

#AI #KI #ArtificialIntelligence #KuenstlicheIntelligenz #VideoPersonalisierung #KIVideoRevolution #DynamicConcepts #Videobearbeitung