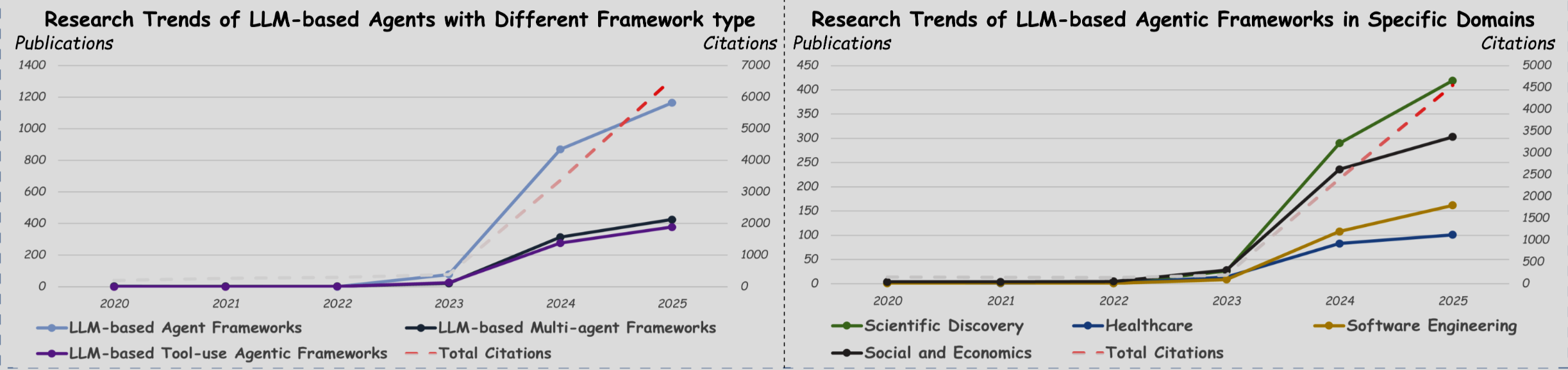

Agentic AI 2025: Guide zu LLM-Agenten & Reasoning Frameworks: Die Welt der Künstlichen Intelligenz erlebt gerade eine seismische Verschiebung. Während große Sprachmodelle (LLMs) wie GPT-4 bereits unseren Alltag durchdringen, entsteht im Hintergrund eine weitaus mächtigere Technologie: Agentic AI. Diese LLM-basierten Agentensysteme sind mehr als nur Chatbots; sie sind autonome Akteure, die komplexe, mehrstufige Aufgaben lösen und dabei eine fast menschliche Leistungsfähigkeit erreichen. Das Forschungsfeld explodiert förmlich, was den Überblick erschwert. Ein bahnbrechender Survey von Bingxi Zhao und einem internationalen Forscherteam, veröffentlicht im August 2025, bringt nun erstmals eine systematische Ordnung in dieses dynamische Feld und liefert eine unverzichtbare Landkarte für die Zukunft der KI.

Dieser Artikel beleuchtet die Erkenntnisse dieser Studie und erklärt dir alles, was Du über die faszinierende Welt der LLM-Agenten und ihrer Reasoning Frameworks wissen musst. Wir entschlüsseln, wie diese Systeme aufgebaut sind, welche Methoden sie nutzen und in welchen Bereichen sie schon heute eine Revolution auslösen – von der Wissenschaft über die Medizin bis hin zur Softwareentwicklung. Du erfährst, wie diese neue Generation von KI nicht nur Anweisungen befolgt, sondern plant, lernt, Werkzeuge nutzt und in Teams zusammenarbeitet, um Probleme zu lösen, die für bisherige Modelle unerreichbar schienen.

Das musst Du wissen – Agentic AI auf den Punkt gebracht

- Mehr als nur ein LLM: Agentic AI geht über die einmalige Beantwortung von Prompts hinaus. Diese Systeme nutzen LLMs als Kern-Engine, um komplexe, mehrstufige Aufgaben autonom zu planen, durchzuführen und aus den Ergebnissen zu lernen. Sie agieren persistent in einer Umgebung und passen sich dynamisch an.

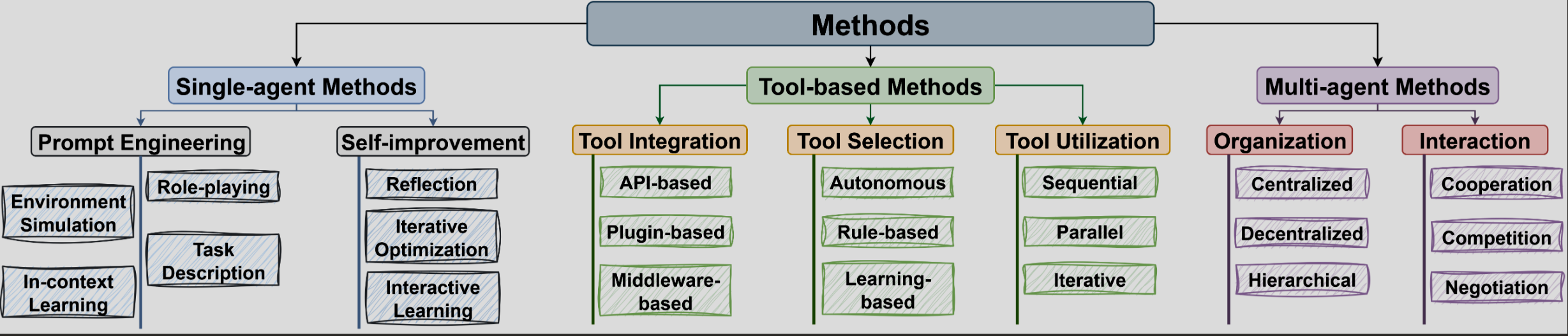

- Eine klare Struktur: Die neue Studie schlägt eine systematische Taxonomie vor, die Reasoning Frameworks in drei progressive Stufen unterteilt: Single-Agent-Methoden (die Optimierung eines einzelnen Agenten), Tool-basierte Methoden (die Nutzung externer Werkzeuge) und Multi-Agenten-Methoden (die Kollaboration mehrerer Agenten).

- Revolution in der Praxis: LLM-Agenten sind keine Zukunftsmusik mehr. Sie werden bereits erfolgreich eingesetzt, um die wissenschaftliche Forschung zu automatisieren, komplexe Diagnosen im Gesundheitswesen zu stellen, ganze Softwareprojekte zu entwickeln und realistische soziale sowie ökonomische Simulationen durchzuführen.

Was genau ist Agentic AI? Die grundlegende Abgrenzung

Um die Bedeutung von Agentic AI zu verstehen, musst Du den Unterschied zu einem Standard-LLM kennen. Ein herkömmliches LLM nimmt einen Input (deinen Prompt) und generiert einen Output in einem einzigen Schritt. Seine „Erinnerung“ beschränkt sich auf das aktuelle Kontextfenster. Ein LLM-Agent hingegen agiert wie ein autonomer Problemlöser. Er zerlegt eine komplexe Aufgabe in eine Kette von logischen Schritten.

Stell es dir so vor: Du bittest ein LLM, eine E-Mail zu schreiben – es schreibt sie. Du bittest einen LLM-Agenten, eine Marketingkampagne zu planen. Der Agent wird:

- Das Ziel analysieren (Planning).

- Eine Websuche nach aktuellen Trends durchführen (Tool-Use).

- Eine Liste mit Zielgruppen erstellen.

- Entwürfe für Social-Media-Posts und E-Mails generieren.

- Die Ergebnisse in einer Präsentation zusammenfassen.

- Auf Feedback warten und den Plan anpassen (Memory & Reflection).

Dieser mehrstufige Prozess, der Planung, Gedächtnis und die Nutzung von Werkzeugen integriert, ist das Herzstück von Agentic AI. Der Agent nimmt seine Umgebung wahr, handelt in ihr und lernt aus den Konsequenzen – eine Fähigkeit, die bisher als Domäne des Menschen galt.

Die Architektur des Denkens: Eine neue Taxonomie für LLM-Agenten

Die zentrale Leistung der Studie von Zhao et al. ist die Schaffung einer klaren und verständlichen Klassifizierung für die verschiedenen Ansätze im Bereich der Reasoning Frameworks. Diese Taxonomie hilft Forschern und Entwicklern, die Stärken und Schwächen unterschiedlicher Architekturen zu verstehen. Sie gliedert sich in drei aufbauende Stufen.

Stufe 1: Single-Agent-Methoden – Die Optimierung des Individuums

Auf dieser grundlegendsten Ebene geht es darum, die kognitiven Fähigkeiten eines einzelnen Agenten zu maximieren. Dies geschieht hauptsächlich auf zwei Wegen, die ohne ein erneutes Training des Basis-LLMs auskommen:

- Prompt Engineering: Hier wird der anfängliche Kontext des Agenten durch präzise formulierte Anweisungen angereichert. Dazu gehören:

- Rollen-Zuweisung: Der Agent erhält eine Persona („Du bist ein erfahrener Biochemiker“), um domänenspezifisches Wissen zu aktivieren.

- Umgebungssimulation: Die Anweisungen beschreiben ein Szenario („Du befindest Dich in einem virtuellen Labor“), um kontextbezogene Entscheidungen zu fördern.

- In-Context Learning (ICL): Dem Agenten werden Beispiele für korrekte Problemlösungen gezeigt, aus denen er Muster ableiten kann.

- Self-Improvement (Selbstverbesserung): Diese Mechanismen ermöglichen es dem Agenten, aus eigenen Erfahrungen zu lernen und seine Strategien dynamisch anzupassen.

- Reflexion: Der Agent analysiert vergangene Aktionen und Ergebnisse, um Fehler zu identifizieren und seine Pläne für zukünftige Versuche zu verfeinern (z.B. im Framework Reflexion).

- Iterative Optimierung: Der Agent erzeugt eine erste Lösung, vergleicht sie mit einem definierten Standard und verfeinert sie in mehreren Schleifen, bis das Ziel erreicht ist (z.B. in Self-Refine).

- Interaktives Lernen: Der Agent interagiert mit einer dynamischen Umgebung und passt seine übergeordneten Ziele basierend auf neuen Entdeckungen an – eine Form des offenen, lebenslangen Lernens (z.B. in Voyager).

Stufe 2: Tool-basierte Methoden – Die Erweiterung der Fähigkeiten

LLMs sind von Natur aus auf die in ihren Trainingsdaten enthaltenen Informationen beschränkt und können nicht direkt mit der Außenwelt interagieren. Tool-basierte Methoden überwinden diese Grenze, indem sie Agenten ermöglichen, auf externe Ressourcen zuzugreifen.

- Tool-Integration: Werkzeuge werden über Schnittstellen wie APIs (z.B. für eine Websuche), Plugins (z.B. für eine Vektordatenbank via RAG) oder Middleware (eine Abstraktionsschicht, die die Interaktion vereinfacht) in das System des Agenten eingebunden.

- Tool-Auswahl: Der Agent muss entscheiden, welches Werkzeug für eine bestimmte Aufgabe am besten geeignet ist. Dies kann autonom (basierend auf der Beschreibung der Tools), regelbasiert (durch vordefinierte Logik) oder lernbasiert (durch Reflexion über frühere Erfolge und Misserfolge) geschehen.

- Tool-Nutzung: Die ausgewählten Werkzeuge können auf verschiedene Weisen eingesetzt werden: sequenziell (der Output eines Tools ist der Input des nächsten), parallel (mehrere Tools werden gleichzeitig aufgerufen, um Zeit zu sparen) oder iterativ (ein Tool wird wiederholt mit verfeinerten Inputs aufgerufen, bis ein Teilproblem gelöst ist, z.B. beim Debuggen von Code).

Stufe 3: Multi-Agenten-Methoden – Die Kraft der Kollaboration

Die komplexesten Herausforderungen erfordern oft unterschiedliche Expertisen und eine „Arbeitsteilung“. Multi-Agenten-Systeme (MAS) setzen genau hier an, indem sie die kollektive Intelligenz mehrerer spezialisierter Agenten nutzen. Der Schlüssel zum Erfolg liegt in der effektiven Koordination, die durch zwei Aspekte bestimmt wird:

- Organisatorische Architektur: Wie sind die Agenten strukturiert?

- Zentralisiert: Ein „Manager-Agent“ plant, verteilt Aufgaben und synthetisiert die Ergebnisse der anderen Agenten.

- Dezentralisiert: Alle Agenten sind gleichberechtigt und treffen Entscheidungen auf Basis von Peer-to-Peer-Kommunikation. Dies fördert Robustheit, da es keinen Single Point of Failure gibt.

- Hierarchisch: Agenten sind in einer Pyramidenstruktur organisiert. Höherrangige Agenten kümmern sich um die strategische Planung, während Agenten auf unteren Ebenen spezifische Aufgaben ausführen (z.B. in MetaGPT).

- Individuelle Interaktionen: Wie verhalten sich die Agenten zueinander?

- Kooperation: Alle Agenten arbeiten auf ein gemeinsames Ziel hin und teilen Informationen, um den kollektiven Nutzen zu maximieren.

- Wettbewerb: Agenten verfolgen individuelle, oft widersprüchliche Ziele. Dies kann in „Debatten“-Szenarien genutzt werden, um Annahmen zu hinterfragen und die Robustheit einer Lösung zu testen.

- Verhandlung: Ein Mittelweg, bei dem Agenten durch Kompromisse einen für alle akzeptablen Konsens finden, um komplexe Entscheidungen zu treffen.

Wo Agentic AI heute schon die Welt verändert: Konkrete Anwendungsfälle 2025

Die in der Taxonomie beschriebenen Frameworks sind weit mehr als theoretische Konstrukte. Sie bilden die Grundlage für eine wachsende Zahl von Anwendungen, die reale Probleme lösen.

Revolution in der Wissenschaft: Von der Hypothese zur Publikation

Agentensysteme automatisieren zunehmend den gesamten wissenschaftlichen Forschungsprozess.

- In der Biochemie entwerfen Frameworks wie ProtAgents und DrugAgent neue Moleküle und Wirkstoffe, indem sie Simulationen durchführen, Daten analysieren und Experimente planen. BioDiscovery-Agent entwirft selbstständig Gen-Experimente und lernt aus den Ergebnissen.

- In den Geowissenschaften analysiert GeoAgent Geodaten, um komplexe räumliche Probleme zu lösen, während GeoMap-Agent sogar geologische Karten interpretieren kann.

- Im Bereich der allgemeinen Forschung können Systeme wie AutoSurvey und SurveyX eigenständig umfassende wissenschaftliche Übersichtsartikel erstellen – von der Literaturrecherche über die Gliederung bis hin zum ausformulierten Text.

Der digitale Hippokrates: Agenten im Gesundheitswesen

Im Gesundheitswesen unterstützen Agenten bei Diagnose, Management und sogar Simulation.

- Diagnosehilfe: Systeme wie MedAgents simulieren ein Expertengremium, in dem verschiedene „Facharzt-Agenten“ über einen Fall diskutieren, um eine präzisere Diagnose zu stellen. Multimodale Agenten wie MedAgent-Pro können dabei sogar medizinische Bilder und Laborwerte analysieren.

- Klinisches Management: ClinicalAgent prognostiziert die Erfolgsaussichten klinischer Studien, während andere Systeme administrative Aufgaben automatisieren und so Ärzte entlasten.

- Umgebungssimulation: Projekte wie Agent Hospital schaffen eine komplette virtuelle Klinik. Hier können KI-Agenten in einer sicheren Umgebung an simulierten Patienten lernen, Diagnosen stellen und Behandlungen durchführen, ohne echte Menschen zu gefährden.

Softwareentwicklung 2.0: Autonome Codierer und Entwicklerteams

Agentic AI revolutioniert, wie Software geschrieben, repariert und verwaltet wird.

- Code-Generierung und -Reparatur: Frameworks wie AgentCoder nutzen einen testgetriebenen Ansatz, bei dem ein Agent Code schreibt, ein zweiter Tests dafür erstellt und ein dritter den Code anhand der Testergebnisse repariert. SWE-Agent kann sogar direkt in einer Code-Repository agieren, um GitHub-Issues selbstständig zu lösen.

- Vollständige Entwicklungszyklen: MetaGPT und ChatDev simulieren ganze Software-Entwicklungsteams. Agenten übernehmen Rollen wie Projektmanager, Analyst, Entwickler und Tester und arbeiten nach etablierten Methoden wie den Standard Operating Procedures (SOPs) zusammen, um von der Anforderung bis zum fertigen Produkt alles zu automatisieren.

Gesellschaft im Simulator: Soziale und ökonomische Dynamiken verstehen

Durch die Simulation menschlichen Verhaltens ermöglichen Agenten völlig neue Einblicke in komplexe Systeme.

- Soziale Simulation: In virtuellen Welten wie Generative Agents entwickeln Agenten mit eigenen Persönlichkeiten und Zielen emergente soziale Verhaltensweisen. Forscher nutzen dies, um Phänomene wie die Verbreitung von Informationen, Wahlverhalten oder die Bildung von sozialen Gruppen zu untersuchen.

- Ökonomische Simulation: StockAgent und andere Frameworks bevölkern simulierte Finanzmärkte mit Tausenden von Händler-Agenten, die jeweils unterschiedliche Strategien verfolgen. So lassen sich Marktdynamiken unter verschiedenen Bedingungen analysieren und die Auswirkungen von Ereignissen vorhersagen.

Die Frameworks im direkten Vergleich: Eine Übersichtstabelle

Um die Unterschiede und Einsatzgebiete der drei Kerntypen von Reasoning Frameworks noch greifbarer zu machen, hilft ein direkter Vergleich. Die folgende Tabelle fasst die wichtigsten Merkmale, Ziele und Herausforderungen der jeweiligen Stufen zusammen und dient dir als schnelle Orientierungshilfe.

| Merkmal | Single-Agent-Methoden | Tool-basierte Methoden | Multi-Agenten-Methoden |

| Komplexität | Gering bis Mittel | Mittel | Hoch |

| Hauptziel | Maximierung der individuellen Leistung und kognitiven Fähigkeiten eines Agenten. | Überwindung der Wissensgrenzen des LLMs und Interaktion mit der realen Welt (Daten, APIs, Code). | Lösung hochkomplexer Probleme durch Arbeitsteilung, diverse Expertisen und kollektive Intelligenz. |

| Typische Anwendungsfälle | Texterstellung mit Selbstkorrektur, einfache Planungsaufgaben, Code-Optimierung in einer Schleife. | Recherchen im Internet, Datenanalyse mit Code-Interpretern, Steuerung von Smart-Home-Geräten. | Komplette Softwareentwicklung, wissenschaftliche Entdeckungsprozesse, komplexe Unternehmenssimulationen. |

| Größte Herausforderung | Gefahr von „Gedankenschleifen“ (Looping), begrenzte Problemlösungskapazität, stark abhängig von der Qualität des Prompts. | Zuverlässigkeit der externen Tools, korrekte Interpretation der Tool-Ergebnisse, Latenz bei API-Aufrufen. | Kommunikations-Overhead, Konfliktlösung zwischen Agenten, Gewährleistung eines kohärenten Gesamtergebnisses. |

Das Herz des Agenten: Welche LLM-Fähigkeiten machen Agentic AI möglich?

Ein agentisches Framework ist nur so stark wie das Sprachmodell, das es antreibt. Bestimmte Kernfähigkeiten moderner LLMs sind die eigentlichen Bausteine, die Agentic AI überhaupt erst ermöglichen. Wenn Du diese Fähigkeiten verstehst, wird klar, warum dieser Technologiesprung gerade jetzt stattfindet:

- Schritt-für-Schritt-Denken (Chain-of-Thought): LLMs können komplexe Anfragen in eine logische Kette von Zwischenschritten zerlegen. Diese Fähigkeit ist die Grundlage für jede Form von Planung. Ein Agent nutzt dies, um einen umfassenden Plan zu erstellen, bevor er den ersten Schritt ausführt.

- Anpassung im Kontext (In-Context Learning): Ohne erneutes Training können LLMs aus den im Prompt bereitgestellten Beispielen lernen. Agenten nutzen dies, um neue Aufgaben zu verstehen, den Stil anzupassen oder aus Fehlern zu lernen, die im Laufe einer Aufgabe im „Gedächtnis“ (Kontextfenster) gespeichert wurden.

- Nutzung von Werkzeugen (Function Calling / Tool Use): Moderne LLMs sind darauf trainiert, zu erkennen, wann sie für eine Anfrage Informationen aus einer externen Quelle benötigen. Sie können dann strukturierte Anfragen an APIs (z.B. eine Wetter-API oder eine interne Datenbank) formulieren. Dies ist die technische Grundlage für alle tool-basierten Agenten.

- Fähigkeit zur Selbstreflexion und -korrektur: LLMs können ihren eigenen Output bewerten und verbessern. Ein Agent nutzt dies für Reflexionsschleifen: Er generiert eine Lösung, erhält den Befehl „Überprüfe deine Antwort auf Fehler“ und erzeugt eine verbesserte Version.

Diese vier Säulen sind das Fundament, auf dem die komplexen Architekturen der LLM-Agenten aufbauen.

Die Hürden auf dem Weg: Aktuelle Herausforderungen für Agentic AI

Trotz des enormen Potenzials stehen Entwickler von agentischen Systemen vor erheblichen Herausforderungen. Ein realistischer Blick auf diese Hürden ist entscheidend, um den aktuellen Stand der Technik einzuordnen und zukünftige Entwicklungen zu verstehen.

- Verlässlichkeit und Halluzination: Das Kernproblem der LLMs – das Erfinden von Fakten – wird in Agenten potenziert. Eine einzige „halluzinierte“ Information in einem frühen Schritt einer langen Aufgabenkette kann das gesamte Endergebnis unbrauchbar machen. Die Sicherstellung der Fakten- und Prozesstreue ist eine der größten Aufgaben.

- Komplexität und Kosten: Mehrstufige Denkprozesse, Tool-Aufrufe und die Kommunikation zwischen mehreren Agenten erfordern eine immense Menge an Rechenleistung. Jeder einzelne Schritt verbraucht Tokens. Eine komplexe Aufgabe kann schnell sehr teuer werden und lange dauern, was den Einsatz in Echtzeitanwendungen erschwert.

- Bewertung und Benchmarking: Wie misst man objektiv, ob ein autonomes System eine komplexe, offene Aufgabe „gut“ gelöst hat? Standardisierte Benchmarks für agentische Fähigkeiten stecken noch in den Kinderschuhen. Oft ist eine aufwändige menschliche Bewertung die einzige Möglichkeit, die tatsächliche Leistung zu beurteilen.

- Sicherheit und Kontrolle: Ein autonomer Agent, der Code ausführen, auf das Internet zugreifen und Dateien verändern kann, stellt ein erhebliches Sicherheitsrisiko dar. Es ist eine gewaltige Herausforderung, robuste „Leitplanken“ (Guardrails) zu errichten, die den Agenten daran hindern, schädliche oder unbeabsichtigte Aktionen auszuführen, während seine Nützlichkeit erhalten bleibt.

Die Lösung dieser Herausforderungen wird entscheidend dafür sein, wie schnell und sicher sich Agentic AI von einer vielversprechenden Technologie zu einem alltäglichen, verlässlichen Werkzeug entwickeln wird.

Fazit und Ausblick: Die nächste Stufe der Künstlichen Intelligenz

Die umfassende Analyse von Zhao und seinem Team macht unmissverständlich klar: Agentic AI ist der nächste logische und transformative Schritt in der Evolution der Künstlichen Intelligenz. Wir bewegen uns weg von reaktiven Werkzeugen hin zu proaktiven, autonomen Partnern. Die vorgestellte Taxonomie der Reasoning Frameworks – von der Optimierung einzelner Agenten über die Nutzung von Werkzeugen bis hin zur Kollaboration in Multi-Agenten-Systemen – liefert das entscheidende Vokabular und die strukturelle Grundlage, um diese komplexen Systeme zu verstehen, zu bauen und zu vergleichen.

Die praktischen Anwendungsfälle zeigen bereits heute, dass dies keine ferne Zukunftsvision ist. Ob bei der Beschleunigung der Wirkstoffforschung, der Entwicklung fehlerfreier Software oder der Simulation komplexer gesellschaftlicher Prozesse – LLM-Agenten beginnen, Aufgaben zu übernehmen, deren Komplexität und Umfang bisher menschliche Teams erforderten. Doch dieser Fortschritt wirft auch neue Fragen auf. Herausforderungen wie die Skalierbarkeit und Effizienz der Systeme, die Gewährleistung von ethischem Verhalten, Fairness und Sicherheit sowie die Fähigkeit der Agenten zum wirklich offenen, kreativen Lernen rücken in den Fokus.

Die Reise der Agentic AI hat gerade erst begonnen. Die hier vorgestellten Frameworks sind die Blaupausen für eine Zukunft, in der Künstliche Intelligenz nicht nur Informationen verarbeitet, sondern eigenständig handelt, entdeckt und kreiert. Es ist eine Entwicklung, die das Potenzial hat, jede Branche und jeden Aspekt unseres Lebens neu zu definieren.

Quellen

- Zhao, B., Foo, L. G., Hu, P., Theobalt, C., Rahmani, H., & Liu, J. (2025). LLM-based Agentic Reasoning Frameworks: A Survey from Methods to Scenarios. arXiv preprint arXiv:2508.17692. Verfügbar unter: https://arxiv.org/abs/2508.17692

#KI #AI #ArtificialIntelligence #KuenstlicheIntelligenz #AgenticAI #LLMAgents #AutonomousAI #FutureOfAI, Agentic AI Frameworks