Was, wenn deine KI nicht nur einen Satz, sondern ein ganzes Buch auf einmal verstehen könnte? Wenn ein KI-Programmierassistent nicht nur eine Codezeile, sondern dein gesamtes Softwareprojekt überblickt? Genau diese Zukunft läutet Nvidia mit einer bahnbrechenden Ankündigung ein. Mit der Nvidia Rubin CPX wurde auf dem AI Infrastructure Summit am 9. September 2025 eine völlig neue Klasse von GPUs vorgestellt, die speziell für die Ära der Long-Context-Inferenz mit über einer Million Token entwickelt wurde.

Dieser Schritt ist mehr als nur ein Hardware-Update; es ist eine strategische Neuausrichtung der KI-Infrastruktur, die massive Auswirkungen auf generative Videoproduktion, komplexe Softwareentwicklung und tiefgehende Forschungsanwendungen haben wird. Wir tauchen tief ein, analysieren die Technik, die dahintersteckt, und zeigen dir, warum die Rubin CPX nicht nur ein Chip, sondern ein Game-Changer für die gesamte Branche ist. Mach dich bereit für die nächste Stufe der künstlichen Intelligenz.

Eher was für´s Heim gesucht: Dann ist NVIDIA G-Assist vielleicht was für Dich?

Nvidia Rubin CPX – Das Wichtigste in Kürze

- Neue GPU-Klasse: Die Nvidia Rubin CPX ist eine spezialisierte GPU, die für die Verarbeitung riesiger Kontextfenster (über 1 Million Token) optimiert ist.

- Disaggregated Inference: Sie ist Teil einer neuen Architektur, die die rechenintensive „Context Phase“ von der speicherintensiven „Generation Phase“ der KI-Inferenz trennt und so die Effizienz massiv steigert.

- Enorme Leistung: Im Verbund der Vera Rubin NVL144 CPX Plattform liefert das System 8 Exaflops KI-Leistung – 7,5-mal mehr als das aktuelle Blackwell GB300-System.

- Schlüsselanwendungen: Die CPX zielt auf hochprofitable Bereiche wie KI-gestützte Softwareentwicklung (Codebases verstehen) und die Erstellung hochauflösender, langer Videos.

- Beeindruckender ROI: Nvidia prognostiziert einen potenziellen Token-Umsatz von 5 Milliarden US-Dollar für jede Investition von 100 Millionen US-Dollar in die Plattform.

- Verfügbarkeit: Die ersten Systeme mit Nvidia Rubin CPX sollen Ende 2026 auf den Markt kommen.

- Marktdominanz: Die Ankündigung untermauert Nvidias unaufhaltsamen Marsch, der dem Unternehmen zuletzt einen Quartalsumsatz von 41,1 Milliarden US-Dollar allein im Datacenter-Bereich bescherte.

Die KI-Kontext-Krise: Warum bisherige GPUs an ihre Grenzen stoßen

Bisherige KI-Modelle waren wie Menschen mit einem Kurzzeitgedächtnis. Sie konnten brillante Texte schreiben oder Bilder erzeugen, vergaßen aber schnell den größeren Zusammenhang. Für moderne KI-Agenten, die komplexe, mehrstufige Aufgaben lösen sollen, ist das eine massive Hürde. Ob eine KI einen einstündigen Film analysieren oder eine komplette Software-Architektur optimieren soll – beides erfordert die Verarbeitung von Millionen von „Tokens“ (Wort- oder Code-Teile) auf einmal.

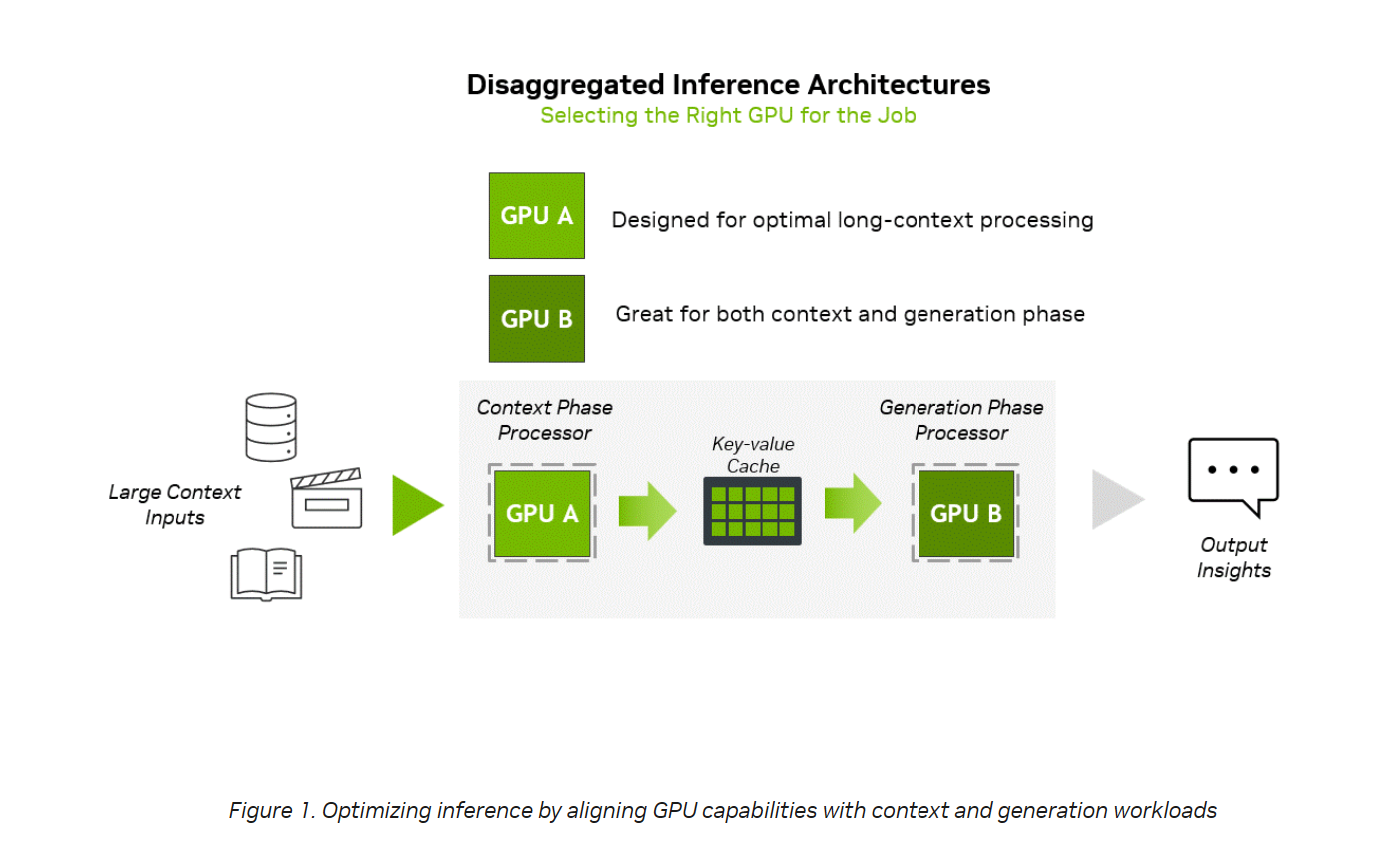

Heutige GPUs sind Allrounder. Sie müssen sowohl die riesige Eingabe (den „Kontext“) verarbeiten als auch Token für Token die Antwort generieren. Das ist ineffizient. Die Verarbeitung des Kontexts ist extrem rechenintensiv (Compute-Bound), während die Generierung der Antwort von der Speicherbandbreite abhängt (Memory-Bound). Ein einziger Chip für beide Aufgaben ist immer ein Kompromiss. Genau hier setzt Nvidias neue Strategie an.

Quelle: NVIDIA

Deep Dive „Disaggregated Inference“

Nvidias geniale Lösung heißt Disaggregated Inference – zu Deutsch etwa „entkoppelte Inferenz“. Stell dir eine Profi-Küche vor. Bisher war ein Koch (die GPU) für alles zuständig: Zutaten schnibbeln (Kontext verarbeiten) und das Gericht anrichten (Antwort generieren). Das ist langsam.

Im neuen Modell gibt es zwei Spezialisten:

- Der Vorbereitungskoch (Nvidia Rubin CPX): Ein Meister darin, riesige Mengen an Zutaten (den 1-Million-Token-Kontext) extrem schnell zu verarbeiten. Er ist auf pure Rechenleistung optimiert.

- Der Anrichte-Koch (Nvidia Rubin GPU): Ein Experte, der blitzschnell auf die vorbereiteten Zutaten zugreift und das perfekte Gericht (die Antwort) Token für Token serviert. Er ist auf Speichergeschwindigkeit optimiert.

Diese Aufgabenteilung ermöglicht es, jeden Teil des Prozesses perfekt zu optimieren, was zu enormen Geschwindigkeits- und Effizienzsteigerungen führt. Die Rubin CPX ist der erste dedizierte „Vorbereitungskoch“ der KI-Welt.

Das Kraftpaket im Detail: Die Vera Rubin NVL144 CPX Plattform

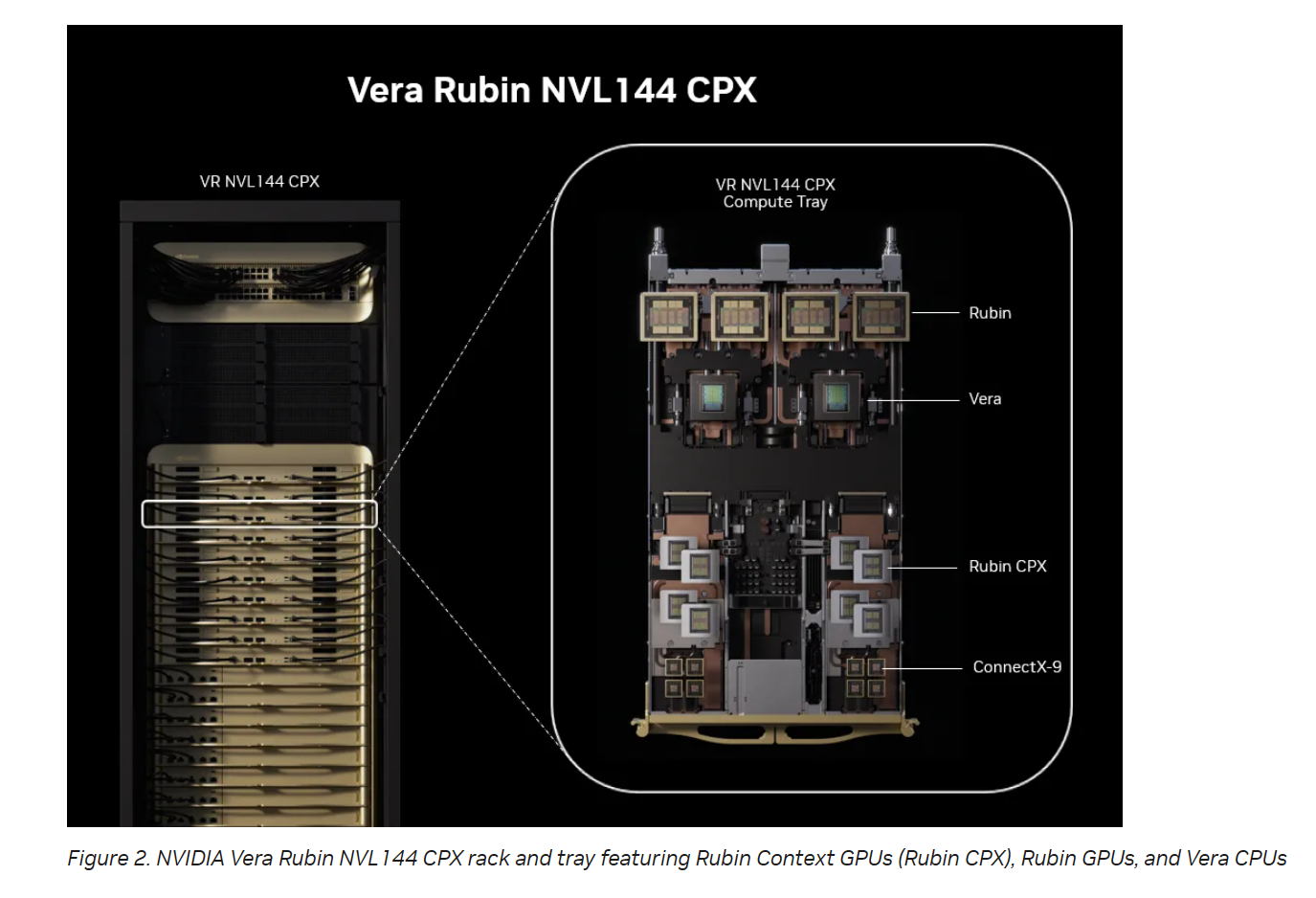

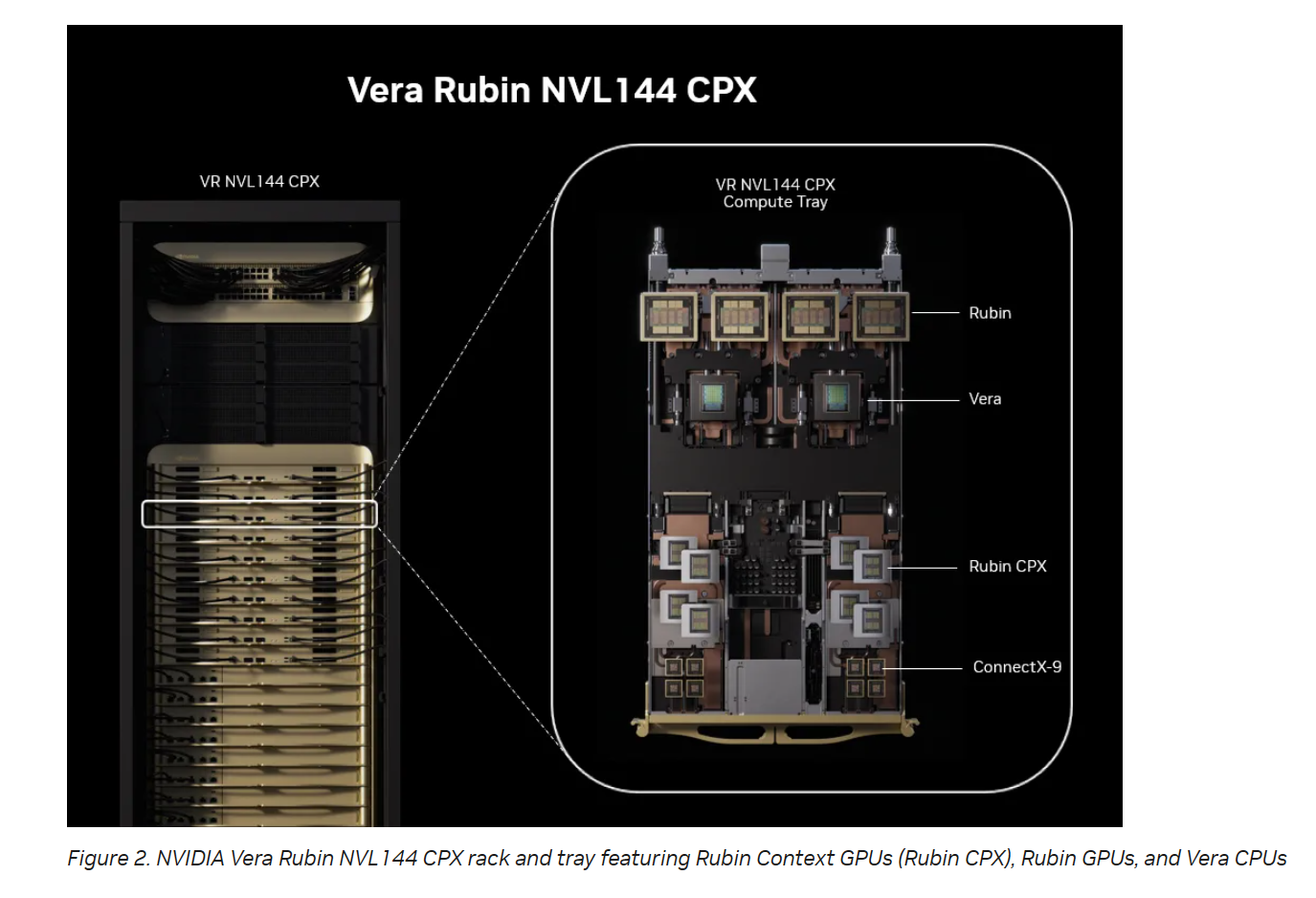

Die Rubin CPX entfaltet ihre volle Kraft nicht allein, sondern als Teil der NVIDIA Vera Rubin NVL144 CPX Plattform. Dieses komplette Rack-System ist eine technische Meisterleistung und kombiniert:

- 144 Rubin CPX GPUs (für die Kontext-Phase)

- 144 Rubin GPUs (für die Generations-Phase)

- 36 Vera CPUs (als zentrale Steuereinheit)

Technische Spezifikationen der Plattform:

- KI-Rechenleistung: 8 Exaflops (mit NVFP4-Präzision)

- Arbeitsspeicher: 100 TB High-Speed Memory

- Speicherbandbreite: 1,7 Petabytes pro Sekunde

- Netzwerk: NVIDIA Quantum-X800 InfiniBand oder Spectrum-X Ethernet

Diese Zahlen bedeuten eine Leistungssteigerung um den Faktor 7,5 gegenüber der bereits extrem schnellen Blackwell-Generation und setzen einen neuen Standard für KI-Infrastruktur.

Quelle: NVIDIA

Vergleichsmatrix: Rubin CPX vs. Blackwell GB200

| Dimension | Nvidia Rubin CPX (im NVL144 Verbund) | Nvidia Blackwell GB200 (im NVL72 Verbund) | Der Vorteil von Rubin CPX |

| Primärer Fokus | Long-Context-Inferenz (Kontext-Phase) | Allzweck-KI-Inferenz & Training | Spezialisiert für höchste Effizienz bei großen Kontexten |

| Systemleistung | 8 Exaflops (NVFP4) | ca. 1,06 Exaflops (NVFP4) | ~7,5x höhere Systemleistung |

| Architektur | Disaggregated Inference | Monolithische Inferenz | Gezielte Optimierung, weniger Engpässe |

| Attention-Beschleunigung | 3x schneller im Vergleich zum GB300 | Basis-Leistung | Deutlich schnellere Verarbeitung von Zusammenhängen |

| Anwendungs- sweetspot | Agentic AI, Gen-Video, Codebase-Analyse | Allgemeine LLM-Aufgaben, KI-Training | Erschließt neue, hochprofitable Anwendungsfälle |

| Verfügbarkeit | Ende 2026 | Verfügbar | Zukünftige Generation |

Praktische Anwendung: Was mit Rubin CPX plötzlich möglich wird

Diese technologische Revolution ist keine reine Theorie. Sie wird konkrete Branchen fundamental verändern.

Case Study 1: Die Zukunft der Softwareentwicklung (Cursor & Magic)

Unternehmen wie Cursor und Magic arbeiten an KI-Agenten, die nicht nur Code vervollständigen, sondern als autonome Software-Ingenieure agieren.

- Problem heute: KI-Assistenten sehen nur kleine Ausschnitte des Codes und verstehen nicht die gesamte Architektur. Änderungen an einer Stelle können unerwartete Fehler an anderer Stelle verursachen.

- Lösung mit Rubin CPX: Ein KI-Agent kann eine Codebasis mit Millionen von Zeilen als einzigen Kontext laden. Er versteht Abhängigkeiten, findet komplexe Fehler und kann eigenständig große Features entwickeln. Eric Steinberger, CEO von Magic, spricht von einem 100-Millionen-Token-Kontextfenster, das es dem Agenten ermöglicht, „Jahre an Interaktionshistorie, Dokumentation und Bibliotheken im Kontext zu sehen“. Das ist der Sprung vom Co-Piloten zum autonomen Chef-Entwickler.

Case Study 2: Hollywood im Rechenzentrum (Runway)

Runway, ein führendes Unternehmen für generative KI im Videobereich, will Kreativen ermöglichen, kinoreife Inhalte zu erstellen.

- Problem heute: Die Generierung langer, konsistenter Videos in hoher Qualität ist extrem rechenintensiv und oft auf wenige Sekunden beschränkt.

- Lösung mit Rubin CPX: Die integrierten Video-Encoder und die massive Rechenleistung erlauben die Verarbeitung von bis zu einer Million Token pro Stunde Videomaterial. Cristóbal Valenzuela, CEO von Runway, sieht darin einen „gewaltigen Leistungssprung“, der „agentengesteuerte kreative Workflows“ ermöglicht und Kreativen „beispiellose Geschwindigkeit, Realismus und Kontrolle“ gibt.

Expert Insights: Was Branchenführer sagen

Die Begeisterung ist in der gesamten Branche spürbar:

Nvidias CEO Jensen Huang bringt es auf den Punkt:

„So wie RTX die Grafik und die physikalische KI revolutioniert hat, ist Rubin CPX die erste CUDA-GPU, die speziell für massive Kontext-KI entwickelt wurde, bei der Modelle über Millionen von Wissens-Tokens auf einmal nachdenken.“ [NVIDIA News, 2025]

Michael Truell, CEO von Cursor, fügt hinzu:

„Mit NVIDIA Rubin CPX wird Cursor in der Lage sein, blitzschnelle Codegenerierung und Entwicklereinblicke zu liefern und so die Softwareerstellung zu transformieren.“ [NVIDIA News, 2025]

Diese Zitate zeigen, dass die Rubin CPX nicht nur eine Nischenlösung ist, sondern als grundlegende Plattform für die nächste Generation von KI-Anwendungen gesehen wird.

Häufige Fehler & Falsche Annahmen über Long-Context-Inferenz

- „Mehr VRAM ist die einzige Lösung.“ Falsch. Während mehr Speicher hilft, ist die Rechenleistung zur Verarbeitung des Kontexts (die Attention-Berechnung) der eigentliche Flaschenhals. Die CPX löst dies mit 3-fach beschleunigter Attention.

- „Das ist nur für große Cloud-Anbieter relevant.“ Anfangs ja, aber die Technologie wird es auch kleineren Unternehmen ermöglichen, über spezialisierte Cloud-Angebote extrem leistungsfähige KI-Agenten zu nutzen, was die Wettbewerbslandschaft verändert.

- „Disaggregated Inference ist komplizierter.“ Ja, die Orchestrierung ist anspruchsvoller. Aber Nvidia liefert mit der Dynamo-Plattform die Software-Schicht, die diese Komplexität für Entwickler handhabbar macht.

Die Milliarden-Dollar-Frage: Die ROI-Analyse

Nvidias Behauptung, mit einer Investition von 100 Millionen Dollar einen Umsatz von 5 Milliarden Dollar zu erzielen, klingt astronomisch. Wie ist das möglich?

Die Rechnung basiert auf der „Token-Ökonomie“. Unternehmen, die KI-Dienste anbieten (wie OpenAI), berechnen die Nutzung oft pro verarbeitetem Token.

- Annahme: Long-Context-Anwendungen wie autonome Softwareentwicklung sind extrem wertvoll. Unternehmen sind bereit, dafür hohe Preise pro Token zu zahlen.

- Kalkulation: Die extreme Effizienz und der hohe Durchsatz der Vera Rubin NVL144 CPX Plattform ermöglichen es, eine riesige Menge an hochpreisigen Tokens zu verarbeiten.

- Ergebnis: Die Betriebskosten pro Token sinken drastisch, während der Wert des generierten Ergebnisses steigt. Diese Hebelwirkung führt zu dem prognostizierten 30- bis 50-fachen Return on Investment. Es ist eine Wette darauf, dass KI-Agenten zum zentralen Produktivitätswerkzeug der Zukunft werden.

Ausblick: Nvidias unaufhaltsame Roadmap und der KI-Wettlauf

Die Vorstellung der Rubin-Plattform, die erst für Ende 2026 geplant ist, während die Blackwell-Generation gerade erst anläuft, zeigt Nvidias unerbittliches Innovationstempo. Das Unternehmen lässt der Konkurrenz kaum Luft zum Atmen und zementiert seine Position als zentraler Ausstatter der KI-Revolution. Die jüngsten Quartalszahlen mit 46,7 Milliarden US-Dollar Umsatz (+56 % im Jahresvergleich) sprechen eine deutliche Sprache. Der „KI-Wettlauf ist eröffnet, und Blackwell ist die Plattform in seinem Zentrum“, so Jensen Huang. Mit Rubin CPX hat er bereits die nächste Rennstrecke abgesteckt.

Tools & Ressourcen für Entwickler

Für Entwickler, die sich auf diese neue Ära vorbereiten wollen, sind folgende Ressourcen entscheidend:

- NVIDIA Dynamo Platform: Die Software zur Orchestrierung von Disaggregated Inference.

- NVIDIA TensorRT-LLM: Eine Open-Source-Bibliothek zur Optimierung der Inferenzleistung.

- NVIDIA CUDA-X Libraries: Die grundlegende Sammlung von Softwarebibliotheken für die GPU-Beschleunigung.

- NVIDIA Nemotron Models: Nvidias eigene Familie multimodaler Modelle, die für den Einsatz als KI-Agenten optimiert sind.

- NVIDIA AI Enterprise: Die umfassende Software-Plattform für die Entwicklung und Bereitstellung von KI in Unternehmen.

Häufig gestellte Fragen zu Nvidia Rubin CPX

Was ist Nvidia Rubin CPX? Nvidia Rubin CPX ist eine neue, spezialisierte GPU-Klasse, die für die extrem schnelle Verarbeitung von sehr großen Kontextfenstern (über 1 Million Token) in KI-Anwendungen wie Softwareentwicklung und Videogenerierung entwickelt wurde.

Was ist der Hauptunterschied zu einer normalen GPU wie Blackwell? Während eine Blackwell-GPU ein Allrounder für KI-Training und -Inferenz ist, ist die Rubin CPX ein Spezialist für die rechenintensive „Kontext-Phase“ der Inferenz. Sie arbeitet im Team mit regulären Rubin-GPUs, die die „Generations-Phase“ übernehmen (Disaggregated Inference).

Wann wird die Rubin CPX verfügbar sein? Nvidia plant die Markteinführung der Rubin CPX und der dazugehörigen Plattformen für Ende 2026.

Wie viel schneller ist die neue Plattform? Die Vera Rubin NVL144 CPX Plattform bietet mit 8 Exaflops etwa 7,5-mal mehr KI-Rechenleistung als ein vergleichbares Blackwell GB300 NVL72 System.

Was ist „Disaggregated Inference“? Es ist ein neuer Architekturansatz, bei dem die zwei Phasen der KI-Antworterstellung (Kontext verstehen und Antwort generieren) auf spezialisierte Hardware aufgeteilt werden, um die Gesamteffizienz und Geschwindigkeit massiv zu erhöhen.

Löst die Rubin CPX das „AI Hallucination“-Problem? Indirekt ja. Indem Modelle einen viel größeren, faktenbasierten Kontext (z. B. eine ganze Wissensdatenbank) auf einmal sehen können, sinkt die Wahrscheinlichkeit, dass sie Informationen erfinden müssen. Die Antworten werden fundierter und zuverlässiger.

Ist diese Technologie auch für Gamer relevant? Nein, die Rubin CPX ist eine reine Rechenzentrums-GPU und hat keine direkten Auswirkungen auf GeForce-Grafikkarten für Gaming. Die Erkenntnisse aus der Chip-Entwicklung können aber langfristig in andere Produktlinien einfließen.

Fazit Nvidia Rubin CPX: Ein neuer Meilenstein für die künstliche Intelligenz

Die Ankündigung der Nvidia Rubin CPX ist weit mehr als die Vorstellung eines neuen Chips. Es ist die materielle Manifestation der nächsten KI-Ära – der Ära der agentenbasierten, kontextbewussten Systeme. Nvidia löst mit dem brillanten Konzept der „Disaggregated Inference“ einen der fundamentalsten Engpässe, der die Entwicklung intelligenterer und fähigerer KI bisher gebremst hat. Die Trennung von Kontext- und Generations-Verarbeitung ist ein Paradigmenwechsel, der die Effizienz und Leistungsfähigkeit von KI-Infrastruktur auf ein neues Niveau hebt.

Für Unternehmen bedeutet dies die greifbare Möglichkeit, KI-Agenten zu entwickeln, die nicht nur assistieren, sondern komplexe, wertschöpfende Aufgaben autonom übernehmen. Von der Softwareentwicklung über die Filmproduktion bis hin zur wissenschaftlichen Forschung – die Fähigkeit, Millionen von Token an Wissen auf einmal zu verarbeiten, wird die Grenzen des Möglichen verschieben. Nvidia hat mit Rubin CPX nicht nur die Zukunft der KI-Hardware skizziert, sondern auch das Geschäftsmodell für deren Monetarisierung neu definiert. Der Wettlauf um die Vorherrschaft in der KI hat gerade einen neuen, entscheidenden Startschuss erhalten.

Der nächste Schritt für dich ist, zu verstehen, wie diese Technologie deine Branche oder deine Projekte beeinflussen könnte. Die Zeit, sich mit agentenbasierten Systemen und Long-Context-Anwendungen zu beschäftigen, ist jetzt. Denn Ende 2026 wird die Hardware bereitstehen, die diese Visionen zur Realität macht.

Quellen und weiterführende Literatur

- NVIDIA News (09.09.2025). „NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference“.

- NVIDIA Developer Blog (09.09.2025). „NVIDIA Rubin CPX Accelerates Inference Performance and Efficiency for 1M+ Token Context Workloads“.

#KI #AI #ArtificialIntelligence #Nvidia #RubinCPX #GPU #KINEWS24 #Tech2025 #DeepLearning