Auch Alibaba hat sein neues Modell veröffentlicht: Alibaba Qwen 2.5: Mit Qwen 2.5-Max einen neuen Mixture-of-Experts (MoE) KI-Sprachmodell vorgestellt, das sich als direkter Konkurrent zu DeepSeek-V3 positioniert. Der Zeitpunkt der Veröffentlichung – mitten ins chinesische Neujahrsfest – zeigt, wie dringend Alibaba reagieren musste. DeepSeek-r1 hatte die AI-Welt überrascht: Es bot eine leistungsfähige Alternative zu bestehenden LLMs wie GPT-4, Claude 3.5 und Llama-3.1, benötigte dabei jedoch deutlich weniger Rechenleistung und Kosten.

Das musst du wissen – Qwen 2.5-Max vs. DeepSeek-V3

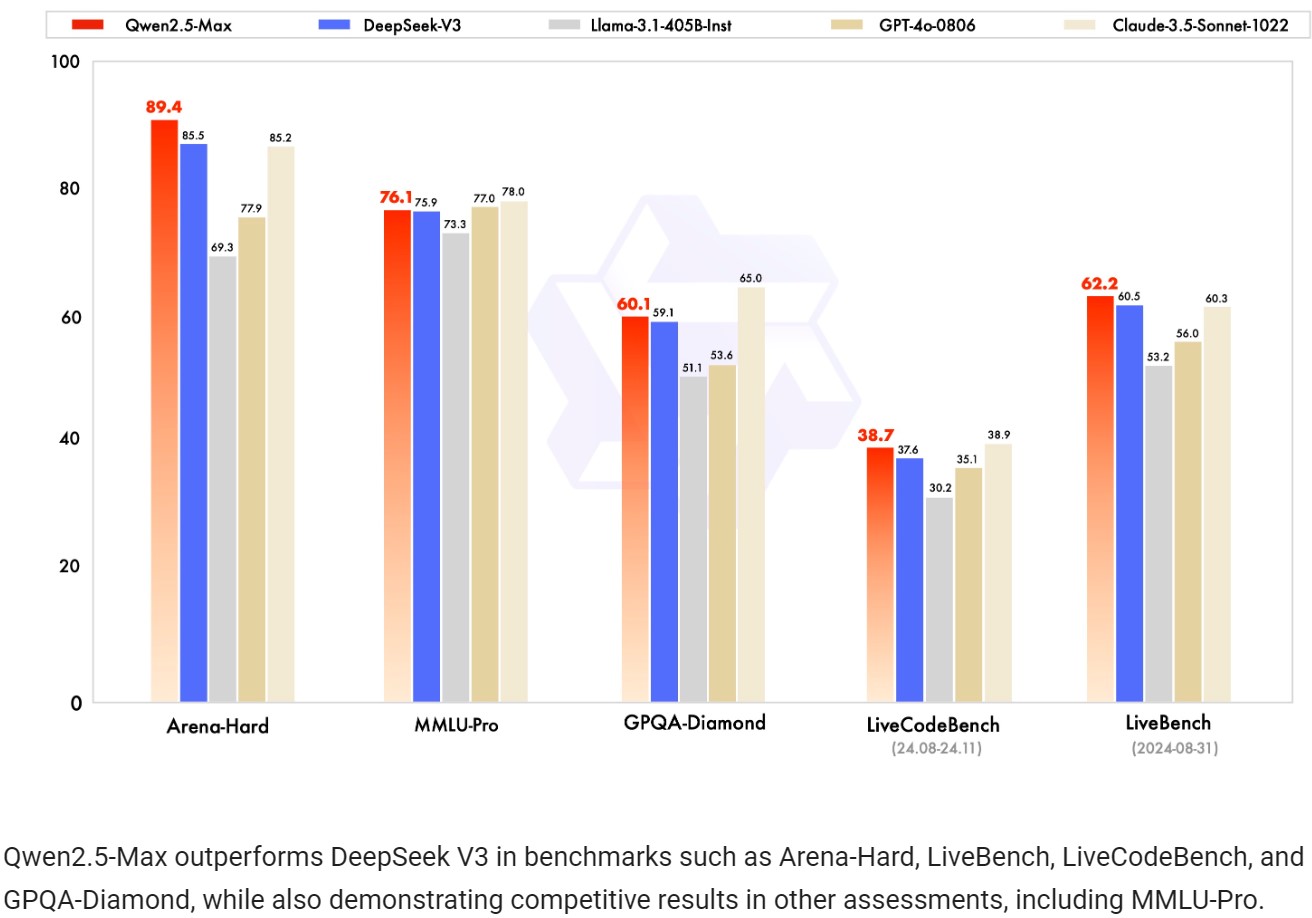

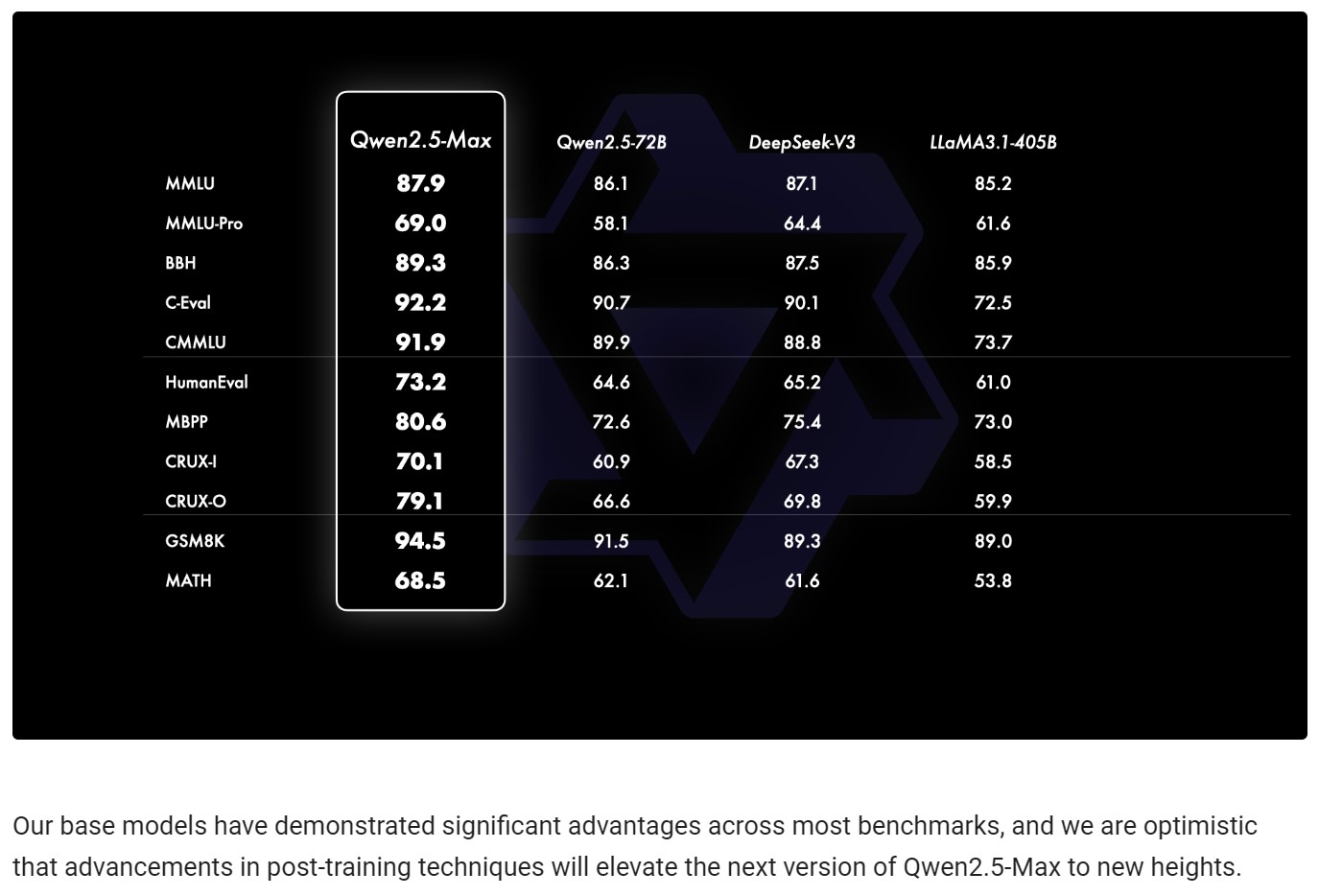

- Qwen 2.5-Max übertrifft DeepSeek-V3 in mehreren Benchmarks wie Arena-Hard, LiveBench und GPQA-Diamond.

- Kosteneffizienz: Dank MoE-Technologie reduziert Qwen 2.5-Max die Infrastrukturkosten um 40–60 % im Vergleich zu herkömmlichen LLMs.

- Trainingsumfang: Alibaba hat sein Modell mit über 20 Billionen Tokens trainiert und mit Supervised Fine-Tuning (SFT) & Reinforcement Learning from Human Feedback (RLHF) verfeinert.

- API-Verfügbarkeit: Entwickler können das Modell über Alibaba Cloud in eigene Anwendungen integrieren – mit einer OpenAI-kompatiblen API.

- Marktstrategie: Chinesische Unternehmen – einschließlich ByteDance – haben durch DeepSeeks rasante Fortschritte einen KI-Wettlauf innerhalb Chinas ausgelöst.

Alibaba Qwen 2.5-Max vs. DeepSeek-V3: Wer hat die Nase vorn?

Während DeepSeek-V3 sich vor allem durch Effizienz und geringe Trainingskosten auszeichnet, setzt Qwen 2.5-Max auf eine breitere Skalierung. Aber welches Modell ist besser?

| Kriterium | Qwen 2.5-Max | DeepSeek-V3 |

|---|---|---|

| Benchmarks | Übertrifft DeepSeek-V3 in mehreren Tests (Arena-Hard, LiveBench) | Starke Leistung, aber teils unterlegen |

| Modellarchitektur | Mixture-of-Experts (MoE), skalierbar | Unklar, aber sehr effizient trainiert |

| Trainingsdaten | 20 Billionen Tokens, SFT & RLHF-Verfeinerung | Genaue Daten unbekannt |

| Kosten | Bis zu 60 % günstiger als herkömmliche LLMs | Entwickelt mit nur 6 Mio. USD Trainingsbudget |

| Rechenaufwand | Hohe Skalierung möglich | Extrem effizient mit älteren Nvidia-GPUs |

| API & Verfügbarkeit | Alibaba Cloud, OpenAI-kompatibel | Noch nicht vollständig offen |

Warum DeepSeek-V3 die Branche erschütterte

DeepSeek hat bewiesen, dass man leistungsstarke KI-Modelle mit geringeren Kosten und älterer Hardware trainieren kann. Während große Unternehmen wie OpenAI, Meta und Nvidia Milliarden in immer leistungsfähigere Hardware investieren, könnte DeepSeeks Methode die Notwendigkeit teurer GPUs infrage stellen.

Diese Innovation hat an der Börse Wellen geschlagen:

- Nvidia-Aktien verloren fast 600 Milliarden USD, da Investoren sich fragten, ob teure GPUs wie die H200 und Blackwell-Prozessoren überhaupt noch nötig seien.

- Meta startete interne „Llama-War Rooms“, um DeepSeeks Strategie zu analysieren.

- ByteDance reagierte mit einer AI-Aufrüstung, um OpenAI-Modelle herauszufordern.

Alibaba Qwen 2.5-Max: Die Antwort auf DeepSeek?

Alibaba hat mit Qwen 2.5-Max einen Konter geliefert, der sich sehen lassen kann. Der MoE-Ansatz sorgt für hohe Rechenleistung bei niedrigen Kosten, und Benchmarks zeigen, dass das Modell DeepSeek-V3 in mehreren Bereichen schlägt.

Doch es bleiben offene Fragen:

- Transparenz & Datennutzung: Hat DeepSeek V3 auf fremde AI-Daten zurückgegriffen?

- Datenschutz & Sicherheit: Wie sicher sind chinesische KI-Modelle für globale Nutzer?

- Langfristige Skalierbarkeit: Kann Alibaba mit OpenAI & Google langfristig konkurrieren?

Fazit Alibaba Qwen 2.5: Eskaliert der KI-Wettlauf weiter?

Der Wettstreit zwischen Alibaba, DeepSeek, OpenAI und Meta nimmt weiter Fahrt auf. Während DeepSeek Effizienz neu definiert, setzt Alibaba auf massive Skalierbarkeit. Wer am Ende die Nase vorn haben wird, bleibt offen – doch sicher ist: Die KI-Welt 2025 wird dramatisch anders aussehen als noch vor einem Jahr.

👉 Hier kannst Du Dich in einer aktiven Community austauschen und KI lernen: https://KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Tor Constantino, Forbes, „Alibaba Unveils Qwen 2.5: A DeepSeek Rival?“, 29.01.2025

➝ https://www.forbes.com/sites/torconstantino/2025/01/29/alibaba-unveils-qwen-25-a-deepseek-rival - Qwen Team, Qwen Blog, „Qwen2.5-Max: Exploring the Intelligence of Large-scale MoE Model“, 28.01.2025

➝ https://qwenlm.github.io/blog/qwen2.5-max/ - Eduardo Baptista, Reuters, „Alibaba releases AI model it says surpasses DeepSeek“, 29.01.2025

➝ https://www.reuters.com/technology/artificial-intelligence/alibaba-releases-ai-model-it-claims-surpasses-deepseek-v3-2025-01-29/

#AI #KI #ArtificialIntelligence #KuenstlicheIntelligenz #Alibaba #DeepSeek #Qwen #TechNews