Die Welt der KI-gestützten Bildgenerierung und -bearbeitung entwickelt sich rasant weiter. Mit FLUX.1 Kontext stellt Black Forest Labs (ja, sie kommen aus dem Schwarzwald und Deutschland hat damit einen echten Player auf dem Weltmarkt der KI-gestützen Bilder!) im Mai 2025 eine neue Modellsuite vor, die nicht nur Bilder aus Textbeschreibungen erzeugt, sondern auch bestehende Bilder intelligent und kontextbezogen modifiziert. Doch was macht diesen Ansatz so besonders und welche neuen Möglichkeiten eröffnen sich dadurch für Kreative und Entwickler? Wir schauen uns das genau an und zeigen dir, was hinter der Technologie steckt, wie sie funktioniert und was du damit praktisch erreichen kannst.

FLUX.1 Kontext ist eine Familie von generativen Flow-Matching-Modellen, die darauf trainiert wurden, sowohl Text- als auch Bild-Inputs zu verstehen. Diese Fähigkeit zur echten In-Context-Bildgenerierung und -bearbeitung hebt sie von vielen traditionellen Text-zu-Bild-Modellen ab. Stell dir vor, du kannst nicht nur ein Bild von Grund auf neu generieren, sondern ein vorhandenes Bild hochladen und mit präzisen Textanweisungen Elemente verändern, Stile übertragen oder Charaktere konsistent in neue Szenen integrieren – und das alles mit beeindruckender Geschwindigkeit und Qualität.

Das Wichtigste in Kürze – FLUX.1 Kontext im Überblick

- Multimodaler Input: FLUX.1 Kontext verarbeitet Text- und Bildaufforderungen und ermöglicht so eine intuitive In-Context-Bearbeitung.

- Kernfähigkeiten: Herausragende Charakterkonsistenz über mehrere Szenen hinweg, präzise lokale Bearbeitungen, Übertragung von Stilreferenzen und interaktive Geschwindigkeit.

- Iterative Workflows: Erlaubt schrittweise Verfeinerungen von Bildern über mehrere Bearbeitungsrunden bei minimaler Latenz und gleichbleibender Qualität.

- Modellvarianten: Verfügbar als FLUX.1 Kontext [pro] für schnelle iterative Bearbeitung, FLUX.1 Kontext [max] für maximale Performance und FLUX.1 Kontext [dev] als anpassbare Open-Weights-Variante (in privater Beta).

- Neue Benchmarks & Testumgebung: Einführung von KontextBench, einem realitätsnahen Benchmark, und dem FLUX Playground zum einfachen Testen der Modelle.

Was ist FLUX.1 Kontext und wer steckt dahinter?

FLUX.1 Kontext ist die neueste Entwicklung von Black Forest Labs (BFL), einem Unternehmen, das sich auf den Bau fortschrittlicher Modelle und Infrastrukturen für die Mediengenerierung spezialisiert hat. Die Kerninnovation von FLUX.1 Kontext liegt in der Vereinheitlichung von Text-zu-Bild-Generierung und komplexer Bild-zu-Bild-Bearbeitung innerhalb eines einzigen, leistungsstarken Systems. Anstatt separate Modelle für Generierung, Inpainting oder Stiltransfer zu benötigen, bietet FLUX.1 Kontext einen integrierten Ansatz.

Die Modelle basieren auf der Flow-Matching-Technologie, einer Methode zur Generierung von Daten, die darauf abzielt, einen einfachen Rauschvektor schrittweise in ein kohärentes Bild (oder andere Daten) zu transformieren, indem sie einem gelernten Vektorfeld folgen. Black Forest Labs hat diesen Ansatz für FLUX.1 Kontext erweitert, um die semantischen Informationen aus Text- und Bild-Inputs effektiv zu nutzen.

Die Technologie im Detail: Flow Matching und In-Context Learning

Um die Leistungsfähigkeit von FLUX.1 Kontext zu verstehen, müssen wir zwei Schlüsselkonzepte betrachten: Flow Matching und In-Context Learning im visuellen Bereich.

Flow Matching: Stell dir vor, du hast ein komplett verrauschtes Bild und möchtest es in ein klares Foto verwandeln. Flow-Matching-Modelle lernen, wie sie dieses Rauschen schrittweise reduzieren und strukturieren können, um das gewünschte Bild zu „formen“. Sie lernen einen „Fluss“ oder einen Pfad vom Rauschen zum Bild. FLUX.1 ist ein sogenannter „rectified flow transformer“, der im latenten Raum eines Bildautoencoders arbeitet. Das bedeutet, Bilder werden zuerst in eine kompaktere Repräsentation (Latents) umgewandelt, bevor der Transformationsprozess stattfindet. Für FLUX.1 Kontext wurde dieser Prozess so optimiert, dass er nicht nur Text, sondern auch die visuellen Informationen aus einem Referenzbild als „Wegweiser“ für den Fluss nutzen kann.

In-Context Learning für Bilder: Ähnlich wie große Sprachmodelle aus Beispielen im Prompt lernen können, ohne dass ihre internen Gewichte angepasst werden müssen, adaptiert FLUX.1 Kontext seine Ausgabe dynamisch an den bereitgestellten visuellen Kontext. Dies wird durch eine einfache, aber effektive Methode erreicht: Die latenten Token des Kontextbildes werden an die Token des Zielbildes angehängt und gemeinsam durch den visuellen Stream des Modells verarbeitet. Spezielle Positionseinbettungen (3D RoPE) sorgen dafür, dass das Modell zwischen Kontext- und Zielinformationen unterscheiden kann. Diese Architektur ermöglicht es, mit einem einzigen Modell sowohl lokale Bearbeitungen (wenn ein Kontextbild vorhanden ist) als auch die Generierung neuer Bilder von Grund auf (wenn kein Kontextbild vorhanden ist) durchzuführen.

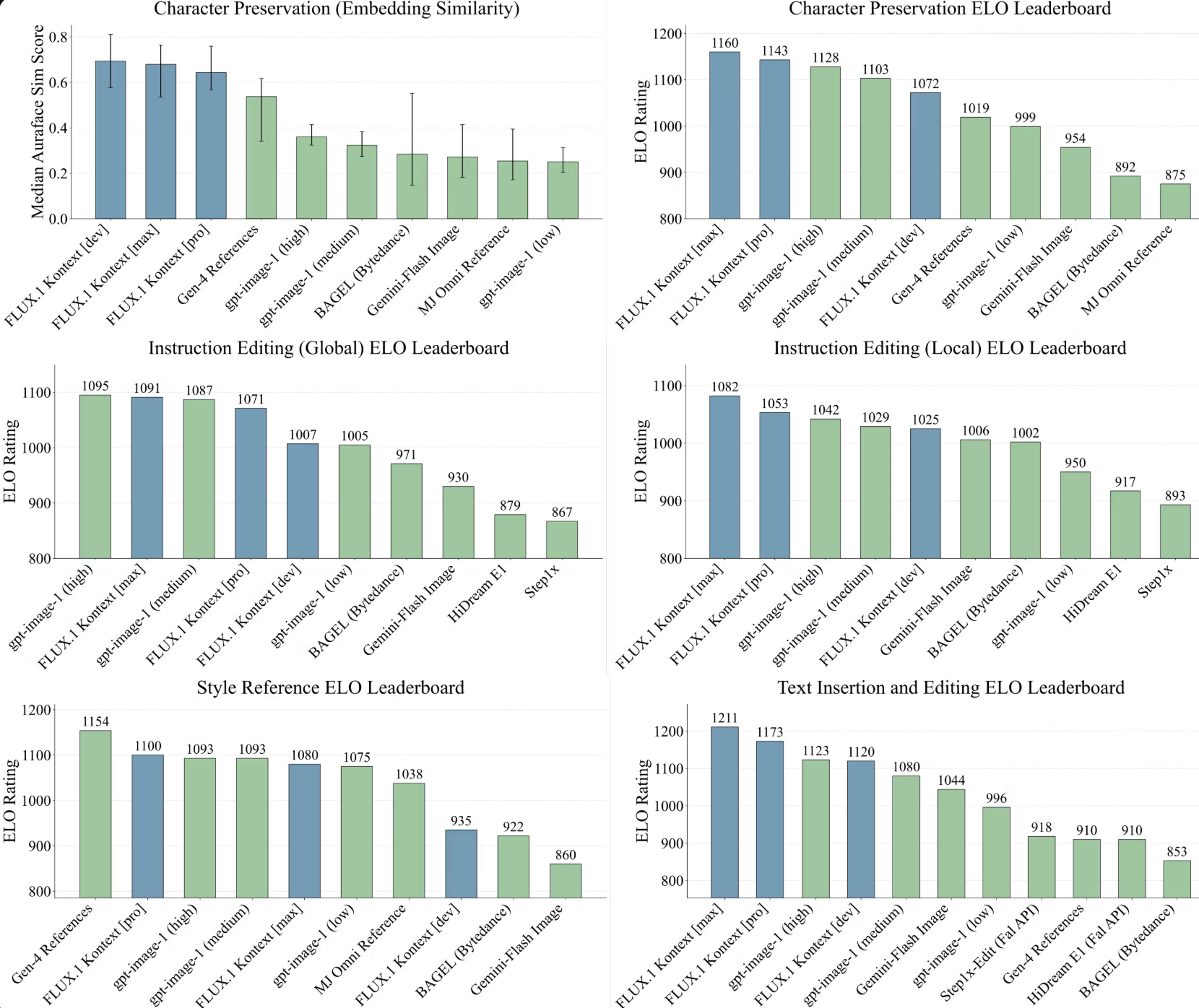

Überlegene Leistung: Die Ergebnisse von KontextBench

Um die Fähigkeiten von FLUX.1 Kontext objektiv zu bewerten und mit anderen State-of-the-Art-Systemen zu vergleichen, hat Black Forest Labs KontextBench eingeführt. Dieser neue Benchmark besteht aus 1026 einzigartigen Bild-Prompt-Paaren, die aus realen Anwendungsfällen von Nutzern stammen und 108 Basisbilder (persönliche Fotos, CC-lizenzierte Kunst, Public Domain Bilder, KI-generierte Inhalte) umfassen. KontextBench deckt fünf Kernaufgaben ab: lokale Instruktionsbearbeitung (416 Beispiele), globale Instruktionsbearbeitung (262), Textbearbeitung (92), Stilreferenz (63) und Charakterreferenz (193). Black Forest Labs argumentiert, dass bestehende Benchmarks oft inhärente Verzerrungen aufweisen oder nicht die volle Bandbreite moderner multimodaler Modelle abdecken.

Die Evaluationsergebnisse, die im technischen Bericht von Black Forest Labs präsentiert werden, zeigen, dass FLUX.1 Kontext [pro] und [max] in vielen Bereichen führend oder zumindest sehr konkurrenzfähig sind:

- Text Editing & Character Preservation: Hier erzielen die FLUX.1 Kontext Modelle die höchsten ELO-Ratings im Vergleich zu anderen Modellen. Die Fähigkeit, Text in Bildern präzise zu ändern oder Charaktere über verschiedene Bearbeitungen hinweg konsistent zu halten, ist ein signifikanter Vorteil. Die quantitative Messung der Charaktererhaltung mittels AuraFace-Embeddings bestätigt dies.

- Local Editing: Auch hier gehören die FLUX.1 Kontext Modelle zur Spitze.

- Global Editing & Style Reference: Bei globalen Bearbeitungen ist FLUX.1 Kontext laut Bericht nur gpt-image-1 unterlegen, bei Stilreferenzen nur Gen-4 References.

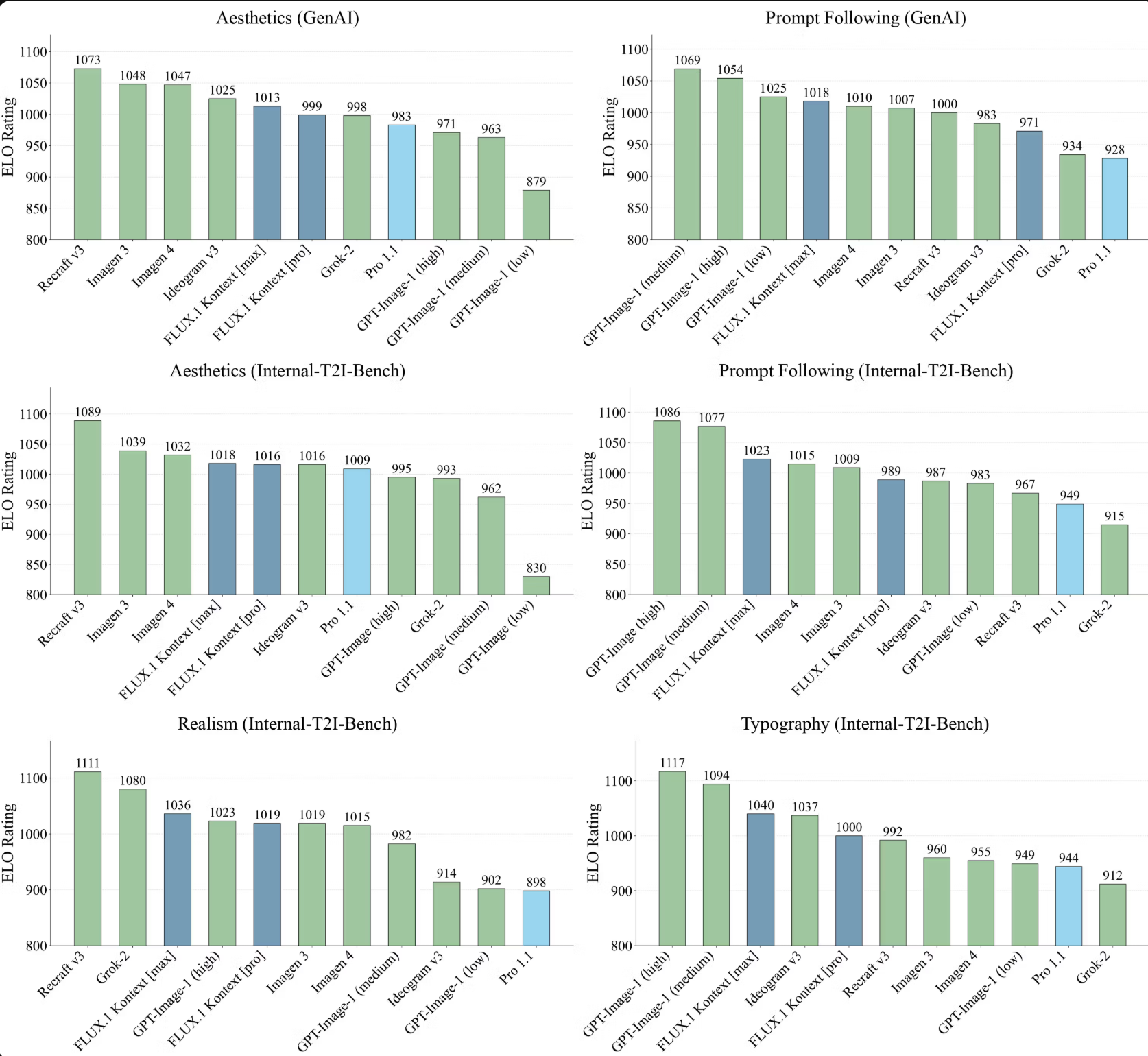

- Aesthetics, Prompt Following, Realism, Typography (Text-to-Image): Im reinen Text-zu-Bild-Modus zeigt FLUX.1 Kontext eine sehr ausgewogene Leistung über alle Kategorien hinweg. Während andere Modelle in Einzelkategorien besser sein mögen (z.B. Recraft bei Ästhetik), büßen diese oft in anderen Bereichen ein. FLUX.1 Kontext zielt darauf ab, einen „Sweet Spot“ ohne die oft kritisierte „Bakeyness“ (übertrieben gesättigte, homogene KI-Ästhetik) zu treffen.

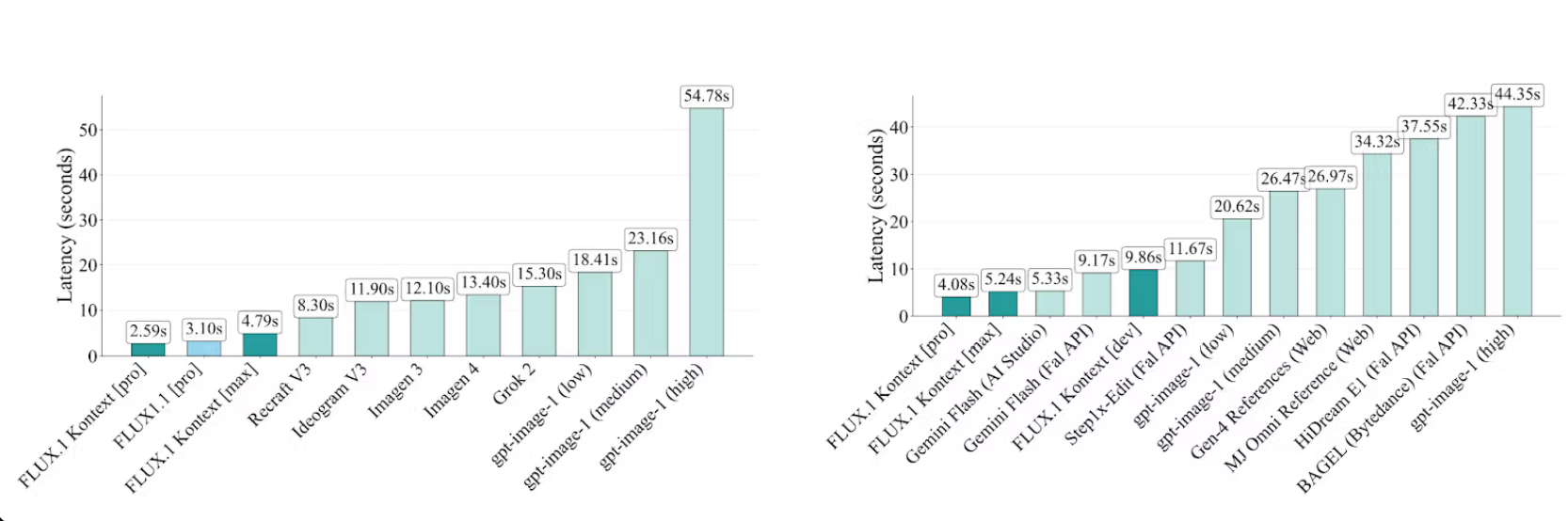

Geschwindigkeit als Schlüsselfaktor: Latenz im Vergleich

Ein entscheidender Vorteil der FLUX.1 Kontext Modelle ist ihre Geschwindigkeit. Sowohl bei der Text-zu-Bild-Generierung als auch bei der Bild-zu-Bild-Bearbeitung erreichen die Modelle beeindruckend niedrige Latenzzeiten. Für die Generierung eines 1024×1024 Bildes liegen die Zeiten oft zwischen 3-5 Sekunden.

Die von Black Forest Labs veröffentlichten Latenz-Benchmarks zeigen:

- Text-to-Image: FLUX.1 Kontext [pro] (2.59s) und FLUX.1 [pro] (3.10s) sind signifikant schneller als Konkurrenten wie Imagen 4 (12.10s) oder gpt-image-1 (low bei 15.30s, high bei 54.78s).

- Image-to-Image: Auch hier sind FLUX.1 Kontext [pro] (4.08s) und [max] (5.24s) an der Spitze, deutlich flotter als beispielsweise gpt-image-1 (low bei 11.67s, high bei 44.35s) oder Gemini Flash (AI Studio bei 5.33s, Fal API bei 9.17s).

Diese Geschwindigkeit ist nicht nur ein technisches Detail, sondern ermöglicht interaktive Anwendungen und schnelle iterative Designprozesse.

Die FLUX.1 Kontext Modelle im Detail: [pro], [max] und [dev]

Black Forest Labs bietet verschiedene Varianten von FLUX.1 Kontext an, um unterschiedlichen Bedürfnissen gerecht zu werden:

- FLUX.1 Kontext [pro]: Dieses Modell ist als Pionier für schnelle, iterative Bildbearbeitung positioniert. Es vereint lokale Bearbeitung, generative In-Context-Modifikationen und klassische Text-zu-Bild-Generierung. Es ist darauf ausgelegt, Charaktere, Identitäten, Stile und Merkmale über mehrere Bearbeitungsrunden hinweg konsistent zu halten – und das bis zu einer Größenordnung schneller als bisherige State-of-the-Art-Modelle. Der Preis liegt bei $0.04 pro Bild.

- FLUX.1 Kontext [max]: Als experimentelles Premium-Modell angekündigt, soll es eine stark verbesserte Prompt-Treue, Typografie-Generierung und hohe Konsistenz bei der Bearbeitung bieten, ohne Kompromisse bei der Geschwindigkeit einzugehen. Dieses Modell kostet $0.08 pro Bild.

- FLUX.1 Kontext [dev]: Dies ist eine Open-Weights-Variante (12B Diffusions-Transformator ), die für Forschungszwecke, Anpassungen und Sicherheitstests gedacht ist. Sie ist zunächst in einer privaten Beta verfügbar und soll später öffentlich über Partner wie FAL, Replicate und HuggingFace vertrieben werden. Für die [dev]-Variante wurde im Training ein exklusiver Fokus auf Bild-zu-Bild-Aufgaben gelegt.

Diese Staffelung erlaubt es sowohl kommerziellen Nutzern, die auf Performance und Zuverlässigkeit angewiesen sind, als auch der Forschungscommunity, von den Fortschritten zu profitieren.

Anwendungsfälle und Praxisbeispiele: Die Power von Kontext

Die wahre Stärke von FLUX.1 Kontext zeigt sich in den vielfältigen Anwendungsmöglichkeiten, die über einfache Bildgenerierung hinausgehen.

Iterative Workflows: Kreativität Schritt für Schritt

Die Fähigkeit, ein Bild über mehrere Schritte hinweg zu verfeinern, ohne dass dabei die Konsistenz von Charakteren oder Objekten verloren geht, ist ein echter Game-Changer. Black Forest Labs demonstriert dies eindrücklich:

- Storyboard-Generierung (PDF, Figure 1): Ein Vogel-Charakter wird von einer Szene zur nächsten iterativ weiterentwickelt – vom Barbesuch über die Verdopplung des Charakters bis hin zum Einkauf im Supermarkt oder dem Feiern eines Starts.

- Instruktionsbasierte Bearbeitung (PDF, Figure 2): Eine Person wird von einer Gesichtsverdeckung befreit, dann in eine andere Stadt (Freiburg) versetzt und schließlich in eine Schneelandschaft transformiert, wobei Charakter, Pose und Kleidung konsistent bleiben.

- Produktfotografie-Anpassung (PDF, Figure 13): Aus einer Schale wird eine passende Vase generiert, die dann farblich angepasst wird, während das Design und die Szene erhalten bleiben.

- Gesichtsausdruck ändern (PDF, Figure 14, Webseite): Der Kopf einer Person wird zur Kamera gedreht und ihr Ausdruck zu einem Lachen verändert, wobei Hintergrund und Kleidung konsistent bleiben.

Diese iterative Konsistenz, wie auch in AuraFace Similarity Tests (PDF, Figure 11) gezeigt, ist ein Bereich, in dem FLUX.1 Kontext laut BFL anderen Modellen überlegen ist, die oft unter „Visual Drift“ leiden, bei dem Charaktere ihre Identität verlieren.

So nutzt Du die iterative Bearbeitung mit FLUX.1 Kontext (Konzeptionell)

Obwohl die genaue Bedienoberfläche von den jeweiligen Partner-Integrationen abhängt, ist das Prinzip der iterativen Bearbeitung mit FLUX.1 Kontext wie folgt denkbar:

- Starte mit einem Bild: Lade ein eigenes Bild hoch oder generiere ein initiales Bild per Text-Prompt.

- Gib eine Bearbeitungsanweisung: Formuliere per Text, was du ändern möchtest (z.B. „Füge einen Hut hinzu“, „Ändere die Hintergrundfarbe zu blau“, „Lass die Person lächeln“).

- Erhalte das Ergebnis: FLUX.1 Kontext wendet die Änderung an und versucht dabei, den Rest des Bildes und die Identität der Elemente konsistent zu halten.

- Iteriere weiter: Nutze das bearbeitete Bild als neuen Input und gib weitere Anweisungen, um dein Bild schrittweise zu perfektionieren. Wiederhole dies, bis du mit dem Ergebnis zufrieden bist.

Dieser Prozess erlaubt eine sehr feingranulare Kontrolle und die Entwicklung komplexer Szenen oder Produktvarianten.

Weitere Spezialanwendungen

- Lokale Bearbeitung: Gezielte Veränderungen in bestimmten Bildbereichen, ohne den Rest zu beeinflussen (z.B. Farbe eines Autos ändern, Hintergrund austauschen).

- Stilreferenz (S-Ref): Übertrage den künstlerischen Stil eines Referenzbildes auf neu generierte Szenen, gesteuert durch Text-Prompts (PDF, Figure 5).

- Textbearbeitung in Bildern: Verfeinere Logos, korrigiere Rechtschreibfehler oder passe Textstile an, während der umgebende Kontext erhalten bleibt (PDF, Figure 12 [falsche Referenz im PDF, Figure 4 zeigt Textbearbeitung]; Webseite zeigt Beispiel mit „YOU HAD ME AT BEER“ zu „YOU HAD ME AT CONTEXT“).

- Produktfotografie (PDF, Figure 6): Extrahiere Objekte wie einen Rock, platziere sie auf einem weißen Hintergrund im Produktfotografie-Stil oder erstelle extreme Nahaufnahmen des Stoffes.

- Visuelle Hinweise (Visual Cues): Das Modell kann auch auf visuelle Hinweise wie rote Ellipsen oder geometrische Formen reagieren, um den Bearbeitungsprozess zu steuern (PDF, Figure 12).

Der FLUX Playground: Einfach lostesten!

Um Entwicklern und Interessierten einen unkomplizierten Zugang zu den fortschrittlichsten FLUX-Modellen zu ermöglichen, hat Black Forest Labs den FLUX Playground gestartet. Diese optimierte Benutzeroberfläche erlaubt das Testen der Modelle ohne technische Integration direkt im Browser unter https://playground.bfl.ai.

Der Playground dient dazu, Anwendungsfälle zu validieren, Funktionen zu demonstrieren und in Echtzeit mit der Bildgenerierung zu experimentieren. Er ist ein idealer Einstiegspunkt, um die Fähigkeiten von FLUX zu bewerten, bevor man sich für eine vollständige API-Implementierung entscheidet.

Erste Schritte mit dem FLUX Playground: So testest Du die Modelle

- Besuche die Webseite: Öffne

playground.bfl.aiin deinem Browser. - Modell auswählen (voraussichtlich): Wähle eines der verfügbaren FLUX.1 Kontext Modelle zum Testen aus.

- Input bereitstellen:

- Text-Prompt: Gib eine detaillierte Beschreibung dessen ein, was du generieren oder ändern möchtest.

- Bild-Upload (für In-Context): Lade ein Referenzbild hoch, wenn du eine Bearbeitung oder eine kontextbezogene Generierung durchführen willst.

- Generieren/Bearbeiten: Starte den Prozess.

- Ergebnis ansehen und iterieren: Betrachte das generierte Bild. Bist du nicht ganz zufrieden? Nutze das Ergebnis als neuen Input und verfeinere es mit weiteren Textanweisungen.

Der Playground ist ein mächtiges Werkzeug, um ein Gefühl für die Leistungsfähigkeit und die intuitive Bedienung von FLUX.1 Kontext zu bekommen.

Limitationen und zukünftige Entwicklungen

Trotz der beeindruckenden Fortschritte ist auch FLUX.1 Kontext nicht frei von Einschränkungen. Black Forest Labs nennt folgende Punkte:

- Artefakte bei exzessiven Multi-Turn-Edits: Sehr lange, iterative Bearbeitungssitzungen können visuelle Artefakte erzeugen, die die Bildqualität mindern (siehe PDF, Figure 10g oder Webseiten-Beispiel).

- Instruktionsbefolgung: Gelegentlich befolgt das Modell Anweisungen nicht präzise oder ignoriert spezifische Anforderungen im Prompt. Ein Beispiel ist das Hinzufügen von Milchschaum anstatt der Verschiebung einer Tasse (PDF, Figure 10e).

- Limitiertes Weltwissen: Die Fähigkeit des Modells, kontextuell akkurate Inhalte basierend auf spezifischem Weltwissen zu generieren, ist begrenzt.

- Distillationsartefakte: Der Prozess der Modelldestillation (wie bei FLUX.1 Kontext [dev] angewandt) kann gelegentlich visuelle Artefakte einführen.

- Identitätsverlust: In manchen Fällen kann es trotz der Verbesserungen zu einem Verlust der Charakteridentität kommen, besonders bei komplexen oder mehrdeutigen Prompts (PDF, Figure 10c).

Zukünftige Arbeiten sollen sich auf die Erweiterung für mehrere Eingabebilder, weitere Skalierung und die Reduzierung der Inferenzlatenz konzentrieren, um Echtzeitanwendungen zu ermöglichen. Auch die Ausweitung auf den Videobereich ist eine natürliche Fortsetzung. Ein Hauptziel bleibt die weitere Reduktion der Qualitätsminderung bei langen iterativen Bearbeitungen.

Black Forest Labs betont, dass die Veröffentlichung von FLUX.1 Kontext und KontextBench eine solide Grundlage und ein umfassendes Evaluationsframework darstellt, um die vereinheitlichte Bildgenerierung und -bearbeitung voranzutreiben. Als ein Zitat aus ihrer Mission: „Bei BFL ist unsere Mission, die fortschrittlichsten Modelle und Infrastrukturen für die Mediengenerierung zu bauen.“

Häufig gestellte Fragen – FLUX.1 Kontext

- Was ist Black Forest Labs FLUX.1 Kontext genau? FLUX.1 Kontext ist eine neue Suite von KI-Modellen, die sowohl Text- als auch Bild-Inputs versteht, um Bilder zu generieren und kontextbezogen zu bearbeiten. Es zeichnet sich durch hohe Charakterkonsistenz, schnelle Bearbeitung und iterative Verfeinerungsmöglichkeiten aus.

- Wie funktioniert die Bildbearbeitung mit FLUX.1 Kontext? Du kannst ein bestehendes Bild hochladen und per Textanweisung (Prompt) Änderungen vornehmen. Das Modell passt das Bild entsprechend an, wobei es versucht, den Stil und die Identität der Elemente beizubehalten. Dies kann schrittweise über mehrere Runden erfolgen.

- Welche Vorteile bietet FLUX.1 Kontext gegenüber anderen KI-Bildgeneratoren? Die Hauptvorteile sind die starke Konsistenz von Charakteren und Objekten über iterative Bearbeitungen, die sehr hohe Verarbeitungsgeschwindigkeit, die Fähigkeit zur echten In-Context-Bearbeitung (Verständnis von Bild-Prompts) und eine einheitliche Architektur für Generierung und Bearbeitung.

- Kann ich FLUX.1 Kontext kostenlos testen? Ja, über den FLUX Playground (

playground.bfl.ai) kannst du die fortschrittlichsten FLUX-Modelle direkt im Browser testen, ohne dass eine technische Integration oder API-Zugang nötig ist. - Für wen eignet sich FLUX.1 Kontext? FLUX.1 Kontext eignet sich für Kreativprofis, Designer, Marketing-Experten, Entwickler von KI-Anwendungen und jeden, der hochwertige Bilder schnell generieren oder präzise bearbeiten möchte. Die verschiedenen Modellvarianten ([pro], [max], [dev]) bedienen dabei unterschiedliche Anforderungen von kommerzieller Nutzung bis Forschung.

Fazit: FLUX.1 Kontext – Ein kraftvoller Schritt nach vorn in der KI-Bildbearbeitung

Mit FLUX.1 Kontext hat Black Forest Labs eindrucksvoll demonstriert, wie die Grenzen der KI-gestützten Bildgenerierung und -bearbeitung weiter verschoben werden können. Die Kombination aus Flow-Matching-Technologie und echtem In-Context-Verständnis für Text- und Bild-Prompts eröffnet eine neue Dimension der kreativen Kontrolle und Effizienz.

Besonders hervorzuheben sind die Fortschritte in der Charakterkonsistenz über iterative Bearbeitungsschritte hinweg – ein lang gehegter Wunsch vieler Anwender. Wenn das Modell hält, was die Benchmarks auf KontextBench versprechen, insbesondere in Bereichen wie Textbearbeitung und Charaktererhaltung, dann ist dies ein signifikanter Mehrwert. Die beeindruckende Geschwindigkeit ist nicht nur ein technisches Schmankerl, sondern der Schlüssel für wirklich interaktive und flüssige Arbeitsabläufe. Kreative können Ideen schneller visualisieren, verfeinern und anpassen, was den Designprozess erheblich beschleunigen dürfte.

Die Einführung des FLUX Playgrounds senkt die Einstiegshürde und lädt zum Experimentieren ein, während die Verfügbarkeit verschiedener Modellvarianten ([pro], [max], [dev]) sowohl kommerzielle als auch akademische Nutzer anspricht. Die transparente Kommunikation der Limitationen ist ebenfalls positiv zu bewerten und zeigt, dass man sich der aktuellen Herausforderungen bewusst ist.

Natürlich wird die Praxis zeigen müssen, wie robust und vielseitig sich FLUX.1 Kontext im Alltagseinsatz bei einer breiten Nutzerbasis bewährt. Die Fähigkeit, komplexe Anweisungen zuverlässig umzusetzen und auch bei sehr langen Bearbeitungsketten die Qualität hochzuhalten, wird entscheidend sein. Doch die vorgestellten Beispiele und Benchmark-Ergebnisse sind vielversprechend. FLUX.1 Kontext ist nicht nur eine Weiterentwicklung bestehender Ansätze, sondern ein intelligenter Versuch, die Lücke zwischen reiner Generierung und anspruchsvoller, kontextsensitiver Bearbeitung zu schließen. Für alle, die im Bereich der visuellen Content-Erstellung tätig sind, ist dies definitiv eine Technologie, die man im Auge behalten sollte. Die Reise der generativen Bildmodelle ist noch lange nicht zu Ende, und FLUX.1 Kontext setzt hier einen wichtigen Meilenstein für das Jahr 2025.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- [1] Black Forest Labs. (2025). FLUX.1 Kontext: Flow Matching for In-Context Image Generation and Editing in Latent Space [Technischer Bericht]. [PDF-Quelldokument]

- [2] Black Forest Labs. (2025, 29. Mai). Introducing FLUX.1 Kontext and the BFL Playground. bfl.ai. Abgerufen von https://bfl.ai/announcements/flux-1-kontext [Webseiten-Quelle]

- [3] Black Forest Labs. [@bfl_ml]. (2025, 29. Mai). Today we’re releasing FLUX.1 Kontext… [X Post]. Abgerufen von https://x.com/bfl_ml/status/1928143010811748863 [Social Media Quelle]

- [4] Black Forest Labs. (2025). Pricing API. bfl.ai. Abgerufen von https://bfl.ai/pricing/api [Webseiten-Quelle]

#KI #FLUX1Kontext #Bildbearbeitung #AI #GenerativeAI #BlackForestLabs #InContext #TechNews #KINEWS24