Stell dir vor, du könntest aus einem einzigen Bild und einfachen Befehlen eine dynamische, spielbare Welt erschaffen. Genau diese Vision rückt mit Hunyuan-GameCraft, einem bahnbrechenden KI-Framework von Tencent, in greifbare Nähe. Veröffentlicht im August 2025, setzt dieses System neue Maßstäbe für die KI-Videogenerierung und verspricht, die Art und Weise, wie wir interaktive Spielvideos erleben und entwickeln, grundlegend zu verändern. Es ist nicht nur ein weiteres Tool zur Videoerstellung, sondern eine hochentwickelte Brücke zwischen statischer Vorstellung und lebendiger, steuerbarer Interaktion.

Die Herausforderung bei der Generierung von Spielinhalten war bisher immer der Kompromiss zwischen visueller Qualität, physikalisch korrektem Verhalten, langfristiger Konsistenz und der Effizienz, die für eine Interaktion in Echtzeit notwendig ist. Bestehende Modelle stießen hier schnell an ihre Grenzen. Hunyuan-GameCraft wurde von Grund auf entwickelt, um genau diese Lücken zu schließen. Das Entwicklerteam von Tencent Hunyuan hat eine Lösung geschaffen, die auf einem riesigen Datensatz aus über 100 AAA-Spielen trainiert wurde und eine beispiellose Kontrolle und Realitätstreue ermöglicht. Es geht darum, dir die Werkzeuge an die Hand zu geben, um immersive Erlebnisse zu erschaffen, die sich nicht nur echt anfühlen, sondern auch direkt auf deine Aktionen reagieren.

Als gröter Gaming-Hersteller der Welt ist Tencent nicht erst seit dieser Neuigkeit aktiv: Am 28.7.2025 wurde Tencent Hunyuan3D veröffentlicht.

Das musst Du wissen – Die Highlights von Hunyuan-GameCraft auf einen Blick

- Einheitliche Steuerung: Hunyuan-GameCraft übersetzt Standard-Eingaben von Tastatur und Maus (W, A, S, D, Pfeiltasten etc.) in einen gemeinsamen, kontinuierlichen Kameraraum. Das Ergebnis ist eine unglaublich flüssige und intuitive Steuerung deiner generierten Spielwelt.

- Langfristige Konsistenz: Dank einer neuartigen Trainingsmethode, dem Hybrid History-Conditioned Training, merkt sich die KI vergangene Szenen. So bleiben generierte Videos auch über längere Zeiträume hinweg logisch und visuell konsistent, ohne dass die Welt plötzlich „vergisst“, wie sie aussah.

- Echtzeit-Performance: Durch eine clevere Technik namens Modelldestillation (PCM) wird die Generierungsgeschwindigkeit um das 10- bis 20-fache beschleunigt. Mit bis zu 6,6 Bildern pro Sekunde und Reaktionszeiten unter fünf Sekunden wird interaktive KI-Videogenerierung erstmals wirklich spielbar.

- Gigantischer Trainingsdatensatz: Die KI lernte von über einer Million Gameplay-Aufnahmen aus mehr als 100 AAA-Spielen wie Cyberpunk 2077 oder Red Dead Redemption. Das sorgt für eine enorme Vielfalt und hohe visuelle Qualität in den generierten Szenen.

- Open Source Verfügbarkeit: Das Framework ist quelloffen und für die meisten Anwendungsfälle kostenlos nutzbar, was Innovationen für Entwickler und Kreative weltweit zugänglich macht.

Was ist Hunyuan-GameCraft genau? Eine Revolution in der Videogenerierung

Hunyuan-GameCraft ist weit mehr als nur ein Text-zu-Video-Generator. Es ist ein umfassendes Framework, das darauf ausgelegt ist, aus einem einzigen Startbild und einer Reihe von Benutzerbefehlen hochdynamische und interaktive Videosequenzen zu erschaffen. Du gibst ein Bild vor – sei es eine ländliche Landschaft, eine städtische Szene oder ein Fantasy-Setting – und steuerst dann mit Tastatur und Maus, wie sich die „Kamera“ durch diese Welt bewegt. Die KI generiert daraufhin in Echtzeit die passenden Videoframes und schafft so die Illusion, du würdest dich durch eine echte Spielumgebung bewegen.

Der Kern des Systems basiert auf dem leistungsstarken Text-zu-Video-Modell HunyuanVideo, wurde aber entscheidend erweitert, um die spezifischen Anforderungen von interaktiven Spielszenarien zu erfüllen. Das Ziel ist es, die Kluft zwischen passiver Videogenerierung und aktivem Gameplay zu überbrücken und Entwicklern wie auch Kreativen ein Werkzeug zu bieten, mit dem sie schnell Prototypen erstellen, virtuelle Welten erkunden oder einfach nur beeindruckende, dynamische Szenen gestalten können.

Die technologische Magie: Wie Hunyuan-GameCraft funktioniert

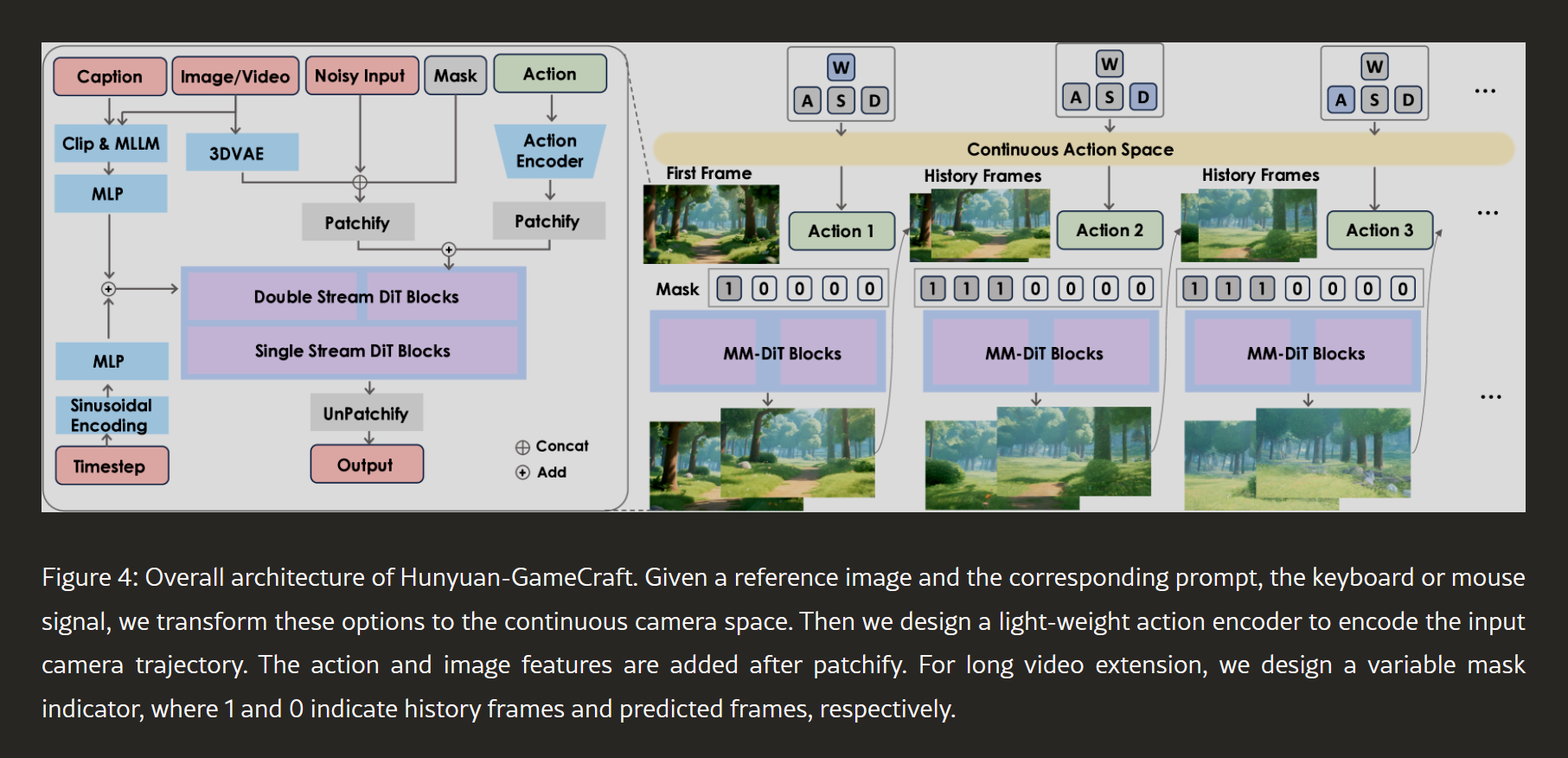

Der beeindruckende Funktionsumfang von Hunyuan-GameCraft beruht auf drei zentralen technologischen Säulen, die perfekt ineinandergreifen, um ein flüssiges und konsistentes Erlebnis zu gewährleisten.

Einheitliche Steuerung: Die Brücke zwischen Dir und der Spielwelt

Eines der größten Hindernisse für interaktive KI-Videos war bisher die starre und oft unnatürliche Steuerung. Hunyuan-GameCraft löst dieses Problem auf elegante Weise. Anstatt einzelne Tastenanschläge (wie ‚W‘ für vorwärts) direkt zu verarbeiten, werden alle Eingaben von Tastatur und Maus in einen gemeinsamen, kontinuierlichen „Kamera-Repräsentationsraum“ übersetzt.

Das bedeutet, die KI versteht nicht nur „gehe vorwärts“, sondern kann auch feinste Nuancen wie Bewegungsgeschwindigkeit, Kameraneigung und sanfte Richtungswechsel verarbeiten. Die diskreten Befehle werden in einen kontinuierlichen Aktionsraum überführt, der durch Parameter wie Translations- und Rotationsrichtung (dtrans,drot) sowie Geschwindigkeit (α,β) definiert ist. Dies ermöglicht fließende Übergänge zwischen verschiedenen Bewegungen und eine Steuerung, die sich natürlich und direkt anfühlt – fast wie in einem echten Videospiel.

Das Gedächtnis der KI: Hybrid History-Conditioned Training

Ein bekanntes Problem bei der autoregressiven Videogenerierung ist der „Szenenkollaps“: Nach einigen generierten Frames vergisst das Modell den ursprünglichen Kontext, was zu visuellen Fehlern und Inkonsistenzen führt. Um das zu verhindern, nutzt Hunyuan-GameCraft eine innovative Trainingsstrategie.

Das Hybrid History-Conditioned Training sorgt dafür, dass die KI bei der Erstellung neuer Videosegmente stets den bisherigen Verlauf berücksichtigt. Sie behält quasi ein Gedächtnis an die vorherigen Frames. Während des Trainings wird das Modell mit drei verschiedenen Szenarien konfrontiert, um sowohl Stabilität als auch Reaktionsfähigkeit zu optimieren:

- Generierung aus einem Einzelbild (25 % des Trainings): Für den Start einer neuen Szene.

- Fortsetzung eines kurzen Clips (70 % des Trainings): Der häufigste Fall, um Konsistenz zu wahren.

- Erweiterung längerer Videos (5 % des Trainings): Um die Langzeitstabilität zu gewährleisten.

Dieser Mix stellt sicher, dass das Modell sowohl auf neue Befehle präzise reagiert, als auch die 3D-Kohärenz und die visuellen Details der Szene über einen langen Zeitraum beibehält.

Echtzeit-Performance dank Modelldestillation (PCM)

Was nützt die beste Grafik, wenn die Interaktion quälend langsam ist? Um eine spielbare Erfahrung zu ermöglichen, implementiert Hunyuan-GameCraft eine Modelldestillation basierend auf dem Phased Consistency Model (PCM). Diese Technik komprimiert den aufwändigen Diffusionsprozess, der normalerweise viele Berechnungsschritte erfordert, in ein kompaktes Modell mit nur acht Schritten.

Das Ergebnis ist eine Beschleunigung um den Faktor 10 bis 20. Das System erreicht dadurch eine Inferenzgeschwindigkeit von 6,6 Bildern pro Sekunde (FPS) auf entsprechender Hardware. Die Latenz von der Eingabe bis zur visuellen Ausgabe sinkt auf unter fünf Sekunden, was Hunyuan-GameCraft zu einem der ersten Frameworks macht, das sich für den Echtzeit-Einsatz in komplexen interaktiven Umgebungen eignet.

Daten, Training & Leistung: Die Kraft hinter der KI

Die beeindruckenden Fähigkeiten von Hunyuan-GameCraft sind das Resultat eines massiven Trainingsaufwands auf einem extrem vielfältigen Datensatz.

Ein Universum an Trainingsdaten: Über 100 AAA-Spiele

Die Grundlage für die hohe visuelle Qualität und das breite stilistische Spektrum bildet ein Datensatz aus über einer Million Gameplay-Aufnahmen. Diese stammen aus mehr als 100 grafisch aufwendigen AAA-Spielen, darunter Titel wie Cyberpunk 2077, die Red Dead Redemption-Reihe und die Assassin’s Creed-Serie. Ergänzt wurde dieser riesige Fundus an realem Gameplay durch etwa 3.000 hochqualitative, synthetisch gerenderte Bewegungssequenzen, um die Präzision bei Kamerabewegungen weiter zu verbessern. Das Training fand auf einem Supercomputer mit 192 NVIDIA H20 GPUs über 50.000 Iterationen statt.

Performance im Vergleich: Wie schlägt sich das Modell?

In quantitativen Vergleichen stellt Hunyuan-GameCraft bestehende Modelle deutlich in den Schatten.

| Metrik | Hunyuan-GameCraft | Matrix-Game | CameraCtrl/MotionCtrl |

| Interaktionsfehler (RPE) | Sehr gering (0.08 trans / 0.20 rot) | 55 % höher | Höher |

| Video-Realismus (FVD) | 1554.2 (Bester Wert) | 2260.7 | Höher |

| Dynamik (Dynamic Average) | 67.2 (Höchster Wert) | 31.7 | Niedriger |

| Temporale Konsistenz | 0.95 (Exzellent) | 0.94 | Geringer |

Diese datengestützten Ergebnisse zeigen, dass Hunyuan-GameCraft nicht nur eine höhere visuelle Qualität und Dynamik liefert, sondern auch die Steuerungssignale des Nutzers deutlich präziser umsetzt. Insbesondere im Vergleich zum bisherigen State-of-the-Art-Modell Matrix-Game konnte der Interaktionsfehler um satte 55 % reduziert werden.

Anwendungsfälle und kreative Möglichkeiten

Die Einsatzmöglichkeiten von Hunyuan-GameCraft sind enorm und gehen weit über reine Gaming-Szenarien hinaus.

- Rapid Game Prototyping: Entwickler können in Minuten spielbare Prototypen aus Konzeptzeichnungen erstellen und das Spielgefühl testen, lange bevor ein einziges 3D-Asset erstellt wurde.

- Virtuelle Welten (VR/AR): Das Framework kann dynamische und explorable Umgebungen für Virtual- und Augmented-Reality-Anwendungen generieren.

- Simulation und Training: Von Fahrsimulatoren bis hin zu Trainingseinheiten in virtuellen Umgebungen können realistische Szenarien schnell erstellt und angepasst werden.

- Film und Spezialeffekte: Regisseure und VFX-Künstler können schnell Pre-Visualisierungen von komplexen Kameraschwenks in computergenerierten Umgebungen erstellen.

Zugänglichkeit: Systemanforderungen und Lizenzierung

Um die Leistungsfähigkeit von Hunyuan-GameCraft nutzen zu können, ist potente Hardware erforderlich.

Was Dein Rechner braucht: Die Hardware-Anforderungen

- Mindestanforderung: Eine NVIDIA-GPU mit CUDA-Unterstützung und mindestens 24 GB VRAM. Die Performance wird hier jedoch eingeschränkt sein.

- Empfohlene Hardware: Für eine optimale Qualität und Geschwindigkeit wird eine GPU mit 80 GB VRAM (z.B. NVIDIA A100 oder H100) empfohlen. Auch eine RTX 4090 kann für bestimmte Versionen des Modells ausreichend sein.

- Betriebssystem: Das System wurde primär für Linux entwickelt und getestet.

Open Source mit Bedingungen: Das Lizenzmodell

Tencent stellt Hunyuan-GameCraft als Open-Source-Projekt zur Verfügung, was es für eine breite Masse zugänglich macht. Die Lizenz erlaubt die kostenlose kommerzielle Nutzung für Unternehmen und Einzelpersonen mit weniger als 100 Millionen monatlich aktiven Nutzern. Größere Unternehmen müssen eine explizite Genehmigung von Tencent einholen. Es gibt jedoch eine wichtige Einschränkung: Die aktuelle Lizenz schließt eine Nutzung in der Europäischen Union, dem Vereinigten Königreich und Südkorea aus.

Hunyuan-GameCraft in der Praxis: So nutzt Du das Framework

Theorie ist das eine, aber wie sieht die Anwendung in der Praxis aus? Obwohl das Framework komplex ist, lässt sich der grundlegende Workflow in fünf klare Schritte unterteilen, um von einer Idee zu einem interaktiven Video zu gelangen.

- Schritt 1: Umgebung einrichten Zuerst musst Du die Entwicklungsumgebung aufsetzen. Das bedeutet, das offizielle GitHub-Repository zu klonen, eine passende Conda-Umgebung mit Python 3.10 zu erstellen und alle erforderlichen Abhängigkeiten wie PyTorch und Flash-Attention zu installieren. Stelle sicher, dass Deine CUDA-Treiber auf dem neuesten Stand sind und die Hardware die Mindestanforderungen erfüllt.

- Schritt 2: Input vorbereiten Die Basis für jede Generierung ist ein hochauflösendes Referenzbild und ein passender Text-Prompt. Das Bild gibt den visuellen Stil, die Objekte und die Atmosphäre der Szene vor. Der Prompt kann zusätzliche Details beschreiben oder die Stimmung verfeinern. Wähle beides sorgfältig aus, da sie die Qualität des Endergebnisses maßgeblich beeinflussen.

- Schritt 3: Steuerung und Kamera konfigurieren Jetzt definierst Du die gewünschte Aktionssequenz. Dies geschieht durch eine Abfolge von Befehlen, die den Tastatur- (W, A, S, D etc.) oder Mausbewegungen entsprechen. Du kannst auch Kameraparameter wie Bewegungsgeschwindigkeit oder die Länge der generierten Videosegmente (Chunks) festlegen. Das System wandelt diese diskreten Befehle automatisch in die kontinuierliche Kamerasteuerung um.

- Schritt 4: Den Generierungsprozess starten Mit allen vorbereiteten Inputs führst Du das Generierungsskript aus. Die KI beginnt nun, basierend auf dem Startbild und dem ersten Steuerbefehl, das erste Videosegment zu rendern. Anschließend wird der Prozess autoregressiv fortgesetzt: Das Ende eines Segments dient als Anfang des nächsten, wobei die KI stets die neuen Steuerbefehle berücksichtigt.

- Schritt 5: Ergebnis prüfen und verwenden Das Ergebnis ist eine Videodatei, die Deine interaktive Reise durch die generierte Welt zeigt. Du kannst die Sequenz prüfen, ob sie Deinen Vorstellungen entspricht, und sie für Prototypen, Präsentationen oder als Grundlage für weitere kreative Projekte verwenden.

Vor- und Nachteile im Überblick: Eine ehrliche Einordnung

Keine Technologie ist perfekt. Für eine fundierte Bewertung ist es entscheidend, die Stärken und Schwächen von Hunyuan-GameCraft klar zu benennen.

| Vorteile (Pros) ✅ | Nachteile (Cons) ❌ |

| Überlegene Steuerungspräzision: Die einheitliche Steuerung ermöglicht eine extrem natürliche und reaktionsschnelle Interaktion. | Enorme Hardware-Anforderungen: Ohne eine High-End-GPU (mind. 24GB, empfohlen 80GB VRAM) ist das System kaum nutzbar. |

| Exzellente Langzeitkonsistenz: Das Hybrid-Training verhindert effektiv den „Szenenkollaps“ und bewahrt die visuelle Kohärenz. | Komplexes Setup: Die Installation und Konfiguration erfordern technisches Fachwissen und sind nicht anfängerfreundlich. |

| Echtzeit-Fähigkeit: Dank Modelldestillation ist die Generierung schnell genug für eine spielbare, interaktive Erfahrung. | Eingeschränkter Funktionsumfang: Der Fokus liegt auf der Erkundung. Komplexe Spielmechaniken wie Kämpfe oder Objektinteraktionen werden noch nicht unterstützt. |

| Vielfältige visuelle Qualität: Das Training mit über 100 AAA-Spielen sorgt für eine beeindruckende stilistische Bandbreite und Detailtreue. | Abhängigkeit von der Input-Qualität: Die Ergebnisse sind nur so gut wie das Referenzbild und der Text-Prompt. |

| Open Source & Zugänglich: Die quelloffene Lizenz fördert die Innovation und ermöglicht vielen Entwicklern den kostenlosen Zugang. | Lizenzrechtliche Einschränkungen: Die Nutzung ist derzeit in der EU, dem Vereinigten Königreich und Südkorea ausgeschlossen. |

Häufig gestellte Fragen (FAQ) zu Hunyuan-GameCraft

Hier beantworten wir die wichtigsten Fragen, die im Zusammenhang mit Tencents innovativem Framework immer wieder aufkommen.

Wofür wird Hunyuan-GameCraft hauptsächlich verwendet? Der primäre Anwendungsfall ist die Erstellung von hochdynamischen, interaktiven Erkundungsvideos aus einem einzigen Bild. Es eignet sich perfekt für das schnelle Prototyping von Spielwelten, die Erstellung von virtuellen Umgebungen für VR/AR und die Generierung von dynamischen Szenen für Film-Pre-Visualisierungen.

Wie genau funktioniert die Steuerung? Die KI wandelt Standard-Eingaben von Tastatur (W, A, S, D, Pfeiltasten) und Maus in einen kontinuierlichen 3D-Kameraraum um. Anstatt starrer Befehle versteht das System fließende Bewegungen, Geschwindigkeitsänderungen und sanfte Kameraschwenks, was zu einem sehr natürlichen und immersiven Gefühl führt.

Kann das System sowohl First-Person- als auch Third-Person-Perspektiven generieren? Ja. Obwohl viele der Beispiele eine First-Person-Sicht zeigen, ist das Framework flexibel genug, um durch entsprechende Prompts und Kamerakonfigurationen auch Third-Person-Szenarien zu generieren. Die Steuerung der Kamera ist vom Charakter unabhängig.

Ist die Generierung wirklich in „Echtzeit“ möglich? Ja, im Sinne von „spielbarer Interaktion“. Dank der PCM-Beschleunigung liegt die Latenz von der Eingabe bis zur Anzeige des nächsten Videosegments bei unter fünf Sekunden. Mit 6,6 FPS ist es zwar keine flüssige Gaming-Erfahrung wie bei 60 FPS, aber schnell genug, um Entscheidungen zu treffen und die Welt reaktiv zu erkunden.

Was sind aktuell die größten Einschränkungen des Modells? Die zwei größten Hürden sind die extrem hohen Hardwareanforderungen, die es für viele Nutzer unzugänglich machen, und die Beschränkung auf reine Navigation. Die KI generiert derzeit keine komplexen Events, NPCs, Partikeleffekte oder physikalischen Interaktionen mit Objekten.

Hunyuan-GameCraft – In der Übersicht

| GameNGen [26] | GameGenX [5] | Oasis [8] | Matrix [10] | Genie 2 [22] | GameFactory [34] | Matrix-Game [36] | Hunyuan-GameCraft | |

| Game Sources | DOOM | AAA Games | Minecraft | AAA Games | Unknown | Minecraft | Minecraft | AAA Games |

| Resolution | 240p | 720p | 640×360 | 720p | 720p | 640×360 | 720p | 720p |

| Action Space | Key | Instruction | Key + Mouse | 4 Keys | Key+Mouse | 7 Keys+Mouse | 7 Keys+Mouse | Continous |

| Scene Generalizable | ✗ | ✗ | ✗ | ✔ | ✔ | ✔ | ✔ | ✔ |

| Scene Dynamic | ✔ | ✔ | ✗ | ✔ | ✗ | ✔ | ✗ | ✔ |

| Scene Memory | ✗ | ✗ | ✗ | ✗ | ✗ | ✗ | ✔ | ✔ |

Table 1:Comparison with recent interactive game models. Hunyuan-GameCraft serves as a model capable of generating infinitely long game videos conditioned on continuous action signals, while maintaining strong generalization, high temporal dynamics, and effective preservation of historical scene information.

Fazit: Der nächste Schritt für interaktive KI-Welten

Hunyuan-GameCraft ist mehr als nur ein technischer Durchbruch; es ist ein entscheidender Schritt in Richtung einer Zukunft, in der die Grenzen zwischen der Erstellung und dem Erleben digitaler Inhalte verschwimmen. Durch die intelligente Kombination aus einem einheitlichen Steuerungssystem, dem innovativen Hybrid History-Conditioned Training für langfristige Konsistenz und der Echtzeit-Performance durch Modelldestillation löst Tencent einige der hartnäckigsten Probleme der KI-Videogenerierung. Das Framework demonstriert eindrucksvoll, was möglich ist, wenn massive Datenmengen auf eine durchdachte Architektur treffen.

Obwohl die Technologie noch in den Kinderschuhen steckt und sich vorerst auf die Erkundung von Umgebungen konzentriert, ist das Potenzial gewaltig. Zukünftige Versionen könnten komplexere Interaktionen wie Objektmanipulation, Charaktersteuerung oder physikbasierte Ereignisse integrieren. Für Entwickler, Kreative und Gamer markiert Hunyuan-GameCraft den Beginn einer neuen Ära, in der das Erschaffen interaktiver Welten so einfach sein könnte wie das Beschreiben einer Idee und das Drücken einiger Tasten. Es ist zweifellos eines der spannendsten Projekte im Bereich der generativen KI des Jahres 2025.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Li, J. et al. (2025). Hunyuan-GameCraft: High-dynamic Interactive Game Video Generation with Hybrid History Condition. arXiv. Verfügbar unter: https://arxiv.org/html/2506.17201v1

- HunyuanGameCraft.org (2025). Hunyuan Gamecraft. Verfügbar unter: https://hunyuangamecraft.org/

#KI #AI #ArtificialIntelligence #KuenstlicheIntelligenz #HunyuanGameCraft #GameDev #Tencent #Videogenerierung, Hunyuan-GameCraft