Stell dir vor, ein kleines Sprachmodell mit 14 Milliarden Parametern übertrifft plötzlich Schwergewichte wie OpenAI-O1 oder Modelle mit über 30 Milliarden Parametern. Klingt unmöglich? Eine bahnbrechende Studie der Zhejiang University und der Ant Group stellt genau das unter Beweis. Ihre Methode, die Merge-of-Thought Distillation (MoT), löst ein fundamentales Problem im KI-Training und könnte die Art und Weise, wie wir leistungsstarke und effiziente KI entwickeln, für immer verändern.

Wir tauchen tief in diese revolutionäre Technik ein, erklären dir, wie sie funktioniert, und zeigen, warum der Konsens mehrerer KI-Lehrer weitaus mächtiger ist als die Weisheit eines einzigen Orakels. Du erfährst, wie mit nur rund 200 hochwertigen Beispielen erstaunliche Leistungssteigerungen erzielt werden, die bisher undenkbar schienen. Mach dich bereit für den nächsten großen Sprung in der KI-Effizienz.

Merge-of-Thought Distillation – Das Wichtigste in Kürze

- Neuartige Methode: Merge-of-Thought Distillation (MoT) ist ein Framework, das das Wissen und die Denkprozesse (Chain-of-Thought) von mehreren „Lehrer“-KIs in einem einzigen, kleineren „Schüler“-Modell vereint.

- Genialer Prozess: MoT wechselt iterativ zwischen zwei Phasen: (1) spezialisiertes Training des Schülers durch jeden Lehrer einzeln und (2) anschließende Verschmelzung der Parameter dieser trainierten Schüler-Varianten.

- Spektakuläre Ergebnisse: Ein mit MoT trainiertes Qwen3-14B-Modell übertrifft etablierte Größen wie DEEPSEEK-R1, QWEN3-32B und sogar OPENAI-O1 in anspruchsvollen Mathematik-Benchmarks.

- Maximale Effizienz: Die Methode benötigt nur einen winzigen Datensatz von etwa 200 hochwertigen Beispielen, um diese signifikanten Leistungssteigerungen zu erzielen.

- Löst Schlüsselprobleme: MoT umgeht die aufwändige Suche nach dem „perfekten“ Lehrer, reduziert „katastrophales Vergessen“ (Wissensverlust) und verbessert das allgemeine logische Denken des Modells.

Das „Bester-Lehrer“-Dilemma: Warum eine KI allein nicht ausreicht

Bisher ging man im Bereich der Reasoning Distillation – dem Prozess, bei dem eine kleinere KI (Schüler) von einer größeren (Lehrer) lernt, komplexe Probleme zu lösen – von einem einzigen, überlegenen „Orakel“-Lehrer aus. Die Idee: Das stärkste verfügbare Modell muss auch der beste Lehrer sein. Doch die Forscher um Zhanming Shen decken auf, dass diese Annahme ein Trugschluss ist.

Ihre Analyse zeigt deutlich:

- Kein universeller Lehrer: Verschiedene Schülermodelle haben unterschiedliche „beste“ Lehrer. Was für ein Qwen3-8B-Modell optimal ist, funktioniert für ein 14B-Modell möglicherweise schlechter.

- Abhängigkeit vom Datensatz: Selbst für dasselbe Schülermodell kann der beste Lehrer je nach Art der Trainingsdaten variieren.

Dieses Dilemma zwingt Entwickler zu einem kostspieligen und zeitaufwändigen Auswahlprozess. Anstatt sich auf einen einzigen, vermeintlich perfekten Lehrer zu verlassen, stellt MoT die entscheidende Frage: „Warum nicht die Stärken aller Lehrer vereinen?“

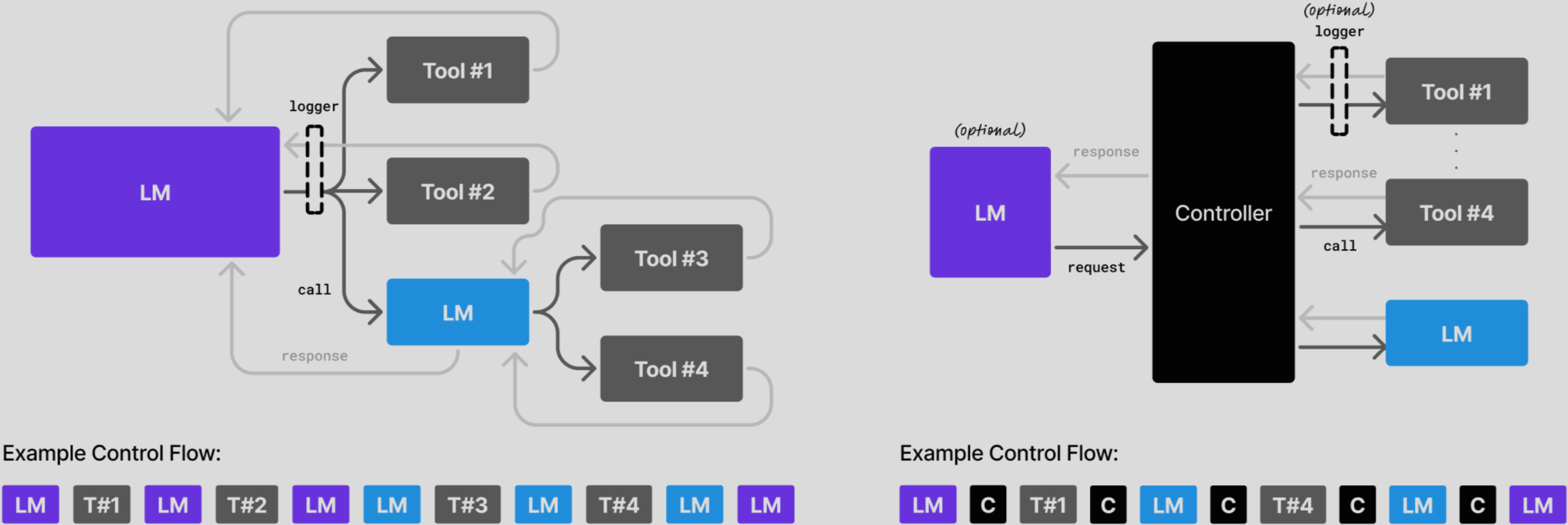

So funktioniert MoT: Der 3-Schritte-Prozess im Detail

Merge-of-Thought Distillation ist ein eleganter und ressourcenschonender Prozess, der die besten Denkpfade (Chain-of-Thought, CoT) aus verschiedenen Quellen herausfiltert und verstärkt. Stell es dir wie einen Elitestudenten vor, der nicht nur von einem Professor lernt, sondern die einzigartigen Methoden von vier verschiedenen Experten internalisiert und zu einer überlegenen Strategie verschmilzt.

Der Prozess läuft in iterativen Runden ab:

Schritt 1: Paralleles Training (Branch Training)

Ausgehend von einem Basis-Schülermodell (z. B. Qwen3-14B) werden mehrere identische Kopien, sogenannte „Branches“, erstellt – eine für jeden Lehrer. Jeder Branch wird nun exklusiv auf dem Datensatz trainiert, der von seinem zugewiesenen Lehrer (z. B. QWEN3-32B, DEEPSEEK-R1 etc.) generiert wurde. In dieser Phase lernt jeder Schüler-Branch den spezifischen „Denkstil“ seines Lehrers.

- Ziel: Internalisiere die einzigartigen Lösungswege jedes Lehrers.

- Mathematisch ausgedrückt: Für jeden Lehrer k wird der Schüler θ optimiert, indem der Fehler L_SFT(k) auf dessen Datensatz D(k) minimiert wird.

Schritt 2: Fusion der Gewichte (Weight Merge)

Nachdem jeder Branch für eine bestimmte Anzahl von Schritten trainiert wurde, geschieht die eigentliche Magie. Die Parameter (Gewichte) aller Schüler-Varianten werden im „Weight Space“ einfach mathematisch gemittelt.

- Ziel: Gemeinsamkeiten verstärken, Eigenheiten und Rauschen abschwächen.

- Die Formel: Das neue, fusionierte Modell θ(t) ist der Durchschnitt aller trainierten Branches: θ(t)=K1∑_k=1Kθ(t,k).

Dieser Fusionsschritt ist entscheidend. Er destilliert den Konsens im Denken der Lehrer. Lösungsstrategien, die von mehreren Lehrern favorisiert werden, werden im fusionierten Modell verstärkt. Individuelle Fehler, seltsame Formulierungen oder irrelevante Schritte eines einzelnen Lehrers werden hingegen abgeschwächt, da sie in den anderen Branches keine Entsprechung finden.

Schritt 3: Iteration

Das in Schritt 2 erstellte, fusionierte Modell dient als neuer Startpunkt für die nächste Runde. Der gesamte Prozess aus parallelem Training und Fusion wird mehrfach wiederholt (in der Studie 5 Runden). Mit jeder Runde konvergiert das Schülermodell weiter in Richtung einer robusten, verallgemeinerten Denkfähigkeit, die die Stärken aller Lehrer vereint.

MoT vs. Standard-Methoden: Ein direkter Vergleich

Um die Überlegenheit von MoT zu beweisen, verglichen die Forscher ihre Methode mit zwei etablierten Ansätzen: Single-Teacher Distillation (STD) und Multi-Teacher Distillation (MTD).

| Dimension | Single-Teacher Distillation (STD) | Multi-Teacher Distillation (MTD) | Merge-of-Thought Distillation (MoT) |

| Ansatz | Ein Schüler lernt von einem einzigen, ausgewählten Lehrer. | Ein Schüler lernt von einem großen Datensatz, der die Daten aller Lehrer vereint. | Ein Schüler lernt parallel von allen Lehrern, die Modelle werden periodisch verschmolzen. |

| Vorteil | Einfach umzusetzen. | Nutzt mehr Datenvielfalt. | Filtert Konsens heraus, reduziert Rauschen. |

| Nachteil | Risiko der falschen Lehrerwahl, „Teacher Style Signature“ wird kopiert. | Konflikte und „Rauschen“ von unterschiedlichen Lehrern können sich gegenseitig stören. | Etwas komplexere Trainings-Pipeline. |

| Ergebnis | Oft gut, aber selten optimal. | Leistung stagniert oder sinkt bei größeren Schülern. | Übertrifft konsistent STD und MTD in fast allen Szenarien. |

Die Ergebnisse aus Tabelle 2 der Studie sind eindeutig: Während MTD (das naive Mischen der Daten) bei kleineren Modellen noch Vorteile bringt, versagt es bei größeren Modellen, da diese anfälliger für die widersprüchlichen Signale der Lehrer sind. MoT hingegen skaliert exzellent und erzielt durch die intelligente Fusion stets die besten Resultate.

Die beeindruckenden Ergebnisse: Wie ein 14B-Modell die Großen schlägt

Die Leistungsdaten sind der beeindruckendste Beweis für die Effektivität von MoT. Trainiert auf dem S1K-200 Datensatz (nur 200 Beispiele!), erreicht das Qwen3-14B + MoT Modell einen durchschnittlichen AIME-Score von 78.65.

Damit übertrifft es:

- DEEPSEEK-R1 (74.90)

- QWEN3-30B-A3B (75.77)

- QWEN3-32B (76.77)

- OPENAI-O1 (76.75)

Ein Modell mit weniger als der Hälfte der Parameter schlägt etablierte Giganten – ein Meilenstein für die Effizienz. Selbst das 30B-Modell, trainiert mit MoT, erreicht einen Score von 80.63, was eine massive Steigerung von fast 5 Punkten gegenüber seiner Basisversion darstellt.

Stolpersteine im KI-Training, die MoT aus dem Weg räumt

Neben der reinen Leistungssteigerung löst MoT weitere kritische Probleme des modernen KI-Trainings:

- Unterdrückung von Overfitting: Die Analysen zeigen, dass Standard-Training (STD) oft zu einem frühen Leistungshöhepunkt führt, gefolgt von einer Verschlechterung durch Overfitting. MoT hingegen erreicht ein höheres Leistungsplateau und hält dieses stabil, selbst bei fortgesetztem Training. Der Trainingsverlust bleibt höher, die reale Leistung aber auch – ein klares Zeichen für bessere Generalisierung.

- Minderung von katastrophalem Vergessen: Ein häufiges Problem beim Fine-Tuning ist, dass Modelle spezialisiertes Wissen auf Kosten ihres Allgemeinwissens erlernen. Tests auf neun verschiedenen Benchmarks zeigten, dass MoT nicht nur die Denkfähigkeiten stärker verbessert, sondern auch den Verlust an Allgemeinwissen (Catastrophic Forgetting) im Vergleich zu STD signifikant reduziert.

- Nutzung von „schlechten“ Lehrern: Selbst ein Lehrer, dessen Denkstil stark von der Architektur des Schülers abweicht (ein sogenannter „distribution-shifted teacher“ wie DEEPSEEK-R1 für Qwen-Modelle), trägt bei MoT positiv zum Gesamtergebnis bei. MoT extrahiert die nützlichen, allgemeinen Denkmerkmale und filtert die schädlichen Eigenheiten heraus.

Die Zukunft des KI-Trainings: Konsens statt Diktat

Die vielleicht faszinierendste Erkenntnis der Studie ist, dass ein mit MoT trainierter Schüler zu einem besseren Lehrer wird. Wenn man das finale MoT-Modell als Lehrer für eine neue Schülergeneration einsetzt, erzielt diese bessere Ergebnisse als Schüler, die vom ursprünglichen besten Einzel-Lehrer lernten.

Das bedeutet: MoT erschafft eine Form von „Konsens-Denken“. Das Modell lernt nicht nur, eine Aufgabe zu lösen, sondern es lernt einen robusteren, verallgemeinerbaren und übertragbareren Lösungsweg. Dieser Weg ist frei von den Idiosynkrasien eines einzelnen Lehrers und repräsentiert eine fundamentalere Form der Logik.

Merge-of-Thought Distillation ist mehr als nur eine neue Trainingstechnik. Es ist ein Paradigmenwechsel: weg von der Suche nach dem einen Orakel, hin zur intelligenten Synthese von vielfältiger Expertise. Für Entwickler bedeutet dies eine Zukunft mit kleineren, günstigeren, aber dennoch extrem leistungsfähigen KI-Modellen, die das Beste aus allen Welten vereinen.

Häufig gestellte Fragen zu Merge-of-Thought Distillation

Was genau ist Merge-of-Thought Distillation (MoT)?

MoT ist eine innovative Trainingsmethode für KI-Modelle. Sie verbessert die logischen Denkfähigkeiten eines „Schüler“-Modells, indem sie es parallel von mehreren „Lehrer“-Modellen lernen lässt und deren trainierte Wissensstände periodisch durch mathematische Mittelung der Modellparameter verschmilzt.

Warum ist MoT besser als das Training mit nur einer Lehrer-KI?

Die Wahl des „besten“ Lehrers ist schwierig und vom Schüler sowie den Daten abhängig. MoT umgeht dieses Problem, indem es die Stärken mehrerer Lehrer kombiniert. Dieser Prozess filtert konsistente, nützliche Denkmuster heraus und schwächt individuelle Fehler oder „Marotten“ einzelner Lehrer ab, was zu einer robusteren und höheren Gesamtleistung führt.

Welche Modelle wurden für die MoT-Studie verwendet?

Als Schüler wurden Modelle der Qwen3-Familie (8B, 14B, 30B-A3B) verwendet. Die Lehrer waren vier leistungsstarke Modelle: QWEN3-32B, QWQ, DEEPSEEK-R1 und QWEN3-235B.

Verliert das KI-Modell durch MoT altes Wissen (Catastrophic Forgetting)?

Nein, im Gegenteil. Die Studie zeigt, dass MoT das „katastrophale Vergessen“ im Vergleich zum Training mit einem einzelnen besten Lehrer (Best STD) sogar reduziert. Das Modell behält sein Allgemeinwissen besser bei, während es neue Denkfähigkeiten erlernt.

Kann ich MoT auch für andere KI-Aufgaben außer Mathematik verwenden?

Obwohl die Studie sich auf mathematisches Denken konzentriert, ist das Prinzip von MoT universell. Es verbessert die allgemeinen Denkfähigkeiten, was sich auch in Tests zu Physik, Programmierung und anderen Logik-Benchmarks zeigte. Eine Anwendung auf andere Domänen wie kreatives Schreiben oder komplexe Textzusammenfassungen ist sehr wahrscheinlich ebenfalls vorteilhaft.

Ist MoT sehr rechenintensiv?

MoT ist überraschend effizient. Der Hauptaufwand liegt im parallelen Training mehrerer Modell-Kopien. Da dies jedoch nur auf sehr kleinen Datensätzen (ca. 200 Beispiele) und für wenige Schritte geschieht, bevor die Fusion stattfindet, ist der Gesamtprozess eine sehr ressourcenschonende Methode, um massive Leistungssteigerungen zu erzielen.

Wer hat Merge-of-Thought Distillation entwickelt?

Die Methode wurde von einem Forscherteam der Zhejiang University und der Inclusion AI Abteilung der Ant Group entwickelt. Die führenden Autoren der Studie sind Zhanming Shen, Zeyu Qin und Zenan Huang.

Quellen und weiterführende Literatur

- Primärquelle: Shen, Z., Qin, Z., Huang, Z., Chen, H., Hu, J., Zhuang, Y., Lu, G., Chen, G., & Zhao, J. (2025). Merge-of-Thought Distillation. Veröffentlicht auf arXiv. https://arxiv.org/html/2509.08814v2