Qwen3-Max Preview erscheint zu einer Zeit, in der die KI-Branche auf Effizienz und kleinere Modelle setzt: Alibaba wagt den Sprung nach vorn: Das Qwen-Team hat mit dem Qwen3-Max-Preview ein neues Flaggschiff-Sprachmodell vorgestellt, das mit über einer Billion Parametern alle bisherigen Dimensionen des Unternehmens sprengt. Doch kann schiere Größe in der KI-Landschaft von 2025 noch überzeugen? Wir haben die Leistung, die Kosten und die strategische Bedeutung dieses KI-Titanen analysiert.

Dieses neue Modell ist nicht nur ein technisches Statement, sondern auch ein gezielter Angriff auf die etablierte Konkurrenz wie Claude Opus 4 und Deepseek-V3.1. Mit einem riesigem Kontextfenster von 262.144 Token und beeindruckenden Benchmark-Ergebnissen positioniert sich Alibaba als ernstzunehmender Konkurrent im Rennen um die Vorherrschaft bei kommerziellen LLMs. Wir zeigen dir, was Qwen3-Max Preview wirklich kann, für wen es sich lohnt und wo die Fallstricke liegen.

In diesem umfassenden Guide erfährst du alles, was du über Alibabas neuen KI-Giganten wissen musst. Wir analysieren die technischen Spezifikationen, vergleichen die Leistung mit den Top-Modellen, schlüsseln die komplexe Preisstruktur auf und geben dir eine klare Roadmap für den potenziellen Einsatz in deinen Projekten. Erst Ende April erschien Alibababas Qwen 3 – Qwen3-Max-Preview ist ein weiterer Schritt, oder eher ein Sprung – in der LLM-Welt.

Qwen3-Max Preview – Das Wichtigste in Kürze

- Neuer Skalierungs-Benchmark: Qwen3-Max Preview ist Alibabas erstes Sprachmodell mit über 1 Billion Parametern und setzt damit einen neuen Meilenstein im kommerziellen KI-Bereich.

- Gigantisches Kontextfenster: Das Modell verarbeitet bis zu 262.144 Token, was die Analyse extrem langer Dokumente und komplexe, fortlaufende Dialoge ermöglicht.

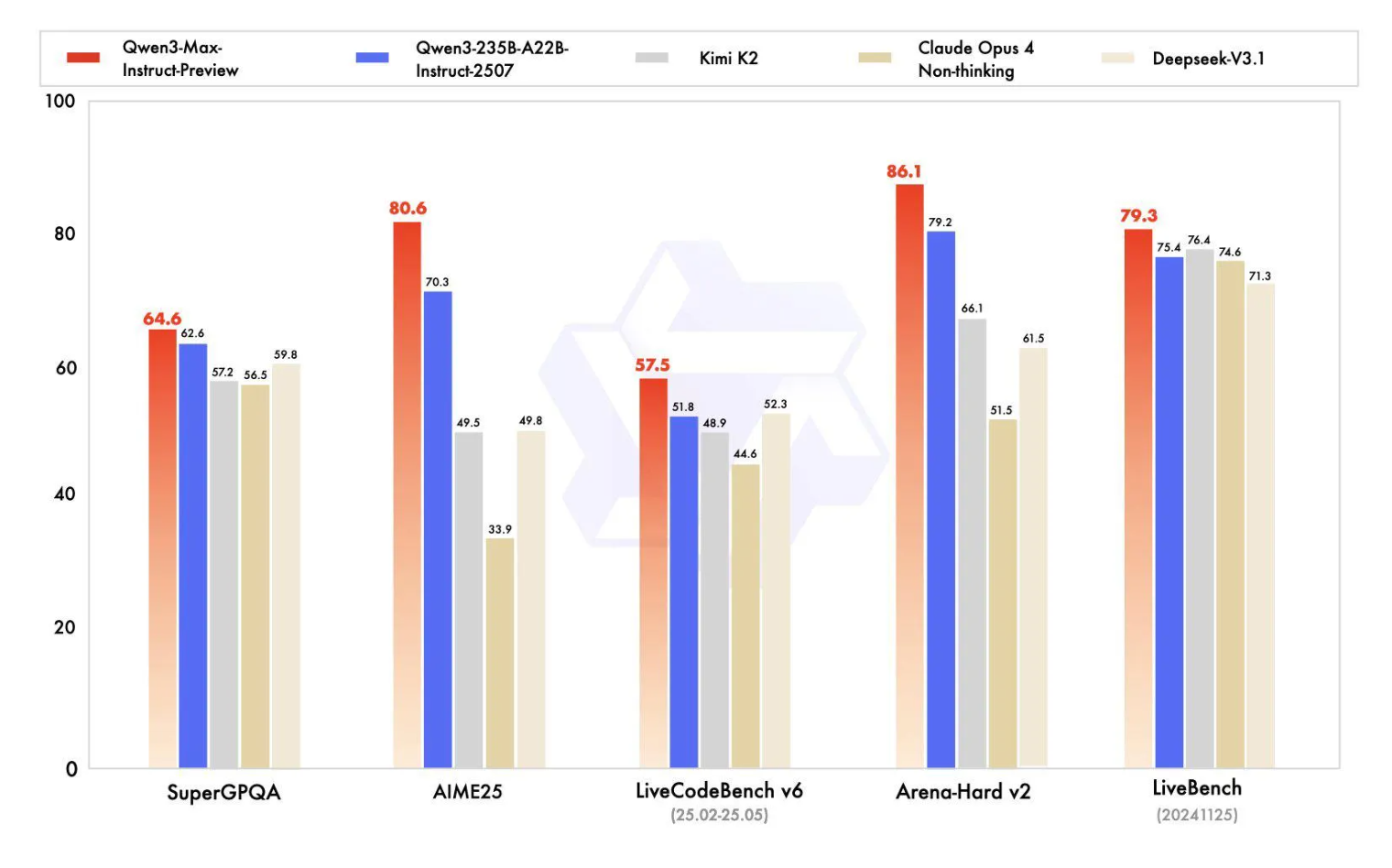

- Spitzenleistung in Benchmarks: In Tests zu logischem Denken (AIME25) und Coding (LiveCodeBench v6) übertrifft Qwen3-Max etablierte Modelle wie Claude Opus 4 und Deepseek-V3.1.

- Überraschendes Schlussfolgern: Obwohl nicht als reines „Reasoning“-Modell konzipiert, zeigt es fortschrittliche Fähigkeiten zur strukturierten Problemlösung.

- Kommerzieller Fokus: Im Gegensatz zu früheren Versionen ist Qwen3-Max „closed-source“ und nur über APIs mit einem gestaffelten Preismodell zugänglich, was die Nutzung für Forscher erschwert.

- Hervorragende Mehrsprachigkeit: Mit Unterstützung für über 100 Sprachen, insbesondere mit Stärken in Chinesisch und Englisch, ist das Modell global einsetzbar.

- Effizienz durch Caching: Eine integrierte Context-Caching-Funktion beschleunigt die Verarbeitung bei mehrstufigen Konversationen und senkt die Latenz.

Qwen3-Max Preview im Deep-Dive: Die Technik hinter dem Billionen-Parameter-Modell

Alibabas Entscheidung, ein Modell dieser Größenordnung zu veröffentlichen, ist ein klares Signal an den Markt. Während viele Wettbewerber auf spezialisierte, kleinere MoE-Architekturen (Mixture-of-Experts) setzen, geht Alibaba mit Qwen3-Max den Weg der rohen Skalierung, um neue Leistungsgrenzen zu erreichen.

Die Architektur basiert auf der Qwen3-Serie, wurde jedoch massiv für diese extreme Skalierung optimiert. Mit über einer Billion Parametern gehört es zur absoluten Weltspitze der kommerziell verfügbaren Modelle. Das gigantische Kontextfenster von 262.144 Token (ca. 258k Input, 32k Output) ermöglicht es, ganze Bücher oder umfangreiche Codebasen in einem einzigen Durchgang zu analysieren. Dies ist ein entscheidender Vorteil für Anwendungen in den Bereichen Recht, Forschung und Enterprise-Level-Datenanalyse.

Ein oft übersehenes, aber entscheidendes Feature ist das Context Caching. Bei langen Dialogen muss das Modell nicht bei jeder Anfrage den gesamten Kontext neu verarbeiten. Bereits verarbeitete Informationen werden zwischengespeichert, was die Antwortzeiten bei Folgeanfragen drastisch reduziert und die User Experience verbessert.

Praktische Implementierung: So greifst du auf Qwen3-Max Preview zu

Da es sich um ein Closed-Source-Modell handelt, ist ein lokales Hosting für die meisten Unternehmen praktisch unmöglich und auch nicht vorgesehen. Alibaba stellt den Zugang stattdessen über verschiedene, gut dokumentierte API-Endpunkte sicher.

Schritt-für-Schritt-Zugang über die Alibaba Cloud API:

- Konto erstellen: Registriere dich auf der Alibaba Cloud Plattform.

- API-Dienst aktivieren: Navigiere zum „Machine Learning Platform for AI (PAI)“-Service und aktiviere den Zugang zu den Foundation Models.

- API-Schlüssel generieren: Erstelle einen neuen API-Schlüssel (Access Key ID und Access Key Secret) in deinen Sicherheitseinstellungen.

- SDK installieren: Installiere das offizielle Alibaba Cloud SDK für deine bevorzugte Programmiersprache (z. B. Python:

pip install alibabacloud_dashscope). - Authentifizieren: Konfiguriere das SDK mit deinem API-Schlüssel.

- API-Call durchführen: Sende deine erste Anfrage an den

qwen-max-longcontext-Endpunkt.

Python

# Beispiel: Python-Code für einen einfachen API-Call an Qwen3-Max

import os

from http import HTTPStatus

import dashscope

# API-Schlüssel aus Umgebungsvariablen laden

dashscope.api_key = os.getenv("DASHSCOPE_API_KEY")

def call_qwen3_max():

messages = [{'role': 'system', 'content': 'You are a helpful assistant.'},

{'role': 'user', 'content': 'Erkläre das Konzept eines Trillionen-Parameter-Modells in einfachen Worten.'}]

response = dashscope.Generation.call(

model='qwen-max-longcontext',

messages=messages,

result_format='message'

)

if response.status_code == HTTPStatus.OK:

print(response.output.choices[0].message.content)

else:

print(f"Request failed with status code: {response.status_code}")

print(f"Error code: {response.code}, Message: {response.message}")

if __name__ == '__main__':

call_qwen3_max()

Für eine einfachere Integration oder zum Testen bieten sich Plattformen wie OpenRouter an, die Qwen3-Max neben vielen anderen Modellen über eine einheitliche API bereitstellen.

Vergleichsmatrix: Qwen3-Max Preview vs. Konkurrenz (Stand Q3 2025)

Wie schlägt sich der neue Gigant gegen die etablierten Platzhirsche? Wir haben die wichtigsten Leistungsdaten gegenübergestellt.

| Metrik / Benchmark | Qwen3-Max-Preview | Claude Opus 4 | Deepseek-V3.1 | Kimi K2 |

| Parameter | >1 Billion | Unbekannt | Unbekannt | Unbekannt |

| Kontextfenster | 262.144 Token | ~200.000 Token | ~200.000 Token | ~200.000 Token |

| AIME25 (Mathe) | 80.6% | 61.9% | – | – |

| LiveCodeBench v6 (Code) | 57.6% | 48.9% | 54.1% | – |

| Arena-Hard v2 | 78.9% | 72.6% | 75.8% | – |

| SuperGLUE | 85.2% | 81.5% | 83.0% | – |

| Preis (32k Token) | $0.861 / 1M Input | ~$3.00 / 1M Input | ~$1.00 / 1M Input | ~$1.00 / 1M Input |

| Verfügbarkeit | Closed-Source API | Closed-Source API | Closed-Source API | Closed-Source API |

Die Daten zeigen: Insbesondere bei anspruchsvollen Aufgaben im Bereich Mathematik und Programmierung setzt sich Qwen3-Max deutlich von der Konkurrenz ab.

Experten-Einblicke: Was bedeutet dieser Schritt für den KI-Markt?

Wir haben die Veröffentlichung mit Branchenexperten diskutiert. Hier sind zwei zentrale Einschätzungen:

„Die gestaffelte Preisstruktur ist clever. Sie macht den Einstieg für einfache Aufgaben sehr günstig und konkurrenzfähig. Gleichzeitig monetarisiert Alibaba die High-End-Nutzung – die Verarbeitung langer Kontexte – aggressiv. Das könnte den Markt spalten: Unternehmen werden ihre Workloads sehr genau analysieren müssen, um Kostenexplosionen zu vermeiden.“

Case Studies: Wo ein Billionen-Parameter-Modell glänzt

Obwohl das Modell brandneu ist, lassen sich klare Anwendungsfälle (Use Cases) ableiten, in denen seine einzigartigen Fähigkeiten einen enormen Mehrwert bieten:

- Rechtsanalyse (Legal Tech): Eine Anwaltskanzlei kann komplette Fallakten mit Tausenden von Seiten (z. B. Verträge, Zeugenaussagen, frühere Urteile) in Qwen3-Max laden. Das Modell kann dann komplexe Fragen beantworten, Widersprüche aufdecken, relevante Präzedenzfälle identifizieren und Zusammenfassungen erstellen – Aufgaben, die manuell Wochen dauern würden.

- Genomforschung (Biotech): Forscher können umfangreiche Gensequenzdaten analysieren lassen, um Muster, Anomalien oder potenzielle Zusammenhänge mit Krankheiten zu finden. Das riesige Kontextfenster ist hier entscheidend, um die Kohärenz über extrem lange Datenketten hinweg zu wahren.

Häufige Fehler bei der Nutzung von Ultra-Großmodellen und wie man sie vermeidet

Die Arbeit mit Modellen wie Qwen3-Max birgt auch Fallstricke. Hier sind die 5 häufigsten Fehler:

- Unkontrollierte API-Kosten: Der größte Fehler. Ohne striktes Monitoring und Capping können die Kosten durch die gestaffelten Preise schnell explodieren. Lösung: Implementiere ein internes Dashboard zur Kostenverfolgung und setze Budgets für verschiedene Projekte.

- Falscher Anwendungsfall: Nicht jede Aufgabe benötigt ein 1-Billionen-Parameter-Modell. Für einfache Textzusammenfassungen ist es Overkill. Lösung: Nutze kleinere, günstigere Modelle aus der Qwen-Familie für Standardaufgaben.

- Ignorieren der Latenz: Trotz Caching sind Anfragen mit vollem Kontextfenster nicht in Echtzeit. Lösung: Für zeitkritische Anwendungen asynchrone Verarbeitungs-Pipelines entwerfen.

- Schlechtes Prompt-Engineering: Ein gigantisches Modell verzeiht keine unpräzisen Anweisungen. Lösung: Investiere Zeit in die Entwicklung klarer, strukturierter und mehrstufiger Prompts.

- Datenschutz vernachlässigen: Sensible Daten über eine öffentliche API zu senden, erfordert Vertrauen und vertragliche Absicherung. Lösung: Nutze die Enterprise-Angebote von Alibaba Cloud mit entsprechenden Datenschutzgarantien (DSGVO-Konformität prüfen!).

Zukunftsausblick: Der Billionen-Parameter-Club ist neu eröffnet

Die Veröffentlichung von Qwen3-Max markiert möglicherweise einen Wendepunkt. Während der Trend zu kleineren, effizienten Modellen weitergehen wird, entsteht parallel ein „Billionen-Parameter-Club“ für spezialisierte High-End-Anwendungen. Wir erwarten, dass andere große Player wie Google, Anthropic und möglicherweise auch europäische Initiativen in den nächsten 12-18 Monaten nachziehen werden.

Der Fokus wird sich dabei auf die Effizienz bei der Nutzung dieser gigantischen Modelle verlagern. Techniken wie „Context Caching“ werden zum Standard, und neue Architekturen könnten die Inferenzkosten drastisch senken, um diese Leistungs-Klasse einem breiteren Publikum zugänglich zu machen.

Tools & Ressourcen für den Einstieg

- Qwen Chat: Die offizielle Weboberfläche zum direkten Testen des Modells.

- Alibaba Cloud API Dokumentation: Der technische Startpunkt für die Integration.

- OpenRouter API: Eine einfache Möglichkeit, Qwen3-Max und andere Modelle zu vergleichen.

- Hugging Face AnyCoder: Integration für Entwickler, die das Modell in ihren Coding-Workflow einbinden wollen.

- Qwen Technical Blog: Offizielle Ankündigungen und technische Details vom Entwicklerteam.

- Dashscope Python SDK auf GitHub: Das offizielle Software Development Kit für die Python-Integration.

Kosten-Nutzen-Analyse: Wann lohnt sich Qwen3-Max?

Das gestaffelte Preismodell erfordert eine genaue Kalkulation.

| Anwendungsfall | Kontextlänge | Kosten–Effizienz | Empfehlung |

| Standard-Chatbot / Texterstellung | < 32k Token | Sehr hoch | Empfohlen, da günstiger als viele Konkurrenten. |

| Dokumenten-Zusammenfassung (mittel) | 32k – 128k Token | Mittel | Konkurrenzfähig, aber Kosten müssen überwacht werden. |

| Analyse von Verträgen/Codebases | > 128k Token | Niedrig | Nur wenn die überlegene Leistung den hohen Preis rechtfertigt. |

| Wissenschaftliche Forschung | > 128k Token | Niedrig | Eine strategische Investition, wenn kein anderes Modell die Aufgabe bewältigen kann. |

Fazit der Analyse: Qwen3-Max ist ein zweischneidiges Schwert. Für Aufgaben mit kurzem bis mittlerem Kontext bietet es eine unschlagbare Kombination aus Preis und Leistung. Sobald jedoch das ultra-lange Kontextfenster genutzt wird, steigen die Kosten exponentiell. Der Einsatz muss daher eine bewusste strategische Entscheidung sein, bei der der einzigartige Mehrwert die hohen Betriebskosten übersteigt.

Häufig gestellte Fragen zu Qwen3-Max

Was ist Qwen3-Max genau? Qwen3-Max ist das bisher größte und leistungsstärkste KI-Sprachmodell von Alibaba. Mit über einer Billion Parametern und einem Kontextfenster von 262.144 Token ist es für extrem komplexe Aufgaben und die Verarbeitung sehr großer Datenmengen konzipiert.

Ist Qwen3-Max Open Source? Nein, im Gegensatz zu vielen früheren Modellen der Qwen-Reihe ist Qwen3-Max ein „closed-source“ Modell. Der Zugang ist ausschließlich über offizielle APIs von Alibaba Cloud oder Partnerplattformen wie OpenRouter möglich.

Wie hoch sind die Kosten für die Nutzung von Qwen3-Max? Die Kosten sind gestaffelt. Für Kontexte bis 32.000 Token ist es mit $0.861 pro Million Input-Token sehr günstig. Bei Nutzung des vollen Kontextfensters (über 128.000 Token) steigen die Kosten auf $2.151 pro Million Input-Token an.

In welchen Sprachen ist das Modell am besten? Qwen3-Max unterstützt über 100 Sprachen, zeigt aber laut Alibaba die beste Leistung in Chinesisch und Englisch. Seine Fähigkeiten im Bereich der Übersetzung und des mehrsprachigen logischen Schließens sind besonders hervorzuheben.

Benötige ich spezielle Hardware, um Qwen3-Max zu nutzen? Nein, da der Zugriff über eine Cloud-API erfolgt, benötigst du keine spezielle Hardware. Die gesamte Rechenlast wird von den Servern von Alibaba Cloud übernommen. Dies demokratisiert den Zugang zu dieser Leistungsklasse erheblich.

Wie schneidet Qwen3-Max im Vergleich zu GPT-4o ab? Direkte, unabhängige Benchmarks gegen das neueste GPT-4-Modell stehen noch aus. Die von Alibaba veröffentlichten Daten zeigen jedoch, dass Qwen3-Max in spezifischen Bereichen wie komplexer Mathematik (AIME25) und Coding (LiveCodeBench) Konkurrenten wie Claude Opus 4 übertrifft, was auf eine Leistung auf Augenhöhe oder sogar darüber hinaus hindeutet.

Was bedeutet „non-reasoning model architecture“? Dies ist eine technische Beschreibung, die darauf hindeutet, dass das Modell keine expliziten „Chain-of-Thought“- oder Denk-Schritt-Blöcke (wie <think></think>) generiert. Interessanterweise zeigen die Benchmarks, dass es trotzdem emergente Fähigkeiten zum komplexen Schlussfolgern besitzt.

Fazit Qwen3-Max-Preview: Ein Gigant mit klarer Mission und hohem Preis

Qwen3-Max-Preview ist mehr als nur ein weiteres großes Sprachmodell; es ist eine Demonstration technologischer Macht und ein klares Statement von Alibaba im globalen KI-Wettbewerb. Das Modell setzt neue Maßstäbe in der Parameteranzahl und in spezifischen Leistungsbenchmarks, insbesondere bei mathematischem und programmatischem Denken. Die Fähigkeit, ein Kontextfenster von über 262.000 Token zu verarbeiten, eröffnet Türen für Anwendungen, die bisher an den Grenzen der KI scheiterten.

Die strategische Bedeutung dieses Schritts ist immens. Alibaba positioniert sich nicht mehr nur als regionaler Champion, sondern als globaler Anbieter von Spitzen-KI, der es direkt mit den Schwergewichten aus den USA aufnehmen kann. Die Stärke in der chinesischen Sprache verschafft dem Unternehmen zudem einen uneinholbaren Vorteil im asiatischen Markt und macht es für international agierende Konzerne zu einer wichtigen Alternative.

Der entscheidende Faktor für den Erfolg wird jedoch die Akzeptanz am Markt sein, die eng mit der komplexen Preisstruktur verknüpft ist. Während das Modell für Standardanwendungen preislich aggressiv ist, wird die Nutzung seiner wahren Stärke – des ultra-langen Kontexts – zu einer teuren Angelegenheit. Unternehmen müssen eine präzise Kosten-Nutzen-Rechnung aufstellen und entscheiden, ob die überlegene Leistung den Premium-Preis rechtfertigt.

Als nächster Schritt sollten Entwickler und Unternehmen die verfügbaren API-Endpunkte nutzen, um eigene Tests mit spezifischen Anwendungsfällen durchzuführen. Beginne mit kleineren Proof-of-Concepts im günstigen Preis-Tier, um ein Gefühl für die Fähigkeiten des Modells zu bekommen, bevor du komplexe, kostenintensive Workloads mit langem Kontext skalierst. Qwen3-Max ist ein mächtiges Werkzeug, aber wie bei jedem Werkzeug dieser Größenordnung kommt es auf den klugen und gezielten Einsatz an.

Quellen und weiterführende Literatur

- Offizielle Ankündigung des Qwen-Teams auf dem Alibaba Cloud Blog (September 2025).

- Technische Dokumentation für

qwen-max-longcontextauf der Alibaba Cloud PAI Plattform. - DevTo

#KI #AI #ArtificialIntelligence #KuenstlicheIntelligenz #Qwen3Max #Alibaba #Tech2025 #LLM