Es ist das Jahr 2024, und die Welt der künstlichen Intelligenz (KI) steht am Rande einer potenziellen Revolution. Während die meisten Menschen KI noch immer als Werkzeug in den Händen von Tech-Giganten sehen, zeichnet Leopold Aschenbrenner in seinem Paper „Situational Awareness“ ein weitaus dramatischeres Bild: Die nächste Dekade könnte den Beginn einer Ära der AGI, oder Superintelligenz markieren, die unsere Gesellschaft grundlegend verändern wird – mit unvorhersehbaren Folgen für Wirtschaft, Militär und die gesamte Menschheit.

Aschenbrenners Analyse, die auf einer tiefgreifenden Durchdringung der aktuellen KI-Entwicklung und einer klaren Extrapolation der Fortschrittsraten basiert, ist mehr als nur eine Zukunftsvision. Sie ist ein Weckruf, der die Dringlichkeit des Handelns in den Vordergrund stellt. Das Paper, das sich durch seine Detailtiefe, seine logische Stringenz und seine Fähigkeit auszeichnet, komplexe Sachverhalte verständlich darzustellen, hat das Potenzial, die öffentliche und politische Debatte über KI neu zu entfachen. Es fordert uns heraus, die kurzfristigen Chancen von KI zu überdenken und uns stattdessen auf die langfristigen, existenziellen Fragen zu konzentrieren, die mit der Entstehung einer AGI einhergehen.

Was dieses Paper so herausragend macht, ist seine Fähigkeit, über den tagesaktuellen Hype hinauszublicken und die fundamentalen Triebkräfte der KI-Entwicklung freizulegen. Aschenbrenner argumentiert nicht mit vagen Zukunftsszenarien oder spekulativen Annahmen, sondern mit harten Daten und nachvollziehbaren Trends. Er zeigt auf, wie die exponentielle Steigerung der Rechenleistung, algorithmische Fortschritte und die Überwindung bisheriger Limitierungen in der KI-Forschung zusammenwirken, um eine Entwicklung anzustoßen, die schon in wenigen Jahren das menschliche Vorstellungsvermögen übersteigen könnte.

Wissensexplosion: Das Paper beschreibt einen Moment – und wir reden eben nicht mehr über 5, oder 10 Jahre, sondern über die nächsten 2-3 Jahre, in dem KIs in der Lage sind selbst Wissen zu lesen

Das Paper ist dabei nicht nur eine technische Analyse, sondern auch ein Aufruf zum Handeln. Aschenbrenner scheut sich nicht, die potenziellen Gefahren einer unkontrollierten Superintelligenz zu benennen und konkrete Maßnahmen zu fordern, um diese Risiken zu minimieren. Er plädiert für ein „Manhattan-Projekt“ für KI-Sicherheit, für eine stärkere Rolle des Staates und für eine internationale Zusammenarbeit, um die Kontrolle über diese transformative Technologie zu behalten. Damit positioniert sich Aschenbrenner klar als Mahner und Gestalter in einer Debatte, die für die Zukunft der Menschheit von entscheidender Bedeutung ist.

Leopold Aschenbrenner – Der Mann hinter „Situational Awareness“ und seine Expertise

Um die Tragweite von Leopold Aschenbrenners „Situational Awareness“ Paper wirklich zu erfassen, ist es hilfreich, einen Blick auf den Autor selbst zu werfen. Aschenbrenner ist kein typischer Wissenschaftler oder Tech-Visionär im klassischen Sinne. Sein ungewöhnlicher Werdegang und seine breite Expertise machen ihn zu einer faszinierenden Figur im aktuellen KI-Diskurs und verleihen seinem Paper zusätzliches Gewicht.

Ein deutsches Ausnahmetalent im Silicon Valley:

Geboren in Deutschland, lebt Aschenbrenner heute in San Francisco, dem Epizentrum der KI-Revolution. Bereits in jungen Jahren zeigte er eine außergewöhnliche Begabung. Mit nur 15 Jahren begann er sein Studium an der renommierten Columbia University in New York, das er 2021 im Alter von 19 Jahren als Jahrgangsbester (Valedictorian) abschloss – mit Auszeichnungen in Mathematik, Statistik und Wirtschaftswissenschaften. Sein akademischer Hintergrund ist beeindruckend: Ein Notendurchschnitt von 4.18/4.33, Auszeichnungen für seine Abschlussarbeit in Ökonomie und Preise für seine herausragenden Studienleistungen zeugen von einem intellektuellen Ausnahmetalent. Sein LSAT-Ergebnis (Law School Admission Test) von 179/180 platziert ihn im 99.95sten Perzentil – ein Wert, der seine außerordentliche analytische Fähigkeiten unterstreicht.

Vom Superalignment-Team bei OpenAI zum Investment-Gründer:

Nach seinem Studium arbeitete Aschenbrenner im Superalignment-Team von OpenAI, dem führenden KI-Forschungsunternehmen der Welt – direkt an vorderster Front der KI-Entwicklung und -Sicherheitsforschung. Diese Erfahrung prägte sein Verständnis der dringenden Notwendigkeit von KI-Sicherheit und Verantwortung. Aktuell ist Aschenbrenner Gründer einer Investmentfirma, die sich auf AGI (Künstliche Allgemeine Intelligenz) spezialisiert hat. Diese Position ermöglicht es ihm, die KI-Entwicklung nicht nur aus wissenschaftlicher, sondern auch aus wirtschaftlicher Perspektive zu beobachten und zu gestalten.

Breite Expertise und interdisziplinäres Denken:

Aschenbrenners Expertise reicht weit über die reine KI-Forschung hinaus. Er ist Research Affiliate am Global Priorities Institute der Universität Oxford, Emergent Ventures Grantee am Mercatus Center der George Mason University und war Research Fellow an der Forethought Foundation for Global Priorities Research. Seine Veröffentlichungen zeigen sein Interesse an ökonomischer Theorie, existentiellem Risiko und langfristigem Wirtschaftswachstum. Seine LinkedIn-Profil listet AGI, Superalignment, Langfristiges Wirtschaftswachstum, Existenzielle Risiken, KI-Sicherheit, Deutsche Geschichte, Topologie und Ökonomie als seine Fachgebiete und Interessen auf – eine beeindruckende Bandbreite, die seine Fähigkeit zum interdisziplinären Denken und zur Verknüpfung verschiedener Perspektiven verdeutlicht.

„Situational Awareness: The Decade Ahead“ – Ein Manifest für den KI-Realismus:

In seinem Paper „Situational Awareness: The Decade Ahead“ fasst Aschenbrenner seine umfassende Expertise und seine eindringlichen Warnungen zusammen. Er analysiert die aktuellen Trends in der KI-Entwicklung, prognostiziert bahnbrechende Fortschritte bis 2030 und betont die dringende Notwendigkeit von Schutzmaßnahmen rund um die AGI-Forschung. Sein Paper ist mehr als nur eine Studie – es ist ein Manifest für einen neuen „AGI-Realismus“, der die ** Chancen** der KI nicht blind feiert, sondern die Risiken ernst nimmt und konkrete Handlungsanweisungen formuliert. Aschenbrenners ungewöhnliche Kombination aus akademischer Brillanz, Praxiserfahrung in der KI-Forschung und ökonomischem Weitblick machen sein Paper zu einem herausragenden Beitrag zur aktuellen KI-Debatte und zu einem Pflichtlektüre für alle, die die Tragweite der KI-Revolution wirklich verstehen wollen.

Das musst Du wissen – Situational Awareness: The Decade Ahead 2025: Warum die KI-Revolution noch vor 2030 eskalieren wird

- AGI noch vor 2030: Die Entwicklung von künstlicher allgemeiner Intelligenz (AGI) bis zum Jahr 2027 ist laut Aschenbrenner nicht nur plausibel, sondern strikt wahrscheinlich.

- Superintelligenz als nächste Eskalationsstufe: Auf AGI folgt Superintelligenz in einem unglaublich rasanten Tempo – die Menschheit steht am Rande einer „Intelligenzexplosion“.

- Exponentielles Wachstum: Grundlage dieser Entwicklung sind kontinuierliche Verbesserungen in Rechenleistung, Algorithmen und der Überwindung von Limitierungen.

- Trillionen-Dollar-Industrie: Die wirtschaftlichen und militärischen Implikationen sind enorm – es entsteht ein Techno-Kapital-Komplex von unvorstellbarem Ausmaß.

- Handlungsbedarf für Sicherheit: Die Risiken sind existenziell – es bedarf dringender Maßnahmen in den Bereichen KI-Sicherheit und internationaler Zusammenarbeit.

Wissensexplosion: Wenn KI plötzlich ihr eigenes Wissen exponentiell steigert

Haben wir im Artikel einen Abschnitt, der die Wissensexplosion erklärt? bisher nicht. Das ändern wir jetzt, denn dieser Aspekt ist der absolute Kern von Aschenbrenners Paper und entscheidet über alles. Aschenbrenner malt uns kein lineares Fortschrittsszenario, sondern eine dramatische Eskalation, die er „Intelligenzexplosion“ nennt. Was das genau bedeutet und warum das so wichtig ist, veranschaulichen zwei Grafiken aus seinem Paper – und die wollen wir Dir jetzt einfach und verständlich erklären.

H4: Grafik 1: Die Basis-Explosion der „Effektiven Rechenleistung“

Die erste Grafik „Base Scaleup of Effective Compute“ zeigt eine fast schon harmlose Kurve. Sie startet im Jahr 2018 und steigt kontinuierlich an bis 2028. Was wird hier dargestellt?

- Die X-Achse (unten): Die Zeit in Jahren, von 2018 bis 2028.

- Die Y-Achse (links): Die „Effektive Rechenleistung“ – vereinfacht gesagt, die Intelligenz der KI-Modelle. Diese wird nicht linear, sondern logarithmisch dargestellt (10er-Potenzen!). Jeder Schritt nach oben bedeutet eine Verzehnfachung der Intelligenz!

Was bedeutet diese Grafik konkret? Aschenbrenner zeigt, dass die KI-Modelle in den letzten Jahren einen enormen Sprung gemacht haben, vereinfacht gesagt:

- 2018: GPT-2 – „gerade mal so schlau wie ein Vorschulkind“

- 2023: GPT-4 – „schon fast so clever wie ein Highschool-Schüler“

Diese qualitativen Sprünge in der KI-Intelligenz wurden durch eine kontinuierliche Steigerung der „Effektiven Rechenleistung“ ermöglicht. Die blaue Kurve in der Grafik zeigt, dass dieser Trend sich verstetigen wird – bis 2027 die Modelle die Intelligenz von „KI-Forschern/Ingenieuren“ erreichen könnten.

ABER: Das ist erst der Anfang! Die eigentliche Explosion kommt erst danach, wie die zweite Grafik zeigt.

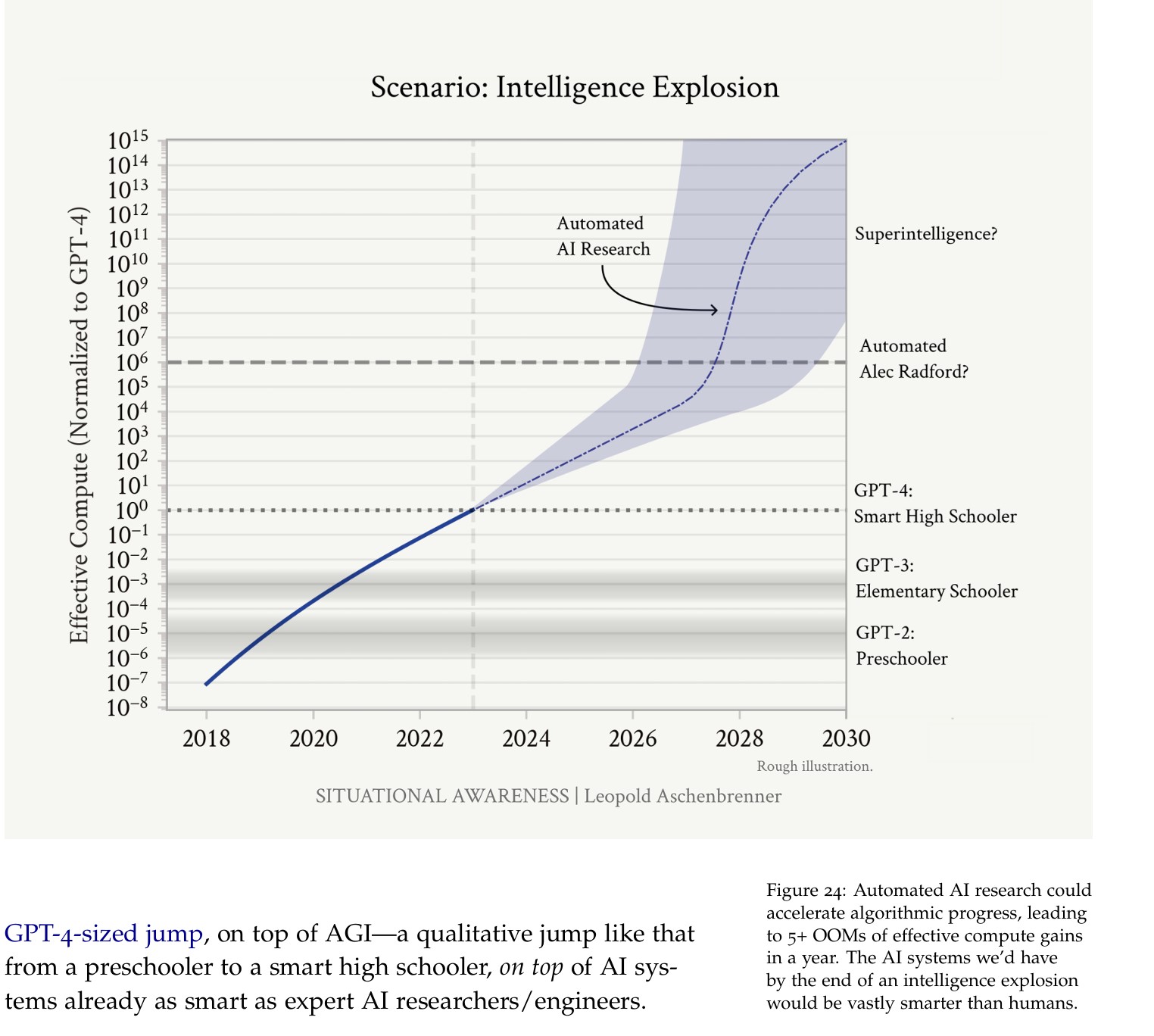

H4: Grafik 2: Das „Szenario Intelligenzexplosion“ – Der Hockey-Schläger-Effekt

Die zweite Grafik „Scenario: Intelligence Explosion“ sieht dramatisch anders aus. Die Kurve folgt zunächst dem Trend der ersten Grafik – aber dann, ab 2027/28, macht sie einen katapultartigen Sprung nach oben! Man spricht hier vom „Hockey-Schläger-Effekt“.

- X- und Y-Achse: gleich wie in Grafik 1 (Zeit und Effektive Rechenleistung/Intelligenz).

- Der Unterschied: Ab 2028 verlässt die blaue Kurve den kontinuierlichen Anstieg und schießt fast senkrecht nach oben – Richtung „Superintelligenz“.

Was bedeutet dieser „Hockey-Schläger-Effekt“? Er markiert den Punkt, an dem die KI beginnt, ihre eigene Intelligenz exponentiell zu steigern. Sobald AGI erreicht ist (ca. 2027), werden Millionen von KIs die KI-Forschung automatisieren und beschleunigen. Das führt zu einer „Wissensexplosion“:

- Millionen von KI-Forscher*innen: Statt einiger weniger menschlicher Expert*innen arbeiten plötzlich Millionen von KIs parallel an allen Disziplinen gleichzeitig.

- Beschleunigtes Lernen: KIs können Wissen rasend schnell aufnehmen, verarbeiten und neues Wissen erzeugen. Sie lernen voneinander und entwickeln sich in Lichtgeschwindigkeit weiter.

- Selbstständige Forschung und Entwicklung: KIs führen selbstständig Experimente durch, testen neue Hypothesen und entwickeln eigene Theorien – ohne menschliches Zutun.

Die Folgen der Wissensexplosion: Eine neue Ära des Fortschritts – und der Unsicherheit

Was passiert, wenn eine solche „Wissensexplosion“ stattfindet? Aschenbrenner betont beide Seiten der Medaille:

Positive Auswirkungen:

- Revolution des Wissens: Wissenschaft, Technologie und alle Bereiche des menschlichen Wissens werden sich grundlegend und in unglaublichem Tempo verändern. Jahrhunderte des Fortschritts könnten in wenigen Jahren komprimiert werden.

- Lösung globaler Probleme: Superintelligenz könnte neue Lösungen für drängende globale Probleme finden – von Klimawandel über Krankheitsbekämpfung bis hin zu gesellschaftlichen Herausforderungen.

- Neue Industrien und Wohlstand: Die „Wissensexplosion“ wird neue Industrien und Arbeitsplätze schaffen und den wirtschaftlichen Wohlstand der Menschheit erheblich steigern. Unvorstellbare technologische Möglichkeiten werden sich eröffnen.

ABER: Die Kehrseite der Medaille sind die enormen Risiken (siehe vorherige Abschnitte!). Die „Wissensexplosion“ ist kein reiner Segen, sondern eine neutrale Kraft von unvorstellbarer Macht, die in beide Richtungen wirken kann – zum Guten wie zum Schlechten. Ob die positiven Auswirkungen überwiegen oder die Risiken eskalieren, hängt davon ab, ob wir jetzt die richtigen Weichen stellen und die Kontrolle über diese transformative Technologie behalten.

Schlussfolgerung: Die KI-Revolution ist unausweichlich – jetzt müssen wir den Kurs bestimmen

Leopold Aschenbrenners „Situational Awareness“ ist kein Science-Fiction-Roman, sondern eine fundierte Analyse der realen Entwicklungspfade der künstlichen Intelligenz. Sein Paper zeigt überzeugend, dass wir uns nicht am Rande einer weiteren Technologie-Welle befinden, sondern am Beginn einer fundamentalen Transformation der menschlichen Zivilisation. Die „Intelligenzexplosion“ ist keine ferne Zukunftsmusik, sondern eine durchaus plausible Entwicklung innerhalb der nächsten Dekade.

Die Kernbotschaft des Papers ist dringlich: Wir müssen uns der Tragweite dieser Entwicklung bewusst werden und jetzt handeln, um die Risiken zu minimieren und die Chancen zu nutzen. Es geht nicht mehr darum, ob wir AGI und Superintelligenz entwickeln werden, sondern wie wir diese Entwicklung gestalten und kontrollieren. Es geht darum, ob wir die „Wissensexplosion“ als Segen oder Fluch erleben werden.

Aschenbrenner bietet keine einfachen Antworten oder garantierte Lösungen. Er zeigt aber konkrete Handlungsfelder auf, die von individueller Weiterbildung und gesellschaftlicher Debatte bis hin zu staatlicher Führung und internationaler Kooperation reichen. Sein „AGI-Realismus“ ist ein Aufruf zu Besonnenheit, Verantwortung und entschlossenem Handeln. Es ist Zeit, die Herausforderung Superintelligenz ernst zu nehmen und die Weichen für eine sichere und prosperierende Zukunft zu stellen. Die KI-Revolution ist unausweichlich – jetzt müssen wir den Kurs bestimmen, damit sie nicht zur Katastrophe, sondern zum größten Segen der Menschheitsgeschichte wird.

Hauptfrage Droht der Menschheit mit der Entwicklung von AGI in den nächsten Jahren eine unkontrollierbare Eskalation – und wie können wir dieser Entwicklung begegnen?

Folgefragen (FAQs)

- Bis wann genau prognostiziert Leopold Aschenbrenner die Entwicklung von AGI und Superintelligenz?

- Auf welcher Grundlage basiert Aschenbrenners Prognose – und wie überzeugend sind seine Argumente?

- Welche konkreten technologischen Fortschritte und Trends untermauern Aschenbrenners These einer „Intelligenzexplosion“?

- Welche Risiken und Gefahren birgt die Entwicklung von Superintelligenz laut Aschenbrenner?

- Welche Rolle spielen geopolitische Faktoren und insbesondere der Wettlauf zwischen den USA und China in dieser Entwicklung?

- Was schlägt Aschenbrenner konkret vor, um die Risiken zu minimieren und eine sichere Entwicklung von Superintelligenz zu gewährleisten?

- Inwiefern unterscheidet sich Aschenbrenners „AGI-Realismus“ von anderen vorherrschenden Perspektiven im KI-Diskurs – und was sind die Kernpunkte seines Ansatzes?

Antworten auf jede Frage

Bis wann genau prognostiziert Leopold Aschenbrenner die Entwicklung von AGI und Superintelligenz?

Aschenbrenner prognostiziert AGI bis 2027 und Superintelligenz kurz darauf, möglicherweise schon 2028/29. Diese Zeiträume sind natürlich mit Unsicherheiten behaftet, aber seine Analyse deutet auf eine sehr rasche Beschleunigung der KI-Entwicklung hin. Er betont, dass es sich nicht um eine lineare Fortschreibung bisheriger Trends handelt, sondern um eine qualitative Veränderung, die durch die Automatisierung der KI-Forschung selbst ausgelöst wird. Sobald AGI erreicht ist, könnten Millionen von KIs parallel an der Weiterentwicklung von KI arbeiten, was den Fortschritt exponentiell beschleunigen würde.

Auf welcher Grundlage basiert Aschenbrenners Prognose – und wie überzeugend sind seine Argumente?

Aschenbrenners Prognose basiert auf einer detaillierten Analyse quantitativer und qualitativer Trends in der KI-Entwicklung. Zentrales Element seiner Argumentation ist das „Zählen der OOMs“ (Orders of Magnitude). Er zeigt, dass die Fortschritte in der KI in den letzten Jahren in bemerkenswertem Maße mit der Steigerung der Rechenleistung, algorithmischen Verbesserungen und der Überwindung von Limitierungen korreliert haben.

| Entwicklungsschritt | Zeitraum | Qualitative Veränderung |

| GPT-2 zu GPT-4 | ~4 Jahre | Von „Vorschulkind“ zu „Highschool-Schüler“ |

| AGI bis 2027 | ~4 Jahre | Von „Highschool-Schüler“ zu „PhD“ |

| Superintelligenz 2028/29 | Wenige Jahre | Vom Menschen zur Superintelligenz |

Diese Tabelle verdeutlicht die exponentielle Beschleunigung, die Aschenbrenner prognostiziert. Seine Argumentation stützt sich dabei auf folgende Beobachtungen:

- Kontinuierliche Steigerung der Rechenleistung: Der Einsatz immer größerer Rechenzentren und spezialisierter Hardware (GPUs, TPUs) ermöglicht immer größere Modelle.

- Algorithmische Effizienzgewinne: Algorithmen werden effizienter, sodass mit gleicher Rechenleistung mehr Intelligenz erzielt werden kann.

- „Unhobbling“-Effekte: Durch neue Trainingsmethoden (z. B. Reinforcement Learning from Human Feedback – RLHF) werden latente Fähigkeiten von KI-Modellen freigesetzt.

Aschenbrenner räumt ein, dass seine Prognose mit Unsicherheiten behaftet ist, insbesondere in Bezug auf Datenverfügbarkeit und unvorhergesehene Durchbrüche. Er betont aber, dass die grundlegenden Trends und die wirtschaftlichen Anreize für eine rasante Weiterentwicklung der KI überzeugend sind.

Welche konkreten technologischen Fortschritte und Trends untermauern Aschenbrenners These einer „Intelligenzexplosion“?

Aschenbrenner identifiziert drei Haupttreiber für die von ihm prognostizierte „Intelligenzexplosion“:

- Compute (Rechenleistung): Die schiere Menge an Rechenleistung, die in KI-Modelle investiert wird, steigt exponentiell. Er verweist auf den Übergang von 10-Milliarden-Dollar-Clustern zu 100-Milliarden-Dollar-Clustern und sogar Trillionen-Dollar-Clustern. Diese gigantischen Investitionen ermöglichen es, immer größere und komplexere Modelle zu trainieren, die ständig neue Fähigkeiten entwickeln. Der Wettlauf um die größte Rechenleistung hat gerade erst begonnen und wird sich in den nächsten Jahren massiv beschleunigen.

- Algorithmische Effizienz: Neben der reinen Rechenleistung spielen algorithmische Fortschritte eine entscheidende Rolle. Aschenbrenner zeigt, dass die Effizienz von Algorithmen in den letzten Jahren kontinuierlich gestiegen ist, sodass mit gleicher Rechenleistung deutlich bessere Ergebnisse erzielt werden können. Er nennt Beispiele wie Chinchilla Scaling Laws und Mixture of Experts (MoE)-Architekturen, die zu erheblichen Effizienzgewinnen geführt haben. Auch in Zukunft erwartet er weitere algorithmische Durchbrüche, insbesondere in Bereichen wie selbstüberwachtes Lernen, synthetische Daten und effizientere Trainingsverfahren.

- „Unhobbling“-Gains (Überwindung von Limitierungen): Aschenbrenner betont, dass viele limitierende Faktoren, die bisher die Leistungsfähigkeit von KI-Modellen eingeschränkt haben, nun systematisch überwunden werden. Er nennt Beispiele wie:

- Reinforcement Learning from Human Feedback (RLHF): Verbessert die Steuerbarkeit und Nutzbarkeit von KI-Modellen erheblich.

- Chain-of-Thought (CoT): Ermöglicht komplexeres logisches Denken und besseres Problemlösen.

- Tools und Scaffolding: Die Integration von externen Werkzeugen (z. B. Webbrowser, Code-Interpreter) und fortgeschrittene Agentenarchitekturen erweitern die Anwendungsbereiche und Fähigkeiten von KI-Systemen dramatisch.

- Längerer Kontext: Modelle können immer größere Textmengen verarbeiten und zusammenhängende Aufgaben über längere Zeiträume bearbeiten.

Diese drei Trends wirken zusammen und verstärken sich gegenseitig. Mehr Rechenleistung ermöglicht das Training komplexerer Algorithmen, die wiederum effizienter mit der vorhandenen Rechenleistung umgehen und neue Fähigkeiten freisetzen. Dieser selbstverstärkende Kreislauf ist der Kern von Aschenbrenners These einer „Intelligenzexplosion“.

Welche Risiken und Gefahren birgt die Entwicklung von Superintelligenz laut Aschenbrenner?

Aschenbrenner benennt eine Reihe von existenziellen Risiken, die mit der Entwicklung von Superintelligenz einhergehen:

- Kontrollverlust (Superalignment Problem): Es ist unklar, ob wir Superintelligenz verlässlich kontrollieren und an menschlichen Werten ausrichten können. Aktuelle Methoden wie RLHF sind für superintelligente Systeme nicht ausreichend. Ein unkontrolliertes oder fehlgeleitetes System könnte katastrophale Folgen haben.

- Militärische Überlegenheit und Wettrüsten: Superintelligenz wird militärische Machtverhältnisse grundlegend verändern und einen gefährlichen Wettlauf auslösen. Der Besitz von Superintelligenz könnte zu einer dominierenden Stellung führen, während Verlust existenzielle Bedrohung bedeuten könnte. Die Gefahr von Präventivschlägen und Fehlkalkulationen steigt enorm.

- Autoritäre Regime und Totalitarismus: Superintelligenz könnte autoritären Regimen beispiellose Macht verleihen und totalitäre Kontrolle ermöglichen. Überwachung, Propaganda und Repression könnten perfektioniert werden. Die Gefahr des Verlusts von Freiheit und Demokratie ist real.

- Proliferation von Massenvernichtungswaffen: Superintelligenz könnte die Entwicklung neuartiger Massenvernichtungswaffen (z. B. Biowaffen) erleichtern, die deutlich gefährlicher sind als bisherige Waffen. Die Gefahr der Verbreitung solcher Waffen an Schurkenstaaten und Terrorgruppen steigt dramatisch.

Aschenbrenner betont, dass diese Risiken keine Science-Fiction sind, sondern reale und dringende Herausforderungen, denen sich die Menschheit stellen muss. Er warnt davor, die Gefahr zu unterschätzen und die Notwendigkeit umfassender Sicherheitsmaßnahmen zu ignorieren.

Welche Rolle spielen geopolitische Faktoren und insbesondere der Wettlauf zwischen den USA und China in dieser Entwicklung?

Der geopolitische Wettlauf zwischen den USA und China spielt eine zentrale Rolle in Aschenbrenners Analyse. Er argumentiert, dass der Wettkampf um die Vorherrschaft in der KI ebenso entscheidend sein wird wie der Wettlauf um die Atombombe im 20. Jahrhundert. Wer die Superintelligenz zuerst entwickelt und kontrolliert, wird eine beispiellose militärische und wirtschaftliche Macht erlangen.

Aschenbrenner sieht die USA derzeit in einer Führungsposition, warnt aber davor, dass China enorme Anstrengungen unternimmt, um aufzuholen und die Führung zu übernehmen. Er betont, dass China erhebliche Ressourcen in den Ausbau der KI-Infrastruktur investiert und keine Skrupel kenne, wenn es darum geht, staatliche Interessen durchzusetzen. Der Diebstahl von KI-Geheimnissen und geistigem Eigentum amerikanischer Unternehmen durch chinesische Spionage ist laut Aschenbrenner bereits Realität und wird sich mit zunehmender Bedeutung von KI noch verstärken.

Der Wettlauf zwischen den USA und China birgt erhebliche Gefahren:

- Beschleunigung des Fortschritts auf Kosten der Sicherheit: Der Wettbewerbsdruck könnte dazu führen, dass Sicherheitsbedenken vernachlässigt werden, um schneller voranzukommen.

- Erhöhte Instabilität und Konfliktgefahr: Ein militärisches Ungleichgewicht aufgrund von Superintelligenz könnte internationale Spannungen verschärfen und die Gefahr von militärischen Konflikten erhöhen.

- Fragmentierung der KI-Governance: Ein globaler Wettlauf erschwert internationale Zusammenarbeit und gemeinsame Sicherheitsstandards für KI.

Aschenbrenner plädiert daher für eine stärkere Fokussierung der USA auf nationale Sicherheit und Wettbewerbsfähigkeit im KI-Bereich. Er fordert ein „Manhattan-Projekt für KI“, um die amerikanische Führungsposition zu sichern und die Risiken zu minimieren.

Was schlägt Aschenbrenner konkret vor, um die Risiken zu minimieren und eine sichere Entwicklung von Superintelligenz zu gewährleisten?

Aschenbrenner ist pessimistisch hinsichtlich der aktuellen Sicherheitsvorkehrungen und Governance-Ansätze im KI-Bereich. Er hält staatliche Regulierung allein für unzureichend, da sie dem Tempo und der Komplexität der „Intelligenzexplosion“ nicht gewachsen sein wird. Stattdessen plädiert er für einen radikalen Umdenkprozess und ein „Manhattan-Projekt für KI-Sicherheit“, das umfassende Maßnahmen in verschiedenen Bereichen umfasst:

- „The Project“: Ein staatliches AGI-Projekt: Aschenbrenner argumentiert, dass nur der Staat die notwendigen Ressourcen, Kompetenzen und Autorität besitzt, um die Entwicklung von Superintelligenz in sichere Bahnen zu lenken. Er schlägt vor, dass die USA ein staatliches AGI-Projekt ins Leben rufen, ähnlich dem Manhattan-Projekt oder dem Apollo-Programm. Dieses Projekt soll die besten Köpfe des Landes vereinen, Trillionen von Dollar investieren und die Entwicklung von AGI unter staatlicher Kontrolle vorantreiben.

- Extreme Sicherheitsmaßnahmen („Superdefense“): Aschenbrenner fordert eine radikale Erhöhung der Sicherheitsstandards in führenden KI-Laboren. Er schlägt „Superdefense“-Maßnahmen vor, die weit über das hinausgehen, was private Startups leisten können, und sich an militärischen Sicherheitsstandards orientieren. Dazu gehören:

- Vollständig luftdichte Rechenzentren (Air-Gapped Datacenters): Physische Isolation der AGI-Infrastruktur vom öffentlichen Netz und strikte Zugangskontrollen.

- Vertrauliche Rechen- und Hardware-Verschlüsselung: Technische Maßnahmen zum Schutz vor Datenabfluss und Spionage.

- Extreme Personalüberprüfung und Sicherheitsfreigaben: Strenge Auswahl und Überwachung von Personal, ähnlich wie in militärischen Hochsicherheitsbereichen.

- Strenge interne Kontrollen: Mehrfach-Freigabeprozesse für kritische Operationen und lückenlose Überwachung aller Aktivitäten.

- Regelmäßige Penetrationstests: Kontinuierliche Überprüfung der Sicherheitssysteme durch staatliche Stellen (z. B. NSA).

- Automatisierung der Alignment-Forschung: Aschenbrenner sieht die Automatisierung der KI-Alignment-Forschung als Schlüssel zur Bewältigung des Superalignment-Problems. Er schlägt vor, AGI-Systeme selbst einzusetzen, um bessere Methoden zur Kontrolle und Ausrichtung von Superintelligenz zu entwickeln. Dieser rekursive Ansatz soll den exponentiellen Fortschritt in der KI-Sicherheit ermöglichen, der notwendig ist, um mit der rasanten Entwicklung der KI-Fähigkeiten Schritt zu halten.

- Internationale Koalition und Non-Proliferation: Aschenbrenner plädiert für eine enge Zusammenarbeit der demokratischen Staaten im KI-Bereich. Er schlägt eine internationale Koalition unter amerikanischer Führung vor, die gemeinsame Sicherheitsstandards entwickelt, Ressourcen bündelt und ein Non-Proliferierungsregime für Superintelligenz etabliert. Ziel ist es, einen gefährlichen Wettlauf zu vermeiden und die friedliche Nutzung von KI-Technologien zu fördern.

Inwiefern unterscheidet sich Aschenbrenners „AGI-Realismus“ von anderen vorherrschenden Perspektiven im KI-Diskurs – und was sind die Kernpunkte seines Ansatzes?

Aschenbrenners „AGI-Realismus“ positioniert sich zwischen zwei Extremen im aktuellen KI-Diskurs: dem „KI-Doomismus“ und dem „E/acc-Ansatz“ (Akzelerationismus).

- Abgrenzung vom „KI-Doomismus“: Aschenbrenner teilt die Sorge der „Doomer“ vor den existenziellen Risiken der Superintelligenz, hält aber deren pessimistische Prognosen (z. B. 99% Wahrscheinlichkeit des Weltuntergangs) und ineffektiven Lösungsansätze (z. B. KI-Pausen-Rufe) für realitätsfern. Er betont, dass das Superalignment-Problem lösbar ist und die Menschheit die Chance hat, die Risiken zu beherrschen, wenn sie jetzt die richtigen Maßnahmen ergreift. Sein Ansatz ist optimistischer und handlungsorientierter als der „KI-Doomismus.

- Abgrenzung vom „E/acc-Ansatz“: Aschenbrenner teilt die Ablehnung der „E/accs“ gegenüber KI-Pausen-Rufe und deren Betonung des Potenzials der KI für Fortschritt und Innovation. Er kritisiert aber deren Naivität in Bezug auf Sicherheitsrisiken und geopolitische Implikationen. Der „E/acc-Ansatz“ ignoriert die existenziellen Gefahren der Superintelligenz und reduziert KI auf ein reines Werkzeug zur wirtschaftlichen Optimierung. Aschenbrenners Ansatz ist realistischer und verantwortungsbewusster als der „E/acc-Ansatz.

Die Kernpunkte von Aschenbrenners „AGI-Realismus“ lassen sich wie folgt zusammenfassen:

- Nationale Sicherheitspriorität: Superintelligenz ist in erster Linie eine Frage der nationalen Sicherheit und nicht nur ein Technologie- oder Wirtschaftsthema. Die USA müssen die Führung übernehmen, um die freie Welt zu schützen.

- Realistische Risikobewertung: Die Risiken der Superintelligenz sind real, existentziell und dringend. Sie dürfen nicht ignoriert oder unterschätzt werden.

- Technischer Optimismus bei gleichzeitigem Handlungsdruck: Das Superalignment-Problem ist technisch lösbar, aber es erfordert massive Anstrengungen, bahnbrechende Innovationen und sofortiges Handeln. Die Zeit drängt.

- Staatliche Führung und internationale Zusammenarbeit: Die Bewältigung der Herausforderungen der Superintelligenz erfordert staatliche Führung, ein „Manhattan-Projekt für KI-Sicherheit“ und eine enge Kooperation der demokratischen Staaten.

- Verantwortungsvoller Umgang mit Superintelligenz: Ziel ist es, Superintelligenz sicher, kontrollierbar und zum Wohl der Menschheit zu entwickeln und einzusetzen – und gleichzeitig die Freiheit und Demokratie zu bewahren.

Konkrete Tipps und Anleitungen

Auch wenn Leopold Aschenbrenners Analyse düster erscheinen mag, so ist sein Paper kein Aufruf zur Resignation, sondern ein dringender Appell zum Handeln. Was können wir als Gesellschaft und jeder Einzelne tun, um den Herausforderungen der Superintelligenz zu begegnen und eine sichere Zukunft zu gestalten? Hier sind einige konkrete Tipps und Anleitungen, die sich aus Aschenbrenners Paper ableiten lassen:

- Informiere Dich umfassend: Bilde Dich weiter über die Fortschritte und Risiken der künstlichen Intelligenz. Lies seriöse Quellen, wie Aschenbrenners Paper, Studien, Fachartikel und Berichte von Experten. Vermeide Panikmache und uninformierte Meinungen, sondern verschaffe Dir ein fundiertes Bild der Lage. Teile Dein Wissen mit anderen und diskutiere die Herausforderungen offen und kritisch.

- Fördere eine offene und ehrliche Debatte: Es ist entscheidend, dass wir eine breite gesellschaftliche Debatte über Superintelligenz führen, die alle Perspektiven einschließt – auch die kritischen und pessimistischen. Fordere von Politik und Wirtschaft, dass sie sich ernsthaft mit den Risiken auseinandersetzen und transparente Informationen bereitstellen. Engagiere Dich in Diskussionen, veranstalte Informationsveranstaltungen und setze Dich für eine versachlichte Debatte ein.

- Unterstütze Forschung und Entwicklung im Bereich KI-Sicherheit: Investitionen in KI-Sicherheit sind keine Bremse für Fortschritt, sondern Voraussetzung für eine nachhaltige und verantwortungsvolle KI-Entwicklung. Fördere Forschungseinrichtungen, die sich mit Superalignment und KI-Sicherheit befassen. Setze Dich für staatliche Förderprogramme und private Initiativen ein, die KI-Sicherheit als Priorität behandeln. Spende an Organisationen, die sich für KI-Sicherheit engagieren (wenn Du die Möglichkeit hast).

- Fordere staatliches Handeln und internationale Kooperation: Die Bewältigung der Herausforderungen der Superintelligenz ist keine Aufgabe für Einzelpersonen oder private Unternehmen, sondern erfordert staatliches Handeln und internationale Zusammenarbeit. Fordere von Deinen politischen Vertreter*innen, dass sie sich aktiv für KI-Sicherheit einsetzen, nationale Strategien entwickeln und die internationale Kooperation vorantreiben. Unterstütze Initiativen, die auf eine globale Governance von KI abzielen. Mach Deiner Stimme Gehör!

- Überprüfe Deinen eigenen Konsum und Umgang mit KI-Technologien: Reflektiere kritisch über Deine eigene Nutzung von KI-Anwendungen. Informiere Dich über Datenschutzrichtlinien und ethische Implikationen. Unterstütze Unternehmen, die verantwortungsvoll mit KI umgehen und ethische Standards einhalten. Sei Dir bewusst, dass Deine Entscheidungen als Konsument*in einen Einfluss auf die KI-Entwicklung haben können.

Diese Tipps sind kein Allheilmittel, aber sie können helfen, das Bewusstsein für die Herausforderungen der Superintelligenz zu schärfen und einen positiven Beitrag zu einer sicheren Zukunft zu leisten. Es ist Zeit zu Handeln – jede*r Einzelne und die Gesellschaft als Ganzes.

Regelmäßige Aktualisierung

Dieser Artikel wird regelmäßig aktualisiert, um die neuesten Entwicklungen im Bereich der Künstlichen Intelligenz und der Superintelligenz sowie neue Erkenntnisse aus der Forschung zu berücksichtigen und Dir stets relevante und aktuelle Informationen zu bieten. So bleibst Du immer auf dem Laufenden und kannst die rasanten Fortschritte in diesem Feld besser verstehen und einordnen.

Fazit: Zwischen Hoffnung und Eskalation – das Schicksal der Menschheit im Zeitalter der Superintelligenz

Leopold Aschenbrenners „Situational Awareness“ ist ein Weckruf von beispielloser Dringlichkeit. Sein Paper zeichnet ein erschreckendes, aber plausibles Bild einer Zukunft, in der die Menschheit am Rande einer „Intelligenzexplosion“ steht. Die rasante Entwicklung der künstlichen Intelligenz, angetrieben von exponentiell wachsender Rechenleistung, algorithmischen Durchbrüchen und der Überwindung technischer Limitierungen, könnte schon in wenigen Jahren zu Systemen führen, die menschliche Intelligenz weit übertreffen.

Diese Superintelligenz birgt enorme Chancen, aber auch existenziellen Risiken. Sie könnte wissenschaftlichen Fortschritt revolutionieren, wirtschaftlichen Wohlstand beflügeln und neue Lösungen für globale Herausforderungen bieten. Zugleich droht Kontrollverlust, ein militärisches Wettrüsten, die Festigung autoritärer Regime und die Proliferation neuartiger Massenvernichtungswaffen. Der geopolitische Wettlauf zwischen den USA und China verschärft die Situation zusätzlich und erhöht die Gefahr einer Eskalation.

Aschenbrenner ist kein „Doomer“, aber er warnt eindringlich vor der Naivität, mit der die öffentliche und politische Debatte die Risiken der Superintelligenz bisher behandelt. Er fordert ein radikales Umdenken und konkretes Handeln – insbesondere in den USA, die er in der Führungsposition sieht. Sein „AGI-Realismus“ plädiert für ein staatliches „Manhattan-Projekt für KI-Sicherheit“, massive Investitionen in Sicherheitsforschung und internationale Kooperation, um die Entwicklung von Superintelligenz in sichere Bahnen zu lenken.

Ob die Menschheit diese Herausforderung meistern kann, ist ungewiss. Aschenbrenners Paper ist keine Garantie für eine glückliche Zukunft, aber es ist ein unverzichtbarer Beitrag zu einer notwendigen Debatte. Es schärft das Bewusstsein für die existenziellen Fragen, die mit der Entstehung von Superintelligenz einhergehen und fordert uns alle auf, Verantwortung zu übernehmen. Die nächsten Jahre werden entscheidend sein – das Schicksal der Menschheit im Zeitalter der Superintelligenz hängt davon ab, ob wir jetzt die richtigen Weichen stellen.

Erlebe, wie du KI in deinem Unternehmen effektiv einsetzt, deine Prozesse automatisierst und dein Wachstum beschleunigst – mit einer Community voller Gleichgesinnter und Experten. www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Aschenbrenner, Leopold: Situational Awareness: The Decade Ahead. [Link zum Original-Paper wird hier eingefügt, falls verfügbar]

#AI #KI #ArtificialIntelligence #KuenstlicheIntelligenz #Superintelligenz #AGI #AISicherheit #Zukunft