Du liest online einen Artikel und fragst Dich: Hat das ein Mensch geschrieben oder eine Künstliche Intelligenz? Angesichts der rasanten Verbreitung von KI-generierten Inhalten ist diese Frage relevanter denn je. Eine brandaktuelle Studie von Januar 2025 liefert nun eine verblüffende Antwort darauf, wer die besten Detektive für Texte von GPT-4o, Claude & Co. sind: Es sind Menschen wie Du – vorausgesetzt, Du nutzt regelmäßig Sprachmodelle für Schreibaufgaben! Diese Untersuchung zeigt, dass erfahrene menschliche Nutzer eine erstaunliche Treffsicherheit beim KI-Texte erkennen entwickeln und damit die meisten automatisierten Detektoren sogar übertreffen, selbst wenn die KI-Texte geschickt getarnt wurden. Erfahre hier, welche Signale diese „Experten-Augen“ wahrnehmen und wie auch Du Deinen Blick dafür schärfen kannst.

Das Wichtigste in Kürze – Menschliche Expertise beim KI-Texte erkennen

- Überlegene Detektive: Eine Studie (Januar 2025) zeigt, dass Menschen, die häufig LLMs für Schreibaufgaben nutzen, KI-Texte von Modellen wie GPT-4o, Claude-3.5-Sonnet und o1-Pro signifikant besser erkennen als die meisten Software-Lösungen.

- Subtile Hinweise: Diese „Experten“ achten nicht nur auf typisches „KI-Vokabular“, sondern erkennen auch komplexere Muster in Formalität, Originalität, Klarheit und Textstruktur.

- Robust gegen Täuschung: Selbst durch Paraphrasierung oder „Humanisierung“ (Anpassung des KI-Textes an menschlichen Stil) ließen sich die menschlichen Experten kaum täuschen.

- Erfahrung zählt: Die Mehrheitsentscheidung von fünf solcher Experten führte bei 300 Testartikeln zu nur einer einzigen Fehlklassifizierung. Laien schnitten hingegen kaum besser als der Zufall ab.

- Menschliche Intuition unersetzlich: Die Studie unterstreicht, dass menschliche Erfahrung und Intuition bei der Bewertung von KI-Inhalten identifizieren eine entscheidende Rolle spielen, besonders in kritischen Anwendungsfällen.

Die Studie im Mikroskop: Wer entlarvt KI-Texte wirklich?

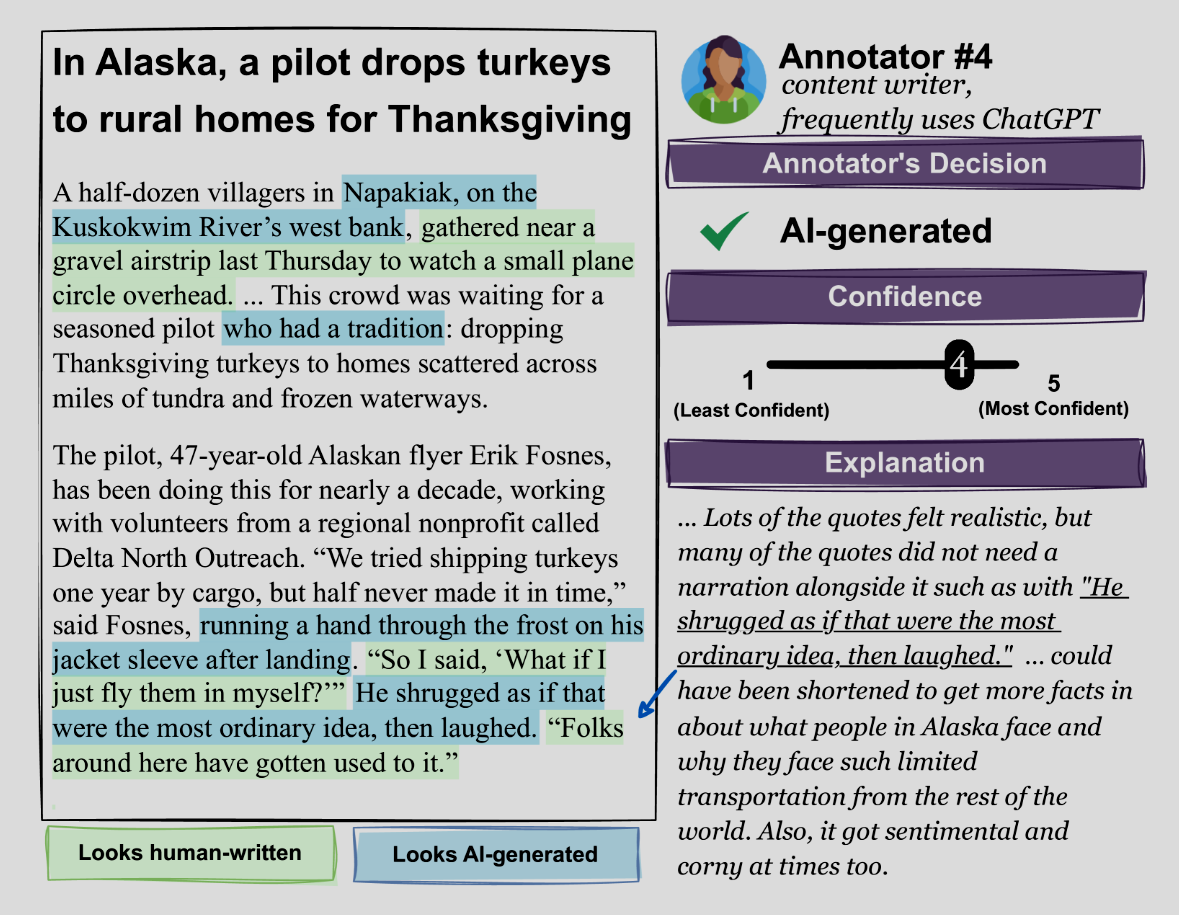

Forscher wie Jenna Russell, Marzena Karpinska und Mohit Iyyer wollten es genau wissen: Wie gut sind Menschen im Vergleich zu Software darin, KI-Texte zu erkennen? Für ihre im Januar 2025 veröffentlichte Studie (arXiv:2501.15654) legten sie 300 englischsprachige Sachtexte vor. Die Hälfte stammte von menschlichen Autoren, die andere Hälfte wurde von aktuellen Top-Sprachmodellen wie OpenAI’s GPT-4o und o1-Pro sowie Anthropic’s Claude-3.5-Sonnet generiert.

Der Clou der Untersuchung lag in der Auswahl der menschlichen Testpersonen. Die Forscher rekrutierten Annotatoren und teilten sie basierend auf ihrer Erfahrung mit LLMs in zwei Gruppen:

- „Laien“: Personen, die LLMs selten oder gar nicht für Schreibaufgaben nutzen.

- „Experten“: Fünf ausgewählte Personen, die beruflich oder privat häufig Sprachmodelle wie ChatGPT für das Verfassen und Bearbeiten von Texten einsetzen. Wichtig dabei: Diese Experten erhielten keinerlei spezielle Schulung oder Feedback zu ihren Entscheidungen während des Tests.

Jeder Teilnehmer musste die Artikel lesen und einschätzen, ob sie von einem Menschen oder einer KI verfasst wurden, inklusive einer Begründung für ihre Entscheidung.

Erstaunlich treffsicher: Warum erfahrene Nutzer die Nase vorn haben

Die Ergebnisse sind ein starkes Plädoyer für die menschliche Urteilskraft, insbesondere für die von erfahrenen Nutzern. Die Gruppe der „Experten“ zeigte eine herausragende Leistung: Bei einer Mehrheitsentscheidung der fünf Experten wurde nur einer von 300 Artikeln falsch zugeordnet! Das ist eine Genauigkeitsrate, die beeindruckt.

Im Gegensatz dazu schnitten die „Laien“ deutlich schlechter ab. Ihre Fähigkeit, KI-Texte zu erkennen, lag kaum über dem Zufallsniveau. Dies unterstreicht, dass die reine Konfrontation mit Texten nicht ausreicht – es ist die aktive, wiederholte Auseinandersetzung und Nutzung von LLMs, die den Blick schärft. Die Experten scheinen durch ihre häufige Interaktion eine Art „sechsten Sinn“ für die typischen Muster und Artefakte von KI-generierten Inhalten entwickelt zu haben.

Mehr als nur „KI-Vokabular“: Die geheimen Signale der Experten

Doch was genau macht diese menschlichen Experten so gut? Die qualitative Analyse ihrer Begründungen offenbarte, dass sie weit über die oft zitierten lexikalischen Hinweise – das sogenannte „KI-Vokabular“ wie „entscheidend“, „wichtig“, „deutlich“, „Facetten“ oder „innovativ“ – hinausblicken. Sie achteten auf eine Kombination subtilerer Merkmale:

- Originalität und Engagement: KI-Texte wirken oft generisch, wenig überraschend oder postiv-verharmlosend. Experten bemerkten einen Mangel an kreativer Wortwahl, unerwarteten Wendungen oder echtem Witz. Ein Text, der eher „langweilt“ als „fesselt“, wurde eher der KI zugeschrieben.

- Formulierung und Satzstruktur: Typisch für KI sind oft sehr korrekte, aber manchmal auch übermäßig formelle oder verschachtelte Sätze. Auch eine gewisse Vorliebe für Aufzählungen (oft Dreier-Kombinationen) oder wiederkehrende Satzmuster („Nicht nur … sondern auch…“) fielen auf. Menschliche Texte weisen oft mehr Variation, auch mal umgangssprachliche Elemente oder sogar kleine grammatikalische „Unsauberkeiten“ auf.

- Klarheit und Kohärenz: Während KI-Texte meist logisch aufgebaut sind, fehlt ihnen manchmal die natürliche Klarheit oder der rote Faden, den ein menschlicher Autor durch geschicktes „Showing, not Telling“ erzeugt. Übererklärungen oder eine gewisse Oberflächlichkeit können Indizien sein.

- Einleitungen und Schlussfolgerungen: KI-generierte Intros neigen dazu, sehr allgemein oder „optimistisch-vage“ zu sein. Schlussfolgerungen sind oft repetitive Zusammenfassungen mit einem übertrieben positiven Ausblick, wie die Studie es nennt („testament,“ „beacon of hope,“ „demonstrating that anything is possible“). Menschliche Texte enden oft abrupter oder pointierter.

- Zitate und Namen: Von KI generierte Zitate klingen oft hölzern, zu perfekt formuliert oder spiegeln stilistisch exakt den Rest des Textes wider. Auch die Verwendung von generisch klingenden Namen (z.B. „Dr. Sarah Thompson“, „Dr. Emily Carter“ in früheren Modellen) oder die durchgängige Nutzung von Titeln (Dr., Prof.) für alle genannten Personen können Hinweise sein.

Zur Veranschaulichung hier eine kleine Gegenüberstellung, basierend auf den Erkenntnissen der Studie:

| Merkmal | Typisch für KI-Text (laut Experten) | Typisch für menschlichen Text (laut Experten) |

|---|---|---|

| Vokabular | „crucial“, „significant“, „delve“, „showcase“, „testament“, „vibrant“ | Breitere, teils spezifischere oder kreativere Wortwahl, auch mal „einfache“ Wörter |

| Satzbau | Oft sehr korrekt, formelhaft (z.B. Listen von drei), gleichförmig | Variantenreicher, auch mal kürzere/längere Sätze, Ellipsen, lockerer |

| Originalität | Generisch, vorhersehbar, „sicher“, wenig Humor/Überraschung | Kreative Analogien, unerwartete Wendungen, persönlicher Stil, Humor |

| Formalität | Oft sehr formal, kaum Umgangssprache, Kontraktionen oder Füllwörter | Kann formell sein, aber oft auch informelle Elemente, „echte“ Sprache |

| Einleitung/Schluss | Vage, optimistisch, zusammenfassend-wiederholend | Prägnanter, manchmal abrupt, individueller |

| Zitate | Hölzern, stilistisch angepasst an Text, oft generische Experten | Natürlicher, variierter, oft prägnant in den Text eingefügt |

| Grammatik/Fehler | Meist perfekt, keine „echten“ Fehler | Kann kleine Fehler, umgangssprachliche Verkürzungen enthalten |

| Tone | Oft neutral bis übertrieben positiv, wenig emotionale Tiefe | Breiteres Spektrum an Tonalitäten, auch mal kritisch oder ironisch |

Diese differenzierte Wahrnehmung macht deutlich, dass erfahrene Menschen eine holistischere Textanalyse vornehmen als viele aktuelle Software-Lösungen.

Hart im Nehmen: Menschliche Experten vs. Täuschungsmanöver

Besonders aufschlussreich war, wie die menschlichen Experten auf Versuche reagierten, die KI-Texte schwerer erkennbar zu machen. Die Forscher testeten zwei gängige Methoden:

- Paraphrasierung: Die ursprünglichen KI-Texte (von GPT-4o) wurden Satz für Satz von einer weiteren KI umformuliert.

- Humanisierung: Für Texte des fortschrittlichen o1-Pro-Modells wurde ein spezieller Prompt verwendet, der die KI anwies, typische KI-Artefakte zu vermeiden und einen menschlicheren Schreibstil zu imitieren (basierend auf einem „Guidebook“ aus früheren Expertenkommentaren).

Das Ergebnis: Die menschlichen Experten ließen sich auch hier kaum beirren! Ihre Erkennungsrate blieb auch bei paraphrasierten und „humanisierten“ Texten erstaunlich hoch. Der Mehrheitsentscheid der Expertengruppe lag selbst bei diesen schwierigen Fällen fast immer richtig.

Im direkten Vergleich mit automatischen Detektions-Tools (wie GPTZero, Binoculars, Fast-DetectGPT, RADAR) zeigten die menschlichen Experten eine überlegene oder mindestens gleichwertige Leistung. Lediglich der kommerzielle Detektor „Pangram Humanizers“, der speziell auf humanisierte Daten trainiert wurde, erreichte eine vergleichbar hohe Trefferquote wie die menschliche Expertengruppe. Die meisten Open-Source-Detektoren hatten insbesondere mit den humanisierten o1-Pro-Texten erhebliche Schwierigkeiten, während die menschlichen Experten hier brillierten.

How-To: Schärfe Deinen Blick – Werde selbst zum KI-Text-Detektiv

Die gute Nachricht der Studie ist: Die Fähigkeit, KI-Inhalte zu identifizieren, ist erlernbar – vor allem durch Praxis! Wenn Du selbst besser darin werden möchtest, achte auf folgende Aspekte, inspiriert von den Beobachtungen der Experten:

- Achte auf „KI-Vokabular“ und Füllphrasen: Wörter wie „darüber hinaus“, „im Grunde genommen“, „es ist wichtig zu verstehen“, „ein entscheidender Aspekt“, „nicht zu vergessen“ oder übermäßig viele Superlative können Warnsignale sein. Aber Vorsicht: Menschen nutzen sie auch, die Häufung und der Kontext sind entscheidend.

- Analysiere Satz- und Textstruktur: Sind Sätze oft ähnlich lang oder komplex aufgebaut? Gibt es viele passive Konstruktionen ohne klaren Grund? Wirkt die Gliederung sehr schematisch (z.B. immer eine Einleitung, drei Hauptargumente, ein Fazit)? Sind Einleitungen und Schlüsse besonders generisch oder blumig-optimistisch?

- Bewerte Originalität und „Seele“: Spricht der Text Dich emotional an? Bringt er neue, überraschende Perspektiven oder wirkt er wie eine gut sortierte, aber sterile Zusammenfassung bekannter Fakten? Fehlt ihm eine erkennbare „Stimme“ oder Persönlichkeit?

- Prüfe auf übermäßige Formalität oder unpassende Tonalität: Ist der Text durchgehend extrem formell, selbst wenn das Thema Lockerheit erlauben würde? Oder wirkt die Tonalität (z.B. durchgehende Positivität, auch bei schwierigen Themen) unpassend oder aufgesetzt?

- Sei skeptisch bei generisch wirkenden Zitaten und Experten: Klingen Zitate wie aus dem Lehrbuch und fügen sich nahtlos in den KI-Jargon ein? Werden Experten ohne spezifische, nachprüfbare Details genannt?

- Achte auf perfekte Fehlerlosigkeit: Während menschliche Texte oft kleine Tippfehler, grammatikalische Ungenauigkeiten oder stilistische Holprigkeiten aufweisen, sind KI-Texte oft makellos – manchmal zu makellos.

Regelmäßiges, bewusstes Lesen und das Hinterfragen von Texten schult Deinen Blick enorm.

Die Grenzen automatischer Detektoren – und wo der Mensch (noch) unschlagbar ist

Automatische KI-Detektoren haben durchaus ihre Berechtigung, besonders bei der schnellen Analyse großer Textmengen. Sie erkennen oft zuverlässig einfache, unveränderte KI-Texte. Die Studie zeigt jedoch auch ihre Grenzen:

- Anfälligkeit für Täuschung: Paraphrasierung und insbesondere Humanisierung können viele Tools austricksen.

- Mangelndes Kontextverständnis: Subtile Ironie, kulturelle Anspielungen oder komplexe argumentative Nuancen sind für Maschinen schwer zu fassen.

- „False Positives“: Manchmal werden auch menschliche Texte fälschlicherweise als KI-generiert markiert, besonders wenn sie sehr formell oder strukturiert sind.

Hier liegt die Stärke des Menschen: Ein erfahrener Leser versteht Kontext, erkennt stilistische Feinheiten und kann eine „Persönlichkeit“ im Text spüren oder deren Fehlen bemerken. Wie die Autoren der Studie, Russell et al. (2025), sinngemäß zusammenfassen: „Unsere Studie unterstreicht, dass erfahrene menschliche Annotatoren eine bemerkenswerte Fähigkeit besitzen, KI-generierte Texte zu erkennen, oft zuverlässiger als automatisierte Systeme, insbesondere wenn es um komplexe Texteigenschaften und Verschleierungstaktiken geht.“ Dieses menschliche Gespür für ChatGPT Texte erkennen und andere LLM-Outputs ist ein wertvolles Gut.

How-To: Dein Fahrplan zur besseren KI-Text-Erkennung im Alltag

Möchtest Du Deine Fähigkeiten im KI-Texte erkennen gezielt verbessern? Hier ist Dein praktischer Fahrplan:

- Nutze LLMs aktiv und reflektiert: Der Schlüssel der Experten in der Studie war ihre häufige Nutzung von LLMs für Schreibaufgaben. Probiere selbst aus, Texte mit ChatGPT, Claude & Co. zu generieren. Experimentiere mit verschiedenen Prompts und analysiere die Ergebnisse kritisch. So entwickelst Du ein Gefühl für ihre „Sprache“.

- Vergleiche bewusst: Nimm Dir einen von Menschen geschriebenen Artikel (z.B. von einer renommierten Nachrichtenseite) und lasse eine KI einen Text zum selben Thema generieren. Vergleiche Stil, Struktur, Wortwahl und Inhalt. Wo liegen die Unterschiede?

- Führe eine „Clue-Liste“: Notiere Dir typische Formulierungen, Strukturmerkmale oder stilistische Auffälligkeiten, die Dir bei KI-Texten begegnen. Diese persönliche Datenbank an Erfahrungswerten ist Gold wert.

- Achte auf den „Flow“ und die „Tiefe“: Wirkt ein Text oberflächlich oder wiederholt er nur bekannte Informationen, ohne neue Einsichten oder eine tiefere Auseinandersetzung zu bieten? Menschliche Experten bringen oft eine einzigartige Perspektive oder recherchierte Details ein, die einer KI (noch) fehlen.

- Diskutiere Deine Beobachtungen: Tausche Dich mit anderen Nutzern über Eure Erfahrungen mit KI-Texten aus. Welche Muster habt ihr erkannt? Welche Texte wirkten besonders „menschlich“ oder „künstlich“?

Je mehr Du Dich aktiv mit der Materie beschäftigst, desto geschulter wird Dein Auge.

Die Zukunft der KI-Text-Erkennung: Mensch und Maschine im Team?

Die Studie untersuchte auch, ob LLMs selbst als Detektoren fungieren können, wenn man sie mit einem „Guidebook“ (einer Art Checkliste basierend auf Experten-Hinweisen) promptet. Die Ergebnisse waren vielversprechend und übertrafen einige Open-Source-Detektoren, erreichten aber nicht die Performance der menschlichen Experten oder der besten kommerziellen Tools, insbesondere bei humanisierten Texten.

Das deutet darauf hin, dass die Zukunft der KI-Text-Erkennung möglicherweise in einer cleveren Kombination aus menschlicher Expertise und maschineller Unterstützung liegt. Menschen könnten für die nuancierten Fälle und die qualitative Bewertung zuständig sein, während Tools große Mengen vorsortieren oder auf bekannte Muster scannen.

Unabhängig von technologischen Fortschritten bleibt die Sensibilisierung und Schulung der menschlichen Urteilsfähigkeit entscheidend. In einer Welt, in der Desinformation und authentisch wirkende Fälschungen zunehmen, ist die Fähigkeit, die Herkunft von Informationen kritisch zu hinterfragen und KI-Inhalte zu identifizieren, eine Schlüsselkompetenz.

Häufig gestellte Fragen – KI-Texte erkennen

Können Menschen KI-Texte besser erkennen als Software? Ja, laut der hier vorgestellten Studie (Russell et al., 2025) können Menschen, die häufig LLMs für Schreibaufgaben nutzen, KI-generierte Texte oft zuverlässiger erkennen als viele automatische Detektoren. Ihre Fähigkeit, subtile Muster und Kontext zu verstehen, gibt ihnen einen Vorteil, besonders bei geschickt getarnten Texten.

Woran erkennt man KI-generierte Texte am häufigsten? Experten achten auf eine Kombination von Faktoren: typisches „KI-Vokabular“ (z.B. „crucial“, „delve“, „showcase“), eine oft sehr korrekte, aber formelhafte Satzstruktur, mangelnde Originalität oder emotionale Tiefe, generische Einleitungen und optimistisch-verallgemeinernde Schlussfolgerungen sowie manchmal unnatürlich klingende Zitate.

Sind KI-Detektoren nutzlos, wenn Texte paraphrasiert oder humanisiert werden? Nicht völlig nutzlos, aber ihre Effektivität sinkt oft erheblich. Die Studie zeigte, dass viele automatische Detektoren durch Paraphrasierung und insbesondere durch „Humanisierung“ (Anpassung an menschlichen Stil) getäuscht werden können. Menschliche Experten zeigten sich hier deutlich robuster.

Welche Rolle spielt die Erfahrung mit ChatGPT & Co. bei der Erkennung? Eine sehr große. Die Studie belegt, dass Personen, die LLMs wie ChatGPT häufig und aktiv für Schreibprozesse nutzen, eine signifikant bessere Erkennungsleistung haben als Laien. Diese praktische Erfahrung schult den Blick für die typischen Charakteristika von KI-Texten.

Warum ist die Unterscheidung zwischen Mensch und KI-Text überhaupt wichtig? Die Unterscheidung ist entscheidend für die Glaubwürdigkeit von Informationen, die Bekämpfung von Desinformation, den Schutz des Urheberrechts und die Wahrung akademischer Integrität. Zu wissen, ob ein Text von einem Menschen mit echter Expertise oder einer KI stammt, beeinflusst, wie wir Informationen bewerten und nutzen.

Fazit: Deine Erfahrung ist der Schlüssel im Umgang mit KI-Texten

Die Studie von Russell, Karpinska und Iyyer aus dem Jahr 2025 sendet ein starkes Signal: Im Wettlauf um die Erkennung von KI-generierten Texten ist die menschliche Expertise, insbesondere die von erfahrenen Nutzern, ein oft unterschätzter, aber ungemein mächtiger Faktor. Während automatische Detektoren wichtige Werkzeuge sind, zeigt sich ihre Anfälligkeit, sobald KI-Texte geschickter aufbereitet werden durch Paraphrasierung oder Humanisierung. Hier brillieren Menschen, die durch ihre häufige Interaktion mit Modellen wie GPT-4o, Claude oder o1-Pro ein feines Gespür für deren „Handschrift“ entwickelt haben.

Die Fähigkeit, KI-Texte zu erkennen, ist mehr als eine technische Spielerei. Sie ist ein Baustein für Medienkompetenz im digitalen Zeitalter. Es geht darum, die Authentizität und Vertrauenswürdigkeit von Informationen einschätzen zu können. Die Erkenntnis, dass Du als aktiver Nutzer von LLMs potenziell über eine „eingebaute Superkraft“ zur Detektion verfügst, ist dabei sowohl faszinierend als auch ermutigend. Diese menschliche Intuition, gepaart mit analytischem Blick auf Vokabular, Struktur, Originalität und Tonalität, macht den Unterschied.

Die Entwicklung von KI-Sprachmodellen schreitet unaufhaltsam voran, und ihre Outputs werden immer ausgefeilter. Doch parallel dazu wächst auch das Verständnis und die Erfahrung der Menschen, die mit ihnen arbeiten. Die Studie gibt Anlass zur Zuversicht, dass menschliche Wachsamkeit und Expertise auch weiterhin eine zentrale Rolle spielen werden, um die digitale Informationslandschaft kritisch zu navigieren. Indem Du Deinen Blick schulst und die Mechanismen hinter KI-Inhalten identifizierst und verstehst, stärkst Du nicht nur Deine eigene Urteilsfähigkeit, sondern trägst auch zu einem bewussteren Umgang mit Künstlicher Intelligenz bei. Deine Erfahrung zählt – mehr denn je.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Russell, J., Karpinska, M., & Iyyer, M. (2025). People who frequently use ChatGPT for writing tasks are accurate and robust detectors of AI-generated text. arXiv:2501.15654 [cs.CL]. Verfügbar unter: https://doi.org/10.48550/arXiv.2501.15654

#KITexteErkennen #AIDetection #MenschVsMaschine #KuenstlicheIntelligenz #LLM #GPT4o #Studie #TechNews #KINEWS24 #ContentAuthenticity