Mistral AI hat mit Mistral Small 3 ein neues, hochperformantes Sprachmodell vorgestellt, das speziell für schnelle und effiziente KI-Anwendungen entwickelt wurde. Dieses Modell, das unter der Apache 2.0 Lizenz veröffentlicht wurde, ist eine echte Alternative zu größeren, oft proprietären Modellen. Es zeichnet sich durch seine geringe Latenz, seine hohe Genauigkeit und seine Fähigkeit aus, auch auf lokaler Hardware zu laufen. Lass uns gemeinsam in die Details eintauchen und herausfinden, was Mistral Small 3 so besonders macht.

Das ist auch deswegen bemerkenswert, weil Mistral Le Chat gerade erste eine Partnerschaft mit der AFP geschlossen hat. Damit gibt es Zugriff auf 40 Millionen Artikel und über 3.000 tägliche Nachrichten. Direkt im Chat.

Das musst Du wissen – Mistral Small 3 im Überblick

- Leistungsstark: Mistral Small 3 konkurriert mit größeren Modellen wie Llama 3.3 70B und Qwen 32B, ist aber deutlich schneller.

- Effizient: Mit über 81% Genauigkeit auf MMLU und 150 Tokens/s ist es eines der effizientesten Modelle seiner Kategorie.

- Open Source: Veröffentlicht unter der Apache 2.0 Lizenz, ermöglicht es dir, das Modell frei zu nutzen, anzupassen und zu modifizieren.

Was macht Mistral Small 3 so besonders?

Mistral Small 3 ist ein 24-Milliarden-Parameter-Modell, das sowohl als vortrainiertes als auch als instruktionsfeinabgestimmtes Modell verfügbar ist. Es wurde entwickelt, um die „80%“ der generativen KI-Aufgaben abzudecken, die eine robuste Sprach- und Instruktionsfolgeleistung mit sehr geringer Latenz erfordern. Das Modell ist besonders geeignet für Szenarien, in denen schnelle, präzise Antworten entscheidend sind.

Folgefragen (FAQs)

- Welche Vorteile bietet Mistral Small 3 gegenüber größeren Modellen?

- Für welche Anwendungsfälle ist Mistral Small 3 besonders geeignet?

- Wie kann ich Mistral Small 3 lokal auf meiner Hardware ausführen?

- Welche Benchmarks wurden für Mistral Small 3 durchgeführt?

- Wie kann ich Mistral Small 3 in meine Projekte integrieren?

- Welche Lizenzbedingungen gelten für Mistral Small 3?

- Wo finde ich die notwendigen Ressourcen und Tools für den Einsatz von Mistral Small 3?

- Welche Rolle spielt die Open-Source-Community bei der Weiterentwicklung von Mistral Small 3?

Antworten auf jede Frage

Welche Vorteile bietet Mistral Small 3 gegenüber größeren Modellen?

Mistral Small 3 bietet mehrere Vorteile gegenüber größeren Modellen:

- Geringere Latenz: Das Modell ist deutlich schneller als vergleichbare Modelle wie Llama 3.3 70B, was es ideal für Echtzeit-Anwendungen macht.

- Effizienz: Mit einer Genauigkeit von über 81% auf MMLU und einer Geschwindigkeit von 150 Tokens/s ist es sehr effizient in Bezug auf Rechenleistung und Speicherbedarf.

- Lokale Ausführung: Mistral Small 3 kann, wenn es quantisiert wird, auf einer einzigen RTX 4090 oder einem MacBook mit 32 GB RAM ausgeführt werden, was es auch für Hobbyisten und Organisationen mit sensiblen Daten zugänglich macht.

- Kosten: Da es auf lokaler Hardware betrieben werden kann, können Kosten für Cloud-basierte Dienste reduziert werden.

- Open Source: Die Apache 2.0 Lizenz ermöglicht eine freie Nutzung und Modifizierung des Modells, was Innovationen und Anpassungen durch die Community fördert.

Für welche Anwendungsfälle ist Mistral Small 3 besonders geeignet?

Mistral Small 3 ist vielseitig einsetzbar und eignet sich besonders gut für:

- Schnelle Konversationsassistenten: Ideal für virtuelle Assistenten und Chatbots, die schnelle und genaue Antworten liefern müssen.

- Funktionsaufrufe mit geringer Latenz: Geeignet für automatisierte oder agentenbasierte Workflows, die eine schnelle Ausführung von Funktionen erfordern.

- Feinabstimmung für Fachexperten: Kann für spezifische Bereiche wie Rechtsberatung, medizinische Diagnostik oder technischen Support trainiert werden, um hochgenaue Fachexperten zu erstellen.

- Lokale Inferenz: Besonders nützlich für Hobbyisten und Organisationen, die sensible oder proprietäre Informationen verarbeiten.

- Finanzdienstleistungen: Für Betrugserkennung.

- Gesundheitswesen: Für die Triage von Patienten.

- Robotik, Automobilindustrie und Fertigung: Für die Befehls- und Steuerung von Geräten.

- Sentiment- und Feedbackanalyse: Zur Analyse von Kundenfeedback.

Wie kann ich Mistral Small 3 lokal auf meiner Hardware ausführen?

Mistral Small 3 kann lokal auf einer einzigen RTX 4090 oder einem MacBook mit 32 GB RAM ausgeführt werden, wenn es quantisiert wird. Hier sind die Schritte:

- Installation von vLLM: Stelle sicher, dass du vLLM >= 0.6.4 installiert hast:

pip install --upgrade vllmcontent_copydownloadUse code with caution. - Installation von mistral_common: Installiere mistral_common >= 1.5.2:

pip install --upgrade mistral_commoncontent_copydownloadUse code with caution. - Server starten: Verwende vLLM, um einen Server zu starten:

vllm serve mistralai/Mistral-Small-24B-Instruct-2501 --tokenizer_mode mistral --config_format mistral --load_format mistral --tool-call-parser mistral --enable-auto-tool-choicecontent_copydownloadUse code with caution.Beachte, dass das Ausführen des Modells auf der GPU etwa 55 GB GPU-RAM in bf16 oder fp16 erfordert. - Client-Verbindung: Verwende ein Python-Snippet, um mit dem Server zu kommunizieren. Ein Beispiel dafür findest du in den Quellen.

- Ollama: Du kannst das Modell auch mit Ollama lokal ausführen. Die Befehle dafür findest du in den Quellen.

Welche Benchmarks wurden für Mistral Small 3 durchgeführt?

Mistral AI hat umfangreiche Benchmarks durchgeführt, um die Leistung von Mistral Small 3 zu bewerten. Hier sind einige der wichtigsten Ergebnisse:

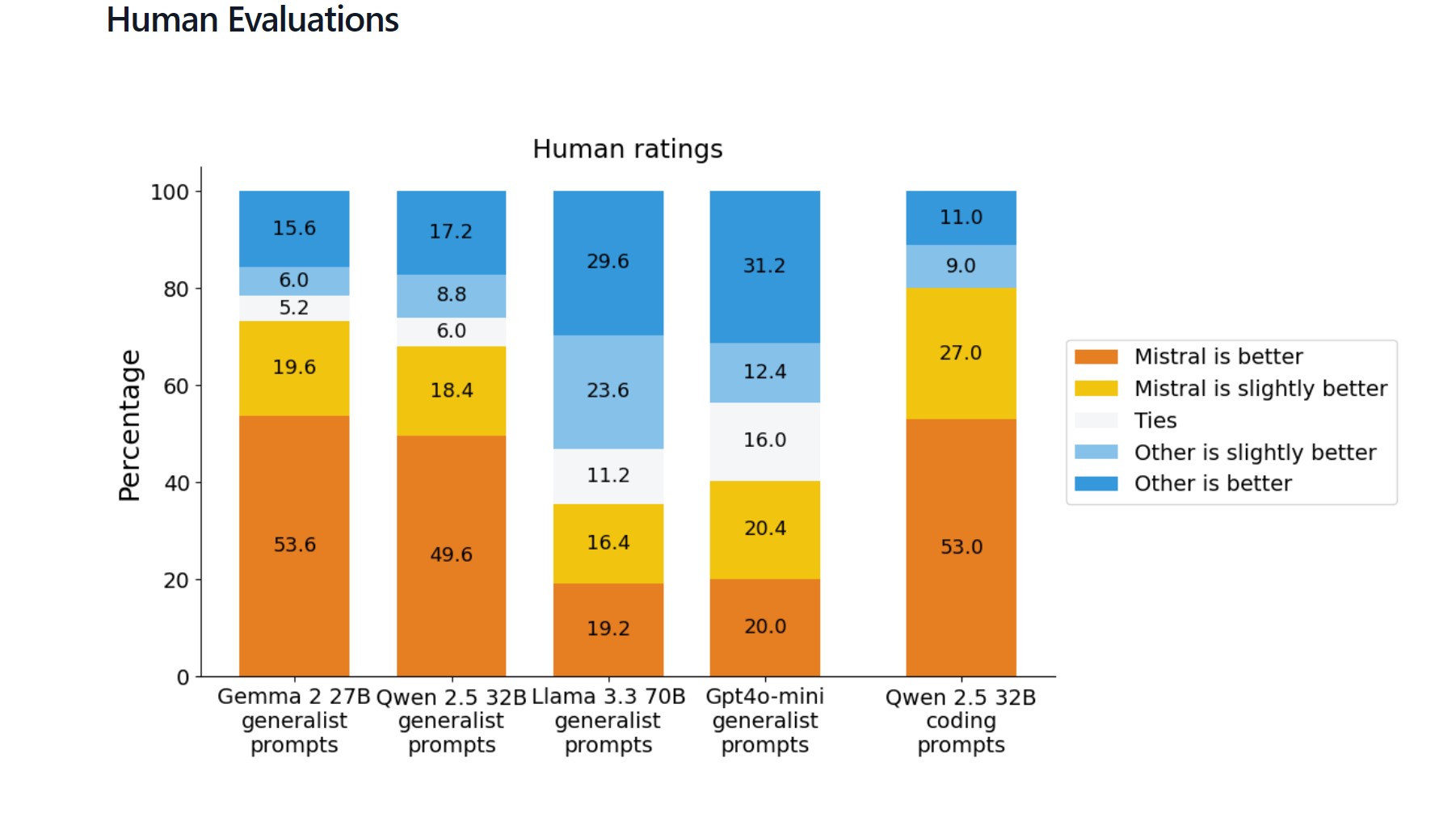

- Human Evaluations: In direkten Vergleichen mit anderen Modellen wurden Evaluatoren gebeten, die bevorzugte Antwort aus anonymisierten Generationen von Mistral Small 3 und einem anderen Modell auszuwählen. Mistral Small 3 schnitt dabei sehr gut ab.

- Publicly Accessible Benchmarks:

- MMLU (Massive Multitask Language Understanding): Mistral Small 3 erreichte 0.663.

- GPQA (General Purpose Question Answering): Mistral Small 3 erreichte 0.453.

- HumanEval: Mistral Small 3 erreichte 0.848.

- Math: Mistral Small 3 erreichte 0.706.

- MTBench: Mistral Small 3 erreichte 8.35.

- Wildbench: Mistral Small 3 erreichte 52.27.

- Arena Hard: Mistral Small 3 erreichte 0.873.

- IFEval: Mistral Small 3 erreichte 0.829.

Diese Benchmarks zeigen, dass Mistral Small 3 in verschiedenen Bereichen, wie z.B. Reasoning, Coding und Instruction Following, sehr wettbewerbsfähig ist.

Wie kann ich Mistral Small 3 in meine Projekte integrieren?

Du kannst Mistral Small 3 mit verschiedenen Frameworks und Tools in deine Projekte integrieren:

- vLLM: Für produktionsreife Inferenzpipelines wird vLLM empfohlen.

- Transformers: Du kannst Hugging Face Transformers verwenden, um Text zu generieren.

- Ollama: Ollama ermöglicht die lokale Ausführung auf MacOS, Windows und Linux.

- Hugging Face: Das Basismodell ist auf Hugging Face verfügbar.

- Weitere Plattformen: Das Modell ist auch auf Ollama, Kaggle, Together AI, Fireworks AI und IBM watsonx verfügbar. Es wird bald auch auf NVIDIA NIM, Amazon SageMaker, Groq, Databricks und Snowflake verfügbar sein.

Welche Lizenzbedingungen gelten für Mistral Small 3?

Mistral Small 3 wird unter der Apache 2.0 Lizenz veröffentlicht. Diese Open-Source-Lizenz erlaubt dir, das Modell frei zu nutzen, anzupassen und zu modifizieren, sowohl für kommerzielle als auch für nicht-kommerzielle Zwecke. Dies fördert die Innovation und ermöglicht es der Community, das Modell weiterzuentwickeln.

Wo finde ich die notwendigen Ressourcen und Tools für den Einsatz von Mistral Small 3?

Die notwendigen Ressourcen und Tools findest du hier:

- Mistral AI Blog: https://mistral.ai/news/mistral-small-3

- Hugging Face: https://huggingface.co/mistralai/Mistral-Small-24B-Instruct-2501

- vLLM Documentation: (Link in den Quellen)

- Transformers Documentation: (Link in den Quellen)

- Ollama: (Link in den Quellen)

Welche Rolle spielt die Open-Source-Community bei der Weiterentwicklung von Mistral Small 3?

Die Open-Source-Community spielt eine entscheidende Rolle bei der Weiterentwicklung von Mistral Small 3. Durch die Apache 2.0 Lizenz können Entwickler das Modell frei nutzen, anpassen und verbessern. Die Community kann dazu beitragen, neue Anwendungsfälle zu entdecken, die Leistung des Modells zu optimieren und es an spezifische Bedürfnisse anzupassen. Mistral AI ermutigt die Community, das Modell zu hacken und es besser zu machen.

Konkrete Tipps und Anleitungen

Hier sind einige praktische Tipps und Anleitungen, die dir bei der Verwendung von Mistral Small 3 helfen können:

- Verwende eine niedrige Temperatur: Für eine höhere Genauigkeit empfiehlt es sich, eine niedrige Temperatur (z.B. 0.15) zu verwenden.

- Füge einen System Prompt hinzu: Ein System Prompt hilft dem Modell, sich besser an deine Bedürfnisse anzupassen. Ein Beispiel für einen System Prompt findest du in den Quellen.

- Nutze vLLM für die Produktion: vLLM ist ideal für die Implementierung von produktionsreifen Inferenzpipelines.

- Experimentiere mit verschiedenen Frameworks: Probiere verschiedene Frameworks wie Transformers und Ollama aus, um die beste Lösung für deine Anforderungen zu finden.

- Nutze die Community: Tausche dich mit anderen Entwicklern in der Community aus, um neue Ideen und Lösungen zu finden.

Fazit: Mistral Small 3 – Dein Schlüssel zu effizienter KI

Mistral Small 3 ist ein beeindruckendes Sprachmodell, das durch seine Effizienz, Geschwindigkeit und Flexibilität überzeugt. Es ist eine hervorragende Wahl für eine Vielzahl von Anwendungen, von schnellen Konversationsassistenten bis hin zu spezialisierten Fachexperten. Die Open-Source-Lizenz ermöglicht es dir, das Modell frei zu nutzen und anzupassen, während die Community ständig an der Weiterentwicklung arbeitet.

Ob du nun ein Hobbyist, ein Entwickler oder ein Unternehmen bist, Mistral Small 3 bietet dir die Werkzeuge, um deine KI-Projekte auf ein neues Level zu heben. Mit seiner Fähigkeit, lokal auf gängiger Hardware zu laufen, ist es zudem eine kosteneffiziente und datenschutzfreundliche Option. Nutze die vielfältigen Integrationsmöglichkeiten und die Kraft der Open-Source-Community, um das volle Potenzial dieses Modells auszuschöpfen. Die Zukunft der KI ist jetzt zugänglich und flexibel – mit Mistral Small 3.

https://KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar. Hier kannst Du Dich in einer aktiven Community austauschen und KI lernen.

Quellen

- Mistral AI Blog: https://mistral.ai/news/mistral-small-3

- Hugging Face: https://huggingface.co/mistralai/Mistral-Small-24B-Instruct-2501

- vLLM Documentation

- Ollama

#AI #KI #ArtificialIntelligence #KuenstlicheIntelligenz #MistralSmall3 #OpenSourceAI #LanguageModel #MachineLearning