OpenAI GPT-OSS: OpenAI bricht mit einer jahrelangen Tradition: Am 5. August 2025 hat das KI-Unternehmen mit GPT-OSS erstmals seit über fünf Jahren wieder „offene“ KI-Modelle veröffentlicht. Dieser strategische Schritt wirbelt den Markt auf und ist eine direkte Antwort auf den wachsenden Druck durch Konkurrenten aus China und die politischen Forderungen aus Washington. Wir haben für dich analysiert, was die neuen Modelle gpt-oss-120b und gpt-oss-20b wirklich können, für wen sie sich eignen und was hinter diesem plötzlichen Strategiewechsel steckt.

Nach dieser Meldung vom frühen Morgen Warum OpenAI jetzt auf dein Wohlbefinden setzt (und was das für dich bedeutet) waren wir sicher – da kommt noch was. Nun haben wir OpenAI GPT-OSS bekommen. Schauen wir es uns an!

Das Wichtigste in Kürze – OpenAI’s neue GPT-OSS-Modelle

- Zwei neue Modelle: OpenAI hat

gpt-oss-120b(für GPUs) undgpt-oss-20b(für Consumer-Laptops) als „Open-Weight“-Modelle veröffentlicht, die kostenlos zum Download auf Hugging Face bereitstehen. - Strategischer Wechsel: Es ist die erste Open-Source-Initiative seit GPT-2 (2019) und eine Reaktion auf die Dominanz chinesischer Anbieter sowie politische Wünsche nach KI-Technologie nach westlichen Werten.

- Hohe Leistung: In Benchmarks übertreffen die Modelle führende Open-Source-Konkurrenten wie DeepSeek, bleiben aber hinter OpenAIs eigenen geschlossenen Modellen (

o3,o4-mini) zurück. - Kontrollierte Offenheit: Die Modelle werden unter der sehr freizügigen Apache-2.0-Lizenz veröffentlicht, die kommerzielle Nutzung erlaubt. Die Trainingsdaten bleiben jedoch geheim.

- Bekannte Schwäche: Die Modelle neigen deutlich stärker zu Halluzinationen als ihre größeren, proprietären Gegenstücke – ein bewusster Kompromiss für mehr Zugänglichkeit.

Was sind die neuen GPT-OSS Modelle von OpenAI?

Nach Jahren der Fokussierung auf geschlossene, proprietäre Systeme wie die GPT- und o-Serien, die über APIs monetarisiert wurden, macht OpenAI eine Kehrtwende. Die neu vorgestellten Modelle sind sogenannte „Open-Weight“-Modelle. Das bedeutet, ihre trainierten Parameter sind frei zugänglich, was Entwicklern und Forschern weltweit erlaubt, sie herunterzuladen, anzupassen und auf eigener Hardware auszuführen.

OpenAI stellt zwei Varianten zur Verfügung, um unterschiedliche Anwendungsfälle abzudecken:

- gpt-oss-120b: Das größere und leistungsfähigere Modell. Es besitzt 117 Milliarden Parameter, nutzt aber dank einer Mixture-of-Experts (MoE)-Architektur pro Anfrage nur 5,1 Milliarden aktive Parameter. Dadurch läuft es effizient auf einer einzigen professionellen NVIDIA-GPU.

- gpt-oss-20b: Die leichtgewichtige Version. Sie ist so konzipiert, dass sie auch auf handelsüblichen Laptops mit 16 GB Arbeitsspeicher lauffähig ist und somit einer breiten Masse von Entwicklern den Einstieg ermöglicht.

Beide Modelle sind reine Textmodelle und können keine Bilder oder Audio verarbeiten. Ihre große Stärke liegt laut OpenAI im sogenannten „Reasoning“ und der Fähigkeit, als KI-Agenten zu agieren. Sie können externe Werkzeuge wie die Websuche oder einen Python-Code-Interpreter ansteuern, um komplexe Aufgaben in einem logischen Schritt-für-Schritt-Prozess (Chain-of-Thought) zu lösen.

Strategischer Paukenschlag: Warum OpenAI jetzt auf „Open“ setzt

Der Zeitpunkt der Veröffentlichung ist kein Zufall. Er ist das Ergebnis einer Kombination aus Marktdruck und politischem Kalkül. CEO Sam Altman gab bereits im Januar 2025 zu, dass OpenAI in Bezug auf Open Source „auf der falschen Seite der Geschichte“ gestanden habe.

Drei Hauptgründe treiben diesen Wandel an:

- Der Aufstieg Chinas: KI-Labore wie DeepSeek, Qwen (von Alibaba) und Moonshot AI haben in den letzten Monaten den Open-Source-Bereich dominiert und technologisch beeindruckende Modelle veröffentlicht. OpenAI drohte hier den Anschluss zu verlieren.

- Politischer Druck: Die Trump-Administration forderte im Juli 2025 US-amerikanische KI-Unternehmen explizit auf, mehr Technologie als Open Source bereitzustellen. Das Ziel: Die globale Verbreitung von KI zu fördern, die auf „amerikanischen Werten“ basiert.

- Rückbesinnung auf die Mission: Altman betont, dass die ursprüngliche Mission von OpenAI darin bestehe, „sicherzustellen, dass AGI der gesamten Menschheit zugutekommt“. Ein offener KI-Stack, der in den USA entwickelt wurde, soll diesem Ziel dienen.

Mit GPT-OSS versucht OpenAI also, Entwicklerherzen zurückzugewinnen, geopolitischen Forderungen nachzukommen und seine Position im globalen KI-Wettbewerb zu festigen.

GPT-OSS im Leistungs-Check: So schlagen sich die Modelle gegen die Konkurrenz

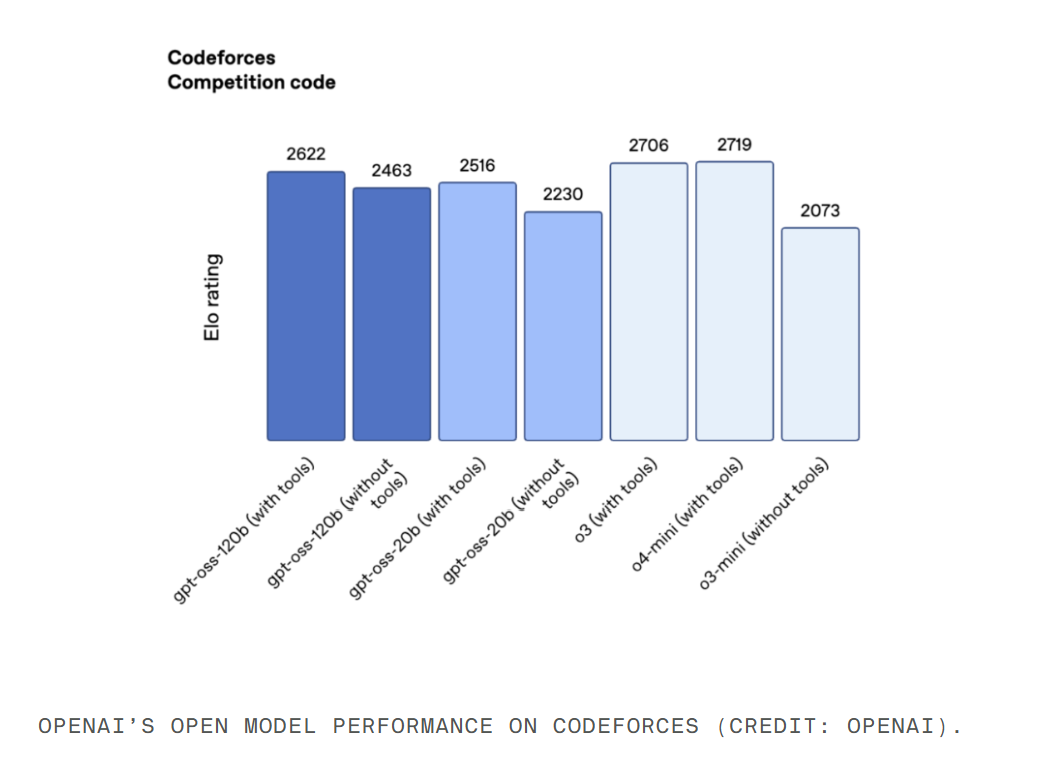

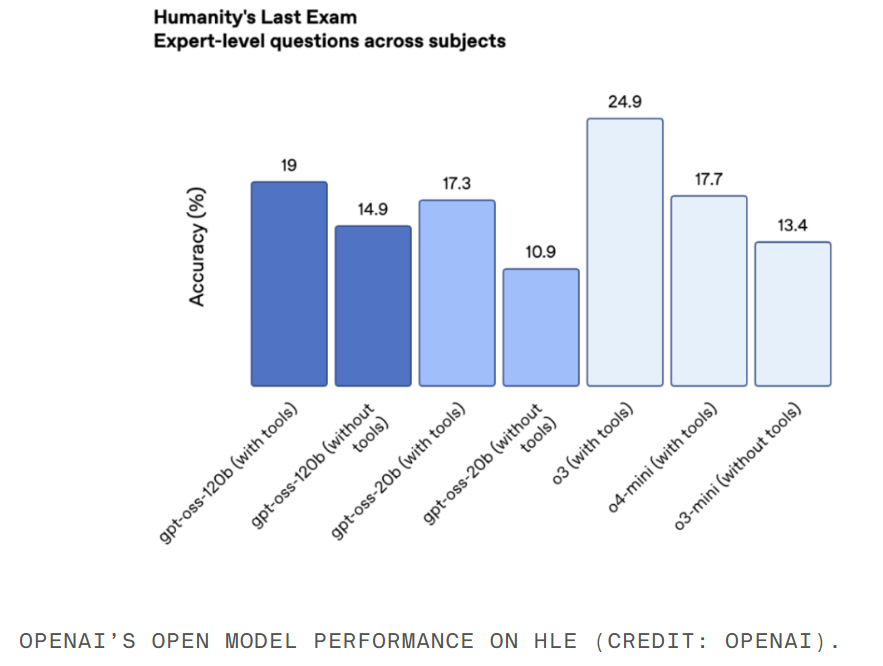

OpenAI behauptet, die GPT-OSS-Modelle seien „State-of-the-Art“ unter den offenen Modellen. Die veröffentlichten Benchmarks stützen diese Aussage, zeigen aber auch klare Grenzen auf.

| Benchmark | gpt-oss-120b | gpt-oss-20b | DeepSeek R1 | OpenAI o3/o4-mini |

| Codeforces (Coding-Test) | 2.622 | 2.516 | Unterlegen | Unterlegen |

| HLE (Allgemeinwissen) | 19,0 % | 17,3 % | Überlegen | Unterlegen |

| PersonQA (Halluzinationen) | 49 % | 53 % | Nicht verglichen | Deutlich höher als o1 (16%) |

In Google Sheets exportieren

Die Kernaussagen der Benchmarks:

- Stark im Coding: Im kompetitiven Programmiertest Codeforces übertreffen beide GPT-OSS-Modelle den Konkurrenten DeepSeek R1, reichen aber nicht an die Leistung der hauseigenen Modelle o3 und o4-mini heran.

- Solides Allgemeinwissen: Im anspruchsvollen Wissenstest HLE (Humanity’s Last Exam) schlagen sie ebenfalls die offenen Modelle von DeepSeek und Qwen, bleiben aber deutlich hinter o3 zurück.

- Spitze unter den Offenen: Die Ergebnisse positionieren GPT-OSS an die Spitze der aktuell verfügbaren Open-Source-Modelle, was OpenAI das gewünschte Prestige im Entwickler-Ökosystem sichert.

How-To: So startest Du mit den GPT-OSS-Modellen

Der Einstieg in die Welt der neuen OpenAI-Modelle ist unkompliziert. Wenn du selbst mit gpt-oss experimentieren möchtest, folge diesen Schritten:

- Wähle das richtige Modell: Entscheide dich zwischen

gpt-oss-120b(wenn du eine leistungsstarke NVIDIA-GPU besitzt) undgpt-oss-20b(wenn du auf einem gut ausgestatteten Laptop oder einer schwächeren Maschine arbeiten möchtest). - Prüfe die Hardware-Anforderungen: Stelle sicher, dass dein System die Voraussetzungen erfüllt. Für das 20b-Modell benötigst du mindestens 16 GB RAM. Für das 120b-Modell ist eine dedizierte GPU mit ausreichend VRAM entscheidend.

- Besuche Hugging Face: Die Modelle sind auf der Entwicklerplattform Hugging Face frei verfügbar. Suche dort nach „gpt-oss“ von OpenAI und folge den Anweisungen zum Download.

- Verstehe die Lizenz: Die Modelle stehen unter der Apache-2.0-Lizenz. Das gibt dir enorme Freiheit: Du darfst die Modelle verändern, weiterverteilen und sogar in kommerziellen Produkten einsetzen, ohne Lizenzgebühren an OpenAI zahlen zu müssen.

Die große Schwäche: Das Halluzinations-Problem und seine Ursachen

Ein entscheidender Nachteil der neuen Modelle ist ihre hohe Halluzinationsrate. In einem internen Test (PersonQA), der die Genauigkeit von Wissen über Personen misst, gaben gpt-oss-120b in 49 % und gpt-oss-20b sogar in 53 % der Fälle halluzinierte, also falsche, Antworten.

Zum Vergleich: OpenAIs älteres o1-Modell lag bei 16 %, das aktuelle o4-mini bei 36 %.

OpenAI erklärt diesen Unterschied offen: „Dies ist zu erwarten, da kleinere Modelle weniger Weltwissen als große Frontier-Modelle besitzen und tendenziell mehr halluzinieren.“ Es ist ein direkter Kompromiss: Geringere Größe und Hardware-Anforderungen werden mit einer geringeren faktischen Zuverlässigkeit erkauft. Für Entwickler bedeutet das: Jede Ausgabe dieser Modelle muss kritisch geprüft und idealerweise durch externe Fakten-Checks validiert werden, besonders in sensiblen Anwendungsbereichen.

„Open-Source-Light“: Was die Apache-2.0-Lizenz wirklich bedeutet

OpenAI wählt mit der Apache-2.0-Lizenz einen sehr entwicklerfreundlichen Weg. Sie gilt als eine der freizügigsten Lizenzen und erlaubt die kommerzielle Nutzung ohne Gegenleistung. Das ist ein starkes Signal an die Community.

Allerdings gibt es einen entscheidenden Haken, der GPT-OSS zu einer Art „Open-Source-Light“ macht: OpenAI veröffentlicht die Trainingsdaten nicht.

Diese Entscheidung ist nachvollziehbar, da das Unternehmen mit mehreren Klagen wegen Urheberrechtsverletzungen bei Trainingsdaten konfrontiert ist. Für die Forschungsgemeinschaft bedeutet es jedoch, dass eine vollständige Replikation oder eine tiefgehende Analyse der Trainingsprozesse unmöglich ist. Die volle Transparenz, die sich Puristen wünschen, bleibt aus.

Häufig gestellte Fragen – OpenAI GPT-OSS

Was ist der Unterschied zwischen einem Open-Weight- und einem Open-Source-Modell? Ein „Open-Weight“-Modell stellt die trainierten Gewichte (Parameter) des Modells zur Verfügung, sodass jeder es ausführen und anpassen kann. Ein vollständiges „Open-Source“-Projekt würde zusätzlich den Quellcode für das Training und die Trainingsdatensätze offenlegen. OpenAI macht hier nur den ersten Schritt.

Wie schneiden die GPT-OSS-Modelle im Vergleich zu Metas Llama ab? Die TechCrunch-Analyse deutet darauf hin, dass die Llama-Modelle von Meta im letzten Jahr technologisch etwas ins Hintertreffen geraten sind. Die neuen GPT-OSS-Modelle positionieren sich laut den Benchmarks von OpenAI an der Spitze der aktuellen Open-Source-Konkurrenz und dürften daher leistungsfähiger als die bisherigen Llama-Generationen sein.

Kann ich mit den GPT-OSS-Modellen Geld verdienen? Ja. Die Apache-2.0-Lizenz erlaubt explizit die kommerzielle Nutzung. Du kannst auf Basis dieser Modelle eigene Anwendungen, Produkte oder Dienstleistungen entwickeln und diese verkaufen, ohne OpenAI dafür bezahlen zu müssen.

Sind die Modelle sicher? OpenAI hat die Modelle auf Missbrauchspotenzial getestet, etwa für Cyberangriffe oder die Entwicklung biologischer Waffen. Zwar wurde eine „marginale“ Steigerung der Fähigkeiten im biologischen Bereich festgestellt, aber die Modelle erreichten auch nach gezieltem Fine-Tuning keine als hochriskant eingestufte Gefahrenschwelle.

Fazit und Ausblick: Ein notwendiger Schritt mit strategischem Kalkül

Mit der Veröffentlichung von gpt-oss-120b und gpt-oss-20b vollzieht OpenAI einen überfälligen und strategisch cleveren Schachzug. Die neuen Open-Source-Modelle sind nicht nur ein Friedensangebot an die Entwickler-Community, sondern auch eine machtpolitische Demonstration gegenüber der Konkurrenz aus China und ein Entgegenkommen an die Politik in Washington.

Technologisch setzen sich die Modelle an die Spitze des Open-Source-Feldes, auch wenn sie die Leistung von OpenAIs eigenen Flaggschiff-Modellen nicht erreichen. Der Preis dafür ist eine spürbar höhere Halluzinationsrate, die Entwickler im Auge behalten müssen.

Die „kontrollierte Offenheit“ – freie Gewichte unter Apache-2.0-Lizenz, aber ohne Trainingsdaten – ist ein pragmatischer Kompromiss, der OpenAI maximale positive Resonanz bei minimalem rechtlichen Risiko verschafft. Für dich als Entwickler, Forscher oder technikbegeisterter Anwender bedeutet dies vor allem eines: mehr Auswahl, mehr Macht und die Möglichkeit, auf modernster KI-Technologie aufzubauen, ohne an die API eines einzigen Anbieters gebunden zu sein.

Der Wettbewerb bleibt spannend: Die KI-Welt wartet bereits gespannt auf DeepSeeks nächstes Modell R2 und neue Open-Source-Initiativen aus Metas Superintelligenz-Labor. Der Schritt von OpenAI hat den Wettlauf um die beste offene KI jedoch gerade neu entfacht – und davon profitieren am Ende alle.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- Zeff, M. (2025, 5. August). OpenAI launches two ‘open’ AI reasoning models. TechCrunch. Verfügbar unter: https://techcrunch.com/2025/08/05/openai-launches-two-open-ai-reasoning-models/

#OpenAI #GPTOSS #OpenSourceAI #KünstlicheIntelligenz #KIModelle #AI #TechNews2025 #HuggingFace