Die Weiterentwicklung von Large Language Models (LLMs) bleibt ein zentraler Fokus der KI-Forschung. Das neue Paper von Sakana AI Transformer 2 setzt neue Maßstäbe für Large Language Models (LLMs). Diese selbstadaptive Technologie von Sakana AI übertrifft traditionelle Ansätze durch ihre Fähigkeit, sich in Echtzeit an neue Aufgaben anzupassen. Dabei wird die Leistung durch die innovative Singular Value Fine-tuning (SVF)-Methode optimiert, die weniger Ressourcen benötigt und dennoch überragende Ergebnisse liefert.

Parallel dazu beschäftigt sich auch Google Research Titans mit der Frage, wie KI-Systeme durch modulare Ansätze effizienter gestaltet werden können. Dabei fokussiert sich Google auf dynamische, kollaborative Modelle, die spezialisierte Aufgabenbereiche abdecken. Diese Trends zeigen klar: Die Zukunft der KI liegt in selbstanpassenden, flexiblen Systemen – genau dort, wo Transformer 2 ansetzt.

Das musst du wissen – Die Vorteile von Sakana AI – Transformer 2

- Transformer 2 Vorteile: Dynamische Anpassung durch den Zwei-Pass-Mechanismus und modulare Expertensysteme.

- Effizientes Fine-Tuning: Mit SVF werden nur Singularwerte angepasst, wodurch Parameter gesenkt und Überanpassung vermieden werden.

- Einsatz in multimodalen Szenarien: Auch für Vision-Language-Aufgaben zeigt Transformer 2 herausragende Ergebnisse.

- Selbstadaptive KI in Echtzeit: Anpassung an neue Aufgaben ohne erneutes, ressourcenintensives Training.

Hauptfrage zu Sakana AI – Transformer 2

Wie verbessert Transformer 2 die Selbstanpassung von KI-Modellen und welche Rolle spielt SVF dabei?

Einführung in die selbstadaptive KI von Sakana AI

Die Herausforderungen bei herkömmlichem LLM-Fine-Tuning liegen auf der Hand: hoher Rechenaufwand, eingeschränkte Anpassungsfähigkeit und das Risiko der Überanpassung. Sakana AI geht mit Transformer 2 einen radikal neuen Weg.

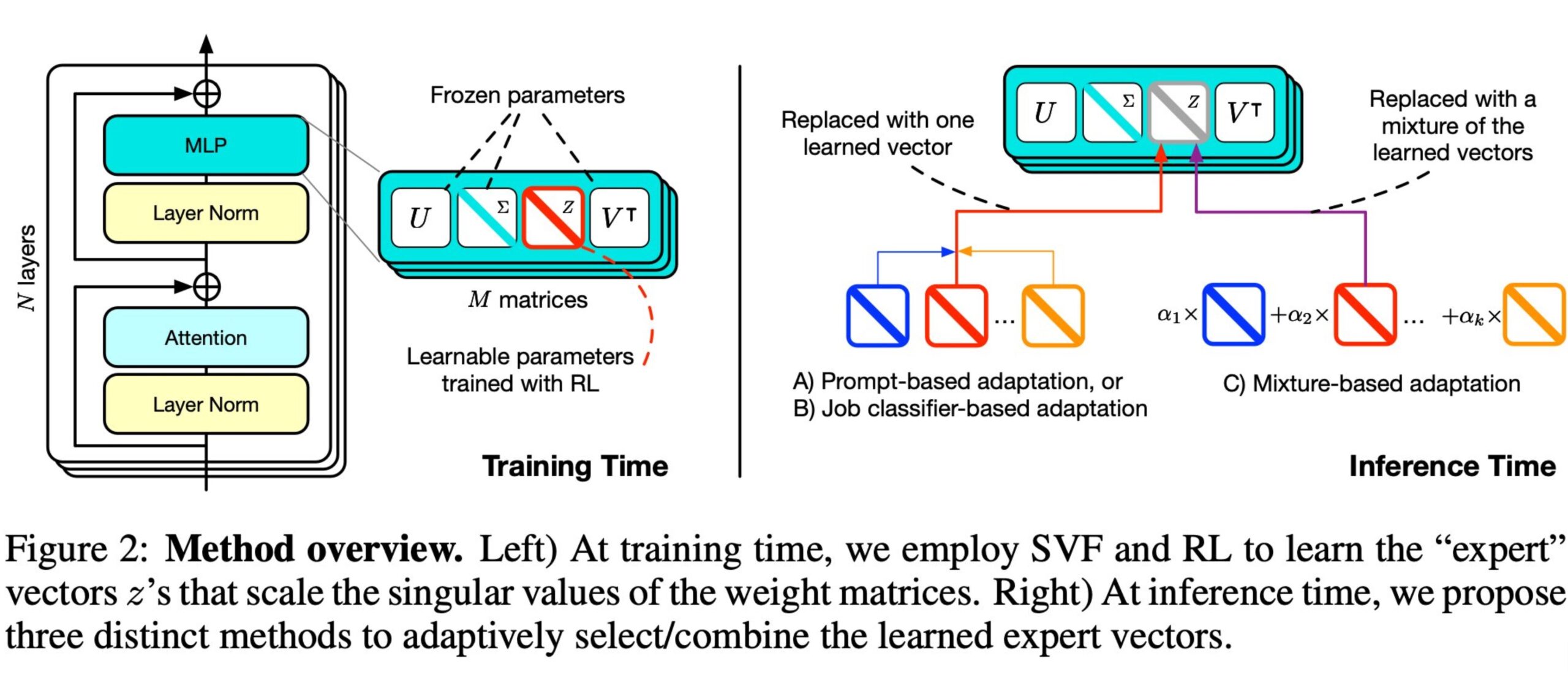

Der Kern dieser Technologie ist die Singular Value Fine-tuning (SVF)-Methode. Statt gesamte Gewichtsmatrizen zu verändern, konzentriert sich SVF auf die Optimierung einzelner Singularwerte. Dies reduziert den Rechenaufwand erheblich, während gleichzeitig die Kompositionsfähigkeit verbessert wird.

Das Herzstück von Transformer 2 bildet der Zwei-Pass-Mechanismus:

- Pass 1: Analyse des Eingabekontexts und Identifikation der Aufgabe.

- Pass 2: Dynamische Anpassung der Modellgewichte mithilfe spezialisierter SVF-Expertenmodule.

Mit dieser modularen Architektur bietet Transformer 2 eine bisher unerreichte Flexibilität und Effizienz in der KI-Anpassung.

FAQs zu Sakana AI – Transformer 2 und selbstadaptiver KI

Was ist Singular Value Fine-tuning (SVF)?

SVF ist eine Methode, die sich ausschließlich auf die Feinjustierung der Singularwerte der Gewichtsmatrizen konzentriert. Dadurch werden die zu optimierenden Parameter drastisch reduziert, was Überanpassung vermeidet und Effizienz steigert.

Wie funktioniert der Zwei-Pass-Mechanismus?

Der erste Pass identifiziert die Anforderungen der Eingabe, der zweite Pass kombiniert spezialisierte SVF-Module für eine präzise, kontextbasierte Antwort.

Welche Vorteile bietet Transformer 2 gegenüber LoRA?

Transformer 2 nutzt weniger Parameter und zeigt dennoch bessere Ergebnisse. Es vermeidet die Einschränkungen von LoRA, wie die Anfälligkeit für Überanpassung und hohe Speicheranforderungen.

Wie funktioniert das Training mit SVF im Detail?

Beim Training extrahiert SVF die Singularwerte aus den Gewichtsmatrizen und optimiert sie mithilfe von Reinforcement Learning (RL). Dies ermöglicht es, Expertenmodule für spezifische Aufgaben effizient zu erstellen.

Welche spezifischen Herausforderungen löst Transformer 2 in der Praxis?

- Speicherbedarf: Reduzierung der notwendigen Parameter durch SVF.

- Anpassungsfähigkeit: Echtzeitanpassung an völlig neue Aufgaben.

- Multimodalität: Anwendung in textbasierten und visuellen Aufgabenfeldern.

Warum ist Transformer 2 für Vision-Language-Aufgaben geeignet?

Dank seiner modularen Expertenarchitektur und der effizienten Anpassungsfähigkeit durch SVF kann Transformer 2 selbst visuelle Fragen wie im TextVQA-Test erfolgreich bearbeiten.

Mögliche Anwendungsbereiche und Potenziale

- Effizienzsteigerung in der Industrie:

Durch die gezielte Optimierung von Singularwerten (SVF) können KI-Modelle künftig in ressourcenbegrenzten Umgebungen eingesetzt werden. Anwendungen wie Predictive Maintenance, Logistikanalysen und adaptive Fertigungslösungen profitieren von einer schnellen Echtzeitanpassung an wechselnde Datenströme. - Revolutionierung der multimodalen KI:

Dank der SVF-basierten modularen Architektur und der Fähigkeit von Transformer 2, visuelle und textuelle Daten in Echtzeit zu kombinieren, ergeben sich völlig neue Möglichkeiten für Bereiche wie TextVQA, Augmented Reality und Smart City-Lösungen. Diese könnten etwa eine intelligente Verkehrssteuerung oder erweiterte Übersetzungsdienste ermöglichen. - Optimierte personalisierte Assistenzsysteme:

Transformer 2 und ähnliche Technologien könnten dazu beitragen, virtuelle Assistenten wie Chatbots und Smart Speaker zu revolutionieren, indem sie kontextabhängige, dynamisch anpassbare Interaktionen bieten, die weit über heutige Fähigkeiten hinausgehen. - Einsatz im Gesundheitswesen:

Mit der Fähigkeit, auf kleindatenspezifische Modelle zu trainieren, könnten KI-Systeme personalisierte Diagnosen und Behandlungsvorschläge liefern, die auf Echtzeitdaten aus Wearables oder Patientendaten basieren.

Verbindung mit Google Research Titans: Ein kollaborativer Ansatz

Die modulare Philosophie von Google Research Titans harmoniert perfekt mit der SVF-Strategie von Transformer 2. Gemeinsam könnten diese Ansätze völlig neue Frameworks für kollaborative KI-Modelle schaffen, die verschiedene Expertensysteme nahtlos integrieren. Diese dynamischen Modelle könnten in Echtzeit miteinander kommunizieren und komplexe Aufgaben wie die Steuerung autonomer Fahrzeuge oder die Optimierung globaler Lieferketten lösen.

Praktische Tipps zur Nutzung von Sakana AI – Transformer 2

Einsatz von SVF in LLMs optimieren

- Kleine Datensätze: SVF ist besonders effizient für Aufgaben mit begrenzten Daten.

- Reinforcement Learning nutzen: Durch RL können Expertenmodule gezielt auf spezifische Aufgaben optimiert werden.

Anwendung des Zwei-Pass-Mechanismus

- Kombiniere spezialisierte Module dynamisch, um die besten Ergebnisse für komplexe Aufgaben zu erzielen.

Dynamische Anpassung von KI-Modellen

- Nutze Few-Shot-Learning, um Transformer 2 an neue Aufgaben anzupassen. Dies reduziert den Bedarf an umfangreichen Trainingsdaten.

Fazit – Transformer 2: Die Zukunft der selbstadaptiven KI

Die Forschung rund um Sakana AI Transformer 2 und seine innovative Singular Value Fine-tuning (SVF)-Methode markiert einen bedeutenden Fortschritt für die Weiterentwicklung von Large Language Models (LLMs). Die Kombination aus dynamischer Anpassung durch den Zwei-Pass-Mechanismus und modularen Expertenmodulen eröffnet vollkommen neue Perspektiven für den Einsatz von KI in realen Szenarien. Gemeinsam mit Ansätzen wie denen von Google Research Titans, die sich auf modulare und kollaborative Systeme spezialisieren, wird die Basis für die nächste Generation selbstadaptiver, skalierbarer und hochflexibler künstlicher Intelligenz gelegt.

Sakana AI Transformer 2 ist nicht nur eine technologische Errungenschaft, sondern auch ein bedeutender Schritt in Richtung einer vielseitigen, skalierbaren und anpassungsfähigen KI. In Kombination mit den modularen, kollaborativen Ansätzen von Google Research Titans eröffnet sich eine Zukunft, in der KI-Modelle nicht nur effizienter, sondern auch präziser und flexibler auf menschliche Bedürfnisse eingehen können. Dies könnte die Grundlage für Innovationen in Bereichen wie Gesundheit, Bildung, Industrie und urbaner Entwicklung schaffen – und die Zukunft der künstlichen Intelligenz neu definieren.

Lerne mehr über KI und entdecke praktische Anwendungsfälle bei KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen Sakana AI – Transformer 2

- Originalstudie: Transformer 2: Self-adaptive LLMs

- Google Research: Google Research Titans

#AI #KI #ArtificialIntelligence #KuenstlicheIntelligenz #Transformer2 #SVF #SelbstadaptiveKI #ZweiPassMechanismus