Alibaba hat am 28. Juli 2025 mit Wan 2.2 einen neuen Meilenstein im Bereich der KI-Videogenerierung gesetzt. Dieses Open-Source-Modell fordert nicht nur kommerzielle Giganten wie Sora von OpenAI und KLING 2.0 heraus, sondern macht professionelle Videoerstellung für eine breite Masse zugänglich. Doch was steckt wirklich hinter dem Hype? Wir haben uns die Technologie, die Features und die praktischen Anwendungsmöglichkeiten von Wan 2.2 genau angesehen und zeigen dir, warum dieses Tool eine echte Revolution sein könnte.

In diesem Guide erfährst du alles, was du über Wan 2.2 wissen musst: von der bahnbrechenden MoE-Architektur über die Hardware-Anforderungen bis hin zur Schritt-für-Schritt-Anleitung für die lokale Installation und die Nutzung mit ComfyUI. Wir klären, für wen sich welches der drei verfügbaren Modelle eignet und wie es im direkten Vergleich mit der Konkurrenz abschneidet.

KI-Videogeneratoren gibt es – gefühlt – inzwischen wie Sand am Meer. OpenAI Sora, Veo 3, Seaweed, Kling AI, Higgsfield, Runway – die Auswahl ist RIESIG. Open Source? Nö – das gibt es bisher nicht so oft! Spannender Ansatz von Alibaba – läuft auch bei Dir zu Hause!

Das Wichtigste in Kürze – Alibaba Wan 2.2 auf einen Blick

- Komplett Open Source: Wan 2.2 steht unter der Apache 2.0 Lizenz und ist damit für private und kommerzielle Projekte kostenlos nutzbar.

- Bahnbrechende MoE-Architektur: Als erstes Open-Source-Videomodell nutzt es eine Mixture-of-Experts (MoE), was die Leistung steigert, ohne die Rechenlast exorbitant zu erhöhen.

- Cineastische Qualität: Mit über 60 detaillierten Kontrollen für Licht, Komposition und Farbe ermöglicht Wan 2.2 eine ästhetische Präzision auf Profi-Niveau.

- Effizient auf Consumer-Hardware: Das 5-Milliarden-Parameter-Modell läuft bereits auf GPUs mit 8 GB VRAM und generiert 720p-Videos in unter 9 Minuten.

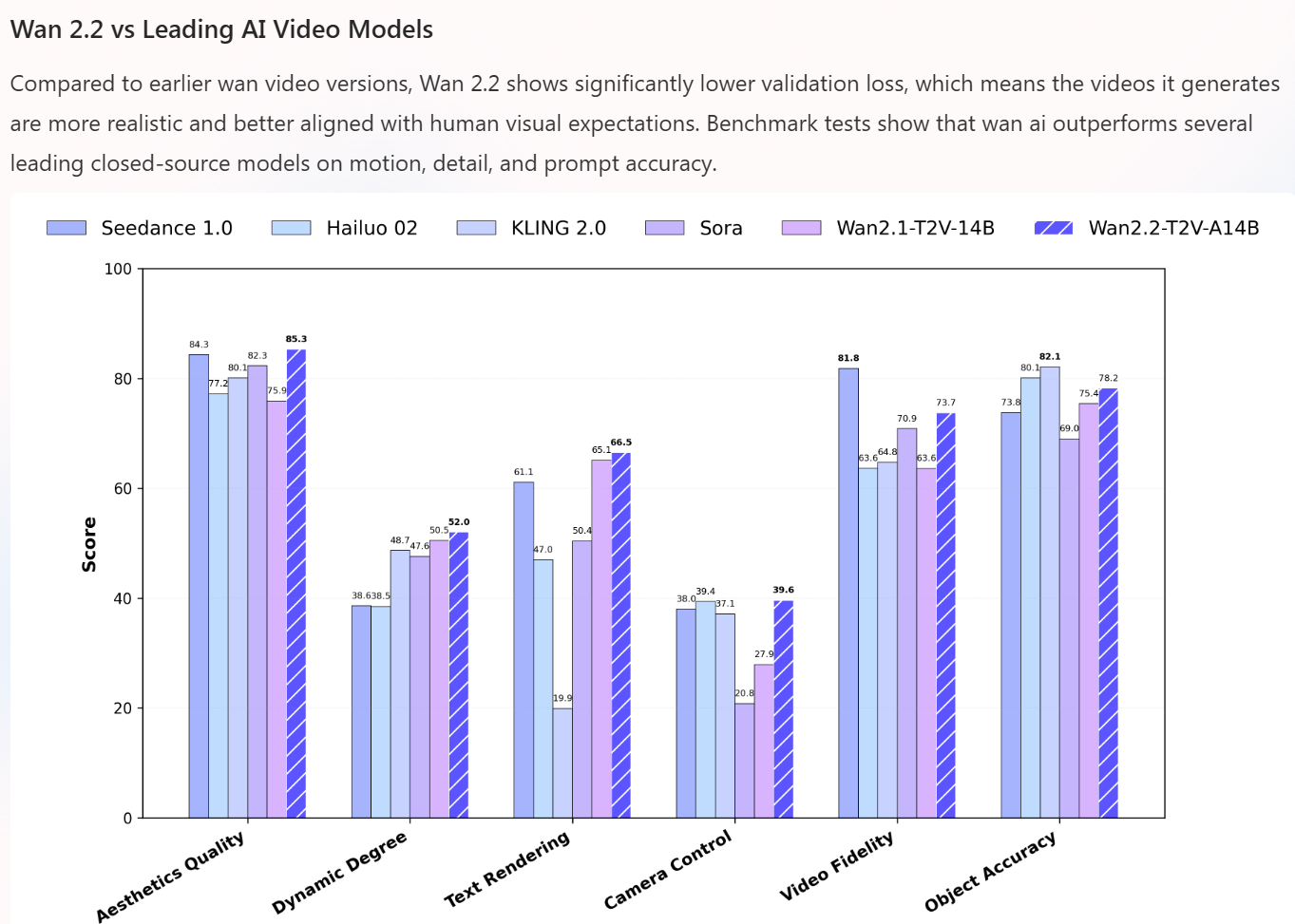

- Benchmark-Spitzenreiter: In internen Tests (Wan-Bench 2.0) übertrifft Wan 2.2 führende Modelle wie Sora und KLING 2.0 in den Kategorien Ästhetik, Bewegung und Kamerakontrolle.

Was ist Alibaba Wan 2.2? Die Revolution im Open-Source-Video

Wan 2.2 ist ein fortschrittliches KI-Modell zur Videogenerierung, entwickelt von Alibabas Tongyi Lab. Es kann aus einfachen Textbeschreibungen (Text-to-Video) oder statischen Bildern (Image-to-Video) dynamische, hochauflösende Videoclips von bis zu 5 Sekunden Länge erstellen. Im Gegensatz zu geschlossenen Systemen wie Sora oder Hailuo 02 legt Alibaba mit Wan 2.2 den gesamten Code und die Modellgewichte offen.

Dieser Open-Source-Ansatz ist mehr als nur eine nette Geste – er ist eine strategische Entscheidung, die die Demokratisierung der KI-Videoproduktion beschleunigt. Entwickler, Forscher und Kreative weltweit können die Technologie nicht nur frei nutzen, sondern auch weiterentwickeln, anpassen und in eigene Anwendungen integrieren.

Die Kerninnovation: Warum die MoE-Architektur alles verändert

Das Herzstück von Wan 2.2 ist seine Mixture-of-Experts (MoE) Architektur – eine Premiere für Open-Source-Videomodelle. Stell dir statt eines einzigen Alleskönner-Modells ein Team von hochspezialisierten Experten vor, die sich eine Aufgabe teilen. Genau das macht MoE:

- High-Noise-Experten: Diese sind für das Grobe zuständig. In den frühen Phasen der Videogenerierung legen sie das grundlegende Layout, die Komposition und die grobe Bewegung fest.

- Low-Noise-Experten: Diese Spezialisten kümmern sich um die Feinarbeit. Sie verfeinern Details, schärfen Texturen und sorgen für ein sauberes, qualitativ hochwertiges Endergebnis.

Der Clou: Obwohl die großen Modelle von Wan 2.2 insgesamt 27 Milliarden Parameter besitzen, sind pro Generierungsschritt nur 14 Milliarden Parameter aktiv. Das erhöht die Leistungsfähigkeit des Modells drastisch, ohne die benötigte Rechenleistung und den Speicherbedarf im gleichen Maße zu steigern. Das Ergebnis ist eine beeindruckende Balance aus Effizienz und Qualität.

Die Modelle im Detail: Welches Wan 2.2 ist das richtige für dich?

Wan 2.2 wird in drei spezialisierten Varianten angeboten, um unterschiedlichen Anforderungen gerecht zu werden:

| Modell | Parameter (Aktiv/Total) | Hauptfunktion | Auflösung | Besonderheiten |

| Wan2.2-T2V-A14B | 14B / 27B | Text-to-Video | 480p / 720p | Maximale semantische Genauigkeit und cineastische Kontrolle. |

| Wan2.2-I2V-A14B | 14B / 27B | Image-to-Video | 480p / 720p | Verwandelt Bilder in flüssige Videos, minimiert unnatürliches Ruckeln. |

| Wan2.2-TI2V-5B | 5B | Hybrid (Text & Bild) | 720p @ 24fps | Effizient und schnell, optimiert für Consumer-GPUs (z.B. RTX 4090). |

Für die meisten Anwender ist das TI2V-5B-Modell der ideale Einstiegspunkt. Es bietet eine hervorragende Qualität, unterstützt beide Generierungsarten und läuft auch auf gängiger Gaming-Hardware. Die 14B-Modelle richten sich an Nutzer mit professioneller Hardware, die maximale Detailtreue und Kontrolle anstreben.

Kreative Freiheit: Über 60 cineastische Kontrollen & Effekte

Eine der größten Stärken von Wan 2.2 ist die granulare Kontrolle über die Ästhetik des Videos. Das Modell wurde auf einem Datensatz trainiert, der sorgfältig mit über 60 verschiedenen cineastischen Attributen verschlagwortet wurde. Das ermöglicht dir, gezielt Anweisungen zu geben für:

- Professionelle Lichtsetzung: Gib Anweisungen wie „global illumination“, „volumetric lighting“ oder „dramatic side lighting“.

- Kamerabewegung und -führung: Kontrolliere präzise Schwenks (Pan), Kamerafahrten (Dolly In/Out), Tilt-Bewegungen oder dynamische Crash-Zooms.

- Komposition und Framing: Nutze Begriffe aus der Filmtheorie, um den Bildaufbau zu steuern.

- Farbgebung und Atmosphäre: Erzeuge durch gezieltes Color Grading eine bestimmte Stimmung.

- Spezialeffekte: Integriere dynamische Partikel wie Rauch, Feuer oder Nebel direkt bei der Generierung.

How-To: Wan 2.2 lokal installieren in 4 einfachen Schritten

Du möchtest Wan 2.2 auf deinem eigenen Rechner ausführen? Kein Problem. Mit Grundkenntnissen der Kommandozeile ist die Einrichtung schnell erledigt. Hier ist eine Anleitung für das beliebte TI2V-5B-Modell.

- Repository klonen: Öffne ein Terminal oder eine Kommandozeile und lade den Code von GitHub herunter.Bash

git clone https://github.com/Wan-Video/Wan2.2.git cd Wan2.2 - Abhängigkeiten installieren: Installiere alle notwendigen Python-Bibliotheken. Stelle sicher, dass du eine aktuelle Version von PyTorch (>= 2.4.0) verwendest.Bash

pip install -r requirements.txt - Modell-Dateien herunterladen: Nutze den Hugging Face Downloader, um das gewünschte Modell in ein lokales Verzeichnis zu laden.Bash

pip install "huggingface_hub[cli]" huggingface-cli download Wan-AI/Wan2.2-TI2V-5B --local-dir ./Wan2.2-TI2V-5B - Video generieren: Nachdem alles eingerichtet ist, kannst du mit den bereitgestellten Skripten dein erstes Video erstellen. Passe den Prompt und die Parameter nach deinen Wünschen an.

Für Kreative & Entwickler: Wan 2.2 mit ComfyUI nutzen

Wenn du eine grafische Benutzeroberfläche bevorzugst, ist die Integration in ComfyUI die beste Wahl. Wan 2.2 wurde mit Day-0-Support für ComfyUI veröffentlicht, was die Nutzung enorm vereinfacht.

- Vorgefertigte Workflows: Im Menü unter

Workflow → Browse Templates → Videofindest du fertige Setups für alle Wan 2.2-Modelle. - Visuelles Interface: Verbinde die verschiedenen Knoten (Modelllader, Prompt-Eingabe, VAE etc.) per Drag-and-Drop, ohne eine Zeile Code schreiben zu müssen.

- Hardware-Voraussetzungen: Für einen flüssigen Betrieb in ComfyUI wird eine GPU mit mindestens 8 GB VRAM empfohlen.

- Einfache Einrichtung: Folge den offiziellen Anleitungen, um die Modell- und VAE-Dateien in die richtigen ComfyUI-Verzeichnisse zu legen.

Wan 2.2 vs. Sora & KLING 2.0: Der direkte Leistungsvergleich

Wie schlägt sich der Open-Source-Herausforderer gegen die etablierten, geschlossenen Modelle? Laut dem von Alibaba entwickelten Benchmark Wan-Bench 2.0 setzt sich Wan 2.2 in entscheidenden Disziplinen an die Spitze.

| Feature | Wan 2.2 | Sora (OpenAI) | KLING 2.0 (Kuaishou) |

| Architektur | MoE (27B/14B aktiv) | Proprietär | Proprietär |

| Max. Auflösung | 720p @ 24fps | 1080p | 1080p @ 30fps |

| Open Source | Ja (Apache 2.0) | Nein | Nein |

| Hardware-Zugang | Consumer-GPUs | Nur Cloud | Nur Cloud |

| Cineastische Kontrolle | Sehr hoch (60+) | Limitiert | Moderat |

| Benchmark (Wan-Bench 2.0) | #1 Ästhetik & Motion | Übertroffen | Übertroffen |

In Google Sheets exportieren

Während Sora und KLING bei der reinen Auflösung und Videolänge (bis zu 60 bzw. 120 Sekunden) noch die Nase vorn haben, punktet Wan 2.2 mit seiner überlegenen Zugänglichkeit, Kosteneffizienz und kreativen Kontrolle. Für viele Anwender ist die Möglichkeit, das Modell lokal und ohne teure Cloud-Credits zu nutzen, der entscheidende Vorteil.

Hardware-Anforderungen: Was du wirklich für Wan 2.2 brauchst

Die MoE-Architektur macht Wan 2.2 überraschend genügsam. Hier ist eine Übersicht, was du für einen reibungslosen Betrieb benötigst:

- Einsteiger-Setup (TI2V-5B Modell):

- GPU: NVIDIA RTX 4060 oder vergleichbar mit mindestens 8 GB VRAM.

- RAM: 32 GB empfohlen, 64 GB für mehr Stabilität.

- Profi-Setup (14B Modelle):

- GPU: NVIDIA RTX 4090 oder eine professionelle Karte mit mindestens 16 GB VRAM, besser 24 GB.

- RAM: 64 GB oder mehr.

Expertenmeinung: „Die Veröffentlichung von Wan 2.2 unter einer Open-Source-Lizenz ist ein strategischer Schachzug, der die Marktdominanz geschlossener Modelle direkt angreift“, so Analysten im Umfeld der Veröffentlichung. „Es senkt die Eintrittsbarriere für unzählige Entwickler und Kreative und wird eine Welle der Innovation auslösen.“

Der Maschinenraum von Alibaba Wan 2.2: Ein technischer Deep Dive

Du willst es ganz genau wissen? Perfekt. Für alle, die tiefer in die Technik hinter Wan 2.2 eintauchen möchten, schlüsseln wir hier die entscheidenden Konzepte auf, die dieses Modell so leistungsfähig machen. Dieser Abschnitt erklärt, was wirklich unter der Haube passiert.

Mixture-of-Experts (MoE): Mehr als nur ein Buzzword

Wir haben die MoE-Architektur als „Team von Spezialisten“ beschrieben. Technisch betrachtet ist dieser Ansatz genial, um die Balance zwischen Modellgröße und Rechenaufwand zu meistern.

- Das Gating Network als intelligenter Router: Bevor ein Experte seine Arbeit aufnimmt, analysiert ein kleines, vorgeschaltetes neuronales Netzwerk – das sogenannte „Gating Network“ – den aktuellen Zustand des Videos (im Diffusionsprozess ist das anfangs nur „Rauschen“) und den Text-Prompt. Basierend auf dieser Analyse entscheidet es, welche der vielen verfügbaren Experten für den nächsten Schritt am besten geeignet sind. Es agiert also wie ein intelligenter Projektleiter, der die Aufgaben an die richtige Abteilung weiterleitet.

- Recheneffizienz durch selektive Aktivierung: Der entscheidende Vorteil liegt in der Effizienz. Bei einem klassischen, „dichten“ Modell müssen bei jedem Berechnungsschritt alle Parameter aktiv sein. Im Fall von Wan 2.2 wären das die vollen 27 Milliarden. Das ist extrem rechenintensiv. Die MoE-Architektur aktiviert jedoch nur die ausgewählten Experten – also nur 14 der 27 Milliarden Parameter. Du erhältst die Wissenskapazität und Nuanciertheit eines riesigen Modells, aber zu den Rechenkosten (FLOPs) eines deutlich kleineren.

- Die Arbeitsteilung im Denoising-Prozess: Die Spezialisierung in „High-Noise“- und „Low-Noise“-Experten ist der Schlüssel zur Qualität.

- High-Noise-Experten sind darauf trainiert, aus dem anfänglichen Chaos eine sinnvolle Grundstruktur zu schaffen. Sie erkennen die groben Formen, das Layout der Szene und die primären Bewegungsrichtungen. Sie sind die Architekten des Videos.

- Low-Noise-Experten übernehmen, sobald eine erkennbare Struktur vorhanden ist. Sie sind die Detail-Künstler, die für feine Texturen, realistische Lichtreflexe, scharfe Kanten und die Beseitigung der letzten Rauschartefakte zuständig sind. Diese Aufteilung sorgt für eine überlegene Qualität, da kein Experte Kompromisse zwischen grobem Aufbau und feinen Details eingehen muss.

Der heimliche Held – Darum ist der Alibaba Wan2.2-VAE so entscheidend

Der VAE (Variational Autoencoder) wird oft nur am Rande erwähnt, ist aber absolut zentral für die Performance von Wan 2.2 auf Consumer-Hardware, insbesondere beim effizienten TI2V-5B-Modell.

- Extreme Kompression im latenten Raum: Der VAE erreicht ein beeindruckendes Kompressionsverhältnis von 16x16x4. Das bedeutet: Ein Block von 16×16 Pixeln über 4 Frames hinweg wird in eine winzige, abstrakte mathematische Repräsentation umgewandelt. Der gesamte rechenintensive Diffusionsprozess findet nicht auf den riesigen Videodaten statt, sondern in diesem hochkomprimierten „latenten Raum“. Erst ganz am Ende des Prozesses nimmt der Decoder des VAE das Ergebnis aus dem latenten Raum und rekonstruiert daraus das finale, hochauflösende Video. Ohne diese Kompression wäre die Generierung auf einer 8-GB-GPU undenkbar.

- Garant für zeitliche Konsistenz: Ein typisches Problem früherer Video-KIs war das unschöne Flackern oder die Inkonsistenz von Objekten zwischen den einzelnen Frames. Der Wan2.2-VAE wurde gezielt darauf trainiert, die temporale Kohärenz zu maximieren. Er „versteht“ also, dass ein Objekt über mehrere Frames hinweg dasselbe bleiben sollte, was zu deutlich flüssigeren und stabileren Bewegungen führt.

Kreativität nach Maß: So funktioniert das LoRA-Training

Ein weiteres mächtiges Feature von Wan 2.2 ist die Unterstützung für LoRA (Low-Rank Adaptation). Dies ist die Technologie, die es dir ermöglicht, das Modell mit deinem eigenen Stil zu versehen.

- Effizientes Feintuning: Anstatt das gesamte riesige Modell (Milliarden von Parametern) neu trainieren zu müssen, friert LoRA das Originalmodell ein und trainiert nur eine winzige Anzahl zusätzlicher, „adaptiver“ Parameter. Das reduziert den Trainingsaufwand von Wochen oder Monaten auf wenige Stunden oder sogar Minuten.

- Few-Shot Learning: Wan 2.2 ist hier besonders effizient. Du benötigst nur 10 bis 20 Beispielbilder, um dem Modell einen neuen Charakter, einen bestimmten künstlerischen Stil oder ein spezifisches Objekt beizubringen.

- Multi-Modell-Fusion: Die Architektur erlaubt es, mehrere LoRA-Modelle intelligent zu kombinieren. Du könntest also ein LoRA für einen bestimmten Charakter mit einem LoRA für einen einzigartigen visuellen Stil (z.B. „Cyberpunk-Aquarell“) mischen und so völlig neue Ästhetiken erschaffen.

Fazit und Ausblick: Ein Game-Changer für die KI-Video-Szene

Wan 2.2 ist mehr als nur ein weiteres KI-Tool – es ist ein Statement. Alibaba beweist eindrucksvoll, dass Open-Source-Modelle nicht nur mit kommerziellen Schwergewichten mithalten, sondern sie in wichtigen Bereichen wie Effizienz und kreativer Kontrolle sogar übertreffen können. Die Kombination aus der innovativen MoE-Architektur, der hohen Ausgabequalität und der Lauffähigkeit auf Consumer-Hardware macht es zu einem der spannendsten Releases des Jahres 2025.

Die Möglichkeit, ein derart leistungsfähiges Werkzeug kostenlos und für kommerzielle Zwecke zu nutzen, wird die Art und Weise, wie Inhalte für Social Media, Marketing oder sogar Kurzfilme produziert werden, nachhaltig verändern. Wan 2.2 senkt die Kosten, beschleunigt die Workflows und gibt die kreative Macht zurück in die Hände der Nutzer.

Die Zukunft sieht vielversprechend aus: Die Entwickler haben bereits höhere Auflösungen (1080p und 4K), längere Videoclips und eine erweiterte Sprachunterstützung in Aussicht gestellt. Die aktive Community wird zweifellos ebenfalls zu schnellen Verbesserungen und neuen Integrationen beitragen. Mit Wan 2.2 hat der Wettbewerb im Bereich der KI-Videogenerierung eine neue, offene und extrem spannende Dynamik bekommen.

Häufig gestellte Fragen – Alibaba Wan 2.2

Was genau ist Wan 2.2? Wan 2.2 ist ein von Alibabas Tongyi Lab entwickelter Open-Source AI Video Generator. Er kann aus Text- oder Bild-Eingaben hochwertige Videoclips mit einer Auflösung von bis zu 720p bei 24 fps erstellen und zeichnet sich durch seine innovative Mixture-of-Experts (MoE) Architektur aus.

Ist Wan 2.2 wirklich kostenlos? Ja, das Kernmodell von Wan 2.2 ist unter der Apache 2.0 Lizenz veröffentlicht. Das bedeutet, du kannst es kostenlos herunterladen, nutzen, verändern und sogar für kommerzielle Projekte einsetzen. Es gibt eine kostenpflichtige Premium-Version namens „Wan 2.2 Plus“ mit erweiterten Features.

Welche Hardware brauche ich, um Wan 2.2 zu nutzen? Für das effiziente TI2V-5B-Modell genügt eine moderne Consumer-GPU mit mindestens 8 GB VRAM (z.B. NVIDIA RTX 4060). Für die größeren 14B-Modelle werden mindestens 16 GB VRAM empfohlen, idealerweise 24 GB (z.B. RTX 4090).

Wie schneidet Wan 2.2 im Vergleich zu OpenAI’s Sora ab? Auf dem Wan-Bench 2.0-Benchmark übertrifft Wan 2.2 Sora in den Kategorien Ästhetik, Bewegungsdynamik und Kamerakontrolle. Sora bietet derzeit eine höhere maximale Auflösung (1080p) und längere Clips, ist aber ein geschlossenes, nicht frei verfügbares Modell. Wan 2.2 punktet mit seiner Open-Source-Natur und Zugänglichkeit.

Kann ich Wan 2.2 auch ohne Programmierkenntnisse nutzen? Ja. Dank der nahtlosen Integration in die grafische Benutzeroberfläche ComfyUI kannst du Wan 2.2 über ein visuelles Node-System bedienen. Alternativ gibt es Cloud-Plattformen wie Hugging Face Spaces, auf denen du das Modell direkt im Browser testen kannst.

www.KINEWS24-academy.de – KI. Direkt. Verständlich. Anwendbar.

Quellen

- GitHub Wan 2.2 Comprehensive Guide

- videomaker.me – Wan 2.2 Open Source AI Video Generator

- news.aibase.com – Ali Wan 2.2 is About to Make a Stunning Launch

- vadoo.tv – Wan 2.2 – Alibaba’s Latest Open-Source AI Video Generator

#Wan22 #AIVideo #OpenSourceAI #KuenstlicheIntelligenz #TextToVideo #AlibabaAI #AItools #Videogenerierung